一种基于人工智能的简笔画生成方法与流程

1.本发明属于人工智能技术领域,特别是涉及一种基于人工智能的简笔画生成方法。

背景技术:

2.简笔画是一种常见的艺术表现形式,用来描绘人类对自然的感知,具有高度的概括性和抽象性。近些年,随着人工智能(ai)的迅速发展,将人工智能技术与生产生活相结合已形成了广泛的趋势,不少学者尝试将ai技术应用于艺术创作,例如风格画生产,颜色光影风格迁移等。

3.然而尽管业界有不少类似的应用并且取得不错的效果,但使用ai技术自动生成简笔画算法是一项大胆而极具挑战的尝试,其难点在于:1)深度学习很难区分错综交错的梯度变换哪些需要生成线条哪些是干扰;2)算法生成得到的简笔画线条过于繁杂3)真实场景中光线明暗变换以及光线不均衡的影响;4)背景干扰、重叠等。现有技术存在以下缺点:

4.a:目前很多算法可以实现多样性的风格画,但基于生成人脸肖像简笔画的算法很少见并且效果不尽如人意,例如人脸肖像轮廓不流畅、人脸五官区域生成不完整、生成线条过于繁杂、不具备简洁和概括性、受光照不均衡的影响等;

5.b:简笔画是对原画进行高度的概括和呈现,现有ai算法的训练方式多是基于成对的数据进行训练的,一方面成对的数据采集非常昂贵,另一方面在使用成对的数据训练时,由于简笔画的轮廓线条(前景)与背景占比不均衡也会影响生成效果,这也是人脸重要特征信息容易丢失的主要原因。因此,受限于数据的数量以及数据的不平衡,这类方法往往不能很好的适应真实的多样的场景。

技术实现要素:

6.本发明的目的在于提供一种基于人工智能的简笔画生成方法,通过从人脸照片到生成简笔画采用不成对的数据训练方法,解决了成对训练数据存在的问题,并极大提升了简笔画生成效果。

7.为解决上述技术问题,本发明是通过以下技术方案实现的:

8.本发明为一种基于人工智能的简笔画生成方法,使用cyclegan作为简笔画生产算法的骨干网络,采用了不成对(unpaired)的训练数据作为深度学习的训练样本,该方法具体包括以下步骤:

9.步骤ss01:获取原始人物肖像数据;

10.步骤ss02:对肖像数据进行预处理;

11.步骤ss03:根据简笔画模型进行简笔画生成;

12.步骤ss04:生成简笔画图像;

13.所述简笔画模型中的网络采用以对抗的方式进行训练,不成对的方法并不要求照片和原画对齐,只要求简笔画风格保持一致即可,这就极大降低了数据采集的难度,同时可

以将共有数据集或者网络上的数据作为训练样本用于训练,并将更具挑战性的照片纳入到训练集中,扩充训练集的同时丰富了数据类别。这为本方法生成简笔画算法提供了强有力的数据支撑,也是本发明最终取得良好效果的重要原因之一,训练时的数据集的制作方法为:

14.针对现实场景的人物照片通过人脸检测算法得到人脸区域,以人脸区域的中心进行区域扩大剪裁出人脸图像;

15.通过关键点检测算法检测得到关键点信息,使用关键点定位到眼、鼻、嘴区域,并分别对眼、鼻、嘴区域制作图像掩膜版;

16.根据剪裁后的人脸图像绘制对应的简笔画数据。

17.进一步地,所述人脸区域为矩形区域,所述人脸区域包括人脸区域一、人脸区域二;

18.其中,所述人脸区域一以发际线、下巴、耳朵为边界;

19.所述人脸区域二以发际线、肩膀、耳朵为边界。

20.进一步地,以人脸区域的中心进行区域扩大剪裁出人脸图像的方法为:

21.步骤c001:获取人脸区域一、人脸区域二的中心点,并分别标记为中心点z1、中心点z2;

22.步骤c002:判断鼻尖与中心点z1的相对位置;

23.若鼻尖处于中心点z1所在的水平线以上,则以人脸区域一的上边缘线、人脸区域一的上边缘线的两端向人脸区域二的下边缘线连线作为边界,圈定三角形区域;

24.若鼻尖处于中心点z1所在的水平线以下,则以人脸区域一的上边缘线下降至边缘线一、边缘线一的两端向人脸区域二的下边缘线连线作为边界,圈定三角形区域;

25.步骤c003:根据步骤c002中圈定的三角形区域剪裁出人脸图像。

26.进一步地,本发明增强了人脸五官区域的生成表现,人脸的五官描绘对整体画作的影响是巨大的,甚至能决定一幅画作的成败,我们发现如果仅仅使用全局的网络,人脸的五官信息很容易受到环境光照、角度、阴影等干扰,导致五官区域生成的线条缺失、错乱、与实际不符、不美观等。因此本方法在原始网络的基础上使用了多个局部判别网络,包含眼睛、鼻子和嘴唇的局部判别网络,用来增强区域信息表达,我们的方法很好地保留了生成的人像图中所有重要的面部特征,关键点包括定位关键点、辅助关键点:

27.定位关键点为:将人脸图像中每只眼睛、鼻子、嘴巴分别以矩形区域覆盖;每一矩形区域的边界线分别与眼睛、鼻子、嘴巴最外处的边缘点相切,并将矩形区域定义为眼周矩形、鼻周矩形、嘴周矩形;每一矩形区域的四个边角点,作为关键点;

28.辅助关键点包括:中心点z1、中心点z2;

29.辅助关键点还包括眼周矩形、鼻周矩形、嘴周矩形的边缘线分别与人脸区域一、人脸区域二对角线的交点。

30.进一步地,通过关键点检测算法检测得到关键点信息,使用关键点定位到眼、鼻、嘴区域的方法为:

31.步骤j00:获取人脸图像;

32.步骤j01:检测出眼周矩形、鼻周矩形、嘴周矩形,获取眼周矩形、鼻周矩形、嘴周矩形对应的四个边角点,作为定位关键点;

33.步骤j02:获取人脸区域一、人脸区域二,并检测出中心点z1、中心点z2以及眼周矩形、鼻周矩形、嘴周矩形的边缘线分别与人脸区域一、人脸区域二对角线的交点,作为辅助关键点;

34.步骤j03:以人脸区域一下边缘线的重点为原点,建立直角坐标系;

35.步骤j04:获取每一定位关键点、辅助关键点在直角坐标系中的位置,以及每一定位关键点与辅助关键点之间的相对位置;

36.步骤j05:根据定位关键点确定眼、鼻、嘴区域,并结合每一定位关键点与辅助关键点之间的相对位置确定眼、鼻、嘴区域的相对位置。

37.进一步地,所述相对位置用定位关键点与辅助关键点之间的向量表示。

38.进一步地,简笔画模型包括:

39.生成器j,其用于将人脸照片转换为简笔画;

40.生成器r,其用于将简笔画转换为人脸照片;

41.判别器p_j,其用于区分生成的简笔画和真实的简笔画;

42.判别器p_r,其用于区分生成的照片和真实的照片;

43.还包括四个局部判别器:

44.判别器p_y1、判别器p_y2、判别器p_b、和判别器p_z,分别用于判别两只眼睛、鼻子和嘴巴的图像,以增强五官区域图像生成的质量;

45.判别器p_j、判别器p_r、判别器p_y1、判别器p_y2、判别器p_b、和判别器p_z网络结构是基于patchgan网络。

46.进一步地,所述生成器j为包括残差模块的编码器解码器,所述生成器j将人脸照片转换为简笔画的方法为:

47.步骤一,通过一个卷积层和两个下采样模块对人脸照片进行编码并提取特征;

48.步骤二,通过9个相同结构的残差模块构造特征并转换到眼、鼻、嘴区域;

49.步骤三,然后通过两个上采样模块和一个最终卷积层重构输出图形。

50.进一步地,所述简笔画模型中的网络采用以对抗的方式进行训练,训练方法包括以下步骤:

51.步骤s1:获取原始人物肖像数据;

52.步骤s2:对肖像数据进行预处理;

53.步骤s3:制作训练集,分别对眼、鼻、嘴区域制作图像掩膜版;

54.步骤s4:绘制对应的简笔画数据;

55.步骤s5:训练,生成简笔画模型。

56.进一步地,对判别器p_j、判别器p_r、判别器p_y1、判别器p_y2、判别器p_b、和判别器p_z进行训练,使对真实照片和合成的简笔画的概率最大化;

57.对生成器g和f进行训练,使分配正确标签的概率最小化。

58.本发明具有以下有益效果:

59.本发明通过采用不成对的训练数据作为深度学习的训练样本,极大降低了数据采集的难度,同时可以将共有数据集或者网络上的数据作为训练样本用于训练,并将更具挑战性的照片纳入到训练集中,扩充训练集的同时丰富了数据类别。这为本方法生成简笔画算法提供了强有力的数据支撑,也是本发明最终取得良好效果的重要原因之一。

60.本发明增强了人脸五官区域的生成表现,在原始网络的基础上使用了多个局部判别网络,包含眼睛、鼻子和嘴唇的局部判别网络,用来增强区域信息表达,很好地保留了生成的人像图中所有重要的面部特征。

61.当然,实施本发明的任一产品并不一定需要同时达到以上所述的所有优点。

附图说明

62.为了更清楚地说明本发明实施例的技术方案,下面将对实施例描述所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

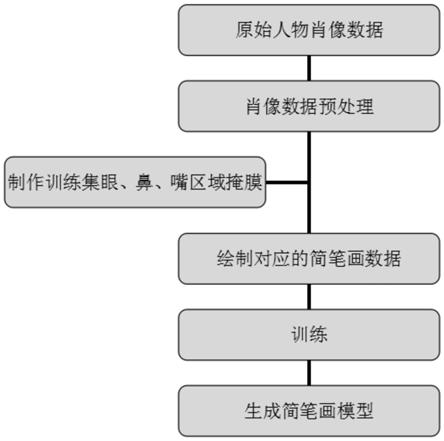

63.图1为本发明.简笔画算法训练流程图;

64.图2为实施例的示意图;

65.图3为实施例的示意图。

具体实施方式

66.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其它实施例,都属于本发明保护的范围。

67.在本发明的描述中,需要理解的是,术语“左”、“上”、“下”、“右”、“边缘”、“相切”等指示方位或位置关系,仅是为了便于描述本发明和简化描述,而不是指示或暗示所指的组件或元件必须具有特定的方位,以特定的方位构造和操作,因此不能理解为对本发明的限制。

68.请参阅图1所示,本发明为一种基于人工智能的简笔画生成方法,使用cyclegan作为简笔画生产算法的骨干网络,采用了不成对(unpaired)的训练数据作为深度学习的训练样本,该方法具体包括以下步骤:

69.步骤ss01:获取原始人物肖像数据;

70.步骤ss02:对肖像数据进行预处理;

71.步骤ss03:根据简笔画模型进行简笔画生成;

72.步骤ss04:生成简笔画图像;

73.所述简笔画模型中的网络采用以对抗的方式进行训练,不成对的方法并不要求照片和原画对齐,只要求简笔画风格保持一致即可,这就极大降低了数据采集的难度,同时可以将共有数据集或者网络上的数据作为训练样本用于训练,并将更具挑战性的照片纳入到训练集中,扩充训练集的同时丰富了数据类别。这为本方法生成简笔画算法提供了强有力的数据支撑,也是本发明最终取得良好效果的重要原因之一,训练时的数据集的制作方法为:

74.针对现实场景的人物照片通过人脸检测算法得到人脸区域,以人脸区域的中心进行区域扩大剪裁出人脸图像;

75.通过关键点检测算法检测得到关键点信息,使用关键点定位到眼、鼻、嘴区域,并

分别对眼、鼻、嘴区域制作图像掩膜版;

76.根据剪裁后的人脸图像绘制对应的简笔画数据。

77.作为本发明提供的一个实施例,优选的,如图2、3所示,所述人脸区域为矩形区域,所述人脸区域包括人脸区域一、人脸区域二;

78.其中,所述人脸区域一以发际线(头发与人脸之间的边缘线的最高点或最低点)、下巴、耳朵为边界;

79.所述人脸区域二以发际线、肩膀、耳朵为边界。

80.作为本发明提供的一个实施例,优选的,以人脸区域的中心进行区域扩大剪裁出人脸图像的方法为:

81.步骤c001:获取人脸区域一、人脸区域二的中心点,并分别标记为中心点z1、中心点z2;

82.步骤c002:判断鼻尖与中心点z1的相对位置;

83.若鼻尖处于中心点z1所在的水平线以上,则以人脸区域一的上边缘线、人脸区域一的上边缘线的两端向人脸区域二的下边缘线连线作为边界,圈定三角形区域;

84.若鼻尖处于中心点z1所在的水平线以下,则以人脸区域一的上边缘线下降至边缘线一、边缘线一的两端向人脸区域二的下边缘线连线作为边界,圈定三角形区域;

85.步骤c003:根据步骤c002中圈定的三角形区域剪裁出人脸图像。

86.作为本发明提供的一个实施例,优选的,本发明增强了人脸五官区域的生成表现,人脸的五官描绘对整体画作的影响是巨大的,甚至能决定一幅画作的成败,我们发现如果仅仅使用全局的网络,人脸的五官信息很容易受到环境光照、角度、阴影等干扰,导致五官区域生成的线条缺失、错乱、与实际不符、不美观等。因此本方法在原始网络的基础上使用了多个局部判别网络,包含眼睛、鼻子和嘴唇的局部判别网络,用来增强区域信息表达,我们的方法很好地保留了生成的人像图中所有重要的面部特征,关键点包括定位关键点、辅助关键点:

87.定位关键点为:将人脸图像中每只眼睛、鼻子、嘴巴分别以矩形区域覆盖;每一矩形区域的边界线分别与眼睛、鼻子、嘴巴最外处的边缘点相切,并将矩形区域定义为眼周矩形、鼻周矩形、嘴周矩形;每一矩形区域的四个边角点,作为关键点;

88.辅助关键点包括:中心点z1、中心点z2;

89.辅助关键点还包括眼周矩形、鼻周矩形、嘴周矩形的边缘线分别与人脸区域一、人脸区域二对角线的交点。

90.作为本发明提供的一个实施例,优选的,通过关键点检测算法检测得到关键点信息,使用关键点定位到眼、鼻、嘴区域的方法为:

91.步骤j00:获取人脸图像;

92.步骤j01:检测出眼周矩形、鼻周矩形、嘴周矩形,获取眼周矩形、鼻周矩形、嘴周矩形对应的四个边角点,作为定位关键点;

93.步骤j02:获取人脸区域一、人脸区域二,并检测出中心点z1、中心点z2以及眼周矩形、鼻周矩形、嘴周矩形的边缘线分别与人脸区域一、人脸区域二对角线的交点,作为辅助关键点;

94.步骤j03:以人脸区域一下边缘线的重点为原点,建立直角坐标系;

95.步骤j04:获取每一定位关键点、辅助关键点在直角坐标系中的位置,以及每一定位关键点与辅助关键点之间的相对位置;

96.步骤j05:根据定位关键点确定眼、鼻、嘴区域,并结合每一定位关键点与辅助关键点之间的相对位置确定眼、鼻、嘴区域的相对位置。

97.作为本发明提供的一个实施例,优选的,所述相对位置用定位关键点与辅助关键点之间的向量表示。

98.作为本发明提供的一个实施例,优选的,简笔画模型包括:

99.生成器j,其用于将人脸照片转换为简笔画;

100.生成器r,其用于将简笔画转换为人脸照片;

101.判别器p_j,其用于区分生成的简笔画和真实的简笔画;

102.判别器p_r,其用于区分生成的照片和真实的照片;

103.还包括四个局部判别器:

104.判别器p_y1、判别器p_y2、判别器p_b、和判别器p_z,分别用于判别两只眼睛、鼻子和嘴巴的图像,以增强五官区域图像生成的质量;

105.判别器p_j、判别器p_r、判别器p_y1、判别器p_y2、判别器p_b、和判别器p_z网络结构是基于patchgan网络。

106.作为本发明提供的一个实施例,优选的,所述生成器j为包括残差模块的编码器解码器,所述生成器j将人脸照片转换为简笔画的方法为:

107.步骤一,通过一个卷积层和两个下采样模块对人脸照片进行编码并提取特征;

108.步骤二,通过9个相同结构的残差模块构造特征并转换到眼、鼻、嘴区域;

109.步骤三,然后通过两个上采样模块和一个最终卷积层重构输出图形。

110.作为本发明提供的一个实施例,优选的,所述简笔画模型中的网络采用以对抗的方式进行训练,训练方法包括以下步骤:

111.步骤s1:获取原始人物肖像数据;

112.步骤s2:对肖像数据进行预处理;

113.步骤s3:制作训练集,分别对眼、鼻、嘴区域制作图像掩膜版;

114.步骤s4:绘制对应的简笔画数据;

115.步骤s5:训练,生成简笔画模型。

116.作为本发明提供的一个实施例,优选的,对判别器p_j、判别器p_r、判别器p_y1、判别器p_y2、判别器p_b、和判别器p_z进行训练,使对真实照片和合成的简笔画的概率最大化;

117.对生成器g和f进行训练,使分配正确标签的概率最小化。

118.一种基于人工智能的简笔画生成方法,通过采用不成对的训练数据作为深度学习的训练样本,极大降低了数据采集的难度,同时可以将共有数据集或者网络上的数据作为训练样本用于训练,并将更具挑战性的照片纳入到训练集中,扩充训练集的同时丰富了数据类别。这为本方法生成简笔画算法提供了强有力的数据支撑,也是本发明最终取得良好效果的重要原因之一;本发明增强了人脸五官区域的生成表现,在原始网络的基础上使用了多个局部判别网络,包含眼睛、鼻子和嘴唇的局部判别网络,用来增强区域信息表达,很好地保留了生成的人像图中所有重要的面部特征。

119.在本说明书的描述中,参考术语“一个实施例”、“示例”、“具体示例”等的描述意指结合该实施例或示例描述的具体特征、结构、材料或者特点包含于本发明的至少一个实施例或示例中。在本说明书中,对上述术语的示意性表述不一定指的是相同的实施例或示例。而且,描述的具体特征、结构、材料或者特点可以在任何的一个或多个实施例或示例中以合适的方式结合。

120.以上公开的本发明优选实施例只是用于帮助阐述本发明。优选实施例并没有详尽叙述所有的细节,也不限制该发明仅为所述的具体实施方式。显然,根据本说明书的内容,可作很多的修改和变化。本说明书选取并具体描述这些实施例,是为了更好地解释本发明的原理和实际应用,从而使所属技术领域技术人员能很好地理解和利用本发明。本发明仅受权利要求书及其全部范围和等效物的限制。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1