神经网络模型借鉴神经认知机理和机器学习数学方法与流程

1.本发明涉及机器学习领域,具体为神经网络模型借鉴神经认知机理和机器学习数学方法。

背景技术:

2.模拟人类实际神经网络的数学方法问世以来,人们已慢慢习惯了把这种人工神经网络直接称为神经网络。神经网络在系统辨识、模式识别、智能控制等领域有着广泛而吸引人的前景,特别在智能控制中,人们对神经网络的自学习功能尤其感兴趣,并且把神经网络这一重要特点看作是解决自动控制中控制器适应能力这个难题的关键钥匙之一。

3.深度神经网络(dnn)是拥有多层感知器的架构,用来解决复杂的学习问题,然而,dnn在训练和概括中面临挑战,传统的dnn互联的大量数据可能会过拟合,需要不同的训练方法来提高泛化,导致现有机器学习无法突破大数据限制,神经网络支撑解决现实人工智能问题的范围和能力不足。

技术实现要素:

4.(一)解决的技术问题

5.针对现有技术的不足,本发明提供了神经网络模型借鉴神经认知机理和机器学习数学方法,解决了dnn互联的大量数据可能会过拟合的问题。

6.(二)技术方案

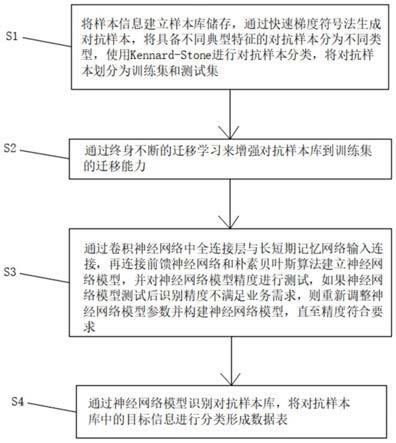

7.为实现以上目的,本发明通过以下技术方案予以实现:神经网络模型借鉴神经认知机理和机器学习数学方法,包括以下步骤:

8.s1:将样本信息建立样本库并储存,通过快速梯度符号法生成对抗样本,将具备不同典型特征的对抗样本分为不同类型,使用kennard-stone算法进行对抗样本分类,将对抗样本划分为训练集和测试集;

9.s2:通过终身不断的迁移学习来增强对抗样本库到训练集的迁移能力;

10.s3:通过卷积神经网络连接递归神经网络,再连接bp神经网络和朴素贝叶斯算法建立神经网络模型,并对神经网络模型精度进行测试,如果神经网络模型测试后识别精度不满足业务需求,则重新调整神经网络模型参数并构建神经网络模型,直至精度符合要求;

11.s4:通过神经网络模型识别对抗样本库,将对抗样本库中的目标信息进行分类形成数据表。

12.优选的,所述快速梯度符号法包括以下步骤:

13.a)计算出正向传播后的损失;

14.b)计算出图像像素的梯度;

15.c)沿着使损失最大化的梯度方向微移图像的像素。

16.优选的,所述kennard-stone算法包括以下步骤:

17.d)计算两两对抗样本之间距离,选择距离最大的两个对抗样本;

18.e)分别计算剩余的对抗样本与已选择的两个对抗样本之间的距离;

19.f)对于每个剩余对抗样本而言,其与已选对抗样本之间的最短距离被选择,然后选择这些最短距离中相对最长的距离所对应的对抗样本,作为第三个对抗样本;

20.g)重复步骤f),直至所选的对抗样本的个数等于事先确定的数目为止。

21.优选的,所述迁移学习包括终身迁移学习、在线迁移学习、深度迁移学习和对抗迁移学习。

22.优选的,所述卷积神经网络包括卷积运算、池化运算和全连接运算。

23.优选的,所述递归神经网络包括长短期记忆网络,所述卷积神经网络的全连接层与长短期记忆网络的输入端连接。

24.优选的,所述bp神经网络包括在输入层、输出层以及输入层与输出层之间增加的三层神经元并且每一层神经元包括有五个节点。

25.优选的,神经网络模型借鉴神经认知机理和机器学习数学方法的系统,包括输入模块、输出模块、存储器和处理器,所述输入模块电性连接处理器,所述存储模块和处理器电性连接,所述处理器电性连接输出模块。

26.优选的,所述存储器内存储有可由处理器运行的神经网络模型、样本库和数据表,所述输出模块用于输出所述数据表。

27.优选的,所述处理器运行时,执行所述神经网络模型借鉴神经认知机理和机器学习数学方法。

28.(三)有益效果

29.本发明提供了神经网络模型借鉴神经认知机理和机器学习数学方法。具备以下有益效果:

30.本发明通过快速梯度符号法生成对抗样本,通过终身不断的迁移学习来增强对抗样本库到训练集的迁移能力,卷积神经网络连接递归神经网络使大量信息同时具有时间空间特性,bp神经网络具有很强的非线性映射能力和柔性的网络结构,当数据呈现不同的特点时,朴素贝叶斯的分类性能不会有太大的差异,当数据集属性之间的关系相对比较独立时,朴素贝叶斯分类算法会有较好的效果,卷积神经网络连接递归神经网络可以起到对输出的文本进行分类的作用,便于形成分类的数据表,是对纯文本语言问答系统的扩展,是对图片理解和语言处理的深度融合,视频、图、文结合,真实的场景对话,带有图像的对话,文本表达更具体,提高人工智能应用范围和观察思考与表达能力,实现通过不同结构来提高泛化,使机器学习进一步突破大数据限制,提高神经网络模型支撑解决现实人工智能问题的范围和能力。

附图说明

31.图1为本发明的方法流程示意图;

32.图2为本发明的快速梯度符号法的流程示意图;

33.图3为本发明的kennard-stone算法的流程示意图;

34.图4为本发明的神经网络模型的系统示意图;

35.图5为本发明的系统框图。

stone算法用于数据集的划分,使用算法,将输入的数据集划分为训练集、测试集,并同时输出训练集和测试集在原样本集中的编号信息,方便样本的查找。

53.迁移学习包括终身迁移学习、在线迁移学习、深度迁移学习和对抗迁移学习;利用终身迁移学习可以通过终身不断地学习来增强源领域到目标领域的迁移,把在线学习和迁移学习相结合,在线迁移学习可以用于训练的源领域的数据在开始训练前并不是全部确定的,而是随着时间的推移而不断增加,充分理由源领域的数据进行训练,以便于更好的迁移到目的领域;深度迁移学习可以深度学习具有非常强的数据拟合能力,可学习到泛化能力更强的特征表达,而迁移学习能学习到领域无关的特征表达,如果通过深度神经网络利用其他领域的知识,能充分利用神经网络来学习所有领域共同具有的特征表示,将深度学习与迁移学习相结合,同时利用深度学习和迁移学习的优势;对抗迁移学习一般是单向的迁移,那么如果双向进行对抗的迁移学习的话,效果可能会更好,因为可以互相迁移而共享共有的数据和特征,双向对抗的迁移学习,尽最大努力地充分利用源领域和目标领域的数据和特征。

54.卷积神经网络包括卷积运算、池化运算和全连接运算,可以进行监督学习和非监督学习,其隐含层内的卷积核参数共享和层间连接的稀疏性使得卷积神经网络能够以较小的计算量对格点化特征,例如像素和音频进行学习、有稳定的效果且对数据没有额外的特征工程要求。

55.递归神经网络包括长短期记忆网络,卷积神经网络的全连接层与长短期记忆网络的输入端连接,便于使大量信息同时具有时间空间特性,视频、图、文结合,真实的场景对话,带有图像的对话,文本表达更具体。

56.视频相对图片描述的内容更完整。

57.bp神经网络包括在输入层、输出层以及输入层与输出层之间增加的三层神经元(这些神经元称为隐单元,它们与外界没有直接的联系,但其状态的改变,则能影响输入与输出之间的关系)并且每一层神经元包括有五个节点。

58.实施例二:

59.如图4所示,神经网络模型借鉴神经认知机理和机器学习数学方法的系统,包括输入模块、输出模块、存储器和处理器,所述输入模块电性连接处理器,所述存储模块和处理器电性连接,所述处理器电性连接输出模块。

60.存储模块电性连接处理器,存储器内存储有可由处理器运行的神经网络模型和样本库,输出模块用于输出数据表。

61.处理器运行时,执行如本说明书方法中的s1

‑‑

s4的各个步骤。

62.尽管已经示出和描述了本发明的实施例,对于本领域的普通技术人员而言,可以理解在不脱离本发明的原理和精神的情况下可以对这些实施例进行多种变化、修改、替换和变型,本发明的范围由所附权利要求及其等同物限定。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1