一种长文本分类方法、装置、电子设备和可读存储介质

1.本发明涉及人工智能技术领域,具体而言,涉及一种长文本分类方法、装置、电子设备和可读存储介质。

背景技术:

2.文本分类任务就是通过自然语言处理技术对文本进行归纳整理,挖掘文本深层信息。相关技术中对长文本的分类,尤其是医学宣教长文本内容的分类,存在一些不足。传统文本分类模型大多是面向单标签的文本分类,显然,对于宣教内容分类这种多标签文本分类问题,传统的单标签文本分类模型已经不再适用。多标签文本分类算法能够解决大多数的分类问题,目前大致可以分为两大类:基于传统机器学习的方法和基于神经网络的方法。传统机器学习的方法,如:二元关联算法(binary relevance,br)是把多标签文本分类看成多个单标签分类的问题,对每个标签使用单标签分类算法。但是br算法未能考虑标签之间的相互关系,分类过程中可能会导致一定的信息损失。相关技术考虑了多标签中标签之间的正负相关性,引入k近邻(k-nearest neighbor,knn)算法。本领域技术人员改进了支持向量机(support vector machine,svm)的时间复杂度,通过近似极值点法和分治策略提高了svm在多标签分类任务上的效率。与传统机器学习方法不同,基于神经网络的方法是通过改进卷积神经网络或者循环神经网络使模型学习文本特征,完成多标签分类。神经网络的方法优势明显,它能够有效关联到标签间的语义关系,并且针对类别较多的情况下也能保证很好的准确率。比如:本领域技术人员提出金字塔卷积神经网络(deep pyramid convolutional neural networks,dpcnn)模型可以利用卷积神经网络在预先训练的词向量上训练,实现了句子级别的分类任务。本领域技术人员融合双向长短期记忆网络(bidirectional long short-term memory,bi-lstm)和cnn结构并加入注意力机制,进行提取问句特征分类。本领域技术人员利用深度长短期记忆网络(long short-term memory,lstm)的特征映射来捕获高阶非线性特征表示,实现对问句进行分类。2018年本领域技术人员提出的深层语义表征预训练模型(bidirectional encoder representations from transformers,bert),不同于bi-lstm网络结构,它的优势在于通过多层双向transformer的编码器并且结合掩码语言机制能够最大化的挖掘语言深层的语义信息。但随着任务的复杂度增加,模型参数量越来越大,导致模型需要更长的时间去训练,并且对于算力较高。为了解决bert参数量过大的问题,本领域技术人员提出了albert(a lite bidirectional encoder representations from transformers)模型,能够大幅减少预训练模型参数量,在多个自然语言理解任务中取得了state-of-the-art的结果。

3.因此,相关技术中存在的不足是:长文本分类识别中,尤其针对一些特殊领域,相关技术无法高效、高质量地自动识别和分类长文本内容。

技术实现要素:

4.本发明解决了长文本分类识别中,尤其针对一些特殊领域,相关技术无法高效、高

质量地自动识别和分类长文本内容的问题。

5.为解决上述问题,本发明第一目的在于提供一种长文本分类方法。

6.本发明第二目的在于提供一种长文本分类装置。

7.本发明第三目的在于提供一种电子设备。

8.本发明第四目的在于提供一种可读存储介质。

9.本发明第五目的在于提供一种创建数据集的方法。

10.为实现本发明的第一个目的,本发明的实施例提供了一种长文本分类方法,其包括:将长文本内容输入到albert特征表示层,对长文本内容进行编码,提取分词特征;使用损失函数l(y,o)训练dpcnn层,dpcnn层对分词特征进行深层次的语义特征学习和提取,输出分类数据;根据分类数据对不同的分类类别进行排序,得到最终的分类结果。

11.本实施例能够达到的效果是:相比其他模型,albert模型降低了参数量,但提升了参数的利用效率,更大的发挥了参数的效果;同时,albert模型能够预测句子之间的连贯性,并能够进行跨层的参数共享。使用损失函数l(y,o)训练dpcnn层,使得模型能够更好的模型初始化,拥有更好的泛化性能,并加快目标任务的收敛速度。使用dpcnn进行特征提取能够使得特征输入和网络的拓扑结构很好的吻合;同时特征提取和模式分类能够同时进行,并同时在训练中产生;dpcnn的权重共享可减少网络的训练参数,使神经网络结构变得简单,适应性更强。

12.可以理解,对于长文本内容,使用albert编码、损失函数l(y,o)训练dpcnn层、dpcnn层进行特征提取,能够高效、高质量地自动识别和分类长文本内容。

13.在本发明的一个实施例中,对长文本内容进行编码,具体包括:albert特征表示层使用transformer双向编码器对长文本内容的字符进行编码。

14.本实施例能够达到的效果是:transformer突破了rnn模型不能并行计算的限制;相比cnn,transformer计算两个位置之间的关联所需的操作次数不随距离而增长;transformer的自注意力机制可以产生更具可解释性的模型,可以从模型中检查注意力分布,各个注意头可以学会执行不同的任务。

15.在本发明的一个实施例中,将长文本内容输入到albert特征表示层,具体包括:albert特征表示层的输入向量包括e1,e2,

…

,em;albert特征表示层的输出向量包括t1,t2,

…

,tm;其中,m为所述长文本的字符数量。

16.本实施例能够达到的效果是:为长文本内容的每个字符嵌入添加一个向量,这些向量遵循模型学习的特定模式,有助于确定每个单词的位置或序列中不同单词之间的距离,将位置向量添加到词嵌入中使得它们在接下来的运算中能够更好地表达词与词之间的距离。

17.在本发明的一个实施例中,dpcnn层对分词特征进行深层次的语义特征学习和提取,具体包括:dpcnn层通过卷积层与池化层学习和提取分词特征的深层次的语义特征,卷积层包括:conv_0、conv_1、conv_2、conv_3和conv_4。

18.本实施例能够达到的效果是:卷积层用于提取特征,池化层用于减少参数数量,全连接层用于连接所有特征,将输出值输送给分类层。

19.卷积层具有局部感知和权值共享的优点,不同层的神经单元采用局部连接的方式,即每一层的神经单元只与前一层部分神经单元相连,这样的局部连接模式保证了学习

到的卷积对输入的空间局部模式具有最强的响应;权值共享网络结构使之更类似生物神经网络,降低了网络模型的复杂度,减少了权值的数量,使神经网络结构变得更简单,适应性更强。

20.本实施例使用了多层卷积层,与没有加深层的网络相比,有加深层的网络可以使用更少的参数达到同等水平的效果。可以理解,通过加深网络,可以分层次地分解需要学习的问题,进一步地,提取了边缘的层的下一层能够使用边缘的信息,所以能高效地学习更高级的模式,通过加深层可将各层学习的问题分解成容易解决的简单问题,从而进行高效的学习。可以理解,不同的卷积核提取到的特征不一样,随着卷积次数的增加,提取的特征能够从低层次逐渐到高层次。

21.池化层的作用是特征降维,压缩数据和参数数量,降低卷积层输出的特征向量,同时改善结果,减少过拟合,提高了模型的容错性。本实施例采用max pooling,max pooling实际就是在n*n的样本中取最大值,作为采样后的样本值。跳跃遍历某个张量,并从被卷积核覆盖的元素中找出最大的数值作为卷积结果。

22.在本发明的一个实施例中,conv_0为融合多尺度的region embedding层,conv_0的卷积核大小包括2*2、3*3、4*4、5*5、6*6、7*7和8*8,不同大小的卷积核的个数均为250个;conv_1、conv_2和conv_3、conv_4分别增加了残差连接。

23.本实施例能够达到的效果是:卷积层conv_0使用上述的多尺度的卷积方式能够有效处理长文本内容,可将不同尺度的卷积核提取到的特征进行整合,形成一个包含多尺度特征的特征矩阵。

24.本实施例在conv_1、conv_2和conv_3、conv_4分别增加了残差连接。随着神经网络深度的增加,其表达能力越强,性能越好,但是也会出现梯度消散,梯度爆炸等问题。示例性地,一旦其中某一个导数很小,多次连乘后其梯度可能越来越小,对于深层网络,传递到浅层几乎就没有了;进一步地,神经网络的退化是难以训练深层网络的根本原因,虽然梯度范数大,但如果网络的可用自由度对这些范数的贡献不均衡,也就是每个层中只有少量的隐藏单元对不同的输入改变他们的激活值,而部分隐藏单元对不同的输入都是相同的反应,此时整个权重矩阵的秩不高,并且随着网络层数的增加,连乘后使得整个秩变得很低,可以理解,虽然是一个很高维的矩阵,但是部分维度没有信息,表达能力没有那么强大。而残差连接能够强制打破网络的对称性,提升网络的表征能力,使得误差能够有效地传递。

25.在本发明的一个实施例中,损失函数l(y,o)包括:

26.l(y,o)=bce(y,o)+λl2(y,o)

[0027][0028][0029]

其中,y表示类别标签的正确值,o表示分类数据的实际值,i表示第i类类别,λ为常数;

[0030]

训练使用的数据来源于数据集,数据集为经过数据样本增强处理后的数据集。

[0031]

本实施例能够达到的效果是:损失函数l(y,o)用于预训练dpcnn层,损失函数l(y,o)能够衡量模型预测的好坏,表现预测与实际数据的差距程度。

[0032]

可选地,长文本内容为医学宣教文本,医学宣教内容的分类是一种多标签分类任务,若只使用bce,很多标签将难以识别,正样本的召回率不高,因此,本实施例将多标签概率预测问题转化为一个回归问题,增加l2损失函数可以预测出更多的分类科室。

[0033]

可选地,长文本内容为医学宣教文本,由于缺少统一标准的宣教数据集,本实例建立医学宣教数据集并对其进行数据预处理与标签标注。

[0034]

优选地,采用三种数据增强方式对数据集进行样本增强,经过数据样本增强处理后的数据集,数据样本数量增加,样本特征分布更加均匀,模型能够更快拟合。

[0035]

在本发明的一个实施例中,根据分类数据对不同的分类类别进行排序,得到最终的分类结果,具体包括:分类数据使用sigmoid激活函数处理后得到分类结果。

[0036]

本实施例能够达到的效果是:sigmoid激活函数的输出映射在(0,1)之间,其单调连续,输出范围有限,比较容易优化;sigmoid激活函数求导比较容易,可以直接推导得出。可选地,在医学宣教文本中,通过上述方法处理后的长文本内容与普通文本处理方法处理后的结果相比,其特征会明显突出,易于分类。

[0037]

为实现本发明的第二目的,本发明的实施例提供了一种长文本分类装置,包括:预处理模块,用于将长文本内容输入到albert特征表示层,对长文本内容进行编码,提取分词特征;卷积神经网络模块,用于使用损失函数l(y,o)训练dpcnn层,dpcnn层对预处理模块提取的分词特征进行深层次的语义特征学习和提取,输出分类数据;分类模块,用于根据卷积神经网络模块输出的分类数据对不同的分类类别进行排序,得到最终的分类结果。

[0038]

本发明实施例的长文本分类装置实现如本发明任一实施例的长文本分类方法的步骤,因而具有如本发明任一实施例的长文本分类方法的全部有益效果,在此不再赘述。

[0039]

为实现本发明的第三目的,本发明的实施例提供了一种电子设备,包括处理器,存储器及存储在存储器上并可在处理器上运行的程序或指令,程序或指令被处理器执行时实现如本发明任一实施例的长文本分类方法的步骤。

[0040]

本发明实施例的电子设备实现如本发明任一实施例的长文本分类方法的步骤,因而具有如本发明任一实施例的长文本分类方法的全部有益效果,在此不再赘述。

[0041]

为实现本发明的第四目的,本发明的实施例提供了一种可读存储介质,可读存储介质上存储程序或指令,程序或指令被处理器执行时实现本发明任一实施例的长文本分类方法的步骤。

[0042]

本发明实施例的可读存储介质实现如本发明任一实施例的长文本分类方法的步骤,因而具有如本发明任一实施例的长文本分类方法的全部有益效果,在此不再赘述。

[0043]

为实现本发明的第五目的,本发明的实施例提供了一种创建数据集的方法,该方法采用三种数据增强方式对数据集进行样本增强,具体增强方式在具体实施方式中进行详细描述。

附图说明

[0044]

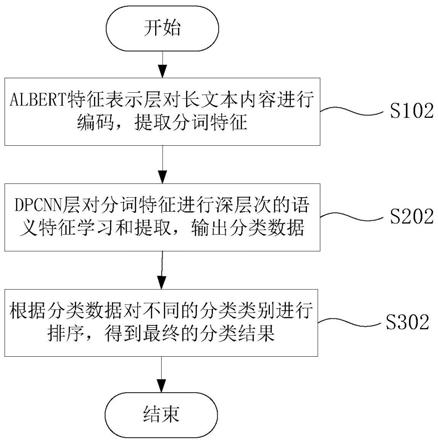

图1为本发明一些实施例的长文本分类方法的第一步骤流程图;

[0045]

图2为本发明一些实施例的长文本分类方法的第二步骤流程图;

[0046]

图3为本发明一些实施例的长文本分类方法的第三步骤流程图;

[0047]

图4为本发明一些实施例的长文本分类方法的数据集样本均衡对比图;

[0048]

图5为本发明一些实施例的长文本分类装置的结构示意图;

[0049]

图6为本发明一些实施例的电子设备的结构示意图。

具体实施方式

[0050]

为了能够更清楚地理解本发明的上述目的、特征和优点,下面结合附图和具体实施方式对本发明进行进一步的详细描述。需要说明的是,在不冲突的情况下,本技术的实施例及实施例中的特征可以相互组合。

[0051]

在下面的描述中阐述了很多具体细节以便于充分理解本发明,但是,本发明还可以采用其他不同于在此描述的其他方式来实施,因此,本发明的保护范围并不受下面公开的具体实施例的限制。

[0052]

下面参照图1至图6描述本发明一些实施例的技术方案。

[0053]

本发明的实施例提供了一种长文本分类方法、长文本分类装置、电子设备以及可读存储介质。本发明实施例的目的在于在长文本分类识别中,尤其针对以下特殊领域,高效、高质量地自动识别和分类长文本内容。

[0054]

【第一实施例】

[0055]

参见图1,本实施例提供一种长文本分类方法,该方法包括以下步骤:

[0056]

步骤s102:将长文本内容输入到albert特征表示层,对长文本内容进行编码,提取分词特征;

[0057]

步骤s202:使用损失函数l(y,o)训练dpcnn层,dpcnn层对分词特征进行深层次的语义特征学习和提取,输出分类数据;

[0058]

步骤s302:根据分类数据对不同的分类类别进行排序,得到最终的分类结果。

[0059]

本实施例中,将长文本内容中的每个词嵌入添加一个向量,输入到albert特征表示层,albert特征表示层会对输入内容进行编码,提取分词特征,输出对应的向量;albert特征表示层输出的向量作为dpcnn层的输入,dpcnn层会对分词特征进行深层次的语义特征学习和提取,输出分类数据;dpcnn层处理分类数据,将该长文本内容对应的不同的分类类别进行排序,得到最后的分类结果。

[0060]

优选的,本实施例中涉及到的将长文本内容输入到albert特征表示层,可以是人工输入,也可以是人工智能自动输入。

[0061]

需要说明的是,相比其他模型,albert模型降低了参数量,但提升了参数的利用效率,更大的发挥了参数的效果;同时,albert模型能够预测句子之间的连贯性,并能够进行跨层的参数共享。使用损失函数l(y,o)训练dpcnn层,使得模型能够更好的模型初始化,拥有更好的泛化性能,并加快目标任务的收敛速度。使用dpcnn进行特征提取能够使得特征输入和网络的拓扑结构很好的吻合;同时特征提取和模式分类能够同时进行,并同时在训练中产生;dpcnn的权重共享可减少网络的训练参数,使神经网络结构变得简单,适应性更强。

[0062]

可以理解,对于长文本内容,使用albert编码、损失函数l(y,o)训练dpcnn层、dpcnn层进行特征提取,能够高效、高质量地自动识别和分类长文本内容。

[0063]

【第二实施例】

[0064]

参见图2,本实施例提供了一种长文本分类方法。除上述实施例1的技术特征以外,本实施例进一步地包括了以下技术特征:

[0065]

对长文本内容进行编码,具体包括:albert特征表示层使用transformer双向编码器对长文本内容的字符进行编码。

[0066]

可选地,albert特征表示层使用的transformer双向编码器个数为6个,transformer双向编码器包括encoder,长文本内容输入到transformer双向编码器编码后,6层encoder的输出作为dpcnn层的输入。

[0067]

采用上述步骤的原因在于,transformer突破了rnn模型不能并行计算的限制;相比cnn,transformer计算两个位置之间的关联所需的操作次数不随距离而增长;transformer的自注意力机制可以产生更具可解释性的模型,可以从模型中检查注意力分布,各个注意头可以学会执行不同的任务。

[0068]

【第三实施例】

[0069]

参见图2,本实施例提供了一种长文本分类方法。除上述任一实施例的技术特征以外,本实施例进一步地包括了以下技术特征:

[0070]

长文本内容输入到albert特征表示层,具体包括:albert特征表示层的输入向量包括e1,e2,

…

,em;albert特征表示层的输出向量包括t1,t2,

…

,tm;其中,m为所述长文本的字符数量。

[0071]

为帮助模型理解输入字符的顺序,长文本内容输入到albert特征表示层后,首先将每个输入字符通过词嵌入算法转换为词向量。albert特征表示层包括若干编码器。

[0072]

可选地,每个字符都被嵌入为512维的向量,词嵌入过程只发生在最底层的编码器,所有编码器都有一个相同的特点,即它们接收一个向量列表,列表中的每个向量大小为512维,在最底层编码器中它就是词向量,但是在其他编码器中,它就是下一层编码器的输出。向量列表的大小是可设置的超参数,一般为训练中最长句子的长度。

[0073]

可以理解,为长文本内容的每个字符嵌入添加一个向量,这些向量遵循模型学习的特定模式,有助于确定每个单词的位置或序列中不同单词之间的距离,将位置向量添加到词嵌入中使得它们在接下来的运算中能够更好地表达词与词之间的距离。

[0074]

【第四实施例】

[0075]

参见图3,本实施例提供了一种长文本分类方法。除上述任一实施例的技术特征以外,本实施例进一步地包括了以下步骤:

[0076]

s203:albert中多层encoder的输出作为dpcnn层的输入。

[0077]

s204:采用求和的方式对albert中的多层输出进行特征融合。

[0078]

s205:第一层卷积层进行卷积操作。

[0079]

s206:第二层卷积层进行卷积操作。

[0080]

s207:第三层卷积层进行卷积操作。

[0081]

s208:第一层池化层进行池化操作。

[0082]

s209:第四层卷积层进行卷积操作。

[0083]

s210:第五层卷积层进行卷积操作。

[0084]

s211:第二层池化层进行池化操作。

[0085]

s212:全连接层输出分类数据。

[0086]

dpcnn层对分词特征进行深层次的语义特征学习和提取,具体包括:dpcnn层通过卷积层与池化层学习和提取分词特征的深层次的语义特征,卷积层包括:conv_0、conv_1、

conv_2、conv_3和conv_4。

[0087]

示例性地,albert中的多层encoder的输出作为dpcnn层的输入,然后采用求和的方式对albert中的多层输出进行特征融合,融合后的特征会通过5层卷积(conv)与2层池化(max pooling)提取深层次的语义特征。最终通过全连接层(fc)输出全部结果的分类数据。

[0088]

卷积层用于提取特征,池化层用于减少参数数量,全连接层用于连接所有特征,将输出值输送给分类层。

[0089]

卷积层具有局部感知和权值共享的优点,不同层的神经单元采用局部连接的方式,即每一层的神经单元只与前一层部分神经单元相连,这样的局部连接模式保证了学习到的卷积对输入的空间局部模式具有最强的响应;权值共享网络结构使之更类似生物神经网络,降低了网络模型的复杂度,减少了权值的数量,使神经网络结构变得更简单,适应性更强。

[0090]

本实施例使用了多层卷积层,与没有加深层的网络相比,有加深层的网络可以使用更少的参数达到同等水平的效果。可以理解,通过加深网络,可以分层次地分解需要学习的问题,进一步地,提取了边缘的层的下一层能够使用边缘的信息,所以能高效地学习更高级的模式,通过加深层可将各层学习的问题分解成容易解决的简单问题,从而进行高效的学习。可以理解,不同的卷积核提取到的特征不一样,随着卷积次数的增加,提取的特征能够从低层次逐渐到高层次。

[0091]

池化层的作用是特征降维,压缩数据和参数数量,降低卷积层输出的特征向量,同时改善结果,减少过拟合,提高了模型的容错性。本实施例采用max pooling,max pooling实际就是在n*n的样本中取最大值,作为采样后的样本值。跳跃遍历某个张量,并从被卷积核覆盖的元素中找出最大的数值作为卷积结果。

[0092]

【第五实施例】

[0093]

参见图3,本实施例提供了一种长文本分类方法。除上述实施例4的技术特征以外,本实施例进一步地包括了以下技术特征:

[0094]

conv_0为融合多尺度的region embedding层,conv_0的卷积核大小包括2*2、3*3、4*4、5*5、6*6、7*7和8*8,不同大小的卷积核的个数均为250个;conv_1、conv_2和conv_3、conv_4分别增加了残差连接。

[0095]

每层卷积核包括若干卷积核,第一层卷积层conv_0为融合多尺度的region embedding层,其包含的卷积核大小包括上述7中,且个数均为250个。可以理解,每一个卷积核输出一个对应的结果,多个卷积核就会输出对应个数的特征结果,堆叠在一起就会输出一个有深度的特征矩阵。

[0096]

可选地,其他卷积层使用普通的文本处理卷积。

[0097]

需要说明的是,卷积层conv_0使用上述的多尺度的卷积方式能够有效处理长文本内容,可将不同尺度的卷积核提取到的特征进行整合,形成一个包含多尺度特征的特征矩阵。

[0098]

本实施例在conv_1、conv_2和conv_3、conv_4分别增加了残差连接。随着神经网络深度的增加,其表达能力越强,性能越好,但是也会出现梯度消散,梯度爆炸等问题。示例性地,一旦其中某一个导数很小,多次连乘后其梯度可能越来越小,对于深层网络,传递到浅层几乎就没有了;进一步地,神经网络的退化是难以训练深层网络的根本原因,虽然梯度范

数大,但如果网络的可用自由度对这些范数的贡献不均衡,也就是每个层中只有少量的隐藏单元对不同的输入改变他们的激活值,而部分隐藏单元对不同的输入都是相同的反应,此时整个权重矩阵的秩不高,并且随着网络层数的增加,连乘后使得整个秩变得很低,可以理解,虽然是一个很高维的矩阵,但是部分维度没有信息,表达能力没有那么强大。而残差连接能够强制打破网络的对称性,提升网络的表征能力,使得误差能够有效地传递。

[0099]

【第六实施例】

[0100]

参见图4,本实施例提供了一种长文本分类方法。除上述任一实施例的技术特征以外,本实施例进一步地包括了以下技术特征:

[0101]

损失函数l(y,o)包括:

[0102]

l(y,o)=bce(y,o)+λl2(y,o)

[0103][0104][0105]

其中,y表示类别标签的正确值,o表示分类数据的实际值,i表示第i类类别,λ为常数;

[0106]

训练使用的数据来源于数据集,数据集为经过数据样本增强处理后的数据集。

[0107]

损失函数l(y,o)用于预训练dpcnn层,损失函数l(y,o)能够衡量模型预测的好坏,表现预测与实际数据的差距程度。

[0108]

可选地,长文本内容为医学宣教文本,医学宣教内容的分类是一种多标签分类任务,若只使用bce,很多标签将难以识别,正样本的召回率不高,因此,本实施例将多标签概率预测问题转化为一个回归问题,增加l2损失函数可以预测出更多的分类科室。

[0109]

可选地,长文本内容为医学宣教文本,由于缺少统一标准的宣教数据集,本实例建立医学宣教数据集并对其进行数据预处理与标签标注。

[0110]

优选地,采用三种数据增强方式对数据集进行样本增强:

[0111]

1.同科室病种名称替换:预先收集的每个科室下所有存在的病种名称,首先利用jieba分词器对句子进行分词,对病种名称进行同科室病种名称替换,比如:肝胆外科存在的诊断有:肝叶囊肿,肝囊肿,那么对于文本“肝囊肿健康宣教”可以替换为“肝叶囊肿健康宣教”。

[0112]

2.随机口语注入:随机加入"啊"、"哦"等语气词。

[0113]

3.随机位置交换:在宣教文本中,随机选择两个词,位置交换,该过程重复100次。

[0114]

参见图4,通过以上三种方式,原有数据进行样本增强后的数据分布明显均匀。

[0115]

可以理解,经过数据样本增强处理后的数据集,数据样本数量增加,样本特征分布更加均匀,模型能够更快拟合。

[0116]

【第七实施例】

[0117]

本实施例提供了一种长文本分类方法。除上述任一实施例的技术特征以外,本实施例进一步地包括了以下技术特征:

[0118]

根据分类数据对不同的分类类别进行排序,得到最终的分类结果,具体包括:分类数据使用sigmoid激活函数处理后得到分类结果。

[0119]

需要说明的是,本实施例完成的分类操作由dpcnn层完成,即dpcnn层输出分类数据,分类数据由docnn层继续使用sigmoid激活函数处理后输出分类结果。

[0120]

本实施例中,sigmoid激活函数的输出映射在(0,1)之间,其单调连续,输出范围有限,比较容易优化;sigmoid激活函数求导比较容易,可以直接推导得出。可选地,在医学宣教文本中,通过上述方法处理后的长文本内容与普通文本处理方法处理后的结果相比,其特征会明显突出,易于分类。

[0121]

【第八实施例】

[0122]

参见图5,本实施例提供了一种长文本分类装置401,包括:预处理模块402,用于将长文本内容输入到albert特征表示层,对长文本内容进行编码,提取分词特征;卷积神经网络模块403,用于使用损失函数l(y,o)训练dpcnn层,dpcnn层对预处理模块402提取的分词特征进行深层次的语义特征学习和提取,输出分类数据;分类模块404,用于根据卷积神经网络模块403输出的分类数据对不同的分类类别进行排序,得到最终的分类结果。

[0123]

【第九实施例】

[0124]

参见图6,本实施例提供了一种电子设备501,包括处理器502,存储器503及存储在存储器503上并可在处理器502上运行的程序或指令,程序或指令被处理器502执行时实现如本发明任一实施例的长文本分类方法的步骤。

[0125]

【第十实施例】

[0126]

本实施例提供了一种可读存储介质,可读存储介质上存储程序或指令,程序或指令被处理器执行时实现本发明任一实施例的长文本分类方法的步骤。

[0127]

虽然本发明披露如上,但本发明并非限定于此。任何本领域技术人员,在不脱离本发明的精神和范围内,均可作各种更动与修改,因此本发明的保护范围应当以权利要求所限定的范围为准。

[0128]

【第十一实施例】

[0129]

参见图1、图2和图3,本实施例提供了一种长文本分类方法,其包括以下步骤:

[0130]

s104:将长文本内容通过词嵌入算法转换为词向量,输入到transformer双向编码器;

[0131]

s106:transformer双向编码器对输入向量编码,提取特征;

[0132]

s108:transformer双向编码器输出向量;

[0133]

s203:albert中多层encoder的输出作为dpcnn层的输入;

[0134]

s204:采用求和的方式对albert中的多层输出进行特征融合;

[0135]

s205:第一层卷积层进行卷积操作;

[0136]

s206:第二层卷积层进行卷积操作;

[0137]

s207:第三层卷积层进行卷积操作;

[0138]

s208:第一层池化层进行池化操作;

[0139]

s209:第四层卷积层进行卷积操作;

[0140]

s210:第五层卷积层进行卷积操作;

[0141]

s211:第二层池化层进行池化操作;

[0142]

s212:全连接层输出分类数据;

[0143]

s302:dpcnn层使用sigmoid激活函数处理全连接层输出分类数据,得到最终的分

类结果。

[0144]

在本说明书的描述中,术语“一个实施例”、“一些实施例”、“具体实施例”等的描述意指结合该实施例或示例描述的具体特征、结构、材料或特点包含于本发明的至少一个实施例或示例中。在本说明书中,对上述术语的示意性表述不一定指的是相同的实施例或示例。而且,描述的具体特征、结构、材料或特点可以在任何的一个或多个实施例或示例中以合适的方式结合。

[0145]

需要说明的是,在本文中,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者装置不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者装置所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在包括该要素的过程、方法、物品或者装置中还存在另外的相同要素。此外,需要指出的是,本技术实施方式中的方法和装置的范围不限按示出或讨论的顺序来执行功能,还可包括根据所涉及的功能按基本同时的方式或按相反的顺序来执行功能,例如,可以按不同于所描述的次序来执行所描述的方法,并且还可以添加、省去、或组合各种步骤。另外,参照某些示例所描述的特征可在其他示例中被组合。

[0146]

通过以上的实施方式的描述,本领域的技术人员可以清楚地了解到上述实施例方法可借助软件加必需的通用硬件平台的方式来实现,当然也可以通过硬件,但很多情况下前者是更佳的实施方式。基于这样的理解,本技术的技术方案本质上或者说对现有技术做出贡献的部分可以以计算机软件产品的形式体现出来,该计算机软件产品存储在一个存储介质(如rom/ram、磁碟、光盘)中,包括若干指令用以使得一台终端(可以是手机,计算机,服务器,或者网络设备等)执行本技术各个实施例所述的方法。

[0147]

上面结合附图对本技术的实施例进行了描述,但是本技术并不局限于上述的具体实施方式,上述的具体实施方式仅仅是示意性的,而不是限制性的,本领域的普通技术人员在本技术的启示下,在不脱离本技术宗旨和权利要求所保护的范围情况下,还可做出很多形式,均属于本技术的保护之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1