确定语义无碰撞空间的方法与流程

1.本公开涉及确定车辆环境中的语义无碰撞空间的方法。

背景技术:

2.对于现代车辆中的安全功能和驾驶员辅助系统,重要的是确定车辆前方的可行驶区域。此外,自主驾驶强烈依赖于确定这种可行驶区域的能力。如果可行驶区域的坐标是可用的,则可以对车辆的导航采取适当决定和动作。

3.为了检测车辆前方的可行驶区域,通常基于由单个摄像头拍摄的图像并通过使用分割技术的直接方法来确定二维无碰撞空间。对于该任务,可以有效地使用深度神经网络。

4.然而,如果基于单个摄像头的图像或基于来自另一单个传感器的数据来确定车辆前方的无碰撞空间,则存在关于确定深度(即,从安装有摄像头的宿主车辆到车辆环境中的其它要素的距离)的问题。然而,到最近障碍物的距离是正确导航的关键参数。尽管根据摄像头图像来可靠地估计距离的方案是可用的,但结果可能受到例如变化的天气条件和空气透明度的影响。

5.此外,对于正确的导航,应当知道限制车辆前方的无碰撞空间的障碍物的类型。换言之,车辆环境中的对象的语义分类应当是可用的,即,对象是否是另一车辆、行人或导致车道不可用于行驶的一些碎片。

6.因此,需要一种能够确定到车辆环境中的对象的准确距离以及该对象的类型的方法和系统。

技术实现要素:

7.本公开提供了一种计算机实现的方法、计算机系统和非暂时性计算机可读介质。在说明书和附图中给出了实施方式。

8.在一个方面,本公开涉及一种确定车辆的环境中的语义无碰撞空间的计算机实现的方法,所述车辆包括摄像头和传感器,所述传感器被配置成提供距离信息。根据所述方法,经由所述摄像头从所述车辆的所述环境拍摄二维视觉图像,并且在所述视觉图像内确定无碰撞空间的界限。经由所述传感器,捕获车辆的环境中的对象相对于车辆的三维距离数据。将所述距离数据指派给所述视觉图像,并且基于所指派的距离数据,将所述无碰撞空间的界限从所述视觉图像转移到关于所述车辆的鸟瞰图。在所述视觉图像中识别对象,并且针对各个所识别的对象确定边界框和分类。从所识别的对象选择限制所述无碰撞空间的对象,并且将各个所选择的对象的相应边界框指派给所述无碰撞空间在所述鸟瞰图中的界限。最后,根据所选择的对象的各个边界框的分类,对所述无碰撞空间的所述界限的段进行分类。

9.在一方面,本方法提供了相对于车辆的可行驶无碰撞空间在鸟瞰图坐标系中的界限。该坐标系包括两个轴,并且可以被限定在与车辆当前行驶的车道相切的平面中。因此,在鸟瞰图中,从上方观看该平面。

10.另外,该界限包括在语义上分类的段,并且针对该段,识别限制无碰撞空间的对象的类型。因此,段可以被认为是语义段,并且该方法的整个输出可以被称为语义无碰撞空间。

11.由于在执行该方法之后,到相对于车辆的最接近对象的距离及最接近对象的类型是已知的,所以可以基于语义无碰撞空间提供的信息,关于车辆的导航(例如在自主驾驶中)采取适当的决定和动作。此外,摄像头和传感器可以同时捕获它们各自的数据,即二维视觉图像和三维距离数据。由于同时捕获,可以提高由该方法提供的输出(即语义无碰撞空间)的准确性和可靠性。

12.摄像头可以是单目摄像头或立体摄像头,其通常在现代车辆中可用。传感器可以是lidar或者雷达传感器或者能够提供距离或深度信息的任何其它合适的传感器。因此,关于执行该方法的硬件没有特别的要求。

13.所识别的对象的边界框可以是在视觉图像内完全包围相应对象的二维框,并且可以由例如x坐标和y坐标的相应最大值和最小值来限定。换句话说,边界框可以在视觉图像中由四个数字简单地限定。所识别的对象的分类包括相应对象的类型,即对象是例如另一车辆、行人还是仅是车道上的一些碎片。

14.该方法可以包括以下特征中的一个或更多个特征:

15.无碰撞空间的界限可以通过将第一神经网络应用于视觉图像来确定。此外,无碰撞空间的界限可以包括无碰撞空间的连续延伸的轮廓,并且轮廓可以通过应用边界跟踪算法来确定。将距离数据指派给无碰撞空间的界限的步骤可以包括对距离数据应用投影变换,该投影变换将三维距离数据投影到二维视觉图像,并且将无碰撞空间的界限从视觉图像转移到鸟瞰图的步骤可以包括对界限应用投影变换的逆变换。

16.无碰撞空间的界限可以包括在视觉图像中表示的多个界限点,并且将无碰撞空间的界限从视觉图像转移到鸟瞰图的步骤还可以包括针对各个界限点从所指派的距离数据选择预定数量的最接近点,并且将各个界限点相对于车辆的距离估计为最接近点的距离的平均值。

17.确定各个所识别的对象的边界框和分类的步骤可以包括将第二神经网络应用于视觉图像,并且确定分类的步骤可以包括当应用第二神经网络时估计各个边界框的类别概率。另外,可以基于各个边界框的类别概率,确定无碰撞空间的界限的各个段的确定性分数。

18.可以基于三维距离数据来确定各个边界框的中心的相对于车辆的相应距离,并且可以将各个边界框的中心的距离指派给无碰撞空间在鸟瞰图的中的界限。各个边界框的中心的距离可以基于预定数量的所指派的距离数据来确定,所述预定数量的所指派的距离数据最接近边界框的相应中心。

19.对象可以仅在以下情况下被选择,以将其边界框指派给所述无碰撞空间的所述界限:该对象的边界框的中心到所指派的距离数据中的至少一个距离数据的距离小于预定距离。无碰撞空间的界限的段可以按照相对于车辆的固定且预定的方位角等分。

20.根据实施方式,无碰撞空间的界限可以通过将第一神经网络应用于视觉图像来确定。第一神经网络可以是卷积神经网络,其可以在视觉图像内执行道路分割。由于第一神经网络,可以提供关于无碰撞空间的界限的快速确定。

21.无碰撞空间的界限还可以包括无碰撞空间的连续延伸的轮廓。该轮廓可以通过应用边界跟踪算法来确定。连续延伸的轮廓可以是无碰撞空间边界的清晰且直接的表示。另外,边界跟踪算法可以提供轮廓的快速确定。

22.根据另一实施方式,将距离数据指派给无碰撞空间的界限的步骤可以包括对距离数据应用投影变换,该投影变换将三维距离数据投影到二维视觉图像。另外,将无碰撞空间的界限从视觉图像转移到鸟瞰图的步骤可以包括将投影变换的逆变换应用于该界限。投影变换可以为距离数据提供关于视觉图像的明确指派。通过使用成对的投影变换及其逆变换,可以减少用于执行该方法的数学工作量和计算工作量。

23.无碰撞空间的界限可以包括在视觉图像中表示的多个限制点。将无碰撞空间的界限从视觉图像转移到鸟瞰图的步骤还可以包括:针对各个界限点从所指派的距离数据选择预定数量的最接近点,并且将各个界限点相对于车辆的距离估计为最接近点的距离的平均值。可以例如通过使用k-d树来从距离数据点选择相对于各个界限点的最接近点。最接近点是来自距离数据的到相应界限点具有最短距离的那些点。另外,加权平均可用于估计界限点的距离。平均值的权重可以取决于最接近点到界限点的相应距离。如果计算这种平均值或加权平均值以对各个界限点的距离进行估计,则可以提高该估计的可靠性。

24.根据另一实施方式,针对各个所识别的对象确定边界框和分类的步骤可以包括将第二神经网络应用于视觉图像。第二神经网络也可以是卷积神经网络,其允许在视觉图像内快速创建边界框。由于可以使用单个视觉图像,基于第二神经网络的边界框和分类的这种确定可以被称为单步多框检测(single shot multi-box detection)。

25.另外,确定分类的步骤可以包括当应用第二神经网络时估计各个边界框的类别概率。类别概率可以为包围预定类别或类型的对象的特定边界框提供确定性值。因此,类型概率可以允许对对象识别进行评估。

26.此外,可以基于各个边界框的类别概率,确定无碰撞空间的界限的各个段的确定性分数。也就是说,确定性分数可以是对基于各个边界框的相应分类概率的语义无碰撞空间确定的可靠性的量度。当对车辆的导航(例如在自主驾驶中)采取决定或动作时,确定性分数可能是有价值的。

27.根据另一实施方式,可以基于三维距离数据来确定各个边界框的中心相对于车辆的相应距离。各个边界框的中心相对于车辆的距离可以被指派给无碰撞空间在鸟瞰图中的界限。对于该指派,可以再次应用投影变换的逆变换,该投影变换之前可以用于将距离数据指派给无碰撞空间的界限。由于指派了各个边界框的中心而不是边界框的多个点,因此由于仅指派了中心,可以减少该方法的数学工作量和计算工作量。

28.各个边界框的中心相对于车辆的距离还可以基于预定数量的所指派的距离数据来确定,所述预定数量的所指派的距离数据最接近边界框的相应中心。详细地,中心的距离可以是最接近的所指派的距离数据点的距离的平均值。另外,对象可以仅在以下情况下被选择,以将其边界框指派给所述无碰撞空间的所述界限:相应边界框的中心到所指派的距离数据点中的至少一个距离数据点的距离小于预定距离。通过这种方式,可以将相对于经投影的距离点没有“合理距离”(即,到由传感器检测到的距离数据点的距离太大)的对象从其边界框到鸟瞰坐标系中的无碰撞空间表示的指派中排除。

29.此外,无碰撞空间的界限的段可以按照相对于车辆的固定且预定的方位角等分。

由于在鸟瞰图坐标系中限定了界限的段,因此在鸟瞰图中也限定了方位角。通过恒定方位角的这种分割可以是进一步的直接方式,以减少该方法的计算工作量。

30.在另一方面,本公开涉及一种确定车辆的环境中的语义无碰撞空间的系统。该系统包括摄像头、传感器、无碰撞空间模块和分类模块。摄像头被配置成从车辆的环境拍摄二维视觉图像,而传感器被配置成捕获车辆的环境中的对象相对于车辆的三维距离数据。所述无碰撞空间模块被配置成:在所述视觉图像内确定无碰撞空间的界限,将所述距离数据指派给所述视觉图像,以及基于所指派的距离数据来将所述无碰撞空间的界限从所述视觉图像转移到关于所述车辆的鸟瞰图。分类模块被配置成在视觉图像中识别对象,并针对各个所识别的对象确定边界框和分类。分类模块还被配置成:从所识别的对象选择限制无碰撞空间的对象,将各个所选择的对象的相应边界框指派给无碰撞空间在鸟瞰图中的界限,以及根据所选择的对象的各个边界框的分类,对无碰撞空间的界限的段进行分类。

31.如本文所使用的,术语模块可以指是以下项的一部分或包括以下项:专用集成电路(asic)、电子电路、组合逻辑电路、现场可编程门阵列(fpga)、执行代码的处理器(共享、专用或组)、提供所述功能的其它合适的组件或者上述的一些或全部的组合,诸如在片上系统中。术语模块可以包括存储由处理器执行的代码的存储器(共享、专用或组)。

32.总之,根据本公开的系统包括摄像头、传感器和两个模块,该摄像头、传感器和两个模块被安装在车辆中并且被配置成执行以上针对对应方法描述的步骤。因此,如上所述的用于该方法的益处、优点和公开内容对于根据本公开的系统也是有效的。

33.在另一方面,本公开涉及一种计算机系统,所述计算机系统被配置成执行本文所述的计算机实现的方法的多个或所有步骤。

34.计算机系统可以包括处理单元、至少一个存储单元和至少一个非暂时性数据存储部。非暂时性数据存储部和/或存储单元可以包含用于指示计算机执行本文描述的计算机实现的方法的多个或所有步骤或方面的计算机程序。

35.在另一方面,本公开涉及一种非暂时性计算机可读介质,所述非暂时性计算机可读介质包含用于执行本文所述的计算机实现的方法的多个或所有步骤或方面的指令。所述计算机可读介质可以被配置成:光学介质,诸如光盘(cd)或数字多功能盘(dvd);磁介质,诸如硬盘驱动器(hdd);固态驱动器(ssd);只读存储器(rom);闪速存储器;等。此外,该计算机可读介质可以被配置成可以经由诸如互联网连接的数据连接来访问的数据存储部。计算机可读介质例如可以是在线数据储存库或云存储。

36.本公开还涉及一种指示计算机执行本文所述的计算机实现的方法的多个或所有步骤或方面的计算机程序。

附图说明

37.本文结合以下示意性示出的附图描述本公开的示例性实施方式和功能:

38.图1示出了包括根据本公开的系统的车辆的示意图;

39.图2示出了由如图1所示的系统的摄像头拍摄的视觉图像;

40.图3是从如图2所示的视觉图像确定的无碰撞空间的表示;

41.图4示出了图3的无碰撞空间的轮廓;

42.图5示出了投影到如图2所示的视觉图像上的三维距离数据;

43.图6示出了被指派给来自图4的无碰撞空间的轮廓的来自图5的三维距离数据;

44.图7示出了被转移到鸟瞰图坐标系的如图3和图4所示的无碰撞空间的表示;

45.图8示出了在来自图2的视觉图像中识别的对象的边界框;

46.图9示出了三维距离数据到如图8所示的边界框的指派;

47.图10示出了来自图8和图9的边界框到鸟瞰图坐标系中的无碰撞空间的轮廓的指派;以及

48.图11示出了如图10所示的无碰撞空间的轮廓的分类段。

49.附图标记列表

50.11 车辆

51.12 系统

52.13 摄像头

53.14 传感器

54.15 无碰撞空间模块

55.16 分类模块

56.17 视觉图像

57.18 道路

58.19 车道

59.20 道路边界

60.21 客车

61.23 卡车

62.25 无碰撞空间

63.27 不可行驶区域

64.29 无碰撞空间的界限

65.30 轮廓

66.31 经变换的轮廓

67.33 三维距离数据

68.35 鸟瞰图坐标系

69.37 角

70.38 x轴

71.39 y轴

72.41 边界框

73.43 分类

74.45 类别概率

75.51 经变换的边界框

76.53 经变换的边界框的中心

77.55 分类段

具体实施方式

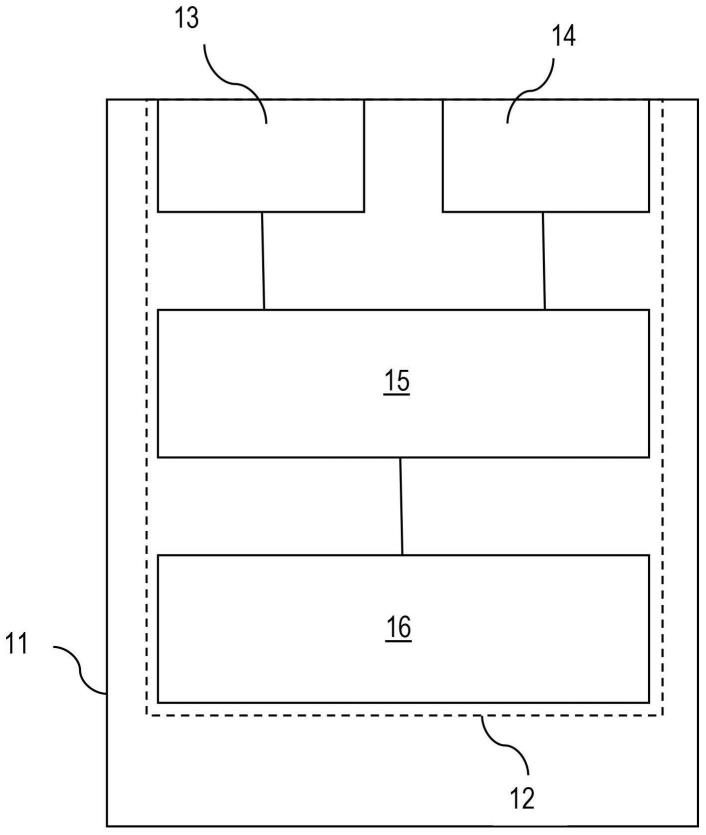

78.图1示意性地示出了宿主车辆11,宿主车辆11包括监测车辆11的环境的摄像头13

和传感器14。摄像头13和传感器14属于系统12,该系统12根据本公开来确定车辆11的环境中的语义无碰撞空间。系统12还包括无碰撞空间模块15和分类模块16,该无碰撞空间模块15和分类模块16彼此连接并且被提供有来自摄像头13和来自传感器14的数据。

79.摄像头13是提供二维视觉图像(例如,如图2中的摄像头图像17所示)的单目摄像头。传感器14(参见图1)通常是针对车辆11的环境中的对象提供三维距离数据的传感器。在本示例中,传感器14是lidar传感器。然而,作为另选方式,雷达传感器也可以用于传感器14,或者提供距离或深度信息的任何合适的传感器也可以用于传感器14。

80.图2示出了由摄像头13(参见图1)提供的视觉图像17。视觉图像17是宿主车辆11前方的环境的二维表示。视觉图像17包括车辆11前方的道路18,道路18包括三个车道19以及道路18的边界20,该边界20由引导栏杆表示。另外,视觉图像17还包括车辆11前方的对象或障碍物,即在车辆11前方或在相反车道中行驶的其它客车21和卡车23。道路18的边界20和其它车辆(即,客车21和卡车23)限制了宿主车辆11可用的可行驶区域。

81.图3示出了从如图2所示的视觉图像17得出的无碰撞空间25的表示。详细地,将第一卷积神经网络应用于如图2所示的二维视觉图像17,该二维视觉图像17能够以摄像头13(参见图1)提供的像素数据的形式获得。经由卷积神经网络,为无碰撞空间25确定界限29(参见图3)。因此,图3的由27表示的上部部分表示当前不可用于宿主车辆11的导航的不可行驶区域。无碰撞空间25的界限29由包括第一神经网络的无碰撞空间模块15(参见图1)确定。

82.图4附加地示出了轮廓30,该轮廓沿着无碰撞空间25与不可行驶区域27之间的界限29(也如图3所示)连续延伸。轮廓30是通过应用边界跟踪算法来确定的,其示例在本领域中是已知的。

83.图5示出了来自图2的视觉图像17以及由传感器14提供的三维数据点33的投影。也就是说,由传感器14捕获的三维数据33经由投影变换被变换到视觉图像17的平面,以便提供如图5所示的数据点33的表示。详细地,数据点33由lidar系统提供并且表示下一个障碍物或对象相对于宿主车辆11的相应最短距离。

84.如在图5中可以认识到的,距离数据点33的一部分被指派给相应的客车21,而距离点33的另一部分被指派给道路18的边界20。

85.图6示出了三维距离数据33到如图3和图4所示的无碰撞空间25的表示的指派。详细地,由传感器14提供的距离数据33被与如图4所示的无碰撞空间25的连续轮廓30的相应点相关。

86.为了将经投影的距离数据33指派给界限29或轮廓30的点,针对轮廓30的各个点确定来自经投影的距离数据点33的固定数量(例如1至5)的最接近点。来自距离数据33的相对于轮廓30的点的最接近点是在图6的表示内相对于轮廓30的某一点具有最短距离的那些点。为了确定相对于轮廓30的点的最接近点33或最近相邻点33,可以使用本领域已知的有效方法,如k-d树。

87.为了针对轮廓30的各个点确定相对于宿主车辆11的距离或“深度”,针对轮廓30的各个点来估计最接近距离数据点33的测量距离的平均值。该平均值可以是加权平均值,其中,各个权重取决于到轮廓30的所考虑的点的相应距离。

88.轮廓30的点的估计距离或深度用于将轮廓30变换到图7所示的鸟瞰图坐标系35。

对于该变换,使用投影变换的逆变换,该投影变换被应用于将由传感器14提供的三维距离数据33投影到视觉图像17(如图5所示)。

89.如图7所示,鸟瞰图坐标系35包含x轴38和y轴39,该x轴38和y轴39位于与宿主车辆11当前行驶的车道的切线平行的平面中。换言之,在图7中,从上方观察宿主车辆11前方的环境。在图7的鸟瞰图坐标系35中,再次示出了由界限29或经变换的轮廓31限制的无碰撞空间25,该经变换的轮廓31已经使用由来自传感器14的三维距离数据33提供的距离信息来从根据视觉图像17的表示(参见图3和图4)变换到图7的鸟瞰图。在鸟瞰图坐标系35中,通过应用移动平均而进行的平滑化被用于轮廓31的x坐标和y坐标,以便实现无碰撞空间25的经变换的轮廓31的平滑化表示。

90.在接近宿主车辆11的区域中,无碰撞空间25根据表示摄像头13的仪器视场的角度37而被限制。另外,在鸟瞰图坐标系35内示出了来自传感器14的三维距离数据33的投影。由于基于来自传感器14的三维距离数据33来确定属于轮廓31的点的相应距离,因此距离数据33的投影被定位在鸟瞰图坐标系35中的轮廓31处。

91.图7所示的无碰撞空间25表示宿主车辆11前方的可行驶区域。然而,对于如图7所示的轮廓31的点,尚未知道无碰撞空间或可行驶区域25被哪种类型的对象限制。然而,对于与宿主车辆11的导航有关的动作,期望具有与限制无碰撞空间25的对象有关的附加信息,即,例如,无碰撞空间25是否被如图2所示的汽车21的另一车辆或被行人或被位于车道19(参见图2)中的一个车道上的碎片限制。根据限制无碰撞空间25的对象的类型,可以对宿主车辆11的导航采取不同的决定或动作。换言之,期望与宿主车辆11的环境中的对象有关的附加“语义”信息。

92.为了提供这种语义信息,在由摄像头13提供的视觉图像17内识别对象,如图8所示。针对各个所识别的对象,一起确定二维边界框41与对象的分类43。详细地,在视觉图像17内确定x坐标和y坐标的相应最小值和最大值,以便确定在视觉图像17内包围相应对象的相应边界框41的帧。另外,如图8所示,针对各个边界框41确定分类43,即,相应边界框包围汽车还是卡车。也就是说,项目“汽车”和“卡车”描述了所识别的对象中的各个对象的相应检测类别或分类43。此外,针对各个边界框41确定检测确定性或类别概率45。

93.为了确定各个边界框41的位置(即,各个边界框41在视觉图像17内的坐标)、分类43和分类概率45,将第二卷积神经网络应用于视觉图像17的像素数据。使用卷积神经网络基于视觉图像17对边界框41以及分类43和类别概率45进行确定也被称为单步多框检测(ssd),因为先前没有执行视觉图像17的分割。第二卷积神经网络被包括在分类模块16中(参见图1)。该模块还执行如下所述的所有另外的方法步骤。

94.为了使边界框41以及它们的分类43和类别概率45与如图7所示的无碰撞空间25相关,针对各个边界框41确定中心,并且针对各边界框41的各个中心,根据由传感器14提供的三维距离数据的投影来确定最接近点33。在图9中,表示三维距离数据33的投影的点33与边界框41一起示出。

95.三维距离数据点33到视觉图像17的投影与图5所示的相同。因此,在将距离数据点33指派给边界框41的相应中心之前,不需要关于这些点的附加计算。针对边界框41的各个中心,以与用于图4和图6所示的轮廓30的点相同的方式,确定固定数量(例如1至5)的最接近数据点33。也就是说,针对边界框41的各个中心确定固定数量的数据点33,这些数据点33

具有到边界框41的相应中心的最短距离。再次,针对边界框41的各个中心计算最接近数据点33的距离的平均值或加权平均值,以便确定边界框41的各个中心相对于宿主车辆11的深度或距离。

96.然而,仅选择边界框41的、在视觉图像17内到最接近距离数据点33的距离小于预定距离的那些中心用于进一步的处理,即用于变换到鸟瞰图坐标系35。通过这种方式,仅选择边界框41的“合理地”接近距离数据点33中的至少一个距离数据点的那些中心。

97.例如,如图9所示的客车21的边界框41各自包括距离点33,该距离点33非常接近相应边界框41的中心。相反,卡车23的边界框41不包括接近相应边界框41的中心的距离数据点33。因此,仅选择图9所示的客车的边界框41用于进一步的过程,并变换到图10所示的鸟瞰图坐标系35。

98.图10示出了图7已经示出的鸟瞰图坐标系35中的车辆11前方的无碰撞空间25。无碰撞空间25由经变换的轮廓31限定,在经变换的轮廓31上也示出了三维距离数据33。

99.另外,图10示出了指派给轮廓31的经变换的边界框51。图8和图9所示的边界框41经由与轮廓30(参见图4和图6)相同的变换(即,用于将三维距离数据33投影到视觉图像17的投影变换的逆变换)从视觉图像17变换到鸟瞰图坐标系35。

100.详细地,将边界框41(参见图8、图9)的相应中心从视觉图像17变换到鸟瞰图坐标系35中的边界框41的中心53。另外,通过将第二神经网络应用于视觉图像17,边界框41的语义也是已知的。也就是说,针对各个边界框41,对于如图10所示的表示,相应对象的类型或类别是已知的。对于本示例,在图10中,已知三个边界框51各自表示汽车21。

101.最后,车辆11前方的无碰撞空间25的轮廓31按照相对于车辆11的预定方位角等分,并且如果轮廓31的各个段55包括边界框51的中心53,则通过将该相应段55指派给边界框51的中心53(参见图10)的相应分类来对该段55进行分类。在图11中示出了分类段55,其包括与图10相同的无碰撞空间25的表示。即,轮廓31的段55被分类为“客车”21,这意味着车辆11前方的无碰撞空间25在分类段55处被客车21(参见图2)限制。

102.总之,根据本公开的方法经由第一神经网络确定鸟瞰图中车辆前方的无碰撞空间25的界限或轮廓31,并且另外,经由第二神经网络确定轮廓31的段的语义,使得将知道无碰撞空间25的哪个部分受到哪种对象的限制。在没有边界框的中心能够被指派给轮廓31的特定段的情况下,可以为这些段假定默认分类,例如分类为道路18的边界20(见图2)或由摄像头13的仪器视场限制。

103.此外,基于经由第二神经网络为各个边界框41确定的类别概率45,估计轮廓31的各个分类段55的确定性分数。通过轮廓31的段(见图11)表示的确定性分数和语义无碰撞空间可以用于宿主车辆11的导航(例如,在自主驾驶中)。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1