一种特定指标下的联邦学习激励方法与流程

1.本发明提供一种特定指标下的联邦学习激励方法,属于分布式机器学习领域,具体提供了一种特定指标下的联邦学习激励方法。

背景技术:

2.随着机器学习技术的不断发展,数据安全已经成为一个不可避免的问题,而联合学习作为一种新的分布式机器学习模型可以很好地解决数据隐私问题。基本的联合学习模型解决了数据隐私问题,但像人群感知、这样的技术还存在另一个问题,即数据岛和平台服务器之间的协作变得低效。因此,设计适当的激励机制,使每个参与者和社会的利益最大化,是普遍的做法。

3.联邦学习激励机制的主要研究方向有stackelberg博弈、拍卖、契约理论、shapley值、强化学习、区块链等。其中,stackelberg博弈可以很好地构建联合学习各相关主体之间的关系,即平台服务器与数据岛之间的关系描述为主从博弈之间的关系。然而,目前的研究主要集中在理论上构建的指标不确定条件下的复杂激励机制。但在现实中,训练模型的精度可能只满足具体指标的要求。即出现未结合现实情况,仅以得出理论最优解为目的,而忽略了实际操作过程中的模型精度冗余问题,可能会导致成本增加问题;未有效将数据质量和数据数量作为激励机制的依据。

技术实现要素:

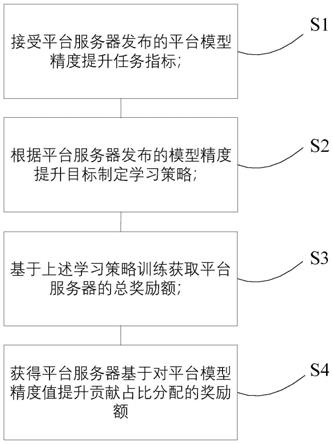

4.鉴于上述问题,本发明提供了一种特定指标下的联邦学习激励方法,适用于平台服务器与多个数据孤岛间协作,包括如下步骤,

5.s1:接受平台服务器发布的平台模型精度提升任务指标;

6.s2:根据平台服务器发布的模型精度提升目标制定学习策略;

7.s3:基于上述学习策略训练获取平台服务器的总奖励额;

8.s4:获得平台服务器基于对平台模型精度值提升贡献占比分配的奖励额。

9.进一步的,步骤s2中,数据孤岛基于自身效用最大化制定学习策略,具体步骤如下,

10.1)建立数据孤岛的效用模型:

11.ui=r

i-ci,i∈(1,...,n),

ꢀꢀ

(1)

12.设定ci=v

iai

+μiqi,δθi=σlog

κ

(q

i ai);

13.其中,ui为数据孤岛i的效用,ri表示数据孤岛i获得的奖励,ci表示数据孤岛i的训练成本,δθi表示数据孤岛i对模型训练精度的提升值,ai为数据数量,qi为数据质量,vi为数据孤岛i的数据计算、存储成本综合参数,μi为数据孤岛i的数据处理成本参数,κ>1为训练参数,σ为精度参数;

14.2)基于数据孤岛效用最大化,针对上述效用模型建立目标函数:

[0015][0016]

其中,数据孤岛i的决策变量为其参与训练的数据集数量ai及数据质量qi,即自身的效用最大化策略;基于第二阶段就是数据孤岛之间的纳什均衡博弈:解决第二阶段博弈,

[0017]

qi的一阶导数:

[0018][0019]ai

的一阶导数:

[0020][0021]

计算海森矩阵:

[0022][0023][0024][0025][0026][0027]

求解方程组:

[0028][0029]

得到其参与训练的决策变量为:

[0030][0031]

进一步的,平台服务器基于自身效果最大化做出相应的总奖励额,具体步骤如下:

[0032]

1)建立平台服务器总奖励信息计算模型:

[0033]

u=v-r,

ꢀꢀ

(3)

[0034]

设定,

[0035]

其中,u为平台服务器所获得的效用,v表示模型总估值增量设定为常数,r表示平台服务器所付出的总激励成本,γ为平台决策的平均奖励额,n为数据孤岛的个数;

[0036]

2)基于第一阶段平台服务器与数据孤岛的博弈,使得平台服务器效用最大化,建立其目标函数为:

[0037][0038]

其中,平台服务器的决策变量为平台提供的平均奖励额γ;

[0039]

将上述代入平台服务器目标函数中,得

[0040][0041]

γ的一阶导数:

[0042][0043]

令一阶导数为零得:

[0044][0045]

通过求解可以得出:

[0046][0047]

平台服务器方的最优策略值为γ

*

,即实际的总奖励额。

[0048]

进一步的,采用数据孤岛决策变量数据集数量ai及数据质量qi,通过δθi=σlog

κ

(q

i ai)计算特定孤岛对平台模型训练所提升的精度值与贡献值占比;平台服务器根据占比分配激励:

[0049][0050][0051]

根据(6)、(7)有:

[0052]

本发明提出的一种在特定模型精度指标下的两阶段联邦学习激励机制,可以更加同实际相结合,降低了不必要的成本浪费,而且从数据质量与数据数量的角度设计的激励机制更加全面、科学,系统性地提高了联邦学习的训练效率。

附图说明

[0053]

图1为本发明的总流程示意图;

[0054]

图2为特定精度指标下的一次训练的联邦学习模型示意图;

具体实施方式

[0055]

为了使本发明的目的、技术方案及优点更加清楚明白,以下结合附图及实施例,对本发明进行进一步详细说明。应当理解,此处所描述的具体实施例仅用以理解本发明,并不用于限定本发明。

[0056]

参考图1,本发明提供了一种特定指标下的联邦学习激励方法,适用于平台服务器与多个数据孤岛间协作,包括如下步骤,所述各个数据孤岛,

[0057]

s1:接受平台服务器发布的平台模型精度提升任务指标;

[0058]

s2:根据平台服务器发布的模型精度提升目标制定学习策略;

[0059]

s3:基于上述学习策略训练获取平台服务器的奖励额;

[0060]

s4:获得平台服务器基于对平台模型精度值提升贡献占比分配的总奖励额。

[0061]

研究假设主要包括两个:数据孤岛训练数据成本与数据质量、数量有关;数据模型的精度提升也与数据质量、数量相关。采用stackelberg博弈分析:两阶段博弈的第一阶段就是服务器与数据孤岛之间的主从博弈;两阶段博弈的第二阶段就是数据孤岛之间的纳什均衡博弈,其意义就是,对于任意数据孤岛i,其最终的策略结果就是其效用最大的结果,即任何其他策略的效用都没有其最终的策略效用大。当所有的数据孤岛都满足要求时,就可以说各个数据孤岛之间达到了纳什均衡状态。

[0062]

具体实施方式如下:

[0063]

s1:接受平台服务器发布的平台模型精度提升任务指标;

[0064]

s2:根据平台服务器发布的模型精度提升目标制定学习策略;

[0065]

数据孤岛基于自身效用最大化制定学习策略,具体步骤如下,

[0066]

1)建立数据孤岛的效用模型:

[0067]

ui=r

i-ci,i∈(1,...,n),

ꢀꢀ

(1)

[0068]

设定ci=v

iai

+μiqi,δθi=σlog

κ

(q

i ai);

[0069]

其中,ui为数据孤岛i的效用,ri表示数据孤岛i获得的奖励;ci表示数据孤岛i的训练成本;δθi表示数据孤岛i对模型训练精度的提升值,ai为数据数量,qi为数据质量,vi为数据孤岛i的数据计算、存储成本综合参数,为已知固定参数;μi为数据孤岛i的数据处理成本参数,为已知固定参数;κ>1为训练参数,σ为精度参数,均为已知固定参数。数据数量ai越高,数据计算、存储成本越高;数据质量qi越高,数据处理成本越高。而数据质量、数据数量越高,模型参数的精度提升δθi越容易,但一定数据质量与数据质量的提升对模型参数精度的提升呈边际递减规律。

[0070]

2)基于数据孤岛效用最大化,针对上述效用模型建立目标函数:

[0071][0072]

其中,数据孤岛i的决策变量为其参与训练的数据集数量ai及数据质量qi,条件下的最优策略,即自身的效用最大化策略;基于第二阶段就是数据孤岛之间的纳什均衡博弈:其意义就是,对于任意数据孤岛i,其最终的策略结果就是其效用最大的结果,即任何其他策略的效用都没有其最终的策略效用大。当所有的数据孤岛都满足要求时,就可以说各个数据孤岛之间达到了纳什均衡状态。

[0073]

解决第二阶段博弈,以确定每个数据孤岛的自身效用最大化下的最优数据数量和数据质量局部精度目标:

[0074]

qi的一阶导数:

[0075][0076]ai

的一阶导数:

[0077][0078]

计算海森矩阵:

[0079][0080][0081][0082][0083][0084]

求解方程组:

[0085][0086]

得到参与学习数据最优策略:

[0087][0088]

s3:基于上述学习策略训练获取平台服务器的总奖励额;

[0089]

1)建立平台服务器总奖励信息计算模型:

[0090]

u=v-r,

ꢀꢀ

(3)

[0091]

设定,

[0092]

其中,u为平台服务器所获得的效用,v表示模型总估值增量,即模型的估计价值的增加量,是平台或第三方根据具体实际模型的现实条件所确定的,因此可合理假设为相应

确定常数;r表示平台服务器所付出的总激励成本,γ为平台决策的平均奖励额,即平台通过决策这个平均奖励额来调整激励程度,进而实现对整个激励机制的调控,最终会根据数据孤岛训练情况得出一个对平台来说效用最大的平均奖励额数值,n为数据孤岛的个数;

[0093]

2)由于训练模型参数精度为服务器平台给定值,服务器平台的效用函数为基于数据质量的模型增量估值减去支出的总激励r,只需要保障服务器平台支出的总激励r越小,服务器的效用就越大。所以,服务器平台的目标函数为:

[0094][0095]

其中,平台服务器的决策变量为平台提供的平均奖励额γ;

[0096]

将上述代入平台服务器目标函数中,得

[0097][0098]

γ的一阶导数:

[0099][0100]

令一阶导数为零得:

[0101][0102]

通过求解可以得出:

[0103][0104]

平台服务器方的最优策略值为γ

*

,其意义就是当确定特定模型精度要求之后,平台服务器只需要做出相应的奖励额,就可以使得在获得特定模型精度的前提下,自身效用最大化。

[0105]

s4:根据单个数据孤岛对平台模型精度值提升贡献的精度值占比进行总奖励额分配。

[0106]

采用上述数据集数量ai及数据质量qi,通过δθi=σlog

κ

(q

i ai)计算特定孤岛对平台模型训练所提升的精度值;平台服务器根据占比分配激励:

[0107][0108][0109]

根据(6)、(7)有:

[0110]

本方案中数据质量评估一般包括一致性、完整性、适时性,平台发布一种包括数据类型、数据完整度、数据适时性三个指标的十三维表,即数据类型、数据完整度、数据适时性分别对应三个维度,在每个维度上在都在0-1区间的值来表示。这三种指标平台的标准都为1,然后数据孤岛通过将自己的数据输入表后进行比对,即数据类型维度是数据孤岛自身拥有的数据类型占平台提供的类型种类的多少;数据完整度是数据孤岛自身拥有的数据占平

台提供的完整程度的多少;数据适时性是数据孤岛自身拥有的数据时效占平台提供的时效标准的多少。最后通过对三项指标的加权平均来实现各个数据孤岛的数据质量的量化。

[0111]

参考图2所示,本发明提出的联邦学习激励机制模型主要针对的是在特定模型精度指标要求下的一次训练的情况。因为在现实中,我们往往遇到的是针对特定精度指标下的要求,因此,这样不仅使得训练机制效率更高,也不会出现训练精度过高而浪费训练成本的情况。另外,虽然模型训练过程可能会出现多轮的情况,但是我们将一次训练机制分析清楚,然后上次的结束也可以当成这次的开始,只不过是多次重复而已,所以本发明的机制对其进行了简化。

[0112]

以上所述仅为本发明的较佳实施例而已,并不用以限制本发明,凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1