一种基于协同对比损失的小样本异质人脸转换方法

1.本发明涉及图像处理技术领域,尤其涉及一种基于协同对比损失的小样本异质人脸转换方法。

背景技术:

2.从不同环境和光线中拍摄的异质人脸图像会使面部外观发生显著变化,并会引起同一人的脸产生大的变化性质。然而,基于可见域人脸图像训练的人脸识别模型很难识别来自低光区域的人脸,这给异构人脸识别(hfr)带来了很大的挑战。异质人脸转化的目的是合成相似的人脸图像,该图像保留源域输入图像的身份信息,并引入目标域参考图像的风格。虽然目前的方法需要在训练时访问源域和目标域中具有相同身份信息的图像且取得了很大的成功。但我们认为这极大地限制了异质人脸转化的应用。

3.鉴于gans在图像合成方面的最新突破,face-to-face translation已被广泛应用,包括跨模态表情生成、面部风格转化、年龄编辑等。上述方法的核心特征是在引用目标人脸的同时保留目标人脸中的所有特征。这正是异构人脸转化(hft)弥合域差异所需要的。虽然这些方法可以生成照片真实感和身份保持(保留人脸中所有特征)的异质人脸图像,但是即使提出的dvg和dvgface 可以用身份信息丰富身份多样性,它们都有一个共同的前提:训练集保存身份匹配的异质人脸图像,从图1的左半部分可以看出,不同姿势、表情和视图的脸都可以看出是同一人。在应用程序中,从不同的采集设置中判定为同一个人的要求是很难的。而且完全无法从几张不明确身份的人脸图像中概括出结果。当人类看到许多不同的物体时,很容易想象出一个新物体的不同的视觉角度。因此我们提出了一个少样本学习的face-to-face translation框架,目的在于学习hft模型,这个模型通过利用少数外来身份的人脸图像,将源域中的人脸图像映射到具有相同身份特征的类似图像。该模型在训练过程中从未用过在目标域中有着相同身份的图像,但被要求在训练时合成它们,并在测试时进行概括,如图1右侧所示。然而,基于少样本的hft有两个需要解决的问题:1)多样的异构人脸合成,2)合成图像的身份一致性。

4.因此,提出一种基于协同对比损失的小样本异质人脸转换方法,解决现有技术中存在的问题,是本领域技术人员亟需解决的问题。

技术实现要素:

5.有鉴于此,本发明提供了一种基于协同对比损失的小样本异质人脸转换方法,保证异构人脸图像的多样性和身份一致性。

6.为了实现上述目的,本发明采用如下技术方案:

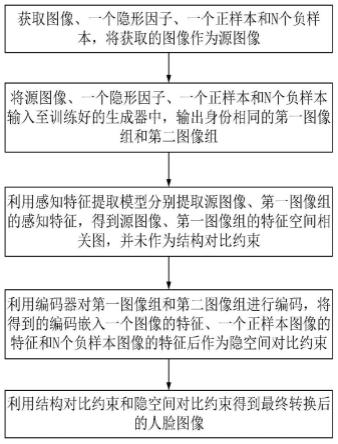

7.一种基于协同对比损失的小样本异质人脸转换方法,包括以下步骤:

8.获取图像、一个隐形因子、一个正样本和n个负样本,将获取的图像作为源图像;

9.将源图像、一个隐形因子、一个正样本和n个负样本输入至训练好的生成器中,输出身份相同的第一图像组和第二图像组;

10.利用感知特征提取模型分别提取源图像、第一图像组的感知特征,得到源图像、第一图像组的特征空间相关图,并作为结构对比约束;

11.利用编码器对第一图像组和第二图像组进行编码,将得到的编码嵌入一个图像的特征、一个正样本图像的特征和n个负样本图像的特征后作为隐空间对比约束;

12.利用结构对比约束和隐空间对比约束得到最终转换后的人脸图像。

13.可选的,生成器的训练过程为:输入源图像和隐形因子,输出训练后的图像,其中隐形因子服从正态分布。

14.可选的,生成器的总损失计算公式如下:

[0015][0016]

其中,l

adv

(g,d)为对抗损失函数,l

lacontra

(g)为潜在对比正则化函数, l

stcontra

(g)为结构对比正则化函数;γ为超参数,g为生成器,d为判别器。

[0017]

可选的,生成器的对抗损失计算公式如下:

[0018]

l

adv

(g,d)=e[log(d(y))]+e[log(1-d(x,z))]

ꢀꢀꢀꢀꢀꢀ

(2)

[0019]

其中,x为来自源域的输入图像,y为来自目标域的参考图像,z为隐形因子。

[0020]

可选的,生成器的合作对比损失包括潜在对比正则化损失和结构对比正则化损失。

[0021]

可选的,潜在对比正则化损失计算公式如下:

[0022][0023]

其中,τ为用于控制损失大小的尺度,e为图像的特征,e

+

为正样本图像的特征。

[0024]

可选的,结构对比正则化损失计算公式如下:

[0025][0026]

其中,为第i个点的结构化损失,n

st

为点的数量。

[0027]

可选的,第i个点的结构化损失的计算公式如下:

[0028][0029]

其中,为在和的余弦相似度,为xi的向量,为的向量,ζ为尺度因子。

[0030]

可选的,获取的图像来自casia nir-vis 2.0上和中大学生数据集。

[0031]

经由上述的技术方案可知,与现有技术相比,本发明提供了一种基于协同对比损失的小样本异质人脸转换方法:首次提出了一个称为cocongan的少样本的无监督异构人脸转化框架,以解除异构人脸图像之间身份匹配的限制(无需配对数据);提出了一种协同对比的损失算法,可以共同保证异构人脸图像的多样性和身份一致性;在casia nir-vis 2.0上和中大学生数据集进行的大量实验表面,cocongan取得了较好的结果,并证明我们的方法具有良好的泛化性能。

附图说明

[0032]

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据提供的附图获得其他的附图。

[0033]

图1为基于相同身份的异质人脸生成和小样本多样化异质人脸生成对比图;

[0034]

图2为本发明提供的一种基于协同对比损失的小样本异质人脸转换方法流程图;

[0035]

图3为本发明提供的一种用于异质人脸转换的框架cocongan;

[0036]

图4为同一身份下成对异质人脸图像的自相似性比较示意图;

[0037]

图5为casia nir-vis 2.0和中大学生的高频音质视觉比较。

具体实施方式

[0038]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0039]

参照图2所示,本发明公开了一种基于协同对比损失的小样本异质人脸转换方法,包括以下步骤:

[0040]

获取图像、一个隐形因子、一个正样本和n个负样本,将获取的图像作为源图像;

[0041]

将源图像、一个隐形因子、一个正样本和n个负样本输入至训练好的生成器中,输出身份相同的第一图像组和第二图像组;

[0042]

利用感知特征提取模型分别提取源图像、第一图像组的感知特征,得到源图像、第一图像组的特征空间相关图,并作为结构对比约束;

[0043]

利用编码器对第一图像组和第二图像组进行编码,将得到的编码嵌入一个图像的特征、一个正样本图像的特征和n个负样本图像的特征后作为隐空间对比约束;

[0044]

利用结构对比约束和隐空间对比约束得到最终转换后的人脸图像。

[0045]

可选的,生成器的训练过程为:输入源图像和隐形因子,输出训练后的图像,其中隐形因子服从正态分布。

[0046]

进一步的,生成器的总损失计算公式如下:

[0047][0048]

其中,l

adv

(g,d)为对抗损失函数,l

lacontra

(g)为潜在对比正则化函数, l

stcontra

(g)为结构对比正则化函数;γ为超参数,g为生成器,d为判别器。

[0049]

可选的,生成器的对抗损失计算公式如下:

[0050]

l

adv

(g,d)=e[log(d(y))]+e[log(1-d(x,z))]

ꢀꢀꢀꢀꢀꢀꢀꢀ

(2)

[0051]

其中,x为来自源域的输入图像,y为来自目标域的参考图像,z为隐形因子。

[0052]

进一步的,生成器的合作对比损失包括潜在对比正则化损失和结构对比正则化损失。可获得具有相同身份的大量新的多样性异构人脸图像。

[0053]

可选的,潜在对比正则化损失计算公式如下:

[0054][0055]

其中,τ为用于控制损失大小的尺度,e为图像的特征,e

+

为正样本图像的特征。

[0056]

进一步的,结构对比正则化损失计算公式如下:

[0057][0058]

其中,为第i个点的结构化损失,n

st

为点的数量。该损失函数可以使相对应的点接近,不对应的点远离,不用管视觉外观如何就可以精确地表达异质人脸图像的结构差异。

[0059]

参见图4所示,为相同身份的面部区域在不考虑域差异的情况下表现出自相似性的示意图。因此,我们采用空间自相似性来测量x和^y之间的差异。

[0060]

可选的,第i个点的结构化损失的计算公式如下:

[0061][0062]

其中,为在和的余弦相似度,为xi的向量,为的向量,ζ为尺度因子。

[0063]

进一步的,获取的图像来自casia nir-vis 2.0上和中大学生数据集。

[0064]

参见图3所示,为实现多样性和身份一致性,提出了一种用于异质人脸转换的框架cocongan。输入图像x结合一个查询隐码z,一个正样本z

+

,和n个从高斯分布采样得到的负样本z-,输入到生成器g中,得到身份相同的输出和然后将输出输入到编码器g

enc

得到输出的编码嵌入e, e

+

和该编码器与g共享了一些层。隐空间对比正则化用于鼓励多样性。利用预训练模型f分别提取图像x,的感知特征f

x

,特征的空间相关图s

x

,用于保证身份一致性。

[0065]

综上,本发明将hft扩展到了一个更具挑战性和新颖的少镜头无监督异构face-to-face translation环境。此外,没有采用各种常规条目进行复杂的限制,只有三个条目明确规定共同指导hft。

[0066]

通过定性和定量实验对cocongan进行评估的具体内容如下:

[0067]

数据集:casia nirvis 2.0和cuhk student。对于casia nir-vis 2.0,为确保nir和vis中的身份不重复,我们从nir中选择了前290人的图像,从vis中选择了最后290人的图像。对于cuhk student,我们会调整数据集 photo和sketch中图像的顺序,以确保两个数据集中的图像不会配对。

[0068]

评估指标:采用kid、is和lpips进行评估。kid和is用于评估生成图像的视觉质量,lpips用于评估生成图像的多样性。

[0069]

对比方法:将本发明的方法与divco和dvgface进行对比。divco使用与cocongan相同的未配对少样本训练集,而dvg face仅使用源域和目标域中存在相同身份的配对训练集。在测试过程中,我们只为divco、dvg face 和cocongan提供目标数据集。

[0070]

定性评估:图5显示了hft结果的视觉对比。我们可以看到,dvg人脸严重依赖在训练中身份匹配一致。divco生成的图像的视觉效果是有改善,但由于缺乏身份一致性的限制,训练出来的图像y和输入的图像x之间仍然存在身份差异(即不是同一人)。具有潜在对比和结构对比规则化的 cocongan不仅生成了多样的样本,而且保持了身份一致性。

[0071]

定量评价:如表1所示与kid、is、lpips的定量比较,箭头表示更好的方向。具体而言,多样性和身份一致性之间存在权衡。因此,在身份一致性的前提下,cocongan的样本多样性必然会受到影响,并且由于dvg-face 不受身份一致性的限制,lpips的值是最大的。

[0072]

表1.

[0073][0074]

结论:异质人脸图像以多种形式出现:高分辨率和低分辨率;素描和线描;面部表情和面部动画;热红外、近红外和可见光人脸图像。本研究主要研究异质人脸的转化。为此,我们提出了一个cocongan,并在两个异构人脸数据集上进行了多个实验,从定性和定量的角度验证了该方法的有效性。

[0075]

对所公开的实施例的上述说明,按照递进的方式进行,使本领域专业技术人员能够实现或使用本发明。对这些实施例的多种修改对本领域的专业技术人员来说将是显而易见的,本文中所定义的一般原理可以在不脱离本发明的精神或范围的情况下,在其它实施例中实现。因此,本发明将不会被限制于本文所示的这些实施例,而是要符合与本文所公开的原理和新颖特点相一致的最宽的范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1