一种基于AR技术的视频透视方法与流程

一种基于ar技术的视频透视方法

技术领域

1.本发明涉及增强现实技术领域,尤其涉及一种基于ar技术的视频透视方法。

背景技术:

2.目前,头戴式ar设备主要有两种显示方式:视频透视式(video see-through)和光学透视式(optical see-through)。透视式指ar设备使用半透明镜片,人眼可直接透过镜片看到外部的现实景象。视频透视式指将摄像头采集到的图像与叠加的信息叠加后以视频或图像流的方式在虚像屏幕上显示,虚像屏幕显示图像与人眼直接看到的现实画面不重合,即虚实不重合。光学透视式指通过光学原理和设备将增强的信息直接叠加在人眼透过镜片看到的现实画面中的相应位置上,屏幕上只显示增强的信息。后者不存在虚实不重合的问题,但对硬件设备及软件技术的要求非常高。对于视频透视式ar设备而言,由于虚实不重合产生的重影会对用户造成视觉干扰。

3.此外,传统的视频透视式显示方式中,由于现实场景的画面是跟随ar设备的移动而改变的,而虚拟图像则是不变的,因此,在ar设备移动后,容易造成虚拟图像在屏幕中的位置与原位置不符,影响用户的体验。

技术实现要素:

4.有鉴于此,本发明所要解决的技术问题是:提供一种基于ar技术的视频透视方法,能够增强ar设备在现实状态中的定位准确性,增强虚拟图像在现实图像中的显示效果,提高用户体验。

5.为解决上述技术问题,本发明的技术方案是:

6.一种基于ar技术的视频透视方法,所述方法包括如下步骤:

7.s1、采用双目相机获取当前现实状态中的现实图像;

8.s2、通过处理器接收所述现实图像,确定关键帧图像,并基于所述关键帧图像,确定当前的第一位姿数据;

9.s3、采用imu传感器,获取imu测量数据,并对加速度值和角速度值进行积分运算,获取第二位姿数据;

10.s4、对所述第一位姿数据和所述第二位姿数据进行卡尔曼融合,依据融合后得到的位姿信息,生成第一坐标系;

11.s5、所述处理器调用存储器中的虚拟图像,确定在显示屏中进行显示的第二坐标系,并与所述第一坐标系建立位置变换关系;

12.s6、所述处理器将所述虚拟图像与所述现实图像进行叠加,依据所述位置变换关系,将叠加图像显示于显示屏上。

13.优选的,所述s1步骤中,还包括:

14.s11、所述双目相机中的左目相机、右目相机分别获取左目图像和右目图像;

15.s12、对所述左目图像和所述右目图像进行时间同步。

16.优选的,所述s2步骤中,还包括:

17.s21、所述处理器对同一时间戳印记上的左目图像和右目图像进行整合,形成完整的所述关键帧图像。

18.优选的,所述s6步骤中,还包括:

19.s61、通过距离传感器对双目相机与当前现实状态中的物体之间确定相对距离;

20.s62、基于所述相对距离的改变,与所述现实图像的尺寸变化,建立对应的尺寸变换关系;

21.s62、基于所述尺寸变换关系,所述处理器改变所述虚拟图像在所述显示屏上的尺寸大小,以适应所述现实图像的尺寸变化。

22.采用了上述技术方案后,本发明的有益效果是:

23.本发明中,公开了基于ar技术的视频透视方法,包括:s1、采用双目相机获取当前现实状态中的现实图像;s2、通过处理器接收现实图像,确定关键帧图像,并基于关键帧图像,确定当前的第一位姿数据;s3、采用imu传感器,获取imu测量数据,并对加速度值和角速度值进行积分运算,获取第二位姿数据;s4、对第一位姿数据和第二位姿数据进行卡尔曼融合,依据融合后得到的位姿信息,生成第一坐标系;s5、处理器调用存储器中的虚拟图像,确定在显示屏中进行显示的第二坐标系,并与第一坐标系建立位置变换关系;s6、处理器将虚拟图像与现实图像进行叠加,依据位置变换关系,将叠加图像显示于显示屏上。本发明中,将通过双目相机获取的第一位姿数据和通过imu传感器获取的第二位姿数据,进行融合,生成第一坐标系,增强了ar设备在现实状态中的定位准确性,第一坐标系与虚拟图像的第二坐标系建立位置变换关系,基于第一坐标系的准确性,将虚拟图像与现实图像进行叠加,进行显示,增强了虚拟图像在现实图像中的显示效果,提高了用户体验。

24.在本发明中,s6步骤中,还包括:s61、通过距离传感器对双目相机与当前现实状态中的物体之间确定相对距离;s62、基于相对距离的改变,与现实图像的尺寸变化,建立对应的尺寸变换关系;s62、基于尺寸变换关系,处理器改变虚拟图像在显示屏上的尺寸大小,以适应现实图像的尺寸变化。通过对相对距离和尺寸建立尺寸变换关系,改变虚拟图像在显示屏上得到尺寸大小,能够让用户在靠近现实图像中的某一物体时,在本物体上的虚拟图像能够进行适应性改变大小,增强用户体验。

附图说明

25.下面结合附图和实施例对本发明进一步说明。

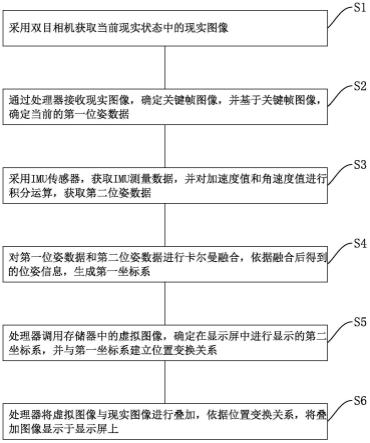

26.图1是本发明实施例的流程图。

具体实施方式

27.为了使本发明的目的、技术方案及优点更加清楚明白,以下结合附图及实施例,对本发明进行进一步详细说明。应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不用于限定本发明。

28.如图1所示,本发明包括如下步骤:

29.s1、采用双目相机获取当前现实状态中的现实图像;

30.所述s1步骤中,还包括:

31.s11、所述双目相机中的左目相机、右目相机分别获取左目图像和右目图像;

32.s12、对所述左目图像和所述右目图像进行时间同步。

33.s2、通过处理器接收现实图像,确定关键帧图像,并基于关键帧图像,确定当前的第一位姿数据;

34.所述s2步骤中,还包括:

35.s21、所述处理器对同一时间戳印记上的左目图像和右目图像进行整合,形成完整的所述关键帧图像。

36.s3、采用imu传感器,获取imu测量数据,并对加速度值和角速度值进行积分运算,获取第二位姿数据;

37.s4、对第一位姿数据和第二位姿数据进行卡尔曼融合,依据融合后得到的位姿信息,生成第一坐标系;

38.s5、处理器调用存储器中的虚拟图像,确定在显示屏中进行显示的第二坐标系,并与第一坐标系建立位置变换关系;

39.s6、处理器将虚拟图像与现实图像进行叠加,依据位置变换关系,将叠加图像显示于显示屏上。

40.本发明中,将通过双目相机获取的第一位姿数据和通过imu传感器获取的第二位姿数据,进行融合,生成第一坐标系,增强了ar设备在现实状态中的定位准确性,第一坐标系与虚拟图像的第二坐标系建立位置变换关系,基于第一坐标系的准确性,将虚拟图像与现实图像进行叠加,进行显示,增强了虚拟图像在现实图像中的显示效果,提高了用户体验。

41.所述s6步骤中,还包括:

42.s61、通过距离传感器对双目相机与当前现实状态中的物体之间确定相对距离;

43.s62、基于所述相对距离的改变,与所述现实图像的尺寸变化,建立对应的尺寸变换关系;

44.s62、基于所述尺寸变换关系,所述处理器改变所述虚拟图像在所述显示屏上的尺寸大小,以适应所述现实图像的尺寸变化。

45.通过对相对距离和尺寸建立尺寸变换关系,改变虚拟图像在显示屏上得到尺寸大小,能够让用户在靠近现实图像中的某一物体时,在本物体上的虚拟图像能够进行适应性改变大小,增强用户体验。

46.以上所述仅为本发明的较佳实施例而已,并不用以限制本发明,凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1