基于保留动力学过程使用稀疏网络鲁棒地分类图片的方法

1.本发明属于机器学习中图片分类和对抗训练领域,具体涉及基于保留动力学过程使用稀疏网络鲁棒地分类图片的方法。

背景技术:

2.深度神经网络由于其近年来在性能上的巨大提升而被广泛地用作最先进的机器学习分类系统。同时,正如szegedy所指出的,最先进的深度神经网络通常容易受到对抗样本的攻击,这些样本在人眼里是可以区分的,但却可以欺骗分类器做出任意的预测。这种不理想的特性可能会使深度神经网络无法应用于安全敏感的应用中。各种对抗性防御方法随后被提出,来应对对抗样本的攻击。然而,大多数防御方法很快就被新的对抗攻击方法打破。madry提出的对抗训练(aleksander madry,aleksandar makelov,ludwig schmidt,dimitris tsipras,and adrian vladu.towards deep learn-ing models resistant to adversarial attacks.in international conference on learning representations,2018.)是为数不多的仍能抵抗对抗性攻击的方法之一。

3.另一方面,深度神经网络经常被发现是高度过度参数化的。网络剪枝已经被证明是一种出色的方法,可以大大减少模型的大小。典型的剪枝算法遵循"训练-剪枝-微调"的三步走策略,"不重要的"权重按照一定的评分策略进行剪枝,例如根据权重的大小来决定参数的重要性程度。然而,用继承的权重对一个修剪过的模型进行微调,只能得到与用随机初始化的权重训练该模型相当或更差的性能,这表明继承的"重要"权重对于微调不一定有用。

4.jaehoon lee提出,模型输出的动态变化可以完全由神经切线核(ntk)和初始网络输出来描述。因此,两个神经网络之间的动力学过程差异可以通过其神经正切核和初始预测的差异来量化。基于这一结果,tianlin liu提出了neural tangent transfer(ntt)(参考文献,chaoqi wang,guodong zhang,and roger grosse.picking winning tickets before training by preserving gradient flow.in international conference on learning representations,2019)来寻找可训练的稀疏神经网络,通过控制密集和稀疏网络之间的神经正切核距离和预测距离来保留模型输出的动态性。

5.另一方面,frankle和carbir在2020年提出了彩票假说(lottery ticket hypothesis),它指出对于一个密集网路,总存在一个子网络结构,如果单独训练,可以达到与原始网络相当的性能。这样的子网络被称为中奖彩票(winnning ticket)。中奖彩票的存在使得可以从头开始训练一个具有良好性能的稀疏网络。特别是,ntt作为一种预见性的剪枝方法,在正常训练背景下提供了对彩票假说的验证。

6.对于对抗性的研究分为两个领域:攻击和防御。对抗性攻击方法的目的是愚弄那些最先进的网络。一般来说,攻击方法包括白盒攻击和黑盒攻击,它取决于攻击者能掌握多少关于模型的信息。白盒攻击被广泛用于生成对抗性样本,用于训练或测试模型的鲁棒性,其中攻击者可以拥有关于模型的所有信息,包括文献1ian goodfellow,jonathon shlens,

and christian szegedy.explaining and harnessing adversarial examples.in inter-national conference on learning representations,2015提出的fast gradient sign method,文献2,seyed-mohsen moosavi-dezfooli,alhussein fawzi,and pascal frossard.deepfool:a simple and accurate method to fool deep neural networks.in proceedings of the ieee conference on computer vision and pattern recognition(cvpr),june 2016提出的deep fool,文献3,francesco croce and matthias hein.reliable evaluation of adversarial robustness with an ensemble of diverse parameter-free attacks.in icml,2020提出的autoattack等等。黑盒攻击,例如文献4,pin-yu chen,huan zhang,yash sharma,jinfeng yi,and cho-jui hsieh.zoo:zeroth order optimization based black-box attacks to deep neural networks without training substitute models.aisec’17,page 15

–

26,new york,ny,usa,2017.association for computing machine,文献5,thibault maho,teddy furon,and erwan le merrer.surfree:a fast surrogate-free black-box attack.in proceedings of the ieee/cvf conference on comput vision and pattern recognition(cvpr)通常是为了攻击现实中应用的模型而开发的,因此对模型结构或参数的信息非常有限。

7.同时,人们研究了防御方法来训练一个对抗性鲁棒的网络,它可以防止来自对抗样本的攻击。其中最受欢迎的一种方法是,用较强的对抗攻击算法产生对抗样本,然后用这些生成的对抗样本进行强化训练。madry提出的投影梯度下降法projected gradient descent(pgd)就是通过迭代生成对抗性样本和利用对抗样本进行参数更新来解决min-max问题。这种方法被称为对抗训练。对抗训练的性能已经被参考文献6,zhuozhuo tu,jingwei zhang,and dacheng tao.theoretical analysis of adversarial learning:a minimax approach.in h.wallach,h.larochelle,a.beygelzimer,f.d'alch

é‑

buc,e.fox,and r.garnett,editors,advances in neural information processing systems在理论上证明。此外,还有参考文献7ali shafahi,mahyar najibi,mohammad amin ghiasi,zheng xu,john dickerson,christoph studer,larry s davis,gavin taylor,and tom goldstein.adversarial training for free!in h.wallach,h.larochelle,a.beygelzimer,f.d'alch

é‑

buc,e.fox,and r.garnett,editors,advances in neural information processing systems提出的共享最大化问题与最小化问题的梯度,参考文献8,eric wong,leslie rice,and j.zico kolter.fast is better than free:revisiting adversarial training.in international conference on learning representations,2020提出的通过随机初始化来加速训练等方法来加快对抗训练在大规模数据集(如imagenet)上的训练速度。

8.网络剪枝近年来被广泛研究,用于减少模型大小,提高深度神经网络的推理效率。由于现代神经网络总是被过度参数化的,所以人们开发了剪枝方法来去除训练后的密集网络中不重要的参数,以减轻这种冗余。根据剪枝的粒度,现有的修剪方法可以大致分为两类,即非结构化修剪和结构化修剪。前者也被称为权重修剪,它以非结构化的方式去除不重要的参数,也就是说,权重张量中的任何元素都可以被去除。后者则是将某一组中的所有权重一起删除,比如通道和滤波器。由于在剪枝中考虑到了结构,所以通过结构化剪枝得到的剪枝网络可以在普通的计算设备上进行有效推理。在结构化和非结构化修剪方法中,它们

的关键思想是提出一个适当的标准(例如。参考文献9,yiwen guo,anbang yao,and yurong chen.dynamic network surgery for efficient dnns.in nips,2016,参考文献10,zhuang liu,mingjie sun,tinghui zhou,gao huang,and trevor darrell.rethinking the value of network pruning.in international conference on learning representations,2019中提出的剪枝方法都可以显著提高深度神经网络的推理效率,而只带来微小的性能下降,使现代神经网络部署在资源有限的设备上成为可能。

9.沿着彩票假说的研究路线,最近的工作,例如snip(参考文献11,namhoon lee,thalaiyasingam ajanthan,and philip torr.snip:single-shot network pruning based on connection sensitivity.in international conference on learning representations,2018)和grasp(参考文献12,chaoqi wang,guodong zhang,and roger grosse.picking winning tickets before training by preserving gradient flow.in international conference on learning representations,2019)都通过保存梯度流实现了在初始化时找到中奖彩票,而不需要像经典的剪枝方法那样进行反复训练和剪枝。ntt利用神经正切核理论,通过微分方程系统捕获正常训练的动力学过程,然后通过保留模型输出的训练动力学过程来修剪权重。

技术实现要素:

10.发明目的:本发明所要解决的技术问题是针对现有技术的不足,提供基于保留动力学过程使用稀疏网络鲁棒地分类图片的方法,本方法找到的稀疏网络,保留了密集网络在对抗训练过程中的动力学过程,从而稀疏网络在对抗训练时的优化轨迹与密集网络在对抗训练时的优化轨迹相近,因而比起现有的通过保存梯度流获取稀疏网络的方法,本方法更大程度上保留了密集网络原本的性能。本发明包括以下步骤:

11.步骤1,寻找可对抗训练稀疏网络;

12.步骤2,对抗训练稀疏网络得到鲁棒分类器。固定步骤1得到的稀疏网络的网络结构和二值掩码,步骤2只更新稀疏网络的参数。对抗训练是一种使用对抗样本作为数据增强的训练方法,在训练过程中先使用分类损失进行攻击当前网络生成对抗样本,然后再将对抗输入网络,利用分类损失函数更新网络参数。重复此过程直到网络收敛。然后使用分类器完成图片分类。

13.步骤1包括:

14.步骤1-1,取两个结构相同的神经网络,一个作为密集网络,另一个额外维护一个表征稀疏性的二值掩码作为稀疏网络;

15.稀疏网络的参数初始化可以与密集网络相同也可以不同,二值掩码的初始化根据预先设定的目标稀疏度、参数重要性判定指标以及剪枝类型(全局剪枝或逐层剪枝)确定,初始的稀疏网络由网络结构、网络参数和二值掩码确定;

16.步骤1-2,根据神经正切核理论,并结合理论推导,通过让稀疏网络和与密集网络的混合神经正切核和网络输出逐渐靠近来保留密集网络的动力学过程:先利用投影梯度下降对抗攻击方法使用分类损失函数分别攻击密集网络和稀疏网络的对抗样本,然后将原始图片样本和对抗样本输入密集网络和稀疏网络计算各自的网络输出关于各自网络参数梯度的外积得到混合神经正切核,将两个网络的对抗样本分别输入各自的网络得到对抗样本

的初始网络输出;

17.步骤1-3,将密集网络与稀疏网络的混合神经正切核的差异以及对抗样本的初始网络输出差异的加权平均作为损失函数,通过梯度下降法更新稀疏网络参数,并周期性根据最新的稀疏网络的参数更新二值掩码。由于稀疏网络的参数一直在更新,所以稀疏网络的对抗样本在每一训练步都需要重新生成,而密集网络的参数是固定的,其对抗样本可以在训练前一次性得到。

18.步骤1-1包括如下步骤:

19.二值掩码中的元素只有0或者1,0代表当前位置对应网络参数被去掉,1代表当前位置对应网络参数被保留,二值掩码的确定与目标稀疏度、参数重要性判定指标和剪枝类型有关:

20.目标稀疏度,即最终稀疏网络中保留的参数数量与原始密集网络的总参数数量之比,也即二值掩码中元素1的数量占掩码中所有元素数量的比重;

21.参数重要性判定指标,即判定参数在整个稀疏网络中所起作用程度的指标,使用参数的绝对值大小作为参数重要性判定指标;

22.剪枝类型,依据是否每层的稀疏度都相同,分为逐层剪枝和全局剪枝;在稀疏度不是特别小时(》10%)全局剪枝的选择空间更大,表现会比逐层剪枝稍好;但在特别稀疏情况下(比如稀疏度《1%)全局剪枝容易出现断层现象(即某一层的参数被全部去掉)。

23.步骤1-2包括如下步骤:

24.根据神经正切核理论,对抗训练的动力学过程由如下微分方程表示:

[0025][0026]

其中d表示微分,t表示训练轮数,f

t

表示t时刻的密集网络,x为原始输入图片,是对抗样本,η是学习率,是梯度算子,l是损失函数,是混合神经正切核,如下所示:

[0027][0028]

其中t代表转置;

[0029]

如果使用均方误差作为损失函数,则:

[0030][0031]

其中y为图片的标签,f(x)为网络函数,则微分方程(1)变成如下形式:

[0032][0033]

其中θ

t

是t时刻的网络参数;

[0034]

稀疏训练的动力学方程如下所示:

[0035][0036]

其中,表示稀疏网络的网络函数,为稀疏网络的对抗样本;可以看出稀疏网络和密集网络的微分方程有着相同的形式,且均由混合神经正切核和网络在对抗样本上的输出控制。虽然要使稀疏网络和密集网络的动力学方程完全一样,需要让二者的神经正

切核和网络输出在任意时刻t都相同,但经过推导可知,只要二者的混合神经正切核和网络输出在初始时刻足够接近就可以让两个网络的输出的差异在任意时刻都控制在一个小范围内。目标函数设计如下:

[0037][0038]

其中min表示最小化,l

awt

是目标函数(awt是adversarial winning ticket的缩写,对抗中奖彩票),‖‖是2-范数,‖‖f表示frobenious范数θ0是密集网络的初始化参数,表示密集网络,

⊙

表示逐元素相乘,w是稀疏网络加掩码前的参数,m

⊙

w表示稀疏网络的参数,fm⊙w表示稀疏网络,n为样本数量,γ2是混合神经正切核的权重,是密集网络在初始时刻的混合神经正切核,是稀疏网络的混合神经正切核。

[0039]

步骤1-3包括如下步骤:

[0040]

每来到一组原始输入图片及其标签y,先对图片进行对抗攻击生成对抗样本,具体包括:

[0041]

训练前先确定对抗训练的三个参数:最大扰动ε、单步扰动δ、扰动步数n;

[0042]

将x输入稀疏网络和密集网络分别得到输出f(x,m

⊙

w)和输出f(x,θ0),再使用如下分类损失函数l反向传播计算l关于x的梯度g,

[0043][0044]

然后将x沿g的方向走一小步,步长为δ,得到第1个临时对抗样本x1;接着将x1输入被攻击网络(可以是密集网络也可以是稀疏网络)得到输出f(x1),再使用如下分类损失函数l反向传播计算l关于x1的梯度g:

[0045][0046]

然后将x1沿g的方向走一小步,步长为δ,得到第2个临时对抗样本x2,如此迭代n步便得到了x的对应当前参数的对抗样本,记为和代表稀疏网络的对抗样本,代表密集网络的对抗样本;

[0047]

得到对抗样本后,将对抗样本输入各自对应的网络,得到网络输出,同时反向传播计算出混合神经正切核,然后使用得到的网络输出和混合神经正切核代入目标函数l

awt

计算得到目标损失,将目标损失反向传播得到稀疏网络参数w的梯度,根据梯度更新w;

[0048]

每更新tm(掩码更新频率,本方法设为100)次w,重新根据当前w更新二值掩码m,直到训练收敛得到最终的参数w和二值掩码m。

[0049]

步骤2包括如下步骤:

[0050]

步骤2-1,将步骤1得到的稀疏网络作为初始网络,对抗训练全程一直固定二值掩码m,从头开始对抗训练,对抗训练看成是迭代生成对抗样本和使用对抗样本进行训练的过程,每来到一组图片x和标签y,先使用对抗攻击生成对抗样本对抗攻击方法和步骤1中的相同,然后将输入网络,利用如下交叉熵损失函数l反向传播更新网络参数w:

[0051][0052]

其中i是样本序号,c是类别序号;y

ic

是指示函数,如果样本i的标签是c则y

ic

取值为1,否则取值为0;p

ic

是网络输出的样本i属于c类的概率;

[0053]

步骤2-2,重复步骤2-1的迭代过程直到网络收敛便得到了对抗鲁棒的分类器。

[0054]

本发明具有如下有益效果:

[0055]

(1)本发明使用稀疏网络进行训练,大大减少了内存资源的占用,加快了推断速度,使得现代深度神经网络在资源有限型设备上的部署成为可能。

[0056]

(2)本发明属于预见型方法,在对抗训练前便已找到了适宜对抗训练的稀疏网络,不需要像现有方法那样经过迭代进行对抗训练-剪枝过程。

[0057]

(3)本发明适用于各种图片类数据集,在各类图片数据集上都有优秀的对抗鲁棒性。

附图说明

[0058]

下面结合附图和实施例对本发明做更进一步的具体说明,本发明的上述和/或其他方面的优点将会变得更加清楚。

[0059]

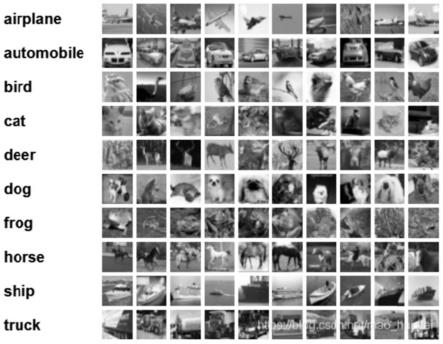

图1是cifar-10数据集示意图。

[0060]

图2是vgg-16神经网络示意图。

[0061]

图3是稀疏网络与密集网络的训练轨迹示意图。

[0062]

图4是本发明的方法寻找稀疏网络时的神经正切核距离的收敛过程示意图。

[0063]

图5是本发明的方法寻找稀疏网络时的网络输出距离的收敛过程示意图。

[0064]

图6是本发明找到的稀疏网络在对抗训练时的对抗样本分类准确率示意图。

[0065]

图7是本法明在数据集mnist、conv-6网络上对抗训练过程中的原始样本分类准确率示意图。

[0066]

图8是本法明在数据集mnist、conv-6网络对抗训练过程中的对抗样本分类准确率示意图。

[0067]

图9是本法明在数据集cifar-10、conv-6网络对抗训练过程中的原始样本分类准确率示意图。

[0068]

图10是本法明在数据集cifar-10、conv-6网络对抗训练过程中的对抗样本分类准确率示意图。

[0069]

图11是本发明方法得到的稀疏网络与随机生成稀疏网络的普通样本分类准确率对比示意图。

[0070]

图12是本发明方法得到的稀疏网络2随机生成稀疏网络的对抗样本分类准确率对比示意图。

实施例

[0071]

本发明的任务目标是使用一个稀疏网络,对其进行对抗训练从而获得对抗鲁棒的图片分类器。下面根据实施例说明本发明的各个步骤。

[0072]

数据集介绍:数据集为cifar-10,见图1,一共包含10个类别的rgb彩色图片:飞机、汽车、鸟类、猫、鹿、狗、蛙类、马、船和卡车。图片的尺寸为32

×

32,数据集中一共有50000张训练图片和10000张测试图片。

[0073]

网络介绍:网络结构选用经典卷积神经网络vgg-16,见图2,该网络主要由5个卷积层、3个全连接层组成,每个卷积层后紧跟一个池化层用于扩大接受域,每个全连接层后跟一个dropout层来减少过拟合,最后使用softmax层进行归一化方便分类任务。

[0074]

超参数的选取。密集网络的初始化分布选用高斯分布,对抗攻击的参数选用业内最常用的设置(扰动强度ε设为8/255,单步扰动强度δ设为2/255,扰动步数设为20),稀疏度从小到大共使用了{0..05,0.1}两种不同的网络密度,掩码更新频率tm选用了100(tm过大会造成稀疏网络的动力学过程延迟于密集网络,tm过小则容易受随机噪声的影响不易于收敛),权重衰减系数β取为1e-6(相较于密集网络,稀疏网络更容易受到权重衰减系数的影响,过小容易过拟合,过大容易无法找到优质解)

[0075]

模型初始化。先使用步骤1选择的初始化方式对密集网络的参数θ0进行随机初始化,然后深拷贝θ0得到一套相同的参数w作为稀疏网络的初始化参数,同时生成一个和θ0形状相同的数据结构m作为二值掩码。m的初始化如下:将w内所有元素按降序排序,设w内共有q个元素,稀疏度为k,w内排序位次低于q*k的所有元素对应位置记为p,则将m内位置p所在位置元素全部置0,其余位置全部置1,后续m更新操作也是类似,根据当前w内元素排序确定。当前训练轮数t设为0,用于后续训练时统计训练步数从而周期更新m。

[0076]

步骤1,寻找稀疏网络。根据前面理论分析中的目标函数更行参数w:

[0077][0078]

步骤1-1,生成对抗样本。每一轮训练步,从数据集中得到一组图片x及其标签y,将其输入稀疏网络和密集网络分别得到输出f(x,m

⊙

w)和输出f(x,θ0),再使用分类损失函数

[0079][0080]

反向传播计算l关于x的梯度g,然后将x沿g的方向走一小步(步长为δ)得到第1个临时对抗样本x1;接着将x1输入网络得到输出f(x1),再使用分类损失函数

[0081][0082]

反向传播计算l关于x1的梯度g:然后将x1沿g的方向走一小步(步长为δ)得到第2个临时对抗样本x2……

,如此迭代20步便得到了x的相对当前参数的对抗样本,记为(代表稀疏网络的对抗样本)和(代表密集网络的对抗样本)。

[0083]

步骤1-2,更新w和m。得到对抗样本后,将x和对抗样本分别输入网络得到网络输出f(x,θ0)和以及神经正切核和然后使用如下目标函数反向传播计算l

awt

关于w的梯度:

[0084][0085]

利用梯度下降法更新w。同时训练轮数t加1,若t刚好可以整除100,则类似步骤2中

m的初始化,根据当前w内元素排序更新m。当t达到指定的最大训练轮数之后,训练便结束,此时得到了优化后的稀疏网络的参数w和二值掩码m。

[0086]

步骤2稀疏网络的对抗训练。依旧使用网络结构vgg-16,并使用步骤1训练得到的参数w和m对网络初始化,然后固定m不变,设置对抗训练的总训练轮数、学习率、对抗攻击参数和权重衰减系数(可以使用与寻找系数网路时相同的配置),开始对抗训练。使用交叉熵损失函数

[0087][0088]

攻击当前稀疏网络生成对抗样本然后用将对抗样本输入稀疏网络,利用交叉熵损失函数

[0089][0090]

更新网络参数w。不断重复对抗样本生成和参数更新过程直到网络收敛。如此便得到了的对抗鲁棒的稀疏网络。训练完后在数据集上测试分类准确率(即直接测试网络在测试集上的准确率)和对抗分类准确率(即先使用对抗攻击将测试集样本转变为对抗样本,再测试在对抗样本上的准确率)

[0091]

结果分析:

[0092]

本发明方法的实验环境参数如下:

[0093]

实验所用数据集为mnist、cifar-10、cifar-100。选用的网络为多层感知机mlp、6层卷积神经网络conv-6、大型卷积神经网络vgg-16。所用环境为jax

[0094]

对抗攻击的参数如下:对于mnist,ε=0.3,δ=0.02,n=20。对于cifar-10,cifar-100,ε=8/255,δ=2/255,n=20。

[0095]

寻找稀疏网络时学习率η为5e-4,验证时学习率η为1e-3;γ2设为1e-3;参数初始化使用了高斯分布;掩码更新频率tm=100;权重衰减稀疏β=1e-5;对于mlp网络使用了稀疏度{0.018,0.036,0.087,0.169,0.513},卷积神经网络稀疏度使用了{0.05,0.1,0.3,0.5,0.7,0.9}。

[0096]

结果一:如图3显示了密集网络和稀疏网络在训练过程中网络输出的演变轨迹。可以看出二者的轨迹十分接近,甚至对抗样本也十分相似,这进一步说明了本发明的方法可以保证稀疏网络在整个训练过程中都可以保持和密集网络十分接近的动力学过程。

[0097]

结果二:图4和图5分别展示了本发明方法在不同稀疏度下(数据集为mnist,网络为mlp)寻找稀疏网络时混合神经正切核距离和网络输出距离的的收敛过程,可以看出在不同稀疏度下本方法都能很快找到目标稀疏网络。图6显示了本方法找到的稀疏网络在对抗训练时的训练集准确率和测试集准确率,可以看出本方法在多种稀疏度下均有良好的表现。

[0098]

结果三:本发明与做同样任务的最新的工作(参考文献16,justin cosentino,federico zaiter,dan pei,and jun zhu.the search for sparse,robust neural networks.arxiv preprint arxiv:1912.02386,2019)在mlp网络上做了对比(因为

cosentino的方法计算量十分巨大,所以它的工作中只给出了在相对规模较小的mlp网络上的结果),结果如表1,可以看到本发明方法在各个不同的稀疏度下的表现都超过了它们的方法,尤其是当网络特别稀疏时,本发明的对抗样本准确率甚至达到了它们的两倍。

[0099]

表1

[0100][0101]

结果四:图7和图8分别是本方法在不同稀疏度下在对抗训练过程中的原始样本分类准确率和对抗样本准确率(数据集为mnist,网络为conv-6)。可以看出在稀疏度只有1%时本方法都能达到90%以上的对抗分类准确率。图9和图10分别是本方法在不同稀疏度下在对抗训练过程中的原始样本分类准确率和对抗样本准确率(数据集为cifar-10,网络为conv-6)。

[0102]

结果五:图11和图12分别显示了本发明的方法找到的稀疏网络和随机生成的稀疏网络在相同条件、不同稀疏度下的性能对比,可以看出随机生成的稀疏网络性能要明显差很多,说明本发明的方法良好的对抗鲁棒性并不或并不仅仅是由稀疏性带来的,保存了动力学过程才是最重要的原因。

[0103]

结果六:表2显示了本发明在大型网络vgg-16、数据集cifar-10上的表现(对抗样本的分类准确率),并于经典迭代训练-剪枝方法以及最近提出的inverse weight inheritance进行了对比,结果显示本方法与现有顶尖方法持平。

[0104]

表2

[0105][0106][0107]

本发明提供了基于保留动力学过程使用稀疏网络鲁棒地分类图片的方法,具体实现该技术方案的方法和途径很多,以上所述仅是本发明的优选实施方式,应当指出,对于本技术领域的普通技术人员来说,在不脱离本发明原理的前提下,还可以做出若干改进和润

饰,这些改进和润饰也应视为本发明的保护范围。本实施例中未明确的各组成部分均可用现有技术加以实现。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1