一种基于多目标跟踪的交通行为判定方法

1.本发明属于计算机视觉、智能识别技术领域,特别地涉及到一种基于多目标跟踪的交通行为判定方法。

背景技术:

2.随着近年来数据通信技术、传感器技术、电子控制技术、计算机视觉技术的蓬勃发展,城市智能交通系统已经在城市中大范围覆盖、而且全天时全方位的发挥作用,通过提升交通网路通过能力、查处交通违规行为、智能调度等功能,达到缓解交通阻塞、减少空气污染、减少交通事故发生等作用。当前现有的智能交通系统多聚焦于机动车辆相关的治理和开发,而忽略了行人、非机动车、管控,据统计我国的行人、非机动车之间涉及交通事故的占比不高,然而不可忽视的是,由于高占比的机动车事故的原因,给行人、非机动车造成严重后果的比例却高居不下。对于以上两种交通实体的事故处理,需要耗费大量的警力维持秩序,但路口的数量远超人力可覆的盖范围,由于交通违规行为时有发生,也是潜在的交通事故来源,所以需要更进一步的管控与治理。

3.多目标跟踪是通过对视频序列中的目标进行持续的定位和身份判定,可以检测到感兴趣的多个类别的目标位置,并生成轨迹,可以用于视频监控、人机交互、自动驾驶等方面,是一项重要的视觉技术。随着深度学习的快速发展,多目标跟踪模型的性能也得到大幅提升,但依托于基于深度网络的目标检测和复杂的数据关联机制,多目标跟踪模型在效率上还比较欠缺,在诸如交通监控等时效性要求较高的场景难以作为实际应用。

技术实现要素:

4.本发明的目的在于针对现有技术的不足,提供一种基于多目标跟踪的交通行为判定方法,通过对交通监控场景下的行人、非机动车目标的跟踪,可以快速准确的判定其交通行为,以辅助交警维持交通秩序。

5.为实现上述目的,本发明采用如下技术方案:

6.步骤1:输入一段交通监控场景的视频;

7.步骤2:给定一段交通监控视频,从中抽取一帧画面,对行人、非机动车的跟踪初始区域regions进行划定;

8.步骤3:使用opencv工具读取交通监控服务器的rtsp协议地址,获得实时视频流,对画面中经过跟踪初始区域regions的行人、非机动车目标进行跟踪,具体步骤如下:

9.步骤3.1:创建暂时丢失的目标集合

10.步骤3.2:按照顺序读取交通监控视频流中的一帧图像,输入第一帧图像时,进行全图的行人、非机动车目标检测,对于处在跟踪起始区域regions的目标建立基于视觉信息的单目标跟踪器和基于运动信息的卡尔曼滤波器,并存储该目标的外观特征向量;

11.步骤3.3:在之后输入的帧图像中每间隔固定数量的帧进行目标检测,当前帧不进行目标检测时:

12.步骤3.3.1:遍历当前所有的跟踪目标,分别使用基于视觉信息的单目标跟踪器、基于运动信息的卡尔曼滤波器进行位置预测,获得目标的预测位置box

sot

、box

kal

;

13.步骤3.3.2:若box

sot

、box

kal

的交叠覆盖度(iou)高于阈值达成匹配,则使用box

sot

作为观测值更新卡尔曼滤波器的状态,并获取此时卡尔曼滤波器的观测值box

out

作为当前帧该目标的位置。

14.若有目标成功跟踪时间超过阈值t

track

,或到达图像的边界,则停止该目标的跟踪。

15.步骤3.3.3:若box

sot

、box

kal

的iou低于阈值不能达成位置上的匹配,则认为目标暂时丢失,加入集合{target

lost

}中,暂停该目标的单目标跟踪器的运行,使用卡尔曼滤波器继续进行预测;

16.步骤3.3.4:遍历所有{target

lost

}中的目标,使用卡尔曼滤波器的预测结果更新自身状态,若丢失时间超过阈值,则删除该目标。

17.步骤3.4:当前帧需要进行目标检测时:

18.步骤3.4.1:进行目标检测,获取所有的目标框集合{box

det

};

19.步骤3.4.2:遍历当前所有的跟踪目标,分别使用基于视觉信息的单目标跟踪器、基于运动信息的卡尔曼滤波器进行位置预测,获得目标的预测位置box

sot

、box

kal

,取两者均值作为当前目标的预测值box

pred

;

20.步骤3.4.3:遍历所有的box

pred

,寻找检测结果{box

det

}中与box

pred

的iou大于阈值达成匹配的包围框,若可以达成匹配,则以相匹配的检测结果作为观测值更新卡尔曼滤波器的状态,获取此时卡尔曼滤波器的观测值box

out

作为当前帧该目标的位置,并更新该目标的外观特征向量。

21.若有目标成功跟踪时间超过阈值t

track

,或到达图像的边界,则停止该目标的跟踪。

22.步骤3.4.4:若步骤

③

中的box

pred

没有检测结果与之匹配,则认为该目标暂时丢失,加入{target

lost

}中,暂停该目标的单目标跟踪器,保留该目标的卡尔曼滤波器;

23.步骤3.4.5:遍历{target

lost

}中的所有目标,若能与经过步骤

③

和

④

后剩余的检测结果在位置和外观特征度量上达成匹配,则重新建立该目标的单目标跟踪器,从{target

lost

}中删除,作为正常跟踪的目标处理,如果{target

lost

}中的目标丢失的时间超过阈值,则删除该目标;

24.步骤3.4.6:若经过以上步骤检测结果{box

det

}中仍有位于跟踪初始区域regions的包围框,则建立新的跟踪目标,为该目标建立基于视觉信息的单目标跟踪器和基于运动信息的卡尔曼滤波器,并存储该目标的外观特征向量。

25.步骤3.5:继续处理交通监控视频流的剩余帧图像,重复步骤2.3和2.4,直至视频结束。

26.步骤4:对于步骤2中跟踪结束的目标,根据其起始位置与跟踪结束位置,进行交通行为的判定,输出该目标的跟踪id、交通行为、发生时间和绘制轨迹的图像,判定方式如下:

27.步骤4.1:设定某个方向的单位向量作为参照向量以目标的初始位置向跟踪结束位置的单位向量作为计算用于判定方向的值

28.步骤4.2:对于行人目标,只有向左和向右横穿马路两种交通行为;而对于非机动车目标,有左转、直行和右转三种交通行为。根据valued的值可以推断目标运动方向向量

与参照向量的夹角角度,进而完成交通行为的判定。

29.与现有技术相比,本发明的有益效果是:本发明是一种基于多目标跟踪的交通行为判定方法,该方法通过使用间隔检测、视觉与运行预测相匹配的跟踪策略,在提升多目标跟踪的运行效率的同时,提升了跟踪的准确性。通过对经过起始区域的行人、非机动车目标进行一定时间的跟踪,可以完成交通行为的判定。本发明优化了多目标跟踪的过程,使其在交通监控场景中具备了时效性,同时对行人、非机动车目标的交通行为自动化分析,可以节省交通管控中的人力物力,更好的帮助交警查处交通违规行为。

附图说明

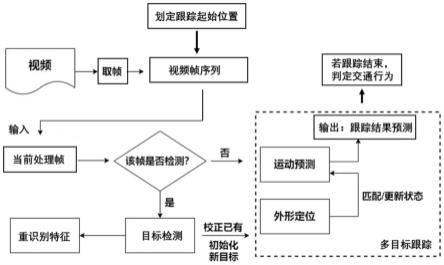

30.图1是本发明基于多目标跟踪的交通行为判定方法流程图;

31.图2是本发明交通行为判断示意图;

32.图3是本发明目标检测模块网络架构图。

具体实施方式

33.为了使本发明的目的、技术方案及优点更加清楚明白,以下结合附图及实施例,对本发明进行进一步详细说明。应该理解,此处所描述的具体实施例仅用以解释本发明,并不用于限定本发明。相反,本发明涵盖任何由权利要求定义的在本发明的精髓和范围上做的替代、修改、等效方法以及方案。进一步,为了使公众对本发明有更好的了解,在下文对本发明的细节描述中,详尽描述了一些特定的细节部分。对本领域技术人员来说没有这些细节部分的描述可以完全理解本发明。

34.参考图1,为本发明实施例的基于多目标跟踪的交通行为判定方法流程图:

35.步骤1:输入一段交通监控场景的视频;

36.步骤2:参考图2,抽取一帧交通监控视频画面,划定跟踪初始区域regions={行人左侧起始区域、行人右侧起始区域、非机动车起始区域};

37.步骤3:使用opencv工具读取交通监控服务器的rtsp协议地址,读取交通监控视频流,对画面中经过跟踪初始区域regions的行人非机动车目标进行跟踪,具体步骤如下:

38.步骤3.1:创建暂时丢失的目标集合

39.步骤3.2:按照顺序读取交通监控视频流中的一帧图像,输入第一帧图像时,进行全图的行人非机动车目标检测,对于处在跟踪起始区域regions的目标建立基于视觉信息的孪生网络单目标跟踪器和基于运动信息的卡尔曼滤波器,并存储该目标的外观特征向量;

40.参考图3,目标检测采用基于深度网络的模型,图像输入后经过特征提取网络获得视觉特征,视觉特征经过多尺度组合增强后进行目标位置的预测,包含分类和框回归分支,目标的外观特征向量通过对视觉特征图进行感兴趣区域对齐(roi align)和全局平均池化操作得到。目标检测网络的损失函数loss包含分类分支的交叉熵损失和回归分支的iou损失,具体为:

41.42.l

reg

=1-iou(box

gt

,box

pred

)

43.其中,l

cls

为分类分支的交叉熵损失,h、w为特征图的宽和高,pi为特征图上一点为前景的真值概率,为特征图上一点为前景的预测概率;l

reg

为回归分支的iou损失,其中box

gt

为真值包围框位置,box

pred

为预测包围框所在位置。

44.步骤3.3:在之后输入的帧中每间隔5帧进行一次目标检测,当前帧不进行目标检测时:

45.步骤3.3.1:遍历当前所有的跟踪目标,分别使用基于视觉信息的单目标跟踪器、基于运动信息的卡尔曼滤波器进行位置预测,获得目标的预测位置box

sot

、box

kal

;

46.步骤3.3.2:若box

sot

、box

kal

的iou(intersection over union),交叠覆盖度)高于阈值达成匹配,则使用box

sot

作为观测值更新卡尔曼滤波器的状态,并获取此时卡尔曼滤波器的观测值box

out

作为当前帧该目标的位置。

47.若有目标成功跟踪时间超过阈值t

track

,或到达图像的边界,则停止该目标的跟踪。

48.步骤3.3.3:若box

sot

、box

kal

的iou低于阈值不能达成位置上的匹配,则认为目标暂时丢失,加入集合{target

lost

}中,暂停该目标的单目标跟踪器的运行,使用卡尔曼滤波器继续进行预测;

49.步骤3.3.4:遍历所有{target

lost

}中的目标,使用卡尔曼滤波器的预测结果更新自身状态,若丢失时间超过阈值,则删除该目标。

50.步骤3.4:当前帧需要进行目标检测时:

51.步骤3.4.1:进行目标检测,获取所有的目标框集合{box

det

};

52.步骤3.4.2:遍历当前所有的跟踪目标,分别使用基于视觉信息的单目标跟踪器、基于运动信息的卡尔曼滤波器进行位置预测,获得目标的预测位置box

sot

、box

kal

,取两者均值作为当前目标的预测值box

pred

;

53.步骤3.4.3:遍历所有的box

pred

,寻找检测结果{box

det

}中与box

pred

的iou大于阈值达成匹配的包围框,若可以达成匹配,则以相匹配的检测结果作为观测值更新卡尔曼滤波器的状态,获取此时卡尔曼滤波器的观测值box

out

作为当前帧该目标的位置,并更新该目标的外观特征向量:

54.feature

new

=(1-θ)*feature

old

+θ*feature

curr

55.其中feature

old

为该目标旧的外观特征向量,feature

curr

为当前帧与之匹配的检测结果的外观特征向量,feature

new

为更新后的特征向量,θ为更新的学习率。若有目标成功跟踪时间超过阈值t

track

,或到达图像的边界,则停止该目标的跟踪。

56.步骤3.4.4:若步骤

③

中的box

pred

没有检测结果与之匹配,则认为该目标暂时丢失,加入{target

lost

}中,暂停该目标的单目标跟踪器,保留该目标的卡尔曼滤波器;

57.步骤3.4.5:遍历{target

lost

}中的所有目标,若能与经过步骤

③

和

④

后剩余的检测结果在位置和外观特征度量上达成匹配,则重新建立该目标的单目标跟踪器,从{target

lost

}中删除,作为正常跟踪的目标处理,如果{target

lost

}中的目标丢失的时间超过阈值,则删除该目标;

58.步骤3.4.6:若经过以上步骤检测结果{box

det

}中仍有位于跟踪初始区域regions的包围框,则建立新的跟踪目标,为该目标建立基于视觉信息的单目标跟踪器和基于运动信息的卡尔曼滤波器,并存储该目标的外观特征向量。

59.步骤3.5:继续处理交通监控视频流的剩余帧图像,重复步骤2.3和2.4,直至视频结束。

60.步骤4:参考图2的交通行为判定示意图,对于步骤2中跟踪结束的目标,根据其起始位置与跟踪结束位置,进行交通行为的判定,输出该目标的跟踪id、交通行为、发生时间和绘制轨迹的图像,判定方式如下:

61.步骤4.1:设定以摄像头朝向的道路方向顺时针旋转30

°

的单位向量为参照向量以目标的初始位置向跟踪结束位置的单位向量作为计算用于判定方向的值计算用于判定方向的值

62.步骤4.2:对于行人目标,只有向左和向右横穿马路两种交通行为:若valued≥0,则交通行为为向右,若valued<0则交通行为为向左;

63.步骤4.3:对于非机动车目标,有左转、直行和右转三种交通行为:若-0.707≤valued<0.707,则交通行为为直行,若valued≥0.707则交通行为为右转,若valued<-0.707则交通行为为左转。

64.以上所述仅为本发明的较佳实施例而已,并不用以限制本发明,凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1