基于联邦学习的水电信号实体抽取方法、系统及终端与流程

1.本发明涉及水电信息处理技术领域,更具体地说,它涉及基于联邦学习的水电信号实体抽取方法、系统及终端。

背景技术:

2.命名实体识别是自然语言处理领域内的一项重要任务,其目标主要是设计一个有效的模型,找到文本中关键实体将其类型标注出来。命名实体识别广泛使用于知识图谱、关系抽取等应用中。早期命名实体识别使用基于规则的方法,如dlcotrain方法,但需要准确度约高,所需的规则量也越大,人工制定这些规则的成本太高昂。随着机器学习的发展,出现了基于统计机器学习的命名实体识别方法,先识别出所有实体再进行分类的coboost方法和使用hmm、svm等机器学习分类模型的序列化标注方法都取得了不错的效果。深度学习技术使用词向量来表示词语,基于卷积神经网络和循环神经网络的模型都取得了显著的成果,基于transformer的bert预训练模型的提出,如biobert,bert-crg等模型,都将识别的精度提高了不少。

3.在水电行业中,设备的运行记录了大量的日志信息,工作人员需要根据系统日志来判断设备的运行状态,而命名实体识别方法可以大大减少人工的工作量,提升效率。尽管基于深度学习的模型可以达到极高的实体识别准确率,但模型往往需要大量的样本来进行训练。而单个站点所能提供的训练样本是有限的,且由于数据安全、隐私的原因,传统集中式的深度学习方式不适用于这个场景下。水电行业中日志文件数据相互隔离,存在着“数据孤岛”、缺少训练数据的问题。除了样本数据稀少的问题外,不同水电站点可能使用系统有差异,行业内术语也不一致,数据存在着非独立同分布的问题,使用统一的模型来进行命名实体识别无法达到最好的效果,甚至在某些权重小的样本中效果很差的情况。

4.因此,如何研究设计一种能够克服上述缺陷的水电信号实体抽取方法是我们目前急需解决的问题。

技术实现要素:

5.为解决现有技术中的不足,本发明的目的是提供基于联邦学习的水电信号实体抽取方法、系统及终端,使用联邦学习的算法来解决单个系统训练数据不足的问题,并通过控制实体模型的部分层来达到个性化的模型参数,以解决各个不同系统间数据非独立同分布的问题。

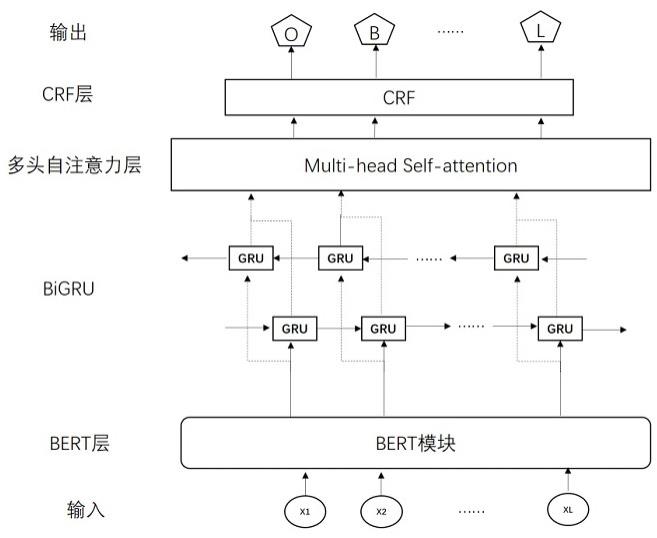

6.本发明的上述技术目的是通过以下技术方案得以实现的:第一方面,提供了基于联邦学习的水电信号实体抽取方法,包括以下步骤:基于bert预训练模型对水电信号表征的句子内容进行嵌入,得到句子的向量表示;将嵌入后的句子传给双向gru层进行全局特征的提取,双向gru层采用联邦学习方法进行优化,得到全局特征序列;

利用多头自注意力层从全局特征序列中捕捉表征重要信息的局部特征作为目标特征;采用线性链条件随机场模型作为标注模型,并依据目标特征进行实体的标注。

7.进一步的,所述基于bert预训练模型对水电信号表征的句子内容进行嵌入的过程具体为:bert模型接收b个长度为l的句子xi作为输入;经过bert中12层的编码器输出大小为b*l*h的句向量表示;h为bert模型中的隐藏大小,取值为768。

8.进一步的,所述双向gru层进行全局特征的提取过程具体为:双向gru层接收大小为b*l*h的句向量表示;b表示输入数量;l表示句子长度;输出大小为b*l*h1的句向量;h1表示双向gru层中的隐藏大小,取值为256。

9.进一步的,所述双向gru层采用联邦学习方法进行优化的过程具体为:双向gru层中的反向gru层不加入的全局聚合中,以双向gru层中的反向gru层对每个客户端私有层的参数进行处理。

10.进一步的,所述联邦学习的聚合阶段分为客户端阶段和服务终端阶段;客户端阶段的运行过程具体为:客户端接收由服务终端分发的模型参数,并初始化双向gru层的参数;、分别表示多头自注意力层、线性链条件随机场模型中的参数;客户端使用本地数据训练模型,将训练好的参数上传给服务终端;客户端接收由服务终端完成聚合后分发的模型参数,并结合上一次的双向gru参数组成新一轮的训练模型,再次训练;直到服务终端发送终止信号,客户端结束运行;服务终端阶段的运行过程具体为:初始化模型参数,分发给所有参与的客户端;接收到数量为n的客户端的模型参数后,对参数聚合,聚合公式为: 其中,表示聚合后的模型参数;表示第k个客户端上传的模型参数;表示第k个客户端所拥有的数据量大小;表示所有n个客户端所用的数据量大小;将聚合后的参数分发给所有客户端,再次聚合;当服务终端运行满足预设时间或预设循环次数,则向所有客户端发送终止信号,结束训练。

11.进一步的,所述多头自注意力层的计算公式具体为:

其中,attention 表示做注意力计算;表示第i 个注意力头的计算结果;分别表示矩阵q , k ,v 的权重矩阵;是h个注意力头计算后产生的结果拼接后对应的权重矩阵。

12.进一步的,所述线性链条件随机场模型在获得全局条件下的最优解情况下,将多头自注意力层输出的b*l*h1的句向量标注后输出大小为b*l的向量,得到实体标准结果;b表示输入数量;l表示句子长度;h1表示双向gru层中的隐藏大小,取值为256。

13.第二方面,提供了基于联邦学习的水电信号实体抽取系统,包括:嵌入处理模块,用于基于bert预训练模型对水电信号表征的句子内容进行嵌入,得到句子的向量表示;特征提取模块,用于将嵌入后的句子传给双向gru层进行全局特征的提取,双向gru层采用联邦学习方法进行优化,得到全局特征序列;特征捕捉模块,用于利用多头自注意力层从全局特征序列中捕捉表征重要信息的局部特征作为目标特征;实体标注模块,用于采用线性链条件随机场模型作为标注模型,并依据目标特征进行实体的标注。

14.第三方面,提供了一种计算机终端,包含存储器、处理器及存储在存储器并可在处理器上运行的计算机程序,所述处理器执行所述程序时实现如第一方面中任意一项所述的基于联邦学习的水电信号实体抽取方法。

15.第四方面,提供了一种计算机可读介质,其上存储有计算机程序,所述计算机程序被处理器执行可实现如第一方面中任意一项所述的基于联邦学习的水电信号实体抽取方法。

16.与现有技术相比,本发明具有以下有益效果:1、本发明提出的基于联邦学习的水电信号实体抽取方法,使用联邦学习的算法,可以有效解决单个站点训练样本有限的情况,且由于数据安全、隐私的原因,传统集中式的深度学习方式不适用于这个场景下;2、本发明在每个客户端的网络中设计了私有层,通过控制实体模型的部分层来达到个性化的模型参数,以保证不同节点的差异性,有效克服了因不同水电站点可能使用系统有差异,行业内术语也不一致,数据存在着非独立同分布的问题,使用统一的模型来进行命名实体识别无法达到最好的效果,甚至在某些权重小的样本中效果很差的情况。

附图说明

17.此处所说明的附图用来提供对本发明实施例的进一步理解,构成本技术的一部分,并不构成对本发明实施例的限定。在附图中:图1是本发明实施例中的整体流程图;

图2是本发明实施例中bert预训练模型的结构框图;图3是本发明实施例中多头自注意力层的示意图;图4是本发明实施例中的系统框图。

具体实施方式

18.为使本发明的目的、技术方案和优点更加清楚明白,下面结合实施例和附图,对本发明作进一步的详细说明,本发明的示意性实施方式及其说明仅用于解释本发明,并不作为对本发明的限定。

19.实施例1:基于联邦学习的水电信号实体抽取方法,如图1所示,包括以下步骤:s1:基于bert预训练模型对水电信号表征的句子内容进行嵌入,得到句子的向量表示;s2:将嵌入后的句子传给双向gru层进行全局特征的提取,双向gru层采用联邦学习方法进行优化,得到全局特征序列;s3:利用多头自注意力层从全局特征序列中捕捉表征重要信息的局部特征作为目标特征;s4:采用线性链条件随机场模型作为标注模型,并依据目标特征进行实体的标注。

20.如图2所示,基于bert预训练模型对水电信号表征的句子内容进行嵌入的过程具体为:bert模型接收b个长度为l的句子xi作为输入;经过bert中12层的编码器输出大小为b*l*h的句向量表示;h为bert模型中的隐藏大小,取值为768。编码器由一个多头注意、标准化层、前馈、标准化层叠加产生,bert模型的每一层由一个这样的编码器单元构成。

21.双向gru层进行全局特征的提取过程具体为:双向gru层接收大小为b*l*h的句向量表示;输出大小为b*l*h1的句向量;h1表示双向gru层中的隐藏大小,取值为256。

22.双向gru层采用联邦学习方法进行优化的过程具体为:双向gru层中的反向gru层不加入的全局聚合中,以双向gru层中的反向gru层对每个客户端私有层的参数进行处理。

23.联邦学习的聚合阶段分为客户端阶段和服务终端阶段。

24.客户端阶段的运行过程具体为:(1)客户端接收由服务终端分发的模型参数,并初始化双向gru层的参数;、分别表示多头自注意力层、线性链条件随机场模型中的参数;(2)客户端使用本地数据训练模型,将训练好的参数上传给服务终端;(3)客户端接收由服务终端完成聚合后分发的模型参数,并结合上一次的双向gru参数组成新一轮的训练模型,再次训练;(4)直到服务终端发送终止信号,客户端结束运行。

25.服务终端阶段的运行过程具体为:(1)初始化模型参数,分发给所有参与的客户端;

(2)接收到数量为n的客户端的模型参数后,对参数聚合,聚合公式为: 其中,表示聚合后的模型参数;表示第k个客户端上传的模型参数;表示第k个客户端所拥有的数据量大小;表示所有n个客户端所用的数据量大小;(3)将聚合后的参数分发给所有客户端,再次聚合;(4)当服务终端运行满足预设时间或预设循环次数,则向所有客户端发送终止信号,结束训练。

26.如图3所示,多头注意力机制就是重复多次对矩阵q,k,v进行不同的线性映射并计算注意力分数。最终将每个注意力头的结果矩阵拼接起来再与一个随机矩阵相乘,得到最终的矩阵作为最终多头注意力的输出。多头自注意力层的计算公式具体为:终的矩阵作为最终多头注意力的输出。多头自注意力层的计算公式具体为:其中,attention 表示做注意力计算;表示第i 个注意力头的计算结果;分别表示矩阵q , k ,v 的权重矩阵;是h个注意力头计算后产生的结果拼接后对应的权重矩阵。

27.线性链条件随机场模型在获得全局条件下的最优解情况下,将多头自注意力层输出的b*l*h1的句向量标注后输出大小为b*l的向量,得到实体标准结果;b表示输入数量;l表示句子长度;h1表示双向gru层中的隐藏大小,取值为256。

28.实施例2:基于联邦学习的水电信号实体抽取系统,如图4所示,包括嵌入处理模块、特征提取模块、特征捕捉模块和实体标注模块。

29.其中,嵌入处理模块,用于基于bert预训练模型对水电信号表征的句子内容进行嵌入,得到句子的向量表示;特征提取模块,用于将嵌入后的句子传给双向gru层进行全局特征的提取,双向gru层采用联邦学习方法进行优化,得到全局特征序列;特征捕捉模块,用于利用多头自注意力层从全局特征序列中捕捉表征重要信息的局部特征作为目标特征;实体标注模块,用于采用线性链条件随机场模型作为标注模型,并依据目标特征进行实体的标注。

30.工作原理:本发明使用联邦学习的算法,可以有效解决单个站点训练样本有限的情况,且由于数据安全、隐私的原因,传统集中式的深度学习方式不适用于这个场景下;此外,在每个客户端的网络中设计了私有层,通过控制实体模型的部分层来达到个性化的模型参数,以保证不同节点的差异性,有效克服了因不同水电站点可能使用系统有差异,行业内术语也不一致,数据存在着非独立同分布的问题,使用统一的模型来进行命名实体识别无法达到最好的效果,甚至在某些权重小的样本中效果很差的情况。

31.本领域内的技术人员应明白,本技术的实施例可提供为方法、系统、或计算机程序

产品。因此,本技术可采用完全硬件实施例、完全软件实施例、或结合软件和硬件方面的实施例的形式。而且,本技术可采用在一个或多个其中包含有计算机可用程序代码的计算机可用存储介质(包括但不限于磁盘存储器、cd-rom、光学存储器等)上实施的计算机程序产品的形式。

32.本技术是参照根据本技术实施例的方法、设备(系统)、和计算机程序产品的流程图和/或方框图来描述的。应理解可由计算机程序指令实现流程图和/或方框图中的每一流程和/或方框、以及流程图和/或方框图中的流程和/或方框的结合。可提供这些计算机程序指令到通用计算机、专用计算机、嵌入式处理机或其他可编程数据处理设备的处理器以产生一个机器,使得通过计算机或其他可编程数据处理设备的处理器执行的指令产生用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的装置。

33.这些计算机程序指令也可存储在能引导计算机或其他可编程数据处理设备以特定方式工作的计算机可读存储器中,使得存储在该计算机可读存储器中的指令产生包括指令装置的制造品,该指令装置实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能。

34.这些计算机程序指令也可装载到计算机或其他可编程数据处理设备上,使得在计算机或其他可编程设备上执行一系列操作步骤以产生计算机实现的处理,从而在计算机或其他可编程设备上执行的指令提供用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的步骤。

35.以上的具体实施方式,对本发明的目的、技术方案和有益效果进行了进一步详细说明,所应理解的是,以上仅为本发明的具体实施方式而已,并不用于限定本发明的保护范围,凡在本发明的精神和原则之内,所做的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1