从部分训练集快速训练模型的方法、系统、设备及介质

1.本发明涉及深度学习技术领域,特别涉及一种从部分训练集快速训练模型的方法、系统、设备及介质。

背景技术:

2.近年来,深度学习已经成为炙手可热的话题,自动驾驶、人脸识别、医疗评估等给人们带来了各方面的便利。为了提供更好的服务,消耗更大性能更高的深度学习模型层出不穷。服务商们则需要搜集大量的数据信息给这些深度学习模型提供基础。人们为了获取更多的便利,也会不断提供个人信息供服务商利用。但在享受个人信息交换而来的便利的同时,系统在收集到这些原始信息后可以计算获得更多的数据,原始信息被深度聚合为统计信息,衍生出更多数据用于系统搭建。然而购买记录可能会暴露用户的存款情况,病史标记可能会暴露用户的家族遗传病史。用户的隐私信息会以一种潜在的方式流出,以多种形式出现在用户不了解的地方,直观上,如果要遗忘一些数据,最简单的方法是从输入样本中删除这些数据,再利用剩下的输入样本中重新训练一个机器学习模型,但是其需要消耗极大的训练时间。前人还提出一些基于统计查询的工作,使用统计查询获得数据集特征而非直接在数据集训练的方法,从而做到比重新训练更少的时间进行遗忘,然而统计查询该方法只适用于非自适应机器学习模型(后期训练不依赖于早期训练),在神经网络上难以达到遗忘效果。

3.另一种bourtoule方法将数据集划分成若干部分,每部分训练为一个单独的子模型并存储,通过增量学习训练总模型,为了忘记一个样本,重新培训从包含该样本贡献的第一个中间模型开始。然而这种方法虽然减少了训练时间,但需要消耗大量存储空间;另一种基于联邦学习的数据遗忘工作在正常训练模型聚合阶段保存每轮的更新参数,然后在删除掉遗忘数据重新训练时,减少客户机训练的迭代次数,模型聚合时把当前客户机的参数和之前训练时保存的更新参数合并构造服务端模型,这种方法减少了训练时间,但是也因为保存参数占用了存储更多的空间。因为需要保存更新参数,修改了目标模型的训练过程,并且保存的参数中本身携带了需遗忘的信息,理论上不能保证遗忘彻底。

技术实现要素:

4.本发明的目的是提供一种新的从部分训练集快速训练模型的方法、系统、设备及介质,旨在采用新的技术构思解决背景技术中,采用现有技术进行数据遗忘时所带来的技术问题。

5.本发明提供一种从部分训练集快速训练模型的方法,其包括如下步骤:

6.选取待遗忘的数据子集,从中删除遗忘数据,将删除遗忘数据后剩余的数据子集作为训练样本,训练得到遗忘模型;

7.利用成员推理攻击对遗忘模型进行评估,计算遗忘模型的输出分布,根据输出分布判断删除的遗忘数据是否遗忘成功,若遗忘成功,则将遗忘模型作为最终遗忘模型;

8.利用后门攻击对最终遗忘模型的遗忘效果进行评估,若评估合格,则将最终遗忘模型作为目标模型。

9.本发明还提供实施上述方法的从部分训练集快速训练模型的系统,其包括相互连接并通讯的如下模块:

10.遗忘模型获取模块,用于选取待遗忘的数据子集,从中删除遗忘数据,将删除遗忘数据后剩余的数据子集作为训练样本,训练得到遗忘模型;

11.最终遗忘模型获取模块,用于利用成员推理攻击对遗忘模型进行评估,计算遗忘模型的输出分布,根据输出分布判断删除的遗忘数据是否遗忘成功,若遗忘成功,则将遗忘模型作为最终遗忘模型;

12.目标模型获取模块,用于利用后门攻击对最终遗忘模型的遗忘效果进行评估,若评估合格,则将最终遗忘模型作为目标模型。

13.本发明还提供一种计算机设备,其包括存储器、处理器及存储在所述存储器上并可在所述处理器上运行的计算机程序,其特征在于,所述处理器执行所述计算机程序时,实现上述第一方面所述的从部分训练集快速训练模型的方法。

14.本发明还提供一种计算机可读存储介质,所述计算机可读存储介质存储有计算机程序,所述计算机程序被处理器执行时使所述处理器执行上述第一方面所述的从部分训练集快速训练模型的方法。

15.本发明提出的从部分训练集快速训练模型的方法、系统、设备及介质,其有益效果包括:

16.1、由于本发明的方法只是对目标模型的权重做微小扰动,不需要重新训练,因此大大节省了时间;

17.2、本发明的方法没有在数据样本或目标模型训练过程做改动,因此对所有训练模型通用,无需额外的约束条件;

18.3、本发明的方法不需要出原始数据集和模型以外的任何信息,因此非常高效便捷;

19.4、本发明的方法使用多种指标来评价效果,从多角度客观证明了方法的有效性。

附图说明

20.为了更清楚的说明本发明实施例技术方案,下面将对实施例描述中所需要使用的附图作简单的介绍,显而易见的,下面的描述中的附图是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他附图。

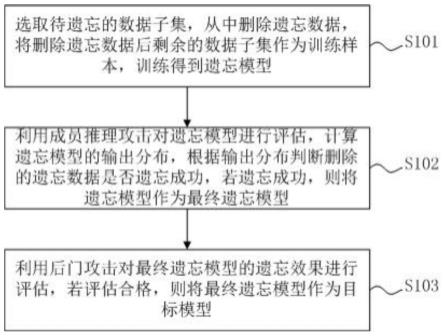

21.图1为本发明实施例提供的从部分训练集快速训练模型的方法流程示意图;

22.图2为本发明实施例提供的模型训练原理示意图;

23.图3为本发明实施例提供的模型推理攻击方法原理示意图;

24.图4为本发明实施例提供的后门攻击原理示意图;

25.图5为本发明实施例提供的后门攻击效果示意图;

26.图6为本发明实施例提供的不同数据集遗忘后的准确率图;

27.图7a和7b为本发明实施例提供的遗忘效果对比图。

具体实施方式

28.下面结合附图对本发明的具体实施方式作进一步说明。在此需要说明的是,对于这些实施方式的说明用于帮助理解本发明,但并不构成对本发明的限定。此外,下面所描述的本发明各个实施方式中所涉及的技术特征只要彼此之间未构成冲突就可以相互组合。

29.参见图1,本实施例提供的从部分训练集快速训练模型的方法,其包括如下步骤:

30.s101、选取待遗忘的数据子集,从中删除遗忘数据,将删除遗忘数据后剩余的数据子集作为训练样本,训练得到遗忘模型。

31.改变遗忘数据在模型中的表现从而校正模型的权重是核心思想。首先,为了进行遗忘,需要确定一个权重校正的方向。在忽略掉成本的情况下,用删除掉遗忘数据后的剩下的数据集进行重新训练是一个简单有效的遗忘方法。基于此想法,不妨把重新训练的模型作为遗忘的参照标准,来引导遗忘的方向。

32.参见图2所示的模型训练原理示意图,其具体步骤为:

33.首先,训练一个参照模型。考虑到时间成本,从剩下的数据中随机选取一部分子集作为参照模型的训练样本,初始模型与目标模型相同。计算遗忘数据在参照模型上的输出分布作为参照。参照模型的后验分布保持不变,在迭代中调整遗忘模型,使得遗忘模型的分布向参照模型的分布迭代靠近。在迭代最后,两种分布近乎一样,迭代到最后遗忘后的遗忘模型,如图2所示。这里的迭代损失函数使用kl散度来计算两种分布之间的距离。

34.s102、利用成员推理攻击对遗忘模型进行评估,计算参考模型的输出分布,根据输出分布判断删除的遗忘数据是否遗忘成功,若遗忘成功,则将遗忘模型作为最终遗忘模型。

35.精度是目标模型训练的重要指标,为了将模型遗忘应用到实际中,不影响目标模型的实际效果,评估遗忘前后的精度是必不可少的。因此,在训练得到遗忘模型之后,还需要对遗忘模型进行评估,在本发明中,使用成员推理攻击对遗忘模型进行评估。

36.参见图3所示的成员推理攻击方法原理图;

37.成员推理攻击可以根据分布判断某个样本是否存在于某个模型的训练集中,成员推理基于一个阴影模型实现,首先需要准备一个与遗忘模型训练集分布类似的数据集成为阴影数据集,以这个阴影数据集为训练集,可以训练一个阴影模型。此时,继续准备阴影模型,阴影训练集,阴影非训练集。以此为基础,训练一个二分类攻击模型,在给定一个输入后,这个攻击模型可以判断出其是否是遗忘模型的训练集成员。

38.在本发明的实验中,将需遗忘的数据输入到遗忘模型中,计算输出分布,攻击模型根据此分布来判断是否为遗忘模型的成员数据。若攻击模型推理出遗忘数据为非成员数据,则表示遗忘成功。

39.在本发明的方法中,采用了成员推理攻击来评估遗忘后模型中仍残存的遗忘信息,成员推理的攻击模型是基于遗忘前的原始模型训练得来,其训练集即是原始模型的训练集减去遗忘数据。能够准确区分学习或未学习过的数据,依照输入样本的后验分布与剩下数据的后验分布差异来判断对于目标模型来说遗忘数据是否为成员数据。

40.不同数据集遗忘后的准确率如图4所示,对于mnist数据集,第一列遗忘前精度为98.97%,第二列在删除掉1/100的样本后重新训练得到98.96%的精度,因样本量没有大量减少,并没有导致精度明显下降,第三列在通过本发明的方法进行遗忘后的精度为98.12%,相较重新训练的模型来说精度没有明显下降,说明本发明的方法并不会影响目标

模型本身的性能。对于cifar10数据集在resnet上的表现,第一列遗忘前精度为90.87%,第二列因为样本数量减少,重新训练得到的精度较遗忘前下降4%,而在本发明的方法中,遗忘后的模型精度为89.64%,略高于重新训练的模型。对于cifar10数据集在vgg16上的表现,遗忘前后趋势与在resnet18相同,但总体精度较resnet低3%内,这是因为vgg16的模型训练cifar10数据集较resnet18模型相比存在架构自身限制,并不受遗忘方法的影响。

41.s103、利用后门攻击对最终遗忘模型的遗忘效果进行评估,若评估合格,则将最终遗忘模型作为目标模型。

42.参见图5所示的模型后门攻击方法原理图;

43.后门攻击作为一种常见的攻击方法,有助于评估遗忘效果。将后门植入在部分数据中,植入后门的数据会被统一打上特定标签。经过后门数据训练生成的模型“记住”了后门信息,在遇到同样后门时会被触发,产生同样的预测结果也就是固定的标签。

44.在本发明中,首先将后门植入在遗忘数据中,标签设置为特定标签,将其与正常数据(即剩余数据)一同训练生成原始模型。如图6左边部分所示,此时的在遇到正常测试数据时可以正常预测,遇到具有同样后门的测试数据时则会产生设定的特定标签。将其应用在遗忘评估阶段,假定已经具有经由后门遗忘数据和正常剩余数据训练而来的,下一步将这个原始模型使用本发明的方法进行遗忘,得到了遗忘后的原始模型。理想情况下,如图6右边部分所示,遗忘后的模型将不会再受到遗忘数据的影响,也就是说,具有后门的数据已经被遗忘。

45.此时将携带后门的数据输入计算,得到的概率分布将会与正常数据的概率分布相似,也会产生与装置后门前同样的预测结果,而非后门打上的特定标签。将携带后门的测试数据输入,得到的精度不到20%,说明模型对80%的后门数据(即需遗忘的数据)的推理结果与其被设置的固定标签不吻合。需遗忘的数据测试精度从98%下降到20%,说明使用本发明的方法确实让目标模型“忘记”了在训练阶段“记住”的后门信息,因此证明遗忘成功。如图所示,在mnist数据集的遗忘过程中,不需要遗忘的数据,其测试精度保持较高的水平,也反映了遗忘后的剩余数据的精度维持在一个较高水平。而在遗忘数据上,其测试精度由最初的98%下降到保持较低的水平,代表遗忘效果。权衡遗忘性能和遗忘后的精度,分别赋上0.5的权重,得到的结果越高代表总体性能最好,如图中的带圆圈的线条所示。cifar10.r数据集同理,如图7a和图7b所示。

46.除了性能外,效率是数据遗忘的关键因素。本发明的目的即是在达到与重新训练效果几乎相同的基础上,耗费比重新训练更少的时间。以重新训练的模型为参照,本发明的方法在时间消耗上可以提高数十倍。如表1所示,对mnist数据集,需要遗忘的数据占总数据集的1/100,一共600条,用本发明的方法进行遗忘,需要两次迭代达到终点,所需时间为3.81s。在训练参照模型时,需花费42.81s,总时长为46.62s。用删除掉需遗忘信息后重新训练的方法花费的总时长为750.69s。对比起来,本发明的方法加速为16.10倍。其他同理。因此,可将最终遗忘模型作为目标模型。

47.表1:不同方法遗忘效率对比表

[0048][0049]

由于本发明的方法只是对目标模型的权重做微小扰动,不需要重新训练,因此大大节省了时间;本发明的方法没有在数据样本或目标模型训练过程做改动,因此对所有训练模型通用,无需额外的约束条件;本发明的方法不需要出原始数据集和模型以外的任何信息,因此非常高效便捷;本发明的方法使用多种指标来评价效果,从多角度客观证明了方法的有效性。

[0050]

在一实施例中,本发明还提供了从部分训练集快速训练模型的系统,该系统包括:

[0051]

遗忘模型获取模块,用于选取待遗忘的数据子集,从中删除遗忘数据,将删除遗忘数据后剩余的数据子集作为训练样本,训练得到遗忘模型;

[0052]

最终遗忘模型获取模块,用于利用成员推理攻击对遗忘模型进行评估,计算遗忘模型的输出分布,根据输出分布判断删除的遗忘数据是否遗忘成功,若遗忘成功,则将遗忘模型作为最终遗忘模型;

[0053]

目标模型获取模块,用于利用后门攻击对最终遗忘模型的遗忘效果进行评估,若评估合格,则将最终遗忘模型作为目标模型。

[0054]

在一实施例中,本发明还提供了一种计算机设备,其包括存储器、处理器及存储在所述存储器上并可在所述处理器上运行的计算机程序,处理器执行所述计算机程序时,实现上述任一实施例所述的从部分训练集快速训练模型的方法。

[0055]

在一实施例中,本发明还提供了一种计算机可读存储介质,所述计算机可读存储介质存储有计算机程序,所述计算机程序被处理器执行时使所述处理器执行上述任一实施例所述的从部分训练集快速训练模型的方法。

[0056]

本发明提供的方法,只需要对目标模型的权重做微小扰动,不需要重新训练,因此大大节省了时间,而且没有在数据样本或目标模型训练过程做改动,对所有训练模型通用,无需增加额外的约束条件。

[0057]

以上结合附图对本发明的实施方式作了详细说明,但本发明不限于所描述的实施方式。对于本领域的技术人员而言,在不脱离本发明原理和精神的情况下,对这些实施方式进行多种变化、修改、替换和变型,仍落入本发明的保护范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1