一种交通异常行为检测方法与系统

2019.》针对背景图像序列,设计一种结合单目标跟踪结果的多目标跟踪方法,来解决无监督异常检测问题。《bai s, he z, lei y, et al. traffic anomaly detection via perspective map based on spatial-temporal information matrix[c]//2019 ieee/cvf conference on computer vision and pattern recongnition, 2019: 117

–

124.》公开的方法中,通过平均背景建模方法、透视图统一裁剪和fpn-dcn网络重新检测提高检测精度,利用轨迹检测结果构造时空信息矩阵,估计异常开始时间。《wang g, yuan x, zhang a, et al. anomaly candidate identification and starting time estimation of vehicles from traffic videos[c]//ieee computer society conference on computer vision and pattern recognition workshops, 2019: 382

–

390.》公开的方法中,使用背景建模与yolov3方法进行异常目标检测,训练tnt(trackletnet tracker,跟踪网络跟踪器)提取异常候选对象的轨迹,估计异常开始时间。《li y, wu j, bai x, et al. multi-granularity tracking with modularlized components for unsupervised vehicles anomaly detection[c]//ieee computer society conference on computer vision and pattern recognition workshops, 2020, 2020-june: 2501

–

2510.》公开的方法中,利用mog2(mixture of gaussians,高斯混合模型)背景建模与faster r-cnn构建检测网络,提出多粒度跟踪算法,分别采用盒级别跟踪和像素级别跟踪来进行异常开始时间预测。

[0008]

但是这些方法都需要使用目标跟踪获取高级轨迹特征,需要消耗大量计算成本、内存需求和时间成本。因此研究降低计算成本、提高预测效率、缩短检测时间的交通异常行为检测方法与系统有着紧迫的需求和必要。

技术实现要素:

[0009]

本发明目的是:针对现有技术的不足,提供一种交通异常行为检测方法与系统,能够提高对交通异常静止车辆状态检测的速度与性能,能够解决交通异常时间检测问题,从而准确估计异常行为开始时间。

[0010]

具体地说,本发明是采用以下技术方案实现的。

[0011]

一方面,本发明提供一种交通异常行为检测方法,包括;通过背景建模,将交通监控视频每一帧中正常移动的车辆从框架中移除,使得异常静止的目标车辆保留在背景中;对通过背景建模提取的每一帧背景进行透视图裁剪,根据车辆大小获得用于对所述交通监控视频进行裁剪的裁剪框;每隔第一帧数对所述交通监控视频进行一次异常目标检测,检测所述交通监控视频的视频帧中的异常目标车辆;在检测到异常目标车辆后,裁剪出异常目标车辆的裁剪图片,将所述交通监控视频以异常目标车辆的位置为中心,向前或向后裁剪出空间容量为若干倍车辆大小、时间为第二帧数的裁剪视频片段,用于之后进行异常时间估计;根据异常目标车辆检测结果进行异常开始时间估计,包括异常车辆状态检测和异常目标匹配;所述异常车辆状态检测,将所述异常目标车辆的裁剪图片与所述裁剪视频片段输入孪生互相关与p3d-attention结合网络模型,检测所述裁剪视频片段中的异常目标是静止状态还是行驶状态,根据异常车辆状态检测结果分别给所述裁剪视频片段打上分类标

签,分别标记为异常、行驶或正常,并确定异常目标车辆发生异常行为时的视频帧;所述异常目标匹配,将待匹配的车辆图片与异常目标车辆的裁剪图输入所述孪生互相关与p3d-attention结合网络,确定该待匹配的车辆是否为异常目标车辆,结合异常目标车辆检测结果中所确定的异常目标车辆发生异常行为时的视频帧,确定交通异常行为开始时间和结束时间。

[0012]

进一步的,所述背景建采用mog2算法。

[0013]

进一步的,所述异常目标检测采用yolov3目标检测方法。

[0014]

进一步的,所述异常车辆状态检测的输入,一是异常目标车辆的裁剪图片,二是以异常目标车辆为中心裁剪出的空间容量为2倍车辆大小、时间为设定的第二帧数的视频片段;所述异常车辆状态检测包括:通过p3d-attention模块分别提取输入的异常目标车辆的裁剪图片的特征图、输入的视频片段每一帧的特征图,并通过p3d-attention提高重要通道特征的相关度;接着将分别提取的特征图选择在三个不同感受野大小的层通过孪生互相关操作进行融合;前两个孪生互相关操作结果使用multiply方法将输入图片和输入视频经过孪生互相关操作后提取的特征图与互相关之前经过p3d-attention模块提取出的输入的视频片段每一帧的特征图融合;使用gap进行池化;最后通过softmax层,直接将输入的异常目标车辆的裁剪图片和输入的视频片段进行分类,根据异常车辆状态检测结果分别给输入的视频片段打上分类标签,分别标记为异常、行驶或正常,并确定发生异常时间点所在的视频帧。

[0015]

进一步的,所述异常目标车辆匹配的输入,一是异常目标车辆的裁剪图片,二是用于异常目标匹配模型的正负类图片;所述异常目标车辆匹配包括:通过p3d-attention模块分别提取两个输入图片的特征图,并且使用提取的两个输入的特征图进行孪生互相关操作;将分别提取的特征图选择在三个不同感受野大小的层通过孪生互相关操作进行融合;获得三个不同大小的特征图,并进行concatenate合并操作;最后通过softmax层,直接将输入的异常目标车辆的裁剪图片和用于异常目标匹配模型正负类图片进行分类,分类结果为匹配或不匹配。

[0016]

进一步的,所述p3d-attention模块由1

×3×

3卷积核和3

×1×

1卷积核分别在空间域和时间域上模拟3

×3×

3卷积,在时间和空间上将3

×3×

3卷积进行解耦; p3d-attention模块还包括提高重要特征的相关度的双通道注意力模块和空间注意力模块。

[0017]

进一步的,所述双通道注意力模块通过空间域上的1

×3×

3卷积核和时间域上3

×1×

1卷积核结合成3

×3×

3卷积,学习帧注意力模块的权重来表达对帧的关注,学习通道注意力模块的权重来表达对通道的关注;其中f代表特征图的帧数,c代表特征图的通道数,h代表特征图的高,w代表特征图的宽。

[0018]

进一步的,所述空间注意力模块通过一个2d卷积核学习单通道的特征图权重矩阵中的位置信息,来确定视频特征图每一个位置的重要性和相关度;其中f代表特征图的帧数,c代表特征图的通道数,h代表特征图的高,w代表特征图的宽。

[0019]

另一方面,本发明还提供一种交通异常行为检测系统,实现上述的交通异常行为检测方法,包括:视频采集剪切模块,采集交通实时视频流,用于提供连续的交通视频流信息,显示在显示模块上,并作为输入信息传输到背景建模模块;所述背景建模模块,预留接口,通过输入格式正确的视频流数据,通过背景建模,将交通监控视频每一帧中正常移动的车辆从框架中移除,使得异常静止的目标车辆保留在背景中;异常目标检测模块,对通过背景建模提取的每一帧背景进行透视图裁剪,根据车辆大小获得用于对所述交通监控视频进行裁剪的裁剪框;每隔第一帧数对所述交通监控视频进行一次异常目标检测,检测所述交通监控视频的视频帧中的异常目标车辆;在检测到异常目标车辆后,裁剪出异常目标车辆的裁剪图片,将所述交通监控视频以异常目标车辆的位置为中心,向前或向后裁剪出空间容量为若干倍车辆大小、时间为第二帧数的裁剪视频片段,用于之后进行异常时间估计;异常时间估计模块,包括异常车辆状态检测和异常目标匹配;所述异常车辆状态检测,将所述异常目标车辆的裁剪图片与所述裁剪视频片段输入孪生互相关与p3d-attention结合网络模型,检测所述裁剪视频片段中的异常目标是静止状态还是行驶状态,根据异常车辆状态检测结果分别给所述裁剪视频片段打上分类标签,分别标记为异常、行驶或正常,并确定异常目标车辆发生异常行为时的视频帧;所述异常目标匹配,将待匹配的车辆图片与异常目标车辆的裁剪图输入所述孪生互相关与p3d-attention结合网络,确定该待匹配的车辆是否为异常目标车辆,结合异常目标车辆检测结果中所确定的异常目标车辆发生异常行为时的视频帧,确定交通异常行为开始时间和结束时间;显示模块,显示输入的视频、图像信息和输出的异常行为检测位置与异常时间信息及警告信息。

[0020]

本发明的交通异常行为检测方法与系统的有益效果如下:本发明的交通异常行为检测方法是一种两阶段道路交通异常事件检测方法,基于孪生互相关与p3d-attention网络结合的机制。孪生互相关主要用于加强对异常目标车辆的关注,充分融合时空特征与异常目标特征,关注特定目标(例如异常静止的车辆,作为异常目标车辆),对异常目标车辆状态检测方法与图像比较方法进行学习,以提高对异常目标车辆状态检测的速度与性能,解决交通异常行为时间检测问题,从而准确估计交通异常行为开始时间。p3d-attention模块,以p3d模块将空间与时间卷积解耦为基础,分别与适应的空间注意力模块和双通道注意力模块融合,充分融合时空特征,提高重要通道特征的相关度,增加特征图的全局相关性,以提高对异常行为车辆的预测性能。在相关数据集上的,对同一个视频中的异常进行融合,以获得最终的异常结果。实验结果表明,本发明的交通异常行为检测方法,在各种交通视频场景下都是有效的,异常目标检测f1成绩为0.9705,异常时间估计均方根误差为9.22,对12帧视频的检测平均时间为12.2 ms,相比使用跟踪轨迹方法的342 ms,消耗更小,在时间效率上更为优越。

附图说明

[0021]

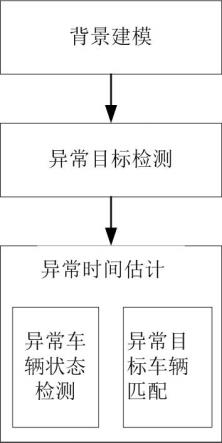

图1是本发明实施例1的流程图。

[0022]

图2是本发明的抖动视角裁剪视频示意图,(a)为摄像头场景下的视频,(b)为将(a)随机裁剪生成的不同抖动摄像头场景下的视频,(c)为根据(b)生成的目标框。

[0023]

图3是本发明的孪生互相关与p3d-attention结合网络模型示意图。

[0024]

图4是本发明的深度互相关操作示意图。

[0025]

图5是本发明的深度互相关机制原理示意图。

[0026]

图6是本发明的调整后的双通道注意力机制。

具体实施方式

[0027]

下面结合实施例并参照附图对本发明作进一步详细描述。

[0028]

实施例1:本发明的一个实施例,为一种交通异常检测方法,基于孪生互相关与p3d-attention网络结合的机制,可用于精确估计道路交通异常行为开始时间和结束时间。

[0029]

如图1所示,本实施例的交通异常检测方法的输入为一个摄像头拍摄的交通监控视频,检测方法包括:一、通过背景建模将异常目标车辆保留在背景中。

[0030]

异常目标车辆,即异常静止的目标车辆。通过背景建模,将交通监控视频每一帧中正常移动的车辆从框架中移除,使得异常静止的目标车辆保留在背景中。

[0031]

背景建模的方法一般包括移动平均值背景建模方法和mog2算法。mog2算法为一种基于高斯混合概率密度的自适应算法,递归方程用于不断更新参数,同时也为每个像素选择适当的gmm分量。在小目标拥挤背景和车速较慢的道路背景下,移动平均值背景建模方法和mog2算法相比,效果较差,且在拥挤的交通流当中,移动平均值背景建模方法会更多的将移动车辆信息保留在建模的背景中,使得后续进行异常目标车辆状态检测方法时对静止车辆出现误检。而且在摄像头晃动的场景下,mog2算法比移动平均值背景建模方法更稳定。

[0032]

因此,本发明采用mog2算法,将异常目标车辆保留在背景中。mog2算法是一种基于高斯混合概率密度的自适应算法,递归方程用于不断更新参数,同时也为每个像素选择适当的gmm分量,gmm分量在较长的时间段内逐渐更新,对不同的场景有更好的适应性。

[0033]

在本实施例中,监控视频中,视频每秒传输帧数为30帧,将mog2算法的更新间隔设置为120帧,对该120帧的视频进行异常目标车辆状态检测需要的时间为4 s。此时,所有正常移动的车辆都从框架中移除,静态车辆仍保留在背景中。

[0034]

通过背景建模,将交通监控视频每一帧中正常移动的车辆从框架中移除,使得异常静止的目标车辆保留在背景中。但是背景建模会导致车辆外观建模延迟的问题,例如前向背景建模会导致静止的车辆在异常静止发生一段时间后才会显示在背景中,得到的是异常的延迟开始时间。为了得到准确的异常开始时间,只能先通过背景建模得到异常的延迟开始时间,然后通过回溯分析原始图像得到更准确的时间定位。为此,本发明还需要对背景进行异常目标检测,获得异常目标车辆的裁剪图片和裁剪视频;将其输入孪生互相关与p3d-attention网络模型,进行异常时间估计,以得到准确的异常开始时间和结束时间。

[0035]

二、对背景进行异常目标检测,获得异常目标车辆的裁剪图片和裁剪视频。

[0036]

对交通监控视频中通过背景建模提取的每一帧背景进行透视图裁剪,根据车辆大小获得用于对监控视频进行裁剪的裁剪框;对交通监控视频的每一帧,每隔指定的第一帧

数(例如30帧)使用异常目标检测方法检测一次背景,检测视频帧中的异常目标车辆;在检测到异常目标车辆后,以异常目标车辆的位置为中心,向前(或向后)裁剪出空间容量为2倍车辆大小、时间为设定帧数(例如12帧)的视频片段,用于之后进行异常时间估计。

[0037]

可以采用的异常目标检测方法包括yolov3、faster-rcnn等通用目标检测方法。优选的,本发明采用yolov3目标检测方法。

[0038]

对于视频,除了存在小目标检测困难的问题之外,还有摄像头抖动的问题。为了能够很好地将异常静止的异常目标车辆与行驶启动车辆区分开来,本发明通过随机裁剪的形式生成了不同抖动摄像头场景下的视频,作为模拟抖动数据集。随机裁剪采用的方式一是根据抖动幅度大小进行裁剪,二是根据抖动是随机或是来回震颤抖动进行裁剪。抖动幅度大小设置分别为半个车辆容量和1个车辆容量等,如图2所示。优选的,考虑到从视频中裁剪出的异常目标车辆数据太少,为了防止孪生互相关与p3d-attention结合网络模型学习偏向导致的过拟,通过目标跟踪算法制作若干数量(例如超过4000个)不同车辆的数据样本。

[0039]

三、将异常目标车辆的裁剪图片和裁剪视频输入孪生互相关与p3d-attention网络模型,进行异常时间估计,得到准确的异常开始时间和结束时间。

[0040]

异常时间估计采用构建的孪生互相关与p3d-attention结合网络模型,对输入图片和输入视频进行异常车辆状态检测和异常目标匹配。

[0041]

异常车辆状态检测任务,主要是检测输入视频片段中的异常目标是静止状态还是行驶状态,根据异常车辆状态检测结果分别给视频片段打上分类标签,分别标记为异常(anomaly)、行驶(driving)或正常(normal),并确定发生异常时间点所在的视频帧。发生异常时间点即为行驶和静止这两种状态变化的瞬间。

[0042]

1)异常(anomaly):异常目标车辆停滞于路面,非异常目标车辆正常行驶,此时标定为异常。

[0043]

2)行驶(driving):异常目标车辆为正常行驶状态。

[0044]

3)正常(normal):没有异常目标车辆停滞于路面,但包括其他正常汽车驶过,以及路面无车的状态。

[0045]

异常目标车辆匹配任务,用于辅助异常车辆状态检测,通过图片匹配确定待匹配的车辆是否为异常目标车辆,结合异常目标车辆检测结果中所确定的该异常目标车辆发生异常行为时所在的视频帧,从而确定交通异常行为开始时间和结束时间。

[0046]

与本发明提出的孪生互相关与p3d-attention网络结合的模型相对应有三个输入:一是异常目标车辆的裁剪图片,二是以异常目标车辆为中心裁剪出的空间容量为2倍车辆大小、时间为设定的第一帧数(例如12帧)的视频片段,三是用于异常目标匹配的正负类图片。

[0047]

在神经网络中,卷积操作本质上是互相关操作(cross-correlation),具有权值共享的特点,即,所有基于卷积神经网络的同一层节点共享相同的连接权重。

[0048]

本发明的孪生互相关与p3d-attention结合网络模型,主体以p3d-attention网络结构为基础,在该p3d-attention网络结构中融合互相关机制,如图3所示。孪生互相关结构中,通过执行深度互相关操作提取图片与视频的特征;特征图是输入图片或输入视频经过孪生互相关与p3d-attention结合网络中孪生互相关的卷积核操作后提取的特征。本实施例中,孪生互相关与p3d-attention结合网络模型的输入是两张

的图片与的视频,且三者都通过p3d-attention主干网络提取特征,即三个输入的主干网络是共享权重的。

[0049]

异常车辆状态检测任务的输入,一是异常目标车辆的裁剪图片(例如),二是以异常目标车辆为中心裁剪出的空间容量为2倍车辆大小、时间为设定的第二帧数(例如12帧,)的视频片段。每隔指定的第一帧数(例如30帧)对异常目标检测结果中包含异常目标的视频进行异常车辆状态检测。首先通过p3d-attention模块分别提取输入模板图片的特征图、输入视频每一帧的特征图,并通过p3d-attention提高重要通道特征的相关度;接着将分别提取的特征图选择在三个不同感受野大小的层通过孪生互相关操作(如图3中互相关1、互相关2、互相关3)进行融合。优选的,孪生互相关操作采用siamfc模型的互相关操作。前两个孪生互相关操作结果使用multiply方法将输入图片和输入视频经过孪生互相关操作后提取的特征图与互相关之前经过p3d-attention模块提取出的视频特征图融合;并使用gap(global average pooling,全局平均池化层)代替全连接层进行池化;最后通过softmax层,直接将输入的异常目标车辆的裁剪图片和输入的视频片段进行分类。使用multiply方法将输入图片和输入视频经过孪生互相关操作后提取的特征图与互相关之前经过p3d-attention模块提取出的视频特征图融合,类似于空间注意力机制,其不同之处在于,空间注意力机制通过梯度下降拟合网络学习所需要关注的部分,而孪生互相关机制的关注部分的输入为由预先设定的异常目标车辆裁剪图片经p3d-attention模块提取的特征图,该提取的特征图用作深度互相关的操作的卷积核输入,强化异常目标车辆裁剪图片与输入视频匹配的特征,通过孪生互相关与p3d-attention结合网络直接强化重要位置,如图5所示。gap在特征图与最终的分类间转换更加简单自然,不像全连接层需要大量训练调优的参数,降低了空间参数会使模型更加健壮,抗过拟合效果更佳。使用gap替代全连接层的网络,通常依然有较好的预测性能,还可以防止模型过拟合,并能够大幅减少模型训练的计算量。

[0050]

异常目标车辆匹配任务的输入,一是异常目标车辆的裁剪图片(例如),二是用于异常目标匹配模型的正负类图片(例如)。首先通过p3d-attention模块分别提取两个输入图片的特征图,并且使用提取的两个输入的特征图进行孪生互相关操作。依然将分别提取的特征图选择在三个不同感受野大小的层通过孪生互相关操作(如图3中互相关4、互相关5、互相关6)进行融合。孪生互相关操作使用valid类型,也就是不添加padding进行互相关操作,获得、和大小的特征图,并进行concatenate合并操作,concatenate合并操作是将张量沿着指定维数拼接起来。最后通过softmax层,直接将输入的异常目标车辆的裁剪图片和用于异常目标匹配模型正负类图片进行分类,分类结果为匹配或不匹配。

[0051]

1)匹配:每一对匹配的图片都是同一辆车在不同时间的裁剪图片。

[0052]

2)不匹配:模板图片是异常目标车辆的裁剪图片,不匹配的图片可以是用于异常

目标匹配模型的正负类图片中另外一辆车或任何可以出现在交通路面场景的图像。考虑到该任务是为了明确车辆静止时间,如果同一辆车iou小于0.7将视为不匹配。

[0053]

在第二个任务中互相关操作没有使用距离函数计算图片之间的相似度,而是使用与siamfc相同的深度互相关操作,对相同形状大小的特征图进行了深度互相关操作,使用连接(concatenate)方法聚合不同尺度的特征,然后进行分类。

[0054]

在对所有输入进行处理获得全部异常的开始时间与结束时间之后,进行异常融合。也就是将异常时间相交的异常视为同一个异常;例如对异常时间间隔不超过5秒,且iou大于0.5的异常视为同一个异常。

[0055]

常规互相关操作的每个卷积核同时操作输入图片的每个通道。本发明选择使用深度互相关(depthwise cross correlation)操作,深度互相关操作的一个卷积核只负责一个通道,一个通道只与相对应的卷积核进行互相关操作,得到一个特征通道数非1的输出,用来保留更多的特征,操作描述如图4所示,其中为深度互相关操作。

[0056]

构建如图3所示的孪生互相关与p3d-attention结合网络模型具体包括以下步骤。

[0057]

步骤3.1,p3d-attention网络对两种输入的调整。

[0058]

本发明提取特征的主干网络为p3d-attention网络。在实现孪生互相关与p3d-attention网络融合时,需要将2d卷积操作替换为3d卷积操作。p3d-attention网络首先由1

×3×

3卷积核和3

×1×

1卷积核分别在空间域和时间域上模拟3

×3×

3卷积,在时间和空间上将3

×3×

3卷积进行解耦;其次p3d-attention网络还包括双通道注意力机制和空间注意力机制,提高重要特征的相关度。

[0059]

孪生互相关与p3d-attention结合网络模型的两种输入分别为图片和视频。其中图片包括异常目标车辆的裁剪图片和用于异常目标匹配模型的正负类图片,例如(,即)的图片;视频为以异常目标车辆为中心裁剪出的空间容量为2倍车辆大小、时间为第二帧数的视频片段,例如(,即)的视频。两种输入都通过p3d-attention主干网络提取特征,即异常车辆状态检测的两个输入及异常目标匹配的两个输入的主干网络是共享权重的。两个输入在同时通过同一个网络的情况下,不仅图片大小不同(80:40),输入维度也不同(4:3),在注意力机制结合时需要对网络结构进行调整。

[0060]

首先需要将图片(例如的图片)调整为添加时间维度的数据(例如),以适应对视频维度的卷积操作;但依然存在时间维度上大小不同的情况(12:1)。针对于此,孪生互相关与p3d-attention结合网络模型结构的实现需要分别在p3d模块和attention模块中调整。

[0061]

对于p3d模块,图片尺寸大小的不同并不是问题,两种输入都可以在1

×3×

3卷积核上进行卷积操作;而对于时间维度大小的不同,在执行图片输入时需要忽略3

×1×

1的卷积核操作,因为对于时间维度只有1的图片,卷积大小为3并没有意义。

[0062]

对于attention模块,分别使用双通道注意力模块与空间注意力模块在时间帧和空间帧上施加关注,强化关键帧,依据特征图自动给不同关节点分配不同的注意力,关注先

验知识所提到的位置,去除背景和噪声对识别的干扰,具体步骤参见步骤3.2。注意力机制表达为:式中,m代表注意力模块,f为特征图,代表矩阵元素依次相乘。

[0063]

步骤3.2:双通道注意力模块和空间注意力模块的调整。

[0064]

由伪3d卷积神经网络与注意力机制结合的p3d-attention网络,采用p3d-attention模块实现使用注意力机制对通道与特征图施加关注,包括双通道注意力模块和空间注意力模块。

[0065]

双通道注意力模块,分别在视频帧之间和每一帧的通道上施加关注。特征图,其中r中的f代表帧,c代表每一帧下的通道数,h和w代表不同通道下的特征,学习的权重来决定每个通道的重要性,将的特征图转置为,并嵌入到2d空间注意力模块中,分别学习与的权重来分别表达对帧与通道的关注。

[0066]

空间注意力模块采用cbam(convolutional block attention module,卷积块注意力模块)模块实现,通过学习在空间维度上的权重图来关注空间特征。以视频每一帧的特征图为例,其中f代表帧,c代表特征图的通道数,h代表特征图的高,w代表特征图的宽,空间注意力模块主要通过一个2d卷积核学习单通道的特征图权重矩阵中的位置信息,来确定视频特征图每一个位置的重要性和相关度。卷积核大小与特征图大小并不相关,所以视频特征和图片特征都可以直接级联空间注意力模块来提高重要位置的相关度。

[0067]

在p3d模块将3d卷积解耦成空间与时间卷积的基础上,注意力模块分为以下三个不同的p3d-attention模块实现网络模型。

[0068]

p3d-attention-a:时间1d卷积核级联到空间2d卷积核,通过在后级联空间注意力模块,并在后级联通道注意力模块,实现p3d-attention-a结构,时间1d卷积核直接连接到最终输出,由式(2)给出:式中,表示输入特征图,表示施加注意力机制后的输出,与具有相同的特征维度。

[0069]

p3d-attention-b:原有的p3d-b采用两个卷积核之间的间接影响,使得两个卷积核以并行方式处理卷积特征;在去掉残差单元基础上,在位置后级联空间注意力模块(),并接着在位置后级联通道注意力模块(),表示为:

p3d-attention-c:p3d-c模块是p3d-a和p3d-b之间的折衷,同时建立、和最终输出之间的直接影响;为了实现基于级联p3d-a架构的和最终输出之间的直接连接,通过添加注意力模块构建p3d-attention-c,表示为:为了适应孪生网络与注意力机制的融合,需要对输入的不同分支进行对应调整,调整后的双通道注意力机制如图6所示。以特征图为例,其中f代表帧数,c代表特征图的通道数,h代表特征图的高,w代表特征图的宽,本发明为了适应3d卷积,构建了双通道注意力模块(dual-channel attention model),通过空间域上的1

×3×

3卷积核和时间域上3

×1×

1卷积核结合成3

×3×

3卷积,学习帧注意力模块的权重来表达对帧的关注,学习通道注意力模块的权重来表达对通道的关注。

[0070]

关于对帧的关注,即学习,需要将的特征图转置为(),通过最大池化和平均池化消除空间维度h与w。最大池化(maxpooling)可以提取特征纹理。减少无用信息的影响。平均池化(avgpooling)可以保留背景信息。那么两个输入(图片与视频)经池化后的维度将会有所不同,分别为和,所以在执行图片输入的帧的注意力机制时本发明忽略帧的注意力操作。

[0071]

关于对每一帧所属通道的关注,即学习,可以直接将时间维度上的f池化消除,图片与视频两个输入池化后的维度是相同的(c:c),所以在执行图片输入的图片通道注意力机制时,本发明忽略图片通道注意力操作。

[0072]

本发明的交通异常行为检测方法,异常时间估计rmse(均方根误差)为9.22,对12帧视频的检测平均时间为12 ms,在时间效率上具有较大的优越性。

[0073]

本发明的交通异常行为检测方法,异常时间估计采用异常车辆状态检测与异常目标匹配结合,采用多任务训练,输入的两张图片和一个视频分别输入到孪生互相关与p3d-attention结合网络的一个分支,三个分支为相同的结构,共享相同的参数;网络尾部使用两个softmax层作为两个分类任务的结果。孪生互相关与p3d-attention结合网络模型基于参数的共享同时对异常车辆状态检测方法与基于孪生网络的图像匹配方法进行多任务学习,通过对车辆的位置状态进行预测,并利用异常目标匹配方法进一步精确异常开始时间所在帧,能够很好的解决交通异常开始时间估计问题,准确估计异常行为开始时间。

[0074]

更进一步,整个孪生互相关与p3d-attention结合网络是一个卷积神经网络架构,在训练时为了减少模型的误判,本发明采用f1-score而不是准确率来评估模型的性能。f1-score又称平衡f分数(balanced f score),被定义为查准率p和召回率r的调和平均数。

[0075]

其中,p(precision)是指准确率。

[0076]

式中,tp表示正样本,即分类器判定为正例,且判定正确;fp表示分类器判定为正例,但是判定错误。

[0077]

r(recall)是指召回率。

[0078]

式中,fn表示分类器判定为负例,但是判定错误。

[0079]

f1得分是准确率和召回率的调和平均值。

[0080]

实施例2:本发明的另一个实施例,为一种交通异常行为检测系统,包括:视频采集剪切模块,采集交通实时视频流,用于提供连续的交通视频流信息,显示在显示模块上,并作为输入信息传输到背景建模模块;所述背景建模模块,预留接口,通过输入格式正确的视频流数据,通过背景建模,将交通监控视频每一帧中正常移动的车辆从框架中移除,使得异常静止的目标车辆保留在背景中;异常目标检测模块,对通过背景建模提取的每一帧背景进行透视图裁剪,根据车辆大小获得用于对所述交通监控视频进行裁剪的裁剪框;每隔第一帧数对所述交通监控视频进行一次异常目标检测,检测所述交通监控视频的视频帧中的异常目标车辆;在检测到异常目标车辆后,裁剪出异常目标车辆的裁剪图片,将所述交通监控视频以异常目标车辆的位置为中心,向前或向后裁剪出空间容量为2倍车辆大小、时间为第二帧数的裁剪视频片段,用于之后进行异常时间估计;异常时间估计模块,包括异常车辆状态检测和异常目标匹配;所述异常车辆状态检测,将所述异常目标车辆的裁剪图片与所述裁剪视频片段输入孪生互相关与p3d-attention结合网络模型,检测所述裁剪视频片段中的异常目标是静止状态还是行驶状态,根据异常车辆状态检测结果分别给所述裁剪视频片段打上分类标签,分别标记为异常、行驶或正常,并确定异常目标车辆发生异常行为时的视频帧;所述异常目标匹配,将待匹配的车辆图片与异常目标车辆的裁剪图输入所述孪生互相关与p3d-attention结合网络,确定该待匹配的车辆是否为异常目标车辆,结合异常目标车辆检测结果中所确定的异常目标车辆发生异常行为时的视频帧,确定交通异常行为开始时间和结束时间;显示模块,显示输入的视频、图像信息和输出的异常行为检测位置与异常时间信息及警告信息。

[0081]

在一些实施例中,上述技术的某些方面可以由执行软件的处理系统的一个或多个处理器来实现。该软件包括存储或以其他方式有形实施在非暂时性计算机可读存储介质上的一个或多个可执行指令集合。软件可以包括指令和某些数据,这些指令和某些数据在由一个或多个处理器执行时操纵一个或多个处理器以执行上述技术的一个或多个方面。非暂

时性计算机可读存储介质可以包括例如磁或光盘存储设备,诸如闪存、高速缓存、随机存取存储器(ram)等的固态存储设备或其他非易失性存储器设备。存储在非临时性计算机可读存储介质上的可执行指令可以是源代码、汇编语言代码、目标代码或被一个或多个处理器解释或以其他方式执行的其他指令格式。

[0082]

计算机可读存储介质可以包括在使用期间可由计算机系统访问以向计算机系统提供指令和/或数据的任何存储介质或存储介质的组合。这样的存储介质可以包括但不限于光学介质(例如,光盘(cd)、数字多功能光盘(dvd)、蓝光光盘)、磁介质(例如,软盘、磁带或磁性硬盘驱动器)、易失性存储器(例如,随机存取存储器(ram)或高速缓存)、非易失性存储器(例如,只读存储器(rom)或闪存)或基于微机电系统(mems)的存储介质。计算机可读存储介质可以嵌入计算系统(例如,系统ram或rom)中,固定地附接到计算系统(例如,磁性硬盘驱动器),可移除地附接到计算系统(例如,光盘或通用基于串行总线(usb)的闪存),或者经由有线或无线网络(例如,网络可访问存储(nas))耦合到计算机系统。

[0083]

请注意,并非上述一般性描述中的所有活动或要素都是必需的,特定活动或设备的一部分可能不是必需的,并且除了描述的那些之外可以执行一个或多个进一步的活动或包括的要素。更进一步,活动列出的顺序不必是执行它们的顺序。而且,已经参考具体实施例描述了这些概念。然而,本领域的普通技术人员认识到,在不脱离权利要求书中阐述的本公开的范围的情况下,可以进行各种修改和改变。因此,说明书和附图被认为是说明性的而不是限制性的,并且所有这样的修改被包括在本公开的范围内。

[0084]

上面已经关于具体实施例描述了益处、其他优点和问题的解决方案。然而,可能导致任何益处、优点或解决方案发生或变得更明显的益处、优点、问题的解决方案以及任何特征都不应被解释为任何或其他方面的关键、必需或任何或所有权利要求的基本特征。此外,上面公开的特定实施例仅仅是说明性的,因为所公开的主题可以以受益于这里的教导的本领域技术人员显而易见的不同但等同的方式进行修改和实施。除了在下面的权利要求书中描述的以外,没有意图限制在此示出的构造或设计的细节。因此明显的是,上面公开的特定实施例可以被改变或修改,并且所有这样的变化被认为在所公开的主题的范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1