基于视觉和无线双模态联合感知的动作表示及识别方法

1.本发明涉及动作识别技术领域,具体而言,尤其涉及一种基于视觉和无线双模态联合感知的动作表示及识别方法。

背景技术:

2.现有的动作识别方法主要基于穿戴式设备技术、雷达技术和计算机视觉技术实现。穿戴式设备需要在人体上提前布置相关装置,便携性较差,导致该方向的研究方式较少。当今主要的研究方向集中在雷达技术和计算机视觉技术两方面。

3.雷达技术有着高隐私性和不受光线背景影响的优点,但是雷达信号受周围运动物体影响较大,并且在动作的横向分辨率上有着明显的劣势。

4.计算机视觉技术包含丰富动作的信息并且有着较高的动作横向分辨率,但是易受光线和背景变化影响。

5.将雷达技术和计算机视觉技术有效融合,是技术研究的热门方向。利用两种技术在动作识别上各自的优势,能够进一步提高动作识别准确率。现有的两种技术的模态融合方式多是特征提取之后进行决策级融合,忽略两个模态数据的关系,导致特征提取的效率不高,从而影响融合性能。

技术实现要素:

6.根据上述提的模态融合方式特征提取效率不高的技术问题,而提供一种基于视觉和无线双模态联合感知的动作表示及识别方法。本发明通过挖掘两个模态间的关系,从而提升模态融合的有效性,进一步提高了动作识别的可靠性。

7.本发明采用的技术手段如下:

8.一种基于视觉和无线双模态联合感知的动作表示方法,包括以下步骤:

9.分别获取针对人体动作的雷达图像数据和视频图像数据;

10.通过第一特征提取网络对所述雷达图像数据进行特征提取,从而获得第一提取特征;通过第二特征提取网络对所述视频图像数据进行特征提取,从而获得第二提取特征;

11.将所述第一提取特征输入速度关系编码器进行编码处理,所述速度关系编码器用于挖掘第一提取特征中的速度相关性信息,并基于所述速度相关性信息对第一提取特征进行引导从而输出第一引导特征,所述速度关系编码器包括依次连接的若干结构相同的子速度关系编码器;同时将所述第二提取特征输入帧间关系编码器进行编码处理,所述帧间关系编码器用于挖掘第二提取特征中的帧间相关性信息,并基于所述帧间相关性信息对第二提取特征进行引导从而输出第二引导特征,所述帧间关系编码器包括依次连接的若干结构相同的子帧间关系编码器;

12.将所述第一引导特征和第二引导特征输入模态关系编码器进行编码处理,所述模态关系编码器用于挖掘第一引导特征和第二引导特征的模态间特征相关性信息,并基于所述模态间特征相关性信息对第一引导特征和第二引导特征进行二次引导,从而生成联合表

征,所述模态关系编码器包括依次连接的若干相同的子模态关系编码器。

13.进一步地,方法还包括:

14.将获取的联合表征输入与所述第一特征提取网络相反的网络结构进行特征重构,从而获取第一重构特征;同时将获取的联合表征输入与所述第二特征提取网络相反的网络结构进行特征重构,从而获取第二重构特征;

15.通过一致性损失在第一提取特征与第一重构特征间形成约束以减少信息损失;同时通过一致性损失在第二提取特征与第二重构特征间形成约束以减少信息损失。

16.进一步地,将所述第一提取特征输入速度关系编码器进行编码处理,包括:

17.基于所述第一提取特征获取第一查询矩阵、第一键矩阵以及第一值矩阵;

18.将所述第一查询矩阵、第一键矩阵以及第一值矩阵输入速度关系编码器,任意所述子速度关系编码器包括依次连接的self-attention模块、add&normalize模块、feed forward模块以及add&normalize模块,所述self-attention模块用于计算模态内信息的相关性,所述add&normalize模块用于对数据进行归一化处理。

19.进一步地,将所述第二提取特征输入帧间关系编码器进行编码处理,包括:

20.基于所述第二提取特征获取第二查询矩阵、第二键矩阵以及第二值矩阵;

21.将所述第二查询矩阵、第二键矩阵以及第二值矩阵输入子帧间关系编码器,任意所述子帧间关系编码器包括依次连接的self-attention模块、add&normalize模块、feed forward模块以及add&normalize模块,所述self-attention模块用于计算模态内信息的相关性,所述add&normalize模块用于对数据进行归一化处理。

22.进一步地,将所述第一引导特征和第二引导特征输入模态关系编码器进行编码处理,包括:

23.基于所述速度关系编码器的输出矩阵获取第三查询矩阵、第三键矩阵以及第三值矩阵;基于所述帧间关系编码器的输出矩阵获取第四查询矩阵、第四键矩阵以及第四值矩阵;

24.任意所述子模态关系编码器包括两条结构相同的编码链路,分别为视觉链路和雷达链路,任意编码链路包括依次连接的cross-attention模块、add&normalize模块、self-attention模块、feed forward模块以及add&normalize模块,所述cross-attention模块用于计算模态间信息的相关性;

25.将第三查询矩阵、第四键矩阵以及第四值矩阵输入视觉链路;

26.将第四查询矩阵、第三键矩阵以及第三值矩阵输入雷达链路;

27.根据cross-attention计算相关性,然后引导模态内值矩阵。

28.进一步地,所述第一特征提取网络为三层2d卷积神经网络,其中前两层卷积核大小为3,使用batchnorm2d函数以及relu激活函数,通道数由3、16、32,依次变化;第三层卷积核大小为3,使用batchnorm2d函数以及relu激活函数,通道数由32变为64。

29.进一步地,所述第二特征提取网络为2层3d卷积神经网络,第一层卷积核大小为3,使用batchnorm3d函数以及relu激活函数,通道数由3变为8;第二层卷积核大小为3,通道数由8变为16。

30.本发明还公开了一种基于视觉和无线双模态联合感知的动作识别方法,包括以下步骤:

31.基于上述任意一项方法获取动作表示数据;

32.基于所述动作表示数据进行动作识别。

33.较现有技术相比,本发明具有以下优点:

34.本发明针对同一个行为动作分别获取视频图像信息和雷达图像信息,通过计算两种模态内部的相关性信息和两种模态之间的相关性信息,并基于上述相关性信息重建图像特征,将两种模态下的图像特征有效融合即满足了整个动作信息的丰富性,也可以弥补单一技术的不足。

35.基于上述理由本发明可在人机交互、人类行为分析、娱乐游戏等领域广泛推广。

附图说明

36.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图做以简单地介绍,显而易见地,下面描述中的附图是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动性的前提下,还可以根据这些附图获得其他的附图。

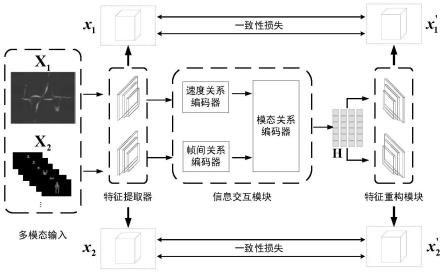

37.图1为本发明动作表示方法执行框架图。

38.图2为本发明动作表示方法执行框架中信息交互模块架构图。

具体实施方式

39.为了使本技术领域的人员更好地理解本发明方案,下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分的实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都应当属于本发明保护的范围。

40.需要说明的是,本发明的说明书和权利要求书及上述附图中的术语“第一”、“第二”等是用于区别类似的对象,而不必用于描述特定的顺序或先后次序。应该理解这样使用的数据在适当情况下可以互换,以便这里描述的本发明的实施例能够以除了在这里图示或描述的那些以外的顺序实施。此外,术语“包括”和“具有”以及他们的任何变形,意图在于覆盖不排他的包含,例如,包含了一系列步骤或单元的过程、方法、系统、产品或设备不必限于清楚地列出的那些步骤或单元,而是可包括没有清楚地列出的或对于这些过程、方法、产品或设备固有的其它步骤或单元。

41.如图1-2所示,本发明提供了一种基于视觉和无线双模态联合感知的动作表示方法,包括以下步骤:

42.s1、分别获取针对人体动作的雷达图像数据和视频图像数据。

43.具体来说,通过77hz ghz fmcw毫米波雷达和1080p网络摄像头同时对人体动作进行采集,并将处理好的数据按比例划分训练集和测试集。

44.s2、通过第一特征提取网络对所述雷达图像数据进行特征提取,从而获得第一提取特征;通过第二特征提取网络对所述视频图像数据进行特征提取,从而获得第二提取特征。

45.将基于s1获取到的两种模态数据分别经过卷积神经网络提取特征,本发明中,特

forward。其中self-attention用于计算模态内信息的相关性,self-attention中包含multi-head操作,其目的主要是为了从不同的参数空间角度取去挖掘特征间的相关性与非相关性。add&normalize一方面用于对数据进行归一化处理减少数据分布变化相差较大的影响,另一方面在传播过程中防止梯度过小信息消失。feed forward用于将multi-head操作后的数据整合后前向传播。

56.上述self-attention均用于实现以下计算:

[0057][0058]

公式对应信息交互过程中self-attention的核心公式,该部分实现了模态内与模态间信息的相关性发掘,实现信息的交互,进而学习到联合表征h。其中qi、ki、vi分别是来自数据xi的查询矩阵、键矩阵、值矩阵。i=1表示雷达模态,i=2表示视频模态。查询矩阵是查询向量的集合,它与键矩阵相乘,得到的数值代表着向量与向量之间的相似度,也就是时刻间的相关性程度,并用它来引导值矩阵vi,通过步骤的不断重复,一步步得到联合表征h。

[0059]

本实施例中,速度关系编码器中子速度关系编码器的个数优选为5,帧间关系编码中子帧间关系编码器的个数同样优选为5,在不同的实施例中,子速度关系编码器和子帧间关系编码的个数根据实际需求设置,可以相同也可以不同。

[0060]

作为本发明进一步优选的实施方式,帧间关系编码器和速度关系编码器均是5层。

[0061]

s4、将所述第一引导特征和第二引导特征输入模态关系编码器进行编码处理,所述模态关系编模块器用于挖掘第一引导特征和第二引导特征的模态间特征相关性信息,并基于所述模态间特征相关性信息对第一引导特征和第二引导特征进行二次引导,从而生成联合表征,所述模态关系编码器包括依次连接的若干相同的子模态关系编码器。主要包括:

[0062]

s401、基于所述速度关系编码器的输出矩阵获取第三查询矩阵、第三键矩阵以及第三值矩阵;基于所述帧间关系编码器的输出矩阵获取第四查询矩阵、第四键矩阵以及第四值矩阵;

[0063]

s402、任意所述子模态关系编码器包括两条结构相同的编码链路,分别为视觉链路和雷达链路,任意编码链路包括依次连接的cross-attention模块、add&normalize模块、self-attention模块、feed forward模块以及add&normalize模块,所述cross-attention模块用于计算模态间信息的相关性;

[0064]

s403、将第三查询矩阵、第四键矩阵以及第四值矩阵输入视觉链路;

[0065]

s404、将第四查询矩阵、第三键矩阵以及第三值矩阵输入雷达链路;

[0066]

s405、根据cross-attention计算相关性,然后引导模态内值矩阵。

[0067]

具体来说,将获取到的经过帧间关系编码器和速度关系编码器的两个模态特征一同送入到模态关系编码器中,并通过训练自动挖掘模态间特征的相关性,寻找两个模态的特征在时间上的相关性。模态关系编码器包括依次连接的p个相同的子模态关系编码器,模态关系编码器的输出为第p个子模态关系编码器的输出,优选p=5。

[0068]

任意子模态关系编码器均为5层,用于挖掘两模态数据间的关系,第一层是一个cross-attention模块,用于计算模态间信息的相关性,后接self-attention其中attention操作均为12-head attention。其余四层使用与第一层相同的网络架构,来挖掘模态间信息相关性。

[0069]

上述cross-attention用于实现以下计算:

[0070][0071]

or

[0072][0073]

公式对应信息交互过程中cross-attention部分的核心公式,该部分实现了模态内与模态间信息的相关性发掘,实现信息的交互,进而学习到联合表征h。其中qi、ki、vi分别是来自数据xi的查询矩阵、键矩阵、值矩阵。i=1表示雷达模态,i=2表示视频模态。查询矩阵是查询向量的集合,它与键矩阵相乘,得到的数值代表着向量与向量之间的相似度,也就是时刻间的相关性程度,并用它来引导值矩阵vi,通过步骤的不断重复,一步步得到联合表征h。

[0074]

作为本发明较佳的实施方式,该方法还包括:

[0075]

s5、将获取的联合表征输入与所述第一特征提取网络相反的网络结构进行特征重构,从而获取第一重构特征;同时将获取的联合表征输入与所述第二特征提取网络相反的网络结构进行特征重构,从而获取第二重构特征;

[0076]

通过一致性损失在第一提取特征与第一重构特征间形成约束以减少信息损失;同时通过一致性损失在第二提取特征与第二重构特征间形成约束以减少信息损失。

[0077]

特征重构部分与前面所述的信息交互部分构成了主体框架的编-解码结构,该部分使用了与提取特征中提取深层特征部分相反的反卷积神经网络架构,视频支路使用3d反卷积神经网络,卷积核为3,通道数由16变为8。雷达支路则是使用2d反卷积神经网络,卷积核为3,通道数由64变为32。通过上述的网络设计进行双模态信息提取与交互,最终获得动作信息的有效表示。

[0078]

利用上述重构网络生成的特征与两模态中提取的浅层特征之间的关系相互制约,减少信息丢失,提升融合效率。然后通过不断的迭代训练,以此来获取完整的信息表示,用于后续识别任务。

[0079]

对设计好的网络框架进行训练,并将训练得到的模型用于测试集测试,得到不同人或不同场景条件下的动作识别的准确率。

[0080]

本发明整体框架设计思想依赖于深度学习技术,主框架从广义上来说是一个大型的编-解码的结构,主要细分为特征提取,模态间信息交互以及特征重构三部分。利用同一个动作的两种不同的信息,将二者有效融合,这样即满足了整个动作的信息的丰富性,也可以弥补两种技术的不足。另一方面,从多模态融合研究来看,克服了现有融合方式在提取特征之后进行决策级融合,而忽略了模态间信息关系挖掘的弊端,从而提高了特征提取的有效性,促进融合效果,更能体现多模态融合的作用与意义。

[0081]

本发明还公开了一种基于视觉和无线双模态联合感知的动作识别方法,包括以下步骤:

[0082]

基于上述任意一项方法获取动作表示数据;

[0083]

基于所述动作表示数据进行动作识别。

[0084]

最后应说明的是:以上各实施例仅用以说明本发明的技术方案,而非对其限制;尽管参照前述各实施例对本发明进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分或者全部技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本发明各实施例技术方案的范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1