一种基于人工智能机器视觉目标定位的编队控制方法

1.本发明属于机器视觉目标编队控制领域,具体涉及一种基于人工智能机器视觉目标定位的编队控制方法。

背景技术:

2.随着国家基础设施建设水平的快速发展,复杂场景对跟踪定位的要求连续提高,人工智能的跟踪定位技术也随之长足发展。目标定位是人工智能机器视觉的重要组成部分,该技术是指利用视频、图像的逻辑信息,对目标的轨迹和轮廓特征信息进行建模,从而对目标定位进行预测和跟踪。随着人工智能机器深度学习在图像和目标检测中的系统化使用,大量使用在目标定位方法中。但是由于图像清晰度、对比度差、背景复杂度等因素,都不利于图像的高清处理,影响了图像特征的提取精度,提升目标定位的难度。所以在此领域为科研人员提出了如何进一步减低计算成本,提升定位精度和鲁棒性的技术问题。

技术实现要素:

3.本发明的目的是为了提供一种基于人工智能机器视觉目标定位的编队控制方法。

4.本发明的目的是这样实现的:

5.一种基于人工智能机器视觉目标定位的编队控制方法,包括如下步骤:

6.(1)检测待定位目标,采集目标图像,将采集出的目标图像为样板图像,设样板图像帧作为视频序列的第一帧;

7.(2)采用全卷积网络的孪生网络对样板图像和视频序列进行特征提取;

8.(3)通过候选网络的分类支路和回归支路对提取的特征进行分类回归;

9.(4)计算每帧视频序列的定位边界框相似度,根据定位边界框相似度进行排名,通过非极大值抑制得到每帧视频序列最后的定位边界框,如果每一帧视频序列最后的定位边界框的值都大于边界框阈值参数,则判定为定位成功,继续执行步骤(5);如果每一帧视频序列最后的定位边界框的值中至少有一个小于等于定位边界框阈值,则判定为定位不成功,重新执行步骤(3);

10.(5)检测视频序列的编号第g-a帧、第g-a+1帧、

…

、第g帧的视频序列中相邻两帧的定位边界框,判断定位边界框的几何中心点在xy坐标系下的平均位移变化,预测第g+1帧视频序列相对于第g帧视频序列的移动方向,以第g帧视频序列定位边界框的几何中心点坐标为中心进行放大,形成放大到视频序列的图像尺寸的图,第g帧视频序列图像和大后的图的重叠部分,判定为第g+1帧视频序列的图像的目标定位范围。

11.(6)单体根据目标定位范围通过应力约束建立拓扑通信;

12.(7)人工智能系统根据单体参数测算编队泛型整体刚性;

13.(8)人工智能系统通过拓普通信和编队泛型整体刚性建立期望队形并确定控制目标;

14.(9)人工智能系统进行仿射单体集的控制;

15.(10)人工智能系统验证单体集运动稳定性。

16.所述的孪生网络分为样板支路和检测支路,两个支路的权重参数相同;其中样板支路接收样板图像,输入标记为m;检测支路接收检测序列当前帧的图像,输入标记为k;样板图像和检测序列经过孪生网络后得到孪生网络特征输出为样板图像孪生网络特征输出ι(m)和检测序列孪生网络特征输出ι(k)。

17.所述的步骤(3)具体包括如下步骤:

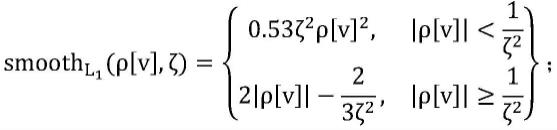

18.(3.1)采用fast-rcnn的损失函数对候选网络进行训练,分类支路的损失函数采用交叉熵损失函数,回归支路的损失函数采用回归损失函数smooth l1 loss;

19.(3.1.1)确认候选网络中锚箱的中心点坐标(n

x

,ny)、宽nw和高nh;

20.(3.1.2)确认实际定位边界框的中心点坐标(g

x

,gy)、高gh和宽gw;

21.(3.1.3)计算锚箱与定位边界框的标准化距离:

[0022][0023][0024][0025][0026]

(3.1.4)构建smooth l1 loss函数:

[0027][0028]

v∈[0,1,2,3];

[0029]

ζ为边界框阈值;

[0030]

(3.1.5)回归支路的损失函数为:

[0031][0032]

(3.2)通过训练后的候选网络的两个卷积层将ι(m)扩展为样板图像孪生网络特征输出分类分支ι(m)

cls

和样板图像孪生网络特征输出回归分支ι(m)

reg

;

[0033]

(3.3)通过训练后的候选网络的两个卷积层将ι(k)扩展为检测序列孪生网络特征输出分类分支ι(k)

cls

和检测序列孪生网络特征输出回归分支ι(k)

reg

;

[0034]

(3.4)确认分类支路的通道向量个数为2x,确认回归支路的通道向量个数为4x;

[0035]

(3.5)对分类支路进行卷积运算,运算结果为:

[0036][0037]

(3.6)对回归支路进行卷积运算,运算结果为:

[0038][0039]

所述步骤(4)具体包括:

[0040]

(4.1)计算当前视频序列最后的定位边界框的高宽比e',以及上一帧视频序列最后的定位边界框的高宽比e",确认当前视频序列最后的定位边界框的面积尺寸f和上一帧视频序列最后的定位边界框的面积尺寸f";

[0041]

f2=(gh+c)(gw+c);

[0042][0043]

(4.2)计算惩罚函数:

[0044][0045]

(4.3)计算分类支路评价值:

[0046][0047]

(4.4)计算定位边界框相似度pscore:

[0048]

pscore=penalty

×

score。

[0049]

所述的步骤(5)包括:

[0050]

以定位边界框的左上角为原点建立xy坐标轴,记录从第g-a帧开始相邻两帧的定位边界框的几何中心点坐标沿x轴方向的位移变化δxg=[δx1,δxa],g∈[1,a],沿y轴方向位移变化分别为δyg=[δy1,δya],g∈[1,a],计算x轴方向和y轴方向的平均位移变化:

[0051]

x轴方向平均位移变化为:

[0052][0053]

y轴方向平均位移变化为:

[0054][0055]

arg指的是复数的辐角主值;

[0056]

当x

p

》0,预测第g+1帧位置是x轴正方向;否则,预测第g+1帧位置是x轴负方向;

[0057]

当x

p

》0,预测第g+1帧位置是y轴正方向;否则,预测第g+1帧位置是y轴负方向;

[0058]

然后以第g帧对应定位边界框的几何中心点坐标为中心向外扩充为第g帧图像大小,第g帧图像和扩充后的图像的重叠部分为第g+1帧目标定位范围

[0059]

(6.1)人工智能系统采集单体标号i以及单体在随体坐标系下的运动方向λi;建立方向矩阵:

[0060][0061]

(6.2)人工智能系统建立单体旋转矩阵:

[0062][0063]

(6.3)人工智能系统采集单体线速度υi、角速度ωi,构建在随体坐标系下的单体速度向量:

[0064]

υi=col(υi,ωi);

[0065]

col代表列向量;

[0066]

(6.4)人工智能系统测量单体在随体坐标系下的位置向量

[0067]ci

=col(xi,yi);

[0068]

为单体坐标;

[0069]

(6.5)构建在大地坐标系下的单体状态向量:

[0070]

τi=col(ci,λi);

[0071]

(6.6)采集单体的惯性矩阵zi,科氏向心力矩阵p(υi),阻力矩阵q(υi),模型参数摄动干扰向量ti,控制指令输入ηi,外界扰动向量η

wi

;

[0072]

(6.7)人工智能系统在智慧城市下构建单体的运动模型:

[0073][0074][0075]

(7.1)采集单体集i={1,2,

……

,a},a为单体总数;为两个单体连成一边的边集;设置每条边的应力为μ

ij

;j代表其他单体编号;

[0076]

(7.2)调取图形库中单体集在行进过程中期望形成的图案c

*

;

[0077]

(7.3)设置平衡状态下的边集应力:

[0078][0079]

(7.4)设置平衡状态下的应力矩阵为:

[0080][0081]

(7.5)设置单体集给定常规构型为e;解算构型的仿射变化集:

[0082][0083]

n为系统旋转、缩放及剪切操作信号,o为平移操作信号,为张量积运算,ia为a维单位矩阵;

[0084]

(7.6)定义关联矩阵:

[0085]

u=[ui]∈rz×a;

[0086]

中z为r中元素的数量;u

t

u=n(e)

[0087]

(7.7)构建边集关系式:

[0088]

[0089]

diag为取对角矩阵函数;为扩展构型;

[0090]

(7.8)计算r的奇异值分解,获取null(r)的正交基h2:建立如下方程:

[0091][0092]

mi是null(r)的解;

[0093]

(7.9)求解线性矩阵不等式得到参数ui:

[0094][0095]

(7.10)求得应力向量:

[0096][0097]

(8.1)构建期望队形(t,c

*

),各单体间的交互拓扑t为t(i,r);

[0098][0099]

是系统队形集中的图案;

[0100]

(8.2)采集队形的期望方向λ

*

;

[0101]

(8.3)从仿射变化集中获取时变队形;

[0102][0103]

为队形分界线的左侧期望队形;为队形分界线的右侧期望队形;

[0104]

(8.4)采集时序t下的期望队形的中心向量:

[0105][0106]

是期望队形中心的坐标;

[0107]

(8.5)计算期望单体集队形的运动方向:

[0108][0109]

atan2指以坐标原点为起点,指向坐标的射线在坐标平面上与x轴正方向之间的角的角度;第i个单体的期望方向为

[0110]

(8.6)根据期望方向计算各单体的常规定位误差:

[0111][0112]

(8.7)计算分布式定位误差为:

[0113][0114]

(8.8)人工智能系统采集第j个单体在i个单体的随体坐标系下的坐标位置ρ

ij

,第j个单体的运行方向在i个单体的随体坐标系下与纵向轴的夹角ζ

ij

;

[0115]

(8.9)采用相对误差作为控制度量:

[0116][0117]

ρ

ij

=e

t

(λi)(c

i-cj),ζ

ij

=λ

i-λj;

[0118]

(9.1)人工智能系统采集单体集的惯性矩阵:

[0119][0120]

j为雅克比矩阵;

[0121]

(9.2)人工智能系统采集单体集的向心力矩阵:

[0122][0123]

(9.3)人工智能系统采集单体集的阻尼矩阵:

[0124][0125]

(9.4)人工智能系统采集单体集的扰动集总:

[0126][0127]

(9.5)人工智能系统推算单体集的欧拉-拉格朗日运动模型为:

[0128][0129]

(9.6)人工智能系统计算单体集分布式滑模面:

[0130][0131]ki

为正向控制增益;

[0132]

(9.7)人工智能系统重构并输出单体集分布式控制器模型:

[0133][0134]

和为两个自适应参数,为自适应参数的向量;

[0135]

自适应参数的更新律为:

[0136][0137]

δi以及εi为正向控制增益。

[0138]

构建稳定性函数:

[0139][0140]

式中,为稳定性分析常数,判断闭环系统的所有信号是否最终一致有界,如一致有界则保持单体集监控,如不一致,则重新执行步骤(6)。

[0141]

本发明的有益效果在于:

[0142]

本方法通过人工智能连续定位迫切需求,同时提出基于相似度的评价机制,以判别继续定位的必要性,根据目标前几帧视频图像轨迹变化,来预测下一帧目标定位范围的预测策略,可以有效地缩小复杂情况下目标定位的范围,减少图像精度、对比度对目标定位造成的错误定位、丢失目标和定位漂移等影响,保证目标定位的鲁棒性。同时本发明控制单体集结合了仿射变换迅速进行缩放、剪切等队形变换,控制系统内的单体需要依赖感知交互和惯性信息在复杂城市环境下实现单体集群控制,有效降低了控制的复杂程度,降低了

人工智能系统的计算量。

附图说明

[0143]

图1是本发明的定位流程图;

[0144]

图2是智慧城市曲折道路目标定位跟踪模拟结果图;

[0145]

图3是期望队形的常规构型及应力分配情况;

[0146]

图4是本发明的智慧城市曲折道路人工模拟控制测试图;

[0147]

图5是单体集内受控单体的控制输出。

具体实施方式

[0148]

下面结合附图对本发明作进一步详细描述。本发明的第一区别特征在于通过候选网络对特征进行分类回归,对定位边界框相似度进行排名,通过前帧图像的趋势变化预判图像的目标定位范围的发明思路,与现有技术相比能够效地缩小复杂情况下目标定位的范围。

[0149]

一种基于人工智能机器视觉目标定位的编队控制方法,包括如下步骤:

[0150]

(1)检测待定位目标,采集目标图像,将采集出的目标图像为样板图像,设样板图像帧作为视频序列的第一帧;

[0151]

(2)采用全卷积网络的孪生网络对样板图像和视频序列进行特征提取;

[0152]

所述的孪生网络分为样板支路和检测支路,两个支路的权重参数相同;其中样板支路接收样板图像,输入标记为m;检测支路接收检测序列当前帧的图像,输入标记为k;样板图像和检测序列经过孪生网络后得到孪生网络特征输出为样板图像孪生网络特征输出ι(m)和检测序列孪生网络特征输出ι(k)。

[0153]

(3)通过候选网络的分类支路和回归支路对提取的特征进行分类回归;

[0154]

(3.1)采用fast-rcnn的损失函数对候选网络进行训练,分类支路的损失函数采用交叉熵损失函数,回归支路的损失函数采用回归损失函数smooth l1 loss;

[0155]

(3.1.1)确认候选网络中锚箱的中心点坐标(n

x

,ny)、宽nw和高nh;

[0156]

(3.1.2)确认实际定位边界框的中心点坐标(g

x

,gy)、高gh和宽gw;

[0157]

(3.1.3)计算锚箱与定位边界框的标准化距离:

[0158][0159][0160][0161][0162]

(3.1.4)构建smooth l1 loss函数:

[0163][0164]

v∈[0,1,2,3];

[0165]

ζ为边界框阈值;

[0166]

(3.1.5)回归支路的损失函数为:

[0167][0168]

(3.2)通过训练后的候选网络的两个卷积层将ι(m)扩展为样板图像孪生网络特征输出分类分支ι(m)

cls

和样板图像孪生网络特征输出回归分支ι(m)

reg

;

[0169]

(3.3)通过训练后的候选网络的两个卷积层将ι(k)扩展为检测序列孪生网络特征输出分类分支ι(k)

cls

和检测序列孪生网络特征输出回归分支ι(k)

reg

;

[0170]

(3.4)确认分类支路的通道向量个数为2x,确认回归支路的通道向量个数为4x;

[0171]

(3.5)对分类支路进行卷积运算,运算结果为:

[0172][0173]

(3.6)对回归支路进行卷积运算,运算结果为:

[0174][0175]

(4)计算每帧视频序列的定位边界框相似度,根据定位边界框相似度进行排名,通过非极大值抑制得到每帧视频序列最后的定位边界框,如果每一帧视频序列最后的定位边界框的值都大于边界框阈值参数,则判定为定位成功,继续执行步骤(5);如果每一帧视频序列最后的定位边界框的值中至少有一个小于等于定位边界框阈值,则判定为定位不成功,重新执行步骤(3);

[0176]

(4.1)计算当前视频序列最后的定位边界框的高宽比e',以及上一帧视频序列最后的定位边界框的高宽比e",确认当前视频序列最后的定位边界框的面积尺寸f和上一帧视频序列最后的定位边界框的面积尺寸f";

[0177]

f2=(gh+c)(gw+c);

[0178][0179]

(4.2)计算惩罚函数:

[0180][0181]

(4.3)计算分类支路评价值:

[0182][0183]

(4.4)计算定位边界框相似度pscore:

[0184]

pscore=penalty

×

score。

[0185]

(5)检测视频序列的编号第g-a帧、第g-a+1帧、

…

、第g帧的视频序列中相邻两帧的定位边界框,判断定位边界框的几何中心点在xy坐标系下的平均位移变化,预测第g+1帧视频序列相对于第g帧视频序列的移动方向,以第g帧视频序列定位边界框的几何中心点坐标为中心进行放大,形成放大到视频序列的图像尺寸的图,第g帧视频序列图像和大后的图的重叠部分,判定为第g+1帧视频序列的图像的目标定位范围;

[0186]

以定位边界框的左上角为原点建立xy坐标轴,记录从第g-a帧开始相邻两帧的定位边界框的几何中心点坐标沿x轴方向的位移变化δxg=[δx1,δxa],g∈[1,a],沿y轴方向位移变化分别为δyg=[δy1,δya],g∈[1,a],计算x轴方向和y轴方向的平均位移变化:

[0187]

x轴方向平均位移变化为:

[0188][0189]

y轴方向平均位移变化为:

[0190][0191]

arg指的是复数的辐角主值;

[0192]

当x

p

》0,预测第g+1帧位置是x轴正方向;否则,预测第g+1帧位置是x轴负方向;

[0193]

当x

p

》0,预测第g+1帧位置是y轴正方向;否则,预测第g+1帧位置是y轴负方向;

[0194]

然后以第g帧对应定位边界框的几何中心点坐标为中心向外扩充为第g帧图像大小,第g帧图像和扩充后的图像的重叠部分为第g+1帧目标定位范围。

[0195]

本发明的第二区别特征在于使用损失函数对候选网络进行训练,通过孪生网络利用分类支路的损失函数和回归支路的损失函数进行输出,并利用其计算定位边界框相似度并进行目标定位范围的确认。与现有技术相比,其能够进一步提高定位精度并避免环境干扰。

[0196]

(6)单体根据目标定位范围通过应力约束建立拓扑通信;

[0197]

(6.1)人工智能系统采集单体标号i以及单体在随体坐标系下的运动方向λi;建立方向矩阵:

[0198][0199]

(6.2)人工智能系统建立单体旋转矩阵:

[0200][0201]

(6.3)人工智能系统采集单体线速度υi、角速度ωi,构建在随体坐标系下的单体速度向量:

[0202]

υi=col(υi,ωi);

[0203]

col代表列向量;

[0204]

(6.4)人工智能系统测量单体在随体坐标系下的位置向量

[0205]ci

=col(xi,yi);

[0206]

(xi,yi)为单体坐标;

[0207]

(6.5)构建在大地坐标系下的单体状态向量:

[0208]

τi=col(ci,λi);

[0209]

(6.6)采集单体的惯性矩阵zi,科氏向心力矩阵p(υi),阻力矩阵q(υi),模型参数摄动干扰向量ti,控制指令输入ηi,外界扰动向量η

wi

;

[0210]

(6.7)人工智能系统在智慧城市下构建单体的运动模型:

[0211][0212][0213]

(7)人工智能系统根据单体参数测算编队泛型整体刚性;

[0214]

(7.1)采集单体集i={1,2,

……

,a},a为单体总数;为两个单体连成一边的边集;设置每条边的应力为μ

ij

;j代表其他单体编号;

[0215]

(7.2)调取图形库中单体集在行进过程中期望形成的图案c

*

;

[0216]

(7.3)设置平衡状态下的边集应力:

[0217][0218]

(7.4)设置平衡状态下的应力矩阵为:

[0219][0220]

(7.5)设置单体集给定常规构型为e;解算构型的仿射变化集:

[0221][0222]

n为系统旋转、缩放及剪切操作信号,o为平移操作信号,为张量积运算,ia为a维单位矩阵;

[0223]

(7.6)定义关联矩阵:

[0224]

u=[ui]∈rz×a;

[0225]

中z为r中元素的数量;u

t

u=n(e)

[0226]

(7.7)构建边集关系式:

[0227][0228]

diag为取对角矩阵函数;为扩展构型;

[0229]

(7.8)计算r的奇异值分解,获取null(r)的正交基h2:建立如下方程:

[0230][0231]

mi是null(r)的解;

[0232]

(7.9)求解线性矩阵不等式得到参数ui:

[0233]

[0234]

(7.10)求得应力向量:

[0235][0236]

本发明的第三区别特征在于通过拓扑通信构建运动模型,通过拓扑通信中引入应力模型能够使本发明控制的单体集进行队形时变,由于考虑应力设计,使本发明的实用性更强。

[0237]

(8)人工智能系统通过拓普通信和编队泛型整体刚性建立期望队形并确定控制目标;

[0238]

(8.1)构建期望队形(t,c

*

),各单体间的交互拓扑t为t(i,r);

[0239][0240]

是系统队形集中的图案;

[0241]

(8.2)采集队形的期望方向λ

*

;

[0242]

(8.3)从仿射变化集中获取时变队形;

[0243][0244]

为队形分界线的左侧期望队形;为队形分界线的右侧期望队形;

[0245]

(8.4)采集时序t下的期望队形的中心向量:

[0246][0247]

是期望队形中心的坐标;

[0248]

(8.5)计算期望单体集队形的运动方向:

[0249][0250]

atan2指以坐标原点为起点,指向坐标的射线在坐标平面上与x轴正方向之间的角的角度;第i个单体的期望方向为

[0251]

(8.6)根据期望方向计算各单体的常规定位误差:

[0252][0253]

(8.7)计算分布式定位误差为:

[0254][0255]

(8.8)人工智能系统采集第j个单体在i个单体的随体坐标系下的坐标位置ρ

ij

,第j个单体的运行方向在i个单体的随体坐标系下与纵向轴的夹角ζ

ij

;

[0256]

(8.9)采用相对误差作为控制度量:

[0257][0258]

ρ

ij

=e

t

(λi)(c

i-cj),ζ

ij

=λ

i-λj;

[0259]

(9)人工智能系统进行仿射单体集的控制;

[0260]

(9.1)人工智能系统采集单体集的惯性矩阵:

[0261][0262]

j为雅克比矩阵;

[0263]

(9.2)人工智能系统采集单体集的向心力矩阵:

[0264][0265]

(9.3)人工智能系统采集单体集的阻尼矩阵:

[0266][0267]

(9.4)人工智能系统采集单体集的扰动集总:

[0268][0269]

(9.5)人工智能系统推算单体集的欧拉-拉格朗日运动模型为:

[0270][0271]

(9.6)人工智能系统计算单体集分布式滑模面:

[0272][0273]ki

为正向控制增益;

[0274]

(9.7)人工智能系统重构并输出单体集分布式控制器模型:

[0275][0276]

和为两个自适应参数,为自适应参数的向量;

[0277]

自适应参数的更新律为:

[0278][0279]

δi以及εi为正向控制增益。

[0280]

本发明的第四区别特征在于通过交互拓扑、仿射变换构建期望队形,将相对角度误差和分布式滑模面以及单体集的扰动集融入队形控制,从而保证控制器能够输出更为合理的信号以使得误差收敛,进一步提高了本发明控制方法的精度。

[0281]

(10)人工智能系统验证单体集运动稳定性。

[0282]

构建稳定性函数:

[0283][0284]

式中,为稳定性分析常数,判断闭环系统的所有信号是否最终一致有界,如一致有界则保持单体集监控,如不一致,则重新执行步骤(6)。

[0285]

本发明的第五区别特征在于通过构建稳定性函数对进行中的发明进行监控,进一步确保本发明方法的稳定性。

[0286]

图2表示智慧城市道路路径以及定位目标的定位结果。以视频序列中每一帧图像的左上角为原点建立坐标轴,以上一帧定位框的中心点,向外扩充为与当前帧的图像大小,两图重叠部分,即为下一帧目标定位的选择范围。本结果进一步表现了本方法在长时连续定位的效果。实验过程中,持续对目标跟踪了300秒,共5700帧图片,其中每秒19帧图片。

[0287]

如图3所示,在曲折通道中,单体集控制使9个单体进行了队形变换,同时进行了避障调整队形通过了狭窄通道。单体集的具体控制如图4所示。

[0288]

综上所述,目前智慧城市的编队控制往往是以分布式架构进行控制器设计,通过传感器进行定位,基于推演图进行的分布式控制仅能实现固定队形的控制定位任务,而实际任务中需要控制对象可以完成时变队形进行避障等复杂大动作,因此本发明提出基于相似度的评价机制,以判别继续定位的必要性,根据目标前几帧视频图像轨迹变化,来预测下一帧目标定位范围的预测策略,以有效地缩小复杂情况下目标定位的范围,减少图像精度、对比度对目标定位造成的错误定位、丢失目标和定位漂移等影响,保证目标定位的鲁棒性,通过通信拓扑引入应力约束同时融合仿射变换技术描述具备时变特点期望队形,同时进行组合变换,避免额外的路径规划,具有显著的技术进步。本发明所提的控制器能够快速的响应跟踪误差,自适应参数的修正是控制器能够快速响应跟踪误差的一个重要原因,从而保证控制器能够输出更为合理的信号以使得误差收敛。此外考虑编队自身的强耦合性,考虑到实际城市环境的复杂性,存在磁场干扰或信号干扰的拒止现象,本发明通过以方位角为定位误差进行滑模控制,使单体仅通过感知交互结合惯性信息即可实现集群控制,有效减少了计算负担。

[0289]

综上,本发明方法与现有技术相比区别明显,具有实质性的技术效果。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1