一种基于注意力量子启发式神经网络的计算机全息图压缩方法

1.本发明提供一种基于注意力量子启发式神经网络的计算机全息图压缩方法,具体涉及计算机全息图的压缩传输技术领域。

技术背景

2.近年来随着科学技术的不断进步,三维(3d)图像显示技术在军用、民用等领域发挥出越来越重要的作用,其中全息显示技术可用于空间三维图像的真3d显示是一种极其重要的立体图像显示方法。但是由于全息图每一点的值皆为衍射波与参考光之间干涉的结果,因此,计算机全息图在制作过程中会产生大量冗余信息,这给全息信息的快速传输以及三维图像的实时立体显示带来了极大的困难,因此,有必要对计算机全息图像的进行压缩编码处理研究。

3.本发明旨在寻找一种更好的神经网络来对计算机全息图进行压缩。近年来,得益于深度学习在计算机视觉[2-3],自然语言处理,全息图像[4-5]等领域的高速发展,目前卷积神经网络已经广泛应用于普通图像的有损压缩[6],并得到了超过jpeg和bpg等传统图像压缩算法的性能。同时已经有一些探索中的工作在尝试着使用卷积神经网络来对计算机全息图进行压缩[7],但是,这些针对计算机全息图像压缩的解决方案只是简单的把应用在普通图像的方法迁移到了计算机全息图上,并没有根据全息图像的性质来进行针对性的优化.此外,近年来,量子计算由于拥有强大的存储能力及快速并列运行计算能力,越来越受到研究者们的青睐,一些学者尝试着使用量子神经网络[8]来对计算机全息图进行压缩,但是过去的这些工作由于受到传统计算机算力的限制,依然只能使用三层量子神经网络模型来对图像进行处理,并没有充分发挥神经网络的优势,因此量子神经网络在计算机全息图的压缩上还有极大的探索空间

技术实现要素:

[0004]

本发明提出了一种基于注意力量子启发式神经网络的计算机全息图压缩方案,可以有效对计算机全息图进行压缩。

[0005]

本发明的原理是:基于计算机全息图(cgh)的生成原理,全息图每一点的值皆为衍射波与参考光之间干涉的结果,涵盖了物体全局信息。基于以上观察,本发明提出了一种空间注意力机制去提取计算机全息图的长距离上下文信息(long-range contextual information)。该长距离上下文信息(long-range contextual information)可以看成是计算机全息图每个像素之间相关关系的一种显性表征形式,它可以帮助网络更好的去利用计算机全息图每个像素之间的相关信息去对压缩后图像进行重建。具体来说,本发明所提出的空间注意力机制可以计算输入特征图中任意两个位置之间的相关性,然后网络可以通过该相关性得到输入特征图中所有特征的全局响应并以此去增强相关像素之间有用的信息,滤除那些无用的信息,从而更好的对压缩后计算机全息图进行恢复。

[0006]

本发明提供的技术方案是:

[0007]

一种基于注意力量子启发式神经网络的计算机全息图压缩方法,具体步骤如下:

[0008]

步骤1)采用菲涅尔离轴全息计算方法,将原始图像制作为计算机全息图;包括如下步骤:

[0009]

11)菲涅耳衍射(fresnel diffraction):使用菲涅耳衍射积分来计算光波在近场区域的衍射传播。设原始物波平面上光源为u0(x0,y0),则菲涅耳衍射的计算公式如下:

[0010][0011]

其中k是波数,j是虚数单位,(x0,y0)是原始物波平面,(x,y)是对应的衍射平面;u0(x0,y0)是原始物体的信息,u(x,y)是物光波前的复振幅函数,z表示衍射距离。

[0012]

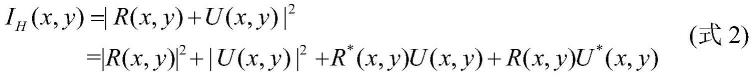

12)离轴参考光干涉:全息图再现时,再现像、零级衍射亮斑以及李生像会发生相互叠加的现像,因此本发明在全息图记录时采用了与物光波前存在一定夹角的参考光以分离不同级的衍射像,具体公式如下:

[0013][0014]

其中ih(x,y)是全息图记录的光强,r(x,y)是参考波的波前函数,u(x,y)是原始图像的波前函数。r

*

(x,y)和u

*

(x,y)分别对应u(x,y)和r(x,y)的共轭项。

[0015]

步骤2)使用基于注意力机制的量子启发式神经网络对计算机全息图进行压缩和解压缩,包括如下步骤:

[0016]

21)使用jpeg压缩标准作为编码器,对输入计算机全息图进行压缩,具体公式如下:

[0017]

ic=j(ih)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(式3)

[0018]

其中ih表示输入的计算全息图,j表示jpeg压缩标准,ic表示压缩后的计算机全息图。

[0019]

22)使用量子启发式神经网络(qnn模块)提取压缩后计算机全息图的特征,具体公式如下:

[0020]

a=δ(ic)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(式4)

[0021]

其中ic指压缩后的计算全息图,δ指的是包含一个隐藏层的量子启发式神经网络,a指由量子启发式神经网络提取出来的特征图

[0022]

23)使用两个注意力模块提取输入特征图的全局特征,并利用它去增强相关像素之间有用的信息,滤除那些无用的信息,从而更好的对压缩后计算机全息图进行恢复,具体公式如下:

[0023]

c=σ2(σ1(a))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(式5)

[0024]

其中σ表示注意力模块,a表示输入特征图,c表示经由注意力模块增强后的特征图。

[0025]

具体来说本发明提出的注意力模块由以下几步构成:

[0026]

231)使用量子启发式神经网络对输入的形如a∈rb×n的特征图进行特征提取,并对得到的新特征图进行维度变换(reshape),具体公式如下:

[0027][0028]

其中δi表示单层的量子启发式神经网络。新得到的三个特征图kr,qr,vr它们的维度分别为kr∈rb×1×n,qr∈rb×n×1,vr∈rb×1×n。

[0029]

232)对qr和kr进行矩阵乘法,并通过softmax函数得到空间注意力图s∈rb×n×n。具体公式如下:

[0030][0031]

其中n表示的输入特征图特征通道的数量。s

ji

表示的是输入特征图第i个特征和第j个特征之间的相似性。

[0032]

233)把空间注意力图s和vr相乘得到经过空间注意力机制增强后的特征图b∈rb×n,具体公式如下:

[0033][0034]

其中α表示的是一个超参数,它一开始初始化为0,随着网络的反向传播,它会慢慢学习到一个合适的权重。

[0035]

234)使用量子启发式神经网络对经过空间注意力机制增强后的特征图b∈rb×n做进一步的正则,并得到最终的输出,具体公式如下:

[0036]

c=δ(b)+b

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(式9)

[0037]

其中ζ表示的是包含一个隐藏层的量子启发式神经网络。

[0038]

24)对使用注意力模块增强后的特征图进行测量操作得到解压后的计算机全息图,具体公式如下:

[0039]irecover

=|im(c)|2ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(式10)

[0040]irecover

表示解压后的计算机全息图,im指复数的虚部。

[0041]

步骤3)采用菲涅尔离轴全息图再现方法,将压缩后图像重建成再现像,包括如下步骤:

[0042]

步骤3)和步骤1)类似也由离轴参考光照射和菲涅耳衍射两部分构成,其中菲涅尔衍射过程与步骤(1)中所描述的完全一致,使用菲涅耳衍射积分来计算光波在近场区域的衍射传播。设原始物波平面上光源为u0(x0,y0),则菲涅耳衍射的计算公式如下:

[0043][0044]

其中k是波数,j是虚数单位,(x0,y0)是原始物波平面,(x,y)是对应的衍射平面;u0(x0,y0)是原始物体的信息,u(x,y)是物光波前的复振幅函数,z表示衍射距离;

[0045]

离轴参考光照射部分,本发明使用了和参考光一致的再现光r(x,y)照射在解压缩后的全息图i

recover

(x,y)上实现再现,具体公式如下:

[0046]irecover

(x,y)

×

r(x,y)=(|r(x,y)|2+|u(x,y)|2)r(x,y)+r2(x,y)u

*

(x,y)+|r(x,y)|2u(x,y)(式11)

[0047]

其中r(x,y)是再现光,它有和参考光一样的波前函数。i

recover

(x,y)是解压缩后的全息图的记录光强,u(x,y)是原始图像的波前再现函数,u

*

(x,y)是共轭项。

[0048]

总的来说,本发明首先采用菲涅尔离轴全息计算方法,将原始图像制作为计算机全息图,其次使用基于注意力机制的量子启发式神经网络对计算机全息图进行压缩和解压缩,最后采用菲涅尔离轴全息图再现方法,将压缩后图像重建成再现像。本发明通过将步骤2)中生成的解压缩后的计算机全息图以及步骤3)中重建像与原图进行比较来验证通过注意力量子启发式神经网络来对计算机全息图进行压缩的可行性与有效性。具体来说,本发明提供一种基于注意力量子启发式神经网络的计算机全息图压缩方法。该方法可以通过基于量子比特神经元模型的空间注意力机制去计算输入特征图中任意两个位置之间的相关性,然后网络可以通过该相关性去增强相关像素之间有用的信息,滤除那些无用的信息,从而更好的对压缩后计算机全息图进行恢复。

[0049]

与现有技术相比,本发明的有益效果是:

[0050]

(一)提出一种基于量子比特神经元模型的空间注意力机制,该空间注意力机制可以通过计算输入特征图中任意两个位置之间的相关性,去增强相关像素之间有用的信息,滤除那些无用的信息

[0051]

(二)提出一种基于注意力机制的量子启发式神经网络,相比于经典的量子启发式神经网络,本发明通过将空间注意力机制融入量子启发式神经网络,可以更好的抓取输入图像的全局信息,从而提高重建图像的质量。

[0052]

(三)综上所述,本发明提出的基于注意力机制的量子启发式神经网络(aqinn)可以有效提升计算机全息图像的重建质量。和只使用量子神经网络进行计算机全息图压缩的方法(qbpnn)相比,本发明再现图像质量的提升是显著的。

附图说明

[0053]

图1为基于注意力量子启发式神经网络的计算机全息图压缩方法的流程框图;

[0054]

图2为基于量子比特神经元模型的空间注意力机制原理图;

[0055]

图3为菲涅耳离轴计算机全息图的记录和再现仿真实验结果示意图;

[0056]

图4为qbpnn和aqinn在不同数据集上再现图像质量变化的比较图

[0057]

图5为aqinn和qbpnn再现结果对比图,其中(a)是输入原始图像;(b)是通过qbpnn解压缩后得到的计算机全息图;(c)是图b对应再现像;(d)是通过aqinn进行解压缩后的计算机全息图;(e)是图d对应再现像

具体实施方式

[0058]

下面结合附图,通过实施实例进一步描述本发明,但不以任何方式限制本发明的范围。

[0059]

本发明提出的基于注意力量子启发式神经网络的计算机全息图压缩方法流程框

图如附图1所示。在本发明实施实例中,本发明提供方法具体包括如下步骤:

[0060]

1)利用菲涅尔离轴全息计算方法制作计算机全息图;

[0061]

菲涅耳离轴全息图的记录过程包括了菲涅耳衍射和离轴参考光干涉两个部分。

[0062]

菲涅耳衍射(fresnel diffraction):使用菲涅耳衍射积分来计算光波在近场区域的衍射传播。设原始物波平面上光源为u0(x0,y0),则菲涅耳衍射的计算公式如下:

[0063][0064]

其中k是波数,j是虚数单位,(x0,y0)是原始物波平面,(x,y)是对应的衍射平面;u0(x0,y0)是原始物体的信息,u(x,y)是物光波前的复振幅函数,z表示衍射距离。

[0065]

离轴参考光干涉是指,全息图再现时,再现像、零级衍射亮斑以及李生像会发生相互叠加的现像,因此本发明在全息图记录时采用了与物光波前存在一定夹角的参考光以分离不同级的衍射像,具体公式如下:

[0066][0067]

其中ih(x,y)是全息图记录的光强,r(x,y)是参考波的波前函数,u(x,y)是原始图像的波前函数。r

*

(x,y)和u

*

(x,y)分别对应u(x,y)和r(x,y)的共轭项。如图3所示,本发明展示了菲涅耳离轴计算机全息图的记录和再现仿真实验结果,具体的实验参数见表1。

[0068]

表1计算机制作全息图相关参数设置

[0069][0070]

2)使用基于注意力机制的量子启发式神经网络对计算机全息图进行压缩和解压缩

[0071]

本发明提出了一种基于注意力机制的量子启发式神经网络来对计算机全息图进行压缩和解压缩,具体来说对于一副输入的计算机全息图,本发明首先使用jpeg压缩标准作为编码器,对输入计算机全息图进行压缩,然后使用量子启发式神经网络(qnn模块)提取压缩后计算机全息图的特征,最后使用注意力模块提取输入特征图的全局特征,并利用它去增强相关像素之间有用的信息,滤除那些无用的信息,从而更好的对压缩后计算机全息图进行恢复。如图1所示,本发明所提出的基于注意力机制的量子启发式神经网络具体来说由以下四个步骤构成:

[0072]

1)使用jpeg压缩标准作为编码器,对输入计算机全息图进行压缩,具体公式如下:

[0073]

ic=j(ih)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(式3)

[0074]

其中ih表示输入的计算全息图,j表示jpeg压缩标准,ic表示压缩后的计算机全息图。

[0075]

2)使用量子启发式神经网络(qnn模块)提取压缩后计算机全息图的特征,具体公式如下:

[0076]

a=δ(ic)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(式4)

[0077]

其中ic指压缩后的计算全息图,δ指的是包含一个隐藏层的量子启发式神经网络,a指由量子启发式神经网络提取出来的特征图

[0078]

3)使用两个注意力模块提取输入特征图的全局特征,并利用它去增强相关像素之间有用的信息,滤除那些无用的信息,从而更好的对压缩后计算机全息图进行恢复,具体公式如下:

[0079]

c=σ2(σ1(a))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(式5)

[0080]

其中σ表示注意力模块,a表示输入特征图,c表示经由注意力模块增强后的特征图。

[0081]

4)对使用注意力模块增强后的特征图进行测量操作得到解压后的计算机全息图,具体公式如下:

[0082]irecover

=|im(c)|2ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(式10)

[0083]irecover

表示解压后的计算机全息图,im指复数的虚部

[0084]

接下来将详细介绍本发明所使用的量子启发式神经网络以及空间注意力机制。

[0085]

量子启发式神经网络:量子计算中一般使用量子比特来存储量子信息,与经典比特在任意时刻只能处在某一个状态不同,量子比特处于本征态|1)与|0)的相干叠加态上:

[0086]

|ψ》=α|0》+β|1》

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(式12)

[0087]

|α|2+|β|2=1

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(式13)

[0088]

其中α和β为复常数,表示量子态的概率幅,满足α2+β2=1。当量子态被观测时, 会以||α||2的概率坍缩至|1》,或以||β||2的概率坍缩至|1》。为了计算方便应用,使用虚数来表示量子态:

[0089]

f(θ)=e

iθ

=cosθ+isinθ

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(式14)

[0090]

其中θ为量子态的相位。将|0》的概率幅对应到复数实部,将|1》的概率幅对应到复数虚部。 由此可以得到量子比特神经元的定义:

[0091]

x=f(y)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(式15)

[0092]

其中

[0093][0094]

这里面arg(u)表示的是复数u的相位,l表示的是输入神经元的个数。θ

l

和λ分别表示该量子比特神经元的相移门相位的权值参数和阈值参数。此外g(ξ)表示的是sigmoid激活函数,具体的表达式如下:

[0095][0096]

由此得到了单层量子启发式神经网络的构建方法

[0097]

基于量子比特神经元模型的空间注意力机制:根据计算机全息图(cgh)的生成原理可知,全息图每一点的值皆为衍射波与参考光之间干涉的结果,涵盖了物体全局信息。因此尝试去提取计算机全息图的长距离上下文信息(long-range contextual information)非常重要,这可以帮助本发明更好的去利用计算机全息图每个像素之间的相关信息去对压

缩后图像进行重建。启发于在卷积神经网络上广泛使用的非局部网络[9],本发明提出了一种空间注意力机制来捕获这种长距离上下文信息(long-range contextual information)。具体来说,本发明所提出的空间注意力机制可以计算输入特征图中任意两个特征之间的相关性,并以此得到输入特征图中所有特征的全局响应。下面将对本发明提出的空间注意力机制的原理进行具体的介绍:

[0098]

如图2所示,本发明所提出的空间注意力机制的输入是形如a∈rb×n的特征图。其中b表示的是批尺寸(batchsize),n表示的是输入特征图特征通道的数量。针对形如a∈rb×n的输入,首先使用三层量子启发式神经网络分别对a进行处理得到三个新的特征图。其次,为了方便后续的处理,分别将得到三个特征图的形状进行重塑(reshape),得到形如kr∈rb×1×n,qr∈rb×n×1,vr∈rb×1×n的三个新特征图,具体公式如下:

[0099][0100]

其中δi表示一层量子启发式神经网络。在得到了qr和kr之后,本发明可以使用矩阵乘法来计算原输入特征图任意两个位置之间的相似度,从而得到空间注意力图s∈rb×n×n。具体公式如下:

[0101][0102]

其中n表示的输入特征图特征通道的数量。s

ji

表示的是输入特征图第i个特征和第j个特征之间的相似性。在得到空间注意力图s∈rb×n×n以后,可以把空间注意力图s和vr相乘得到经过空间注意力机制增强后的特征图b∈rb×n,具体公式如下:

[0103][0104]

其中α表示的是一个超参数,它一开始初始化为0,随着网络的反向传播,它会慢慢学习到一个合适的权重。最后本发明使用三层级联的量子启发式神经网络对经过空间注意力机制增强后的特征图b∈rb×n做进一步的正则,并得到最终的输出:

[0105]

c=δ(b)+b

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(式9)

[0106]

其中ζ表示的是三层级联的量子启发式神经网络。从上述公式可以看出,最终输出特征图c在每个特征通道的响应都是通过输入特征图a所有特征通道加权求和的结果。也就是说,得到的空间注意力图s可以捕获图像之间的长距离上下文信息(long-range contextual information)。因此本发明可以通过该空间注意力机制去增强相关像素之间有用的信息,滤除那些无用的特征,从而更好的对压缩后计算机全息图进行恢复。

[0107]

网络训练使用数据集:本发明使用的训练集是由srcnn提供的包含91张图片的小数据集[10],测试集是在图像压缩领域广泛使用的set5[11],set14[12],live1[13]和classic5[14],以下将依次进行一个介绍。

[0108]

91-image dataset:91-image dataset一共包含91张不同分辨率的彩色图片,对于这91张图片,本发明首先使用菲涅尔计算机全息图的记录方法生成对应的分辨率为256*256的计算机全息图,然后将生成的计算机全息图按照32*32的大小切割成训练所需的输入图像。

[0109]

set 5,set14,classic5和live1:set5,set14,classic5和live1是在图像压缩领域广泛使用的数据集,本发明用它来测试基于注意力机制的量子启发式神经网络(aqinn)的压缩性能。对于这四个数据集中所有图片本发明同样使用菲涅尔计算机全息图的记录方法生成对应的分辨率为256*256的计算机全息图。

[0110]

实现细节介绍:本发明使用pytorch来实现提出的网络并使用adam优化算法来端到端的训练整个网络。在训练过程中batch size被设置成了8并使用了l2损失函数来训练整个网络。网络总共会被训练100代,初始学习率是0.02,在迭代30,60以及90次以后会分别降到0.004和0.0008。由于硬件资源的限制,在训练过程中,输入图片会被裁剪到32*32的大小。使用的输入图片和真值都是由菲涅尔离轴全息原理生成的对应计算机全息图。

[0111]

3)利用菲涅尔离轴全息图再现方法,将压缩后图像重建成再现像;

[0112]

在通过步骤(1)所述方法生成菲涅耳离轴全息图之后,可以利用菲涅尔离轴全息图再现方法,将压缩后图像重建成再现像,该过程同样由离轴参考光照射和菲涅耳衍射两步组成。

[0113]

离轴参考光照射部分,本发明使用了和参考光一致的再现光r(x,y)照射在解压缩后的全息图i

recover

(x,y)上实现再现,具体公式如下:

[0114]irecover

(x,y)

×

r(x,y)=(|r(x,y)|2+|u(x,y)|2)r(x,y)+r2(x,y)u

*

(x,y)+|r(x,y)|2u(x,y)

ꢀꢀ

(式11)

[0115]

其中r(x,y)是再现光,它有和参考光一样的波前函数。i

recover

(x,y)是解压缩后的全息图的记录光强,u(x,y)是原始图像的波前再现函数,u

*

(x,y)是共轭项

[0116]

菲涅尔衍射:全息图的再现过程中的菲涅尔衍射过程和(1)所描述的完全一致,通过菲涅尔衍射可以在衍射平面上得到原始物体的再现像。

[0117]

4)实验结果;

[0118]

表1在不同数据集下,通过aqinn和qbpnn解压缩的计算机全息图的质量比较结果

[0119][0120]

如表1所示,实验表明,本发明提出的基于注意力机制的量子启发式神经网络(aqinn)在多个数据集上都可以有效提升计算机全息图像的重建质量。和只使用量子启发式神经网络进行计算机全息图压缩的方法qbpnn[8]相比,本发明的提升是显著的,可视化结果见图4和图5。

[0121]

需要注意的是,公布实施例的目的在于帮助进一步理解本发明,但是本领域的技

engineering,2019,58(5):053105.

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1