基于多重校验机制的智能支付设备及其支付方法与流程

1.本发明涉及智能支付的领域,且更为具体地,涉及一种基于多重校验机制的智能支付设备及其支付方法。

背景技术:

2.公共交通,尤其是地铁作为现在交通事业中的重要组成部分,在解决道路拥挤问题与提高通行效率方面起到关键性作用,但乘车支付的形式及支付速度成为一个备受关注的问题。支付的快慢与便捷不仅影响上车时间还决定着乘客的乘车体验,更决定着人们出行效率,对道路通行能力也会带来一定的影响。

3.目前乘坐公交的支付方式大多是现金、刷卡、扫码支付,而在乘坐过程中往往会出现一些不确定因素,如忘带公交卡、手机欠费、手机关机、扫码时的识别错误等,这些都会给我们的出行带来不便以至于无法支付,导致不能乘车的尴尬局面。

4.因此,期待一种用于公共交通领域的智能支付设备,其能够以无感支付的方式来进行运作以提高人们乘车出行的支付效率,让出行更加方便。

技术实现要素:

5.为了解决上述技术问题,提出了本技术。本技术的实施例提供了一种基于多重校验机制的智能支付设备及其支付方法,其通过深度神经网络模型来从待校验对象的人脸图像和眼球区域图像中挖掘深层的局部隐含关联特征信息,以结合人脸识别和虹膜识别来提高支付的安全性和准确性,并且在此过程中,为了提高融合的效果以提高分类的准确性,进一步使用基于自注意力的数据密集簇机制对虹膜特征图进行加权,这样可以通过所述虹膜特征图内的数据密集簇的自适应依赖来提升融合后的特征图对于分类目标函数的参数自适应变化性以提高分类准确性,这样提高支付的安全性和便利性。

6.根据本技术的一个方面,提供了一种基于多重校验机制的智能支付设备,其包括:人脸采集模块,用于获取由智能支付设备的摄像头采集的待校验对象的人脸图像;人脸检测模块,用于将所述待校验对象的人脸图像通过作为人脸区域检测网络的第一卷积神经网络模型以得到人脸特征图;眼球区域提取模块,用于基于眼球在所述人脸图像中的位置,从所述人脸特征图提取对应于所述眼球的眼球区域特征图;眼球区域像素增强模块,用于将所述眼球区域特征图通过作为像素增强器的生成器模型以得到生成眼球区域图像;虹膜特征提取模块,用于将所述生成眼球区域图像通过具有显著性检测模块的第二卷积神经网络模型以得到虹膜特征图;特征分布校正模块,用于基于所述人脸特征图,使用基于自注意力的数据密集簇机制对所述虹膜特征图进行加权以得到加权后虹膜特征图,其中,所述使用基于自注意力

的数据密集簇机制对虹膜特征图进行加权基于所述人脸特征图和所述虹膜特征图之间的按位置点乘所得到的空间交互特征图,以及,所述人脸特征图和所述虹膜特征图之间的距离来进行;特征分布融合模块,用于融合所述加权后虹膜特征图和所述人脸特征图以得到分类特征图;校验结果生成模块,用于将所述分类特征图通过分类器以得到分类结果,所述分类结果为待检验对象对应于数据库中的对象标签;以及支付模块,用于基于所述对象标签所关联的支付账户中的金额,支付乘车所需的费用。

7.在上述基于多重校验机制的智能支付设备中,所述第一卷积神经网络模型为fast r-cnn、faster r-cnn或retinanet。

8.在上述基于多重校验机制的智能支付设备中,所述虹膜特征提取模块,进一步用于以所述第二卷积神经网络的各层对输入数据进行如下方式的编码:以所述第二卷积神经网络的各层的第一卷积单元以第一卷积核对所述输入数据进行卷积编码以得到卷积特征图;以所述第二卷积神经网络的各层的第二卷积单元以第二卷积核对所述卷积特征图进行卷机编码以得到再卷积特征图,其中,所述第一卷积单元和所述第二卷积单元形成所述显著性特征检测模块,所述第一卷积核的尺寸大于所述第二卷积核的尺寸;以所述第二卷积神经网络的各层的池化单元对所述再卷积特征图进行基于局部特征矩阵的均值池化以得到池化特征图;以及,以所述第二卷积神经网络的各层的激活单元对所述池化特征图中各个位置的特征值进行非线性激活以得到激活特征图;其中,所述第二卷积神经网络的最后一层的输出为所述虹膜特征图。

9.在上述基于多重校验机制的智能支付设备中,所述特征分布校正模块,包括:空间交互特征图生成单元,用于计算所述人脸特征图和所述虹膜特征图之间的按位置点乘以得到所述空间交互特征图;数据差异性度量单元,用于计算所述所述人脸特征图和所述虹膜特征图之间欧式距离的平方根;注意力单元,用于以所述空间交互特征图中各个位置的特征值分别除以所述所述人脸特征图和所述虹膜特征图之间欧式距离的平方根以得到注意力特征图;指数运算单元,用于计算以所述注意力特征图中各个位置的特征值为幂的自然指数函数值以得到指数注意力特征图;第一类概率单元,用于将所述指数注意力特征图通过所述分类器以得到第一类概率指数;第二类概率单元,用于将所述虹膜特征图通过所述分类器以得到第二类概率指数;作用单元,用于计算所述第一类概率指数和所述第二类概率指数之间的乘积作为所述虹膜特征图的加权系数;以及,校正单元,用于以所述加权系数对所述虹膜特征图进行加权以得到所述加权后虹膜特征图。

10.在上述基于多重校验机制的智能支付设备中,所述特征分布校正模块,进一步用于以如下公式使用基于自注意力的数据密集簇机制对所述虹膜特征图进行加权以得到所述加权后虹膜特征图;其中,所述公式为:

其中f

face

表示所述人脸特征图,f

iris

表示所述虹膜特征图,表示点乘,softmax(

·

)表示特征图通过分类器得到的概率值,d(

·

,

·

)表示特征图之间的距离,exp(

·

)表示特征图的指数运算,所述特征图的指数运算表示计算以特征图中各个位置的特征值为幂的自然指数函数值,特征图除以参数表示以特征图中各个位置的特征值分别除以参数。

11.在上述基于多重校验机制的智能支付设备中,所述特征分布融合模块,进一步用于:以如下公式融合所述加权后虹膜特征图和所述人脸特征图以得到所述分类特征图;其中,所述公式为:f=αwf

iris

+βf

face

其中,f为所述分类特征图,f

iris

为所述虹膜特征图,f

face

为所述人脸特征图,wf

iris

表示所述加权后虹膜特征图,“+”表示所述加权后虹膜特征图和所述人脸特征图相对应位置处的元素相加,α和β为用于控制所述加权后虹膜特征图和所述人脸特征图之间的平衡的加权参数。

12.在上述基于多重校验机制的智能支付设备中,所述校验结果生成模块,进一步用于:所述分类器以如下公式对所述分类特征图进行处理以生成分类结果,其中,所述公式为:softmax{(wn, bn):...:(w1, b1)|project(f)},其中project(f)表示将所述分类特征图投影为向量,w1至wn为各层全连接层的权重矩阵,b1至bn表示各层全连接层的偏置矩阵。

13.在上述基于多重校验机制的智能支付设备中,所述支付模块,进一步用于响应于所述对象标签所关联的支付账户中的金额小于所述乘车所需的费用,生成费用不足提示。

14.根据本技术的另一方面,一种基于多重校验机制的智能支付设备的支付方法,其包括:获取由智能支付设备的摄像头采集的待校验对象的人脸图像;将所述待校验对象的人脸图像通过作为人脸区域检测网络的第一卷积神经网络模型以得到人脸特征图;基于眼球在所述人脸图像中的位置,从所述人脸特征图提取对应于所述眼球的眼球区域特征图;将所述眼球区域特征图通过作为像素增强器的生成器模型以得到生成眼球区域图像;将所述生成眼球区域图像通过具有显著性检测模块的第二卷积神经网络模型以得到虹膜特征图;基于所述人脸特征图,使用基于自注意力的数据密集簇机制对所述虹膜特征图进行加权以得到加权后虹膜特征图,其中,所述使用基于自注意力的数据密集簇机制对虹膜特征图进行加权基于所述人脸特征图和所述虹膜特征图之间的按位置点乘所得到的空间交互特征图,以及,所述人脸特征图和所述虹膜特征图之间的距离来进行;融合所述加权后虹膜特征图和所述人脸特征图以得到分类特征图;

将所述分类特征图通过分类器以得到分类结果,所述分类结果为待检验对象对应于数据库中的对象标签;以及基于所述对象标签所关联的支付账户中的金额,支付乘车所需的费用。

15.在上述基于多重校验机制的智能支付设备的支付方法中,所述第一卷积神经网络模型为fast r-cnn、faster r-cnn或retinanet。

16.在上述基于多重校验机制的智能支付设备的支付方法中,将所述生成眼球区域图像通过具有显著性检测模块的第二卷积神经网络模型以得到虹膜特征图,包括:以所述第二卷积神经网络的各层对输入数据进行如下方式的编码:以所述第二卷积神经网络的各层的第一卷积单元以第一卷积核对所述输入数据进行卷积编码以得到卷积特征图;以所述第二卷积神经网络的各层的第二卷积单元以第二卷积核对所述卷积特征图进行卷机编码以得到再卷积特征图,其中,所述第一卷积单元和所述第二卷积单元形成所述显著性特征检测模块,所述第一卷积核的尺寸大于所述第二卷积核的尺寸;以所述第二卷积神经网络的各层的池化单元对所述再卷积特征图进行基于局部特征矩阵的均值池化以得到池化特征图;以及,以所述第二卷积神经网络的各层的激活单元对所述池化特征图中各个位置的特征值进行非线性激活以得到激活特征图;其中,所述第二卷积神经网络的最后一层的输出为所述虹膜特征图。

17.在上述基于多重校验机制的智能支付设备的支付方法中,基于所述人脸特征图,使用基于自注意力的数据密集簇机制对所述虹膜特征图进行加权以得到加权后虹膜特征图,包括:计算所述人脸特征图和所述虹膜特征图之间的按位置点乘以得到所述空间交互特征图;计算所述所述人脸特征图和所述虹膜特征图之间欧式距离的平方根;以所述空间交互特征图中各个位置的特征值分别除以所述所述人脸特征图和所述虹膜特征图之间欧式距离的平方根以得到注意力特征图;计算以所述注意力特征图中各个位置的特征值为幂的自然指数函数值以得到指数注意力特征图;将所述指数注意力特征图通过所述分类器以得到第一类概率指数;将所述虹膜特征图通过所述分类器以得到第二类概率指数;计算所述第一类概率指数和所述第二类概率指数之间的乘积作为所述虹膜特征图的加权系数;以及,以所述加权系数对所述虹膜特征图进行加权以得到所述加权后虹膜特征图。

18.在上述基于多重校验机制的智能支付设备的支付方法中,基于所述人脸特征图,使用基于自注意力的数据密集簇机制对所述虹膜特征图进行加权以得到加权后虹膜特征图,包括:以如下公式使用基于自注意力的数据密集簇机制对所述虹膜特征图进行加权以得到所述加权后虹膜特征图;其中,所述公式为:其中f

face

表示所述人脸特征图,f

iris

表示所述虹膜特征图,表示点乘,softmax(

·

)表示特征图通过分类器得到的概率值,d(

·

,

·

)表示特征图之间的距离,exp(

·

)表示特征图的指数运算,所述特征图的指数运算表示计算以特征图中各个位置的特征值为幂的

自然指数函数值,特征图除以参数表示以特征图中各个位置的特征值分别除以参数。

19.在上述基于多重校验机制的智能支付设备的支付方法中,融合所述加权后虹膜特征图和所述人脸特征图以得到分类特征图,包括:以如下公式融合所述加权后虹膜特征图和所述人脸特征图以得到所述分类特征图;其中,所述公式为:f=αwf

iris

+βf

face

其中,f为所述分类特征图,f

iris

为所述虹膜特征图,f

face

为所述人脸特征图,wf

iris

表示所述加权后虹膜特征图,“+”表示所述加权后虹膜特征图和所述人脸特征图相对应位置处的元素相加,α和β为用于控制所述加权后虹膜特征图和所述人脸特征图之间的平衡的加权参数。

20.在上述基于多重校验机制的智能支付设备的支付方法中,将所述分类特征图通过分类器以得到分类结果,包括:所述分类器以如下公式对所述分类特征图进行处理以生成分类结果;其中,所述公式为:softmax{(wn, bn):...:(w1, b1)|project(f)},其中project(f)表示将所述分类特征图投影为向量,w1至wn为各层全连接层的权重矩阵,b1至bn表示各层全连接层的偏置矩阵。

21.在上述基于多重校验机制的智能支付设备的支付方法中,基于所述对象标签所关联的支付账户中的金额,支付乘车所需的费用,包括:响应于所述对象标签所关联的支付账户中的金额小于所述乘车所需的费用,生成费用不足提示。

22.与现有技术相比,本技术提供的基于多重校验机制的智能支付设备及其支付方法,其通过深度神经网络模型来从待校验对象的人脸图像和眼球区域图像中挖掘深层的局部隐含关联特征信息,以结合人脸识别和虹膜识别来提高支付的安全性和准确性,并且在此过程中,为了提高融合的效果以提高分类的准确性,进一步使用基于自注意力的数据密集簇机制对虹膜特征图进行加权,这样可以通过所述虹膜特征图内的数据密集簇的自适应依赖来提升融合后的特征图对于分类目标函数的参数自适应变化性以提高分类准确性,这样提高支付的安全性和便利性。

附图说明

23.通过结合附图对本技术实施例进行更详细的描述,本技术的上述以及其他目的、特征和优势将变得更加明显。附图用来提供对本技术实施例的进一步理解,并且构成说明书的一部分,与本技术实施例一起用于解释本技术,并不构成对本技术的限制。在附图中,相同的参考标号通常代表相同部件或步骤。

24.图1为根据本技术实施例的基于多重校验机制的智能支付设备的应用场景图。

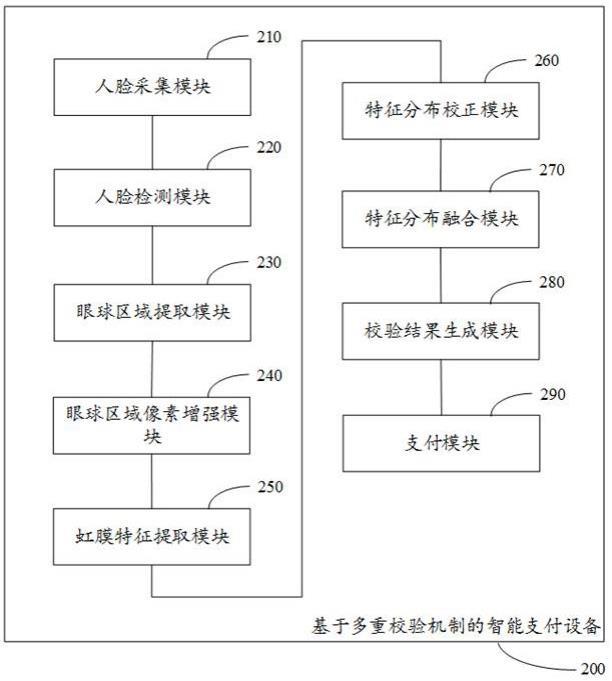

25.图2为根据本技术实施例的基于多重校验机制的智能支付设备的框图。

26.图3为根据本技术实施例的基于多重校验机制的智能支付设备中特征分布校正模块的框图。

27.图4为根据本技术实施例的基于多重校验机制的智能支付设备的支付方法的流程图。

28.图5为根据本技术实施例的基于多重校验机制的智能支付设备的支付方法的架构

示意图。

具体实施方式

29.下面,将参考附图详细地描述根据本技术的示例实施例。显然,所描述的实施例仅仅是本技术的一部分实施例,而不是本技术的全部实施例,应理解,本技术不受这里描述的示例实施例的限制。

30.场景概述如前所述,公共交通,尤其是地铁作为现在交通事业中的重要组成部分,在解决道路拥挤问题与提高通行效率方面起到关键性作用,但乘车支付的形式及支付速度成为一个备受关注的问题。支付的快慢与便捷不仅影响上车时间还决定着乘客的乘车体验,更决定着人们出行效率,对道路通行能力也会带来一定的影响。

31.目前乘坐公交的支付方式大多是现金、刷卡、扫码支付,而在乘坐过程中往往会出现一些不确定因素,如忘带公交卡、手机欠费、手机关机、扫码时的识别错误等,这些都会给我们的出行带来不便以至于无法支付,导致不能乘车的尴尬局面。因此,期待一种用于公共交通领域的智能支付设备,其能够以无感支付的方式来进行运作以提高人们乘车出行的支付效率,让出行更加方便。

32.相应地,考虑到刷脸支付是常用的无感支付手段,但在公共交通领域,刷脸支付却无法很好地满足应用场景要求。究其原因,本技术发明人发现人们在出行时会做各式各样的装饰,例如女性会化妆打扮、穿戴遮阳设备,这使得在刷脸支付时无法准确地识别人脸,导致无法支付或者错误支付。因此,在本技术中,本技术发明热尝试结合了人脸识别和虹膜识别来提高支付的安全性和便利性。

33.具体地,在本技术的技术方案中,首先,通过智能支付设备的摄像头采集待校验对象的人脸图像。然后,使用在图像的局部隐含特征提取方面具有优异表现的卷积神经网络来对所述待校验对象的人脸图像进行隐含特征的深层挖掘。应可以理解,基于深度学习的目标检测方法依据网络中是否使用锚窗将网络分为基于锚窗(anchor-based)与无锚窗(anchor-free)两大类。基于锚窗的方法如fast r-cnn、faster r-cnn、retinanet等,基于无锚窗的方法如 centernet、extremenet、 reppoints等。其中,使用基于锚窗的方法能够使得网络之间进行目标分类与边界框坐标的回归,加入先验使得训练稳定,并且其还能够有效地提高网络目标的召回能力,对于小目标检测来说提升非常明显。因此,在本技术的技术方案中,将所述待校验对象的人脸图像通过作为人脸区域检测网络的第一卷积神经网络模型以得到人脸特征图。特别地,这里,所述第一卷积神经网络模型为fast r-cnn、faster r-cnn或retinanet。

34.然后,进一步基于眼球在所述人脸图像中的位置,从所述人脸特征图提取对应于所述眼球的眼球区域特征图。这里,利用了卷积神经网络在提取特征的位置不变形,因此,所述人脸特征图中的对应于眼球的眼球区域特征图可以根据原图像中所述眼球在所述人脸图像中的位置来确定。应可以理解,由于通常所采集的所述待校验对象的人脸图像中的眼球图像的分辨率不高,无法清晰地识别虹膜,因此,在本技术的技术方案中,进一步将所述眼球区域特征图通过作为像素增强器的生成器模型以得到生成眼球区域图像。

35.这样,再将所述生成眼球区域图像通过具有显著性检测模块的第二卷积神经网络

模型中进行局部高维隐含特征提取,以得到虹膜特征图。具体地,在本技术实施例中,以所述第二卷积神经网络的各层的第一卷积单元以第一卷积核对所述输入数据进行卷积编码以得到卷积特征图;再以所述第二卷积神经网络的各层的第二卷积单元以第二卷积核对所述卷积特征图进行卷机编码以得到再卷积特征图,其中,所述第一卷积单元和所述第二卷积单元形成所述显著性特征检测模块,所述第一卷积核的尺寸大于所述第二卷积核的尺寸;接着,以所述第二卷积神经网络的各层的池化单元对所述再卷积特征图进行基于局部特征矩阵的均值池化以得到池化特征图;以及,然后,以所述第二卷积神经网络的各层的激活单元对所述池化特征图中各个位置的特征值进行非线性激活以得到激活特征图;其中,所述第二卷积神经网络的最后一层的输出为所述虹膜特征图。

36.应可以理解,在获得虹膜特征图时,通过候选框作为参考窗提取图像中的局部区域,再通过分辨率增强和显著性检测获得虹膜特征图,这就使得虹膜特征图在数据密集程度上要高于人脸特征图,如果直接融合人脸特征图f

face

和虹膜特征图f

iris

,可能导致融合特征图相对于人脸特征图和虹膜特征图的分类偏差。

37.因此,使用基于自注意力的数据密集簇机制对虹膜特征图进行加权,具体为:其中f

face

表示所述人脸特征图,f

iris

表示所述虹膜特征图,表示点乘,softmax(

·

)表示特征图通过分类器得到的概率值,d(

·

,

·

)表示特征图之间的距离,exp(

·

)表示特征图的指数运算,所述特征图的指数运算表示计算以特征图中各个位置的特征值为幂的自然指数函数值,特征图除以参数表示以特征图中各个位置的特征值分别除以参数。

38.这里,该基于自注意力的数据密集簇机制使能基于参考窗的局部特征与整体特征的空间交互,并通过特征图距离表示的数据相异性的度量来表达数据密集对象实例之间的相似度。通过以其对虹膜特征图加权后再与人脸特征图融合,可以通过虹膜特征图内的数据密集簇的自适应依赖来提升融合后的特征图对于分类目标函数的参数自适应变化性,从而提高分类准确性。

39.然后,融合所述加权后虹膜特征图和所述人脸特征图以得到分类特征图,再将所述分类特征图通过分类器以获得用于表示待检验对象对应于数据库中的对象标签的分类结果。进一步地,基于所述对象标签所关联的支付账户中的金额,支付乘车所需的费用。在本技术实施例中,响应于所述对象标签所关联的支付账户中的金额小于所述乘车所需的费用,生成费用不足提示。

40.基于此,本技术提出了一种基于多重校验机制的智能支付设备,其包括:人脸采集模块,用于获取由智能支付设备的摄像头采集的待校验对象的人脸图像;人脸检测模块,用于将所述待校验对象的人脸图像通过作为人脸区域检测网络的第一卷积神经网络模型以得到人脸特征图;眼球区域提取模块,用于基于眼球在所述人脸图像中的位置,从所述人脸特征图提取对应于所述眼球的眼球区域特征图;眼球区域像素增强模块,用于将所述眼球区域特征图通过作为像素增强器的生成器模型以得到生成眼球区域图像;虹膜特征提取模

块,用于将所述生成眼球区域图像通过具有显著性检测模块的第二卷积神经网络模型以得到虹膜特征图;特征分布校正模块,用于基于所述人脸特征图,使用基于自注意力的数据密集簇机制对所述虹膜特征图进行加权以得到加权后虹膜特征图,其中,所述使用基于自注意力的数据密集簇机制对虹膜特征图进行加权基于所述人脸特征图和所述虹膜特征图之间的按位置点乘所得到的空间交互特征图,以及,所述人脸特征图和所述虹膜特征图之间的距离来进行;特征分布融合模块,用于融合所述加权后虹膜特征图和所述人脸特征图以得到分类特征图;校验结果生成模块,用于将所述分类特征图通过分类器以得到分类结果,所述分类结果为待检验对象对应于数据库中的对象标签;以及,支付模块,用于基于所述对象标签所关联的支付账户中的金额,支付乘车所需的费用。

41.图1图示了根据本技术实施例的基于多重校验机制的智能支付设备的应用场景图。如图1所示,在该应用场景中,首先,通过智能支付设备(例如,如图1中所示意的t)中的摄像头(例如,如图1中所示意的c)采集待校验对象的人脸图像。然后,将获取的所述待校验对象的人脸图像输入至部署有基于多重校验机制的智能支付算法的服务器中(例如,如图1中所示意的云服务器s),其中,所述服务器能够以基于多重校验机制的智能支付算法对所述待校验对象的人脸图像进行处理,以生成用于表示待检验对象对应于数据库中的对象标签的分类结果,进而,基于所述对象标签所关联的支付账户中的金额,支付乘车所需的费用。

42.在介绍了本技术的基本原理之后,下面将参考附图来具体介绍本技术的各种非限制性实施例。

43.示例性系统图2图示了根据本技术实施例的基于多重校验机制的智能支付设备的框图。如图2所示,根据本技术实施例的基于多重校验机制的智能支付设备 200,包括:人脸采集模块 210,用于获取由智能支付设备的摄像头采集的待校验对象的人脸图像;人脸检测模块 220,用于将所述待校验对象的人脸图像通过作为人脸区域检测网络的第一卷积神经网络模型以得到人脸特征图;眼球区域提取模块 230,用于基于眼球在所述人脸图像中的位置,从所述人脸特征图提取对应于所述眼球的眼球区域特征图;眼球区域像素增强模块 240,用于将所述眼球区域特征图通过作为像素增强器的生成器模型以得到生成眼球区域图像;虹膜特征提取模块 250,用于将所述生成眼球区域图像通过具有显著性检测模块的第二卷积神经网络模型以得到虹膜特征图;特征分布校正模块 260,用于基于所述人脸特征图,使用基于自注意力的数据密集簇机制对所述虹膜特征图进行加权以得到加权后虹膜特征图,其中,所述使用基于自注意力的数据密集簇机制对虹膜特征图进行加权基于所述人脸特征图和所述虹膜特征图之间的按位置点乘所得到的空间交互特征图,以及,所述人脸特征图和所述虹膜特征图之间的距离来进行;特征分布融合模块 270,用于融合所述加权后虹膜特征图和所述人脸特征图以得到分类特征图;校验结果生成模块 280,用于将所述分类特征图通过分类器以得到分类结果,所述分类结果为待检验对象对应于数据库中的对象标签;以及,支付模块 290,用于基于所述对象标签所关联的支付账户中的金额,支付乘车所需的费用。

44.具体地,在本技术实施例中,所述人脸采集模块 210和所述人脸检测模块 220,用于获取由智能支付设备的摄像头采集的待校验对象的人脸图像,并将所述待校验对象的人

脸图像通过作为人脸区域检测网络的第一卷积神经网络模型以得到人脸特征图。如前所述,考虑到刷脸支付是常用的无感支付手段,但在公共交通领域,刷脸支付却无法很好地满足应用场景要求。究其原因,是由于人们在出行时会做各式各样的装饰,例如女性会化妆打扮、穿戴遮阳设备,这使得在刷脸支付时无法准确地识别人脸,导致无法支付或者错误支付。因此,在本技术的技术方案中,期望结合人脸识别和虹膜识别来提高支付的安全性和准确性。

45.具体地,在本技术的技术方案中,首先,通过智能支付设备的摄像头采集待校验对象的人脸图像。然后,使用在图像的局部隐含特征提取方面具有优异表现的卷积神经网络来对所述待校验对象的人脸图像进行隐含特征的深层挖掘。应可以理解,基于深度学习的目标检测方法依据网络中是否使用锚窗将网络分为基于锚窗(anchor-based)与无锚窗(anchor-free)两大类。所述基于锚窗的方法如fast r-cnn、faster r-cnn、retinanet等,所述基于无锚窗的方法如 centernet、extremenet、 reppoints等。其中,使用所述基于锚窗的方法能够使得网络之间进行目标分类与边界框坐标的回归,加入先验使得训练稳定,并且其还能够有效地提高网络目标的召回能力,对于小目标检测来说提升非常明显。因此,在本技术的技术方案中,将所述待校验对象的人脸图像通过作为人脸区域检测网络的第一卷积神经网络模型中进行处理,以提取出所述人脸图像中的局部高维隐含特征分布,以得到人脸特征图。特别地,这里,所述第一卷积神经网络模型为fast r-cnn、faster r-cnn或retinanet。

46.具体地,在本技术实施例中,所述眼球区域提取模块 230和所述眼球区域像素增强模块 240,用于基于眼球在所述人脸图像中的位置,从所述人脸特征图提取对应于所述眼球的眼球区域特征图,并将所述眼球区域特征图通过作为像素增强器的生成器模型以得到生成眼球区域图像。也就是,为了结合人脸识别和虹膜识别来提高支付的安全性和准确性,进一步基于眼球在所述人脸图像中的位置,从所述人脸特征图提取对应于所述眼球的眼球区域特征图。应可以理解,这里,利用了卷积神经网络在提取特征的位置不变形,因此,在本技术的技术方案中,所述人脸特征图中的对应于眼球的眼球区域特征图可以根据原图像中所述眼球在所述人脸图像中的位置来确定。

47.然后,应可以理解,由于通常所采集的所述待校验对象的人脸图像中的眼球图像的分辨率不高,无法清晰地识别虹膜,因此,在本技术的技术方案中,进一步将所述眼球区域特征图通过作为像素增强器的生成器模型以得到生成特征增强后的眼球区域图像。

48.具体地,在本技术实施例中,所述虹膜特征提取模块 250,用于将所述生成眼球区域图像通过具有显著性检测模块的第二卷积神经网络模型以得到虹膜特征图。也就是,在本技术的技术方案中,这样,再将所述生成眼球区域图像通过具有显著性检测模块的第二卷积神经网络模型中进行局部高维隐含特征提取,以得到对应于眼球区域的虹膜特征图。

49.更具体地,在本技术实施例中,所述虹膜特征提取模块,进一步用于以所述第二卷积神经网络的各层对输入数据进行如下方式的编码:以所述第二卷积神经网络的各层的第一卷积单元以第一卷积核对所述输入数据进行卷积编码以得到卷积特征图;以所述第二卷积神经网络的各层的第二卷积单元以第二卷积核对所述卷积特征图进行卷机编码以得到再卷积特征图,其中,所述第一卷积单元和所述第二卷积单元形成所述显著性特征检测模块,所述第一卷积核的尺寸大于所述第二卷积核的尺寸;以所述第二卷积神经网络的各层

的池化单元对所述再卷积特征图进行基于局部特征矩阵的均值池化以得到池化特征图;以及,以所述第二卷积神经网络的各层的激活单元对所述池化特征图中各个位置的特征值进行非线性激活以得到激活特征图;其中,所述第二卷积神经网络的最后一层的输出为所述虹膜特征图。

50.具体地,在本技术实施例中,所述特征分布校正模块 260,用于基于所述人脸特征图,使用基于自注意力的数据密集簇机制对所述虹膜特征图进行加权以得到加权后虹膜特征图,其中,所述使用基于自注意力的数据密集簇机制对虹膜特征图进行加权基于所述人脸特征图和所述虹膜特征图之间的按位置点乘所得到的空间交互特征图,以及,所述人脸特征图和所述虹膜特征图之间的距离来进行。应可以理解,在获得所述虹膜特征图时,通过候选框作为参考窗提取图像中的局部区域,再通过分辨率增强和显著性检测获得所述虹膜特征图,这就使得所述虹膜特征图在数据密集程度上要高于所述人脸特征图,如果直接融合所述人脸特征图f

face

和所述虹膜特征图f

iris

,可能导致融合特征图相对于所述人脸特征图和所述虹膜特征图的分类偏差。因此,在本技术的技术方案中,进一步使用基于自注意力的数据密集簇机制对虹膜特征图进行加权。

51.相应地,在一个具体示例中,首先,计算所述人脸特征图和所述虹膜特征图之间的按位置点乘以得到所述空间交互特征图。接着,计算所述所述人脸特征图和所述虹膜特征图之间欧式距离的平方根。然后,以所述空间交互特征图中各个位置的特征值分别除以所述所述人脸特征图和所述虹膜特征图之间欧式距离的平方根以得到注意力特征图。接着,计算以所述注意力特征图中各个位置的特征值为幂的自然指数函数值以得到指数注意力特征图。然后,将所述指数注意力特征图通过所述分类器以得到第一类概率指数。接着,将所述虹膜特征图通过所述分类器以得到第二类概率指数。然后,计算所述第一类概率指数和所述第二类概率指数之间的乘积作为所述虹膜特征图的加权系数。最后,以所述加权系数对所述虹膜特征图进行加权以得到所述加权后虹膜特征图。应可以理解,基于所述自注意力的数据密集簇机制使能基于参考窗的局部特征与整体特征的空间交互,并通过特征图距离表示的数据相异性的度量来表达数据密集对象实例之间的相似度。这样,通过以其对所述虹膜特征图加权后再与所述人脸特征图融合,可以通过所述虹膜特征图内的数据密集簇的自适应依赖来提升融合后的特征图对于分类目标函数的参数自适应变化性,从而提高分类准确性。

52.更具体地,在本技术实施例中,所述特征分布校正模块,进一步用于:以如下公式使用基于自注意力的数据密集簇机制对所述虹膜特征图进行加权以得到所述加权后虹膜特征图;其中,所述公式为:其中f

face

表示所述人脸特征图,f

iris

表示所述虹膜特征图,表示点乘,softmax(

·

)表示特征图通过分类器得到的概率值,d(

·

,

·

)表示特征图之间的距离,exp(

·

)表示

特征图的指数运算,所述特征图的指数运算表示计算以特征图中各个位置的特征值为幂的自然指数函数值,特征图除以参数表示以特征图中各个位置的特征值分别除以参数。

53.图3图示了根据本技术实施例的基于多重校验机制的智能支付设备中特征分布校正模块的框图。如图3所示,所述特征分布校正模块 260,包括:空间交互特征图生成单元 261,用于计算所述人脸特征图和所述虹膜特征图之间的按位置点乘以得到所述空间交互特征图;数据差异性度量单元 262,用于计算所述所述人脸特征图和所述虹膜特征图之间欧式距离的平方根;注意力单元 263,用于以所述空间交互特征图中各个位置的特征值分别除以所述所述人脸特征图和所述虹膜特征图之间欧式距离的平方根以得到注意力特征图;指数运算单元264,用于计算以所述注意力特征图中各个位置的特征值为幂的自然指数函数值以得到指数注意力特征图;第一类概率单元 265,用于将所述指数注意力特征图通过所述分类器以得到第一类概率指数;第二类概率单元 266,用于将所述虹膜特征图通过所述分类器以得到第二类概率指数;作用单元 267,用于计算所述第一类概率指数和所述第二类概率指数之间的乘积作为所述虹膜特征图的加权系数;以及,校正单元 268,用于以所述加权系数对所述虹膜特征图进行加权以得到所述加权后虹膜特征图。

54.具体地,在本技术实施例中,所述特征分布融合模块 270,用于融合所述加权后虹膜特征图和所述人脸特征图以得到分类特征图。应可以理解,这样,通过使用所述基于自注意力的数据密集簇机制对所述虹膜特征图加权后再与所述人脸特征图融合,可以通过所述虹膜特征图内的数据密集簇的自适应依赖来提升融合后的所述分类特征图对于分类目标函数的参数自适应变化性,从而提高分类准确性。

55.更具体地,在本技术实施例中,所述特征分布融合模块,进一步用于:以如下公式融合所述加权后虹膜特征图和所述人脸特征图以得到所述分类特征图;其中,所述公式为:f=αwf

iris

+βf

face

其中,f为所述分类特征图,f

iris

为所述虹膜特征图,f

face

为所述人脸特征图,wf

iris

表示所述加权后虹膜特征图,“+”表示所述加权后虹膜特征图和所述人脸特征图相对应位置处的元素相加,α和β为用于控制所述加权后虹膜特征图和所述人脸特征图之间的平衡的加权参数。

56.具体地,在本技术实施例中,所述校验结果生成模块 280和所述支付模块 290,用于将所述分类特征图通过分类器以得到分类结果,所述分类结果为待检验对象对应于数据库中的对象标签,并基于所述对象标签所关联的支付账户中的金额,支付乘车所需的费用。也就是,在本技术的技术方案中,在得到所述分类特征图后,进一步将所述分类特征图通过分类器中以获得用于表示待检验对象对应于数据库中的对象标签的分类结果,进而,基于所述对象标签所关联的支付账户中的金额,支付乘车所需的费用。相应地,在一个具体示例中,响应于所述对象标签所关联的支付账户中的金额小于所述乘车所需的费用,生成费用不足提示。

57.更具体地,在本技术实施例中,所述分类器以如下公式对所述分类特征图进行处理以生成分类结果;所述公式为:softmax{(wn, bn):...:(w1, b1)|project(f)},其中project(f)表示将所述分类特征图投影为向量,w1至wn为各层全连接层的权重矩阵,b1至bn表示各层全连

接层的偏置矩阵。

58.综上,基于本技术实施例的所述基于多重校验机制的智能支付设备 200被阐明,其通过深度神经网络模型来从待校验对象的人脸图像和眼球区域图像中挖掘深层的局部隐含关联特征信息,以结合人脸识别和虹膜识别来提高支付的安全性和准确性,并且在此过程中,为了提高融合的效果以提高分类的准确性,进一步使用基于自注意力的数据密集簇机制对虹膜特征图进行加权,这样可以通过所述虹膜特征图内的数据密集簇的自适应依赖来提升融合后的特征图对于分类目标函数的参数自适应变化性,从而提高分类准确性。

59.如上所述,根据本技术实施例的基于多重校验机制的智能支付设备 200可以实现在各种终端设备中,例如基于多重校验机制的智能支付算法的服务器等。在一个示例中,根据本技术实施例的基于多重校验机制的智能支付设备 200可以作为一个软件模块和/或硬件模块而集成到终端设备中。例如,该基于多重校验机制的智能支付设备 200可以是该终端设备的操作系统中的一个软件模块,或者可以是针对于该终端设备所开发的一个应用程序;当然,该基于多重校验机制的智能支付设备 200同样可以是该终端设备的众多硬件模块之一。

60.替换地,在另一示例中,该基于多重校验机制的智能支付设备 200与该终端设备也可以是分立的设备,并且该基于多重校验机制的智能支付设备 200可以通过有线和/或无线网络连接到该终端设备,并且按照约定的数据格式来传输交互信息。

61.示例性方法图4图示了基于多重校验机制的智能支付设备的支付方法的流程图。如图4所示,根据本技术实施例的基于多重校验机制的智能支付设备的支付方法,包括步骤:s110,获取由智能支付设备的摄像头采集的待校验对象的人脸图像;s120,将所述待校验对象的人脸图像通过作为人脸区域检测网络的第一卷积神经网络模型以得到人脸特征图;s130,基于眼球在所述人脸图像中的位置,从所述人脸特征图提取对应于所述眼球的眼球区域特征图;s140,将所述眼球区域特征图通过作为像素增强器的生成器模型以得到生成眼球区域图像;s150,将所述生成眼球区域图像通过具有显著性检测模块的第二卷积神经网络模型以得到虹膜特征图;s160,基于所述人脸特征图,使用基于自注意力的数据密集簇机制对所述虹膜特征图进行加权以得到加权后虹膜特征图,其中,所述使用基于自注意力的数据密集簇机制对虹膜特征图进行加权基于所述人脸特征图和所述虹膜特征图之间的按位置点乘所得到的空间交互特征图,以及,所述人脸特征图和所述虹膜特征图之间的距离来进行;s170,融合所述加权后虹膜特征图和所述人脸特征图以得到分类特征图;s180,将所述分类特征图通过分类器以得到分类结果,所述分类结果为待检验对象对应于数据库中的对象标签;以及,s190,基于所述对象标签所关联的支付账户中的金额,支付乘车所需的费用。

62.图5图示了根据本技术实施例的基于多重校验机制的智能支付设备的支付方法的架构示意图。如图5所示,在所述基于多重校验机制的智能支付设备的支付方法的网络架构中,首先,将获得的所述待校验对象的人脸图像(例如,如图5中所示意的p1)通过作为人脸区域检测网络的第一卷积神经网络模型(例如,如图5中所示意的cnn1)以得到人脸特征图(例如,如图5中所示意的f1);接着,基于眼球在所述人脸图像中的位置,从所述人脸特征图提取对应于所述眼球的眼球区域特征图(例如,如图5中所示意的f2);然后,将所述眼球区域特征图通过作为像素增强器的生成器模型(例如,如图5中所示意的gm)以得到生成眼球

区域图像(例如,如图5中所示意的f3);接着,将所述生成眼球区域图像通过具有显著性检测模块的第二卷积神经网络模型(例如,如图5中所示意的cnn2)以得到虹膜特征图(例如,如图5中所示意的f4);然后,基于所述人脸特征图,使用基于自注意力的数据密集簇机制(例如,如图5中所示意的dcm)对所述虹膜特征图进行加权以得到加权后虹膜特征图(例如,如图5中所示意的f);接着,融合所述加权后虹膜特征图和所述人脸特征图以得到分类特征图(例如,如图5中所示意的fc);然后,将所述分类特征图通过分类器(例如,如图5中所示意的分类器)以得到分类结果,所述分类结果为待检验对象对应于数据库中的对象标签;以及,最后,基于所述对象标签所关联的支付账户中的金额,支付乘车所需的费用。将获得的所述当前时间点的输入信号波形(例如,如图5中所示意的in1)和输出信号波形(例如,如图4中所示意的in2)分别输入卷积神经网络(例如,如图4中所示意的cnn)以获得输入信号特征图(例如,如图4中所示意的f1)和输出信号特征图(例如,如图4中所示意的f2);接着,分别对所述输入信号特征图和所述输出信号特征图进行沿通道维度的池化以获得输入特征矩阵(例如,如图4中所示意的m1)和输出特征矩阵(例如,如图4中所示意的m2);然后,将所述眼球区域特征图通过作为像素增强器的生成器模型以得到生成眼球区域图像(例如,如图4中所示意的mt1);接着,将获得的所述当期时间点之前的一系列预定时间点的输入信号波形(例如,如图4中所示意的in3)和输出信号波形(例如,如图4中所示意的in4)分别以处理所述当前时间点的输入信号波形和输出信号波形的方式进行处理,以获得第二转移矩阵至第n转移矩阵(例如,如图4中所示意的mt2-mtn);然后,融合所述加权后虹膜特征图和所述人脸特征图以得到分类特征图(例如,如图4中所示意的md);接着,对所述距离矩阵进行相关坐标估计以获得分类矩阵(例如,如图4中所示意的mc);以及,最后,将所述分类矩阵通过用于回归的编码器(例如,如图4中所示意的e)以获得所需的pwn激励波的占空比。

63.更具体地,在步骤s110和步骤s120中,获取由智能支付设备的摄像头采集的待校验对象的人脸图像,并将所述待校验对象的人脸图像通过作为人脸区域检测网络的第一卷积神经网络模型以得到人脸特征图。应可以理解,考虑到刷脸支付是常用的无感支付手段,但在公共交通领域,刷脸支付却无法很好地满足应用场景要求。究其原因,是由于人们在出行时会做各式各样的装饰,例如女性会化妆打扮、穿戴遮阳设备,这使得在刷脸支付时无法准确地识别人脸,导致无法支付或者错误支付。因此,在本技术的技术方案中,期望结合人脸识别和虹膜识别来提高支付的安全性和准确性。

64.具体地,在本技术的技术方案中,首先,通过智能支付设备的摄像头采集待校验对象的人脸图像。然后,使用在图像的局部隐含特征提取方面具有优异表现的卷积神经网络来对所述待校验对象的人脸图像进行隐含特征的深层挖掘。应可以理解,基于深度学习的目标检测方法依据网络中是否使用锚窗将网络分为基于锚窗(anchor-based)与无锚窗(anchor-free)两大类。所述基于锚窗的方法如fast r-cnn、faster r-cnn、retinanet等,所述基于无锚窗的方法如 centernet、extremenet、 reppoints等。其中,使用所述基于锚窗的方法能够使得网络之间进行目标分类与边界框坐标的回归,加入先验使得训练稳定,并且其还能够有效地提高网络目标的召回能力,对于小目标检测来说提升非常明显。因此,在本技术的技术方案中,将所述待校验对象的人脸图像通过作为人脸区域检测网络的第一卷积神经网络模型中进行处理,以提取出所述人脸图像中的局部高维隐含特征分布,以得到人脸特征图。特别地,这里,所述第一卷积神经网络模型为fast r-cnn、faster r-cnn或

retinanet。

65.更具体地,在步骤s130和步骤s140中,基于眼球在所述人脸图像中的位置,从所述人脸特征图提取对应于所述眼球的眼球区域特征图,并将所述眼球区域特征图通过作为像素增强器的生成器模型以得到生成眼球区域图像。也就是,为了结合人脸识别和虹膜识别来提高支付的安全性和准确性,进一步基于眼球在所述人脸图像中的位置,从所述人脸特征图提取对应于所述眼球的眼球区域特征图。应可以理解,这里,利用了卷积神经网络在提取特征的位置不变形,因此,在本技术的技术方案中,所述人脸特征图中的对应于眼球的眼球区域特征图可以根据原图像中所述眼球在所述人脸图像中的位置来确定。

66.然后,应可以理解,由于通常所采集的所述待校验对象的人脸图像中的眼球图像的分辨率不高,无法清晰地识别虹膜,因此,在本技术的技术方案中,进一步将所述眼球区域特征图通过作为像素增强器的生成器模型以得到生成特征增强后的眼球区域图像。

67.更具体地,在步骤s150中,将所述生成眼球区域图像通过具有显著性检测模块的第二卷积神经网络模型以得到虹膜特征图。也就是,在本技术的技术方案中,这样,再将所述生成眼球区域图像通过具有显著性检测模块的第二卷积神经网络模型中进行局部高维隐含特征提取,以得到对应于眼球区域的虹膜特征图。

68.更具体地,在步骤s160中,基于所述人脸特征图,使用基于自注意力的数据密集簇机制对所述虹膜特征图进行加权以得到加权后虹膜特征图,其中,所述使用基于自注意力的数据密集簇机制对虹膜特征图进行加权基于所述人脸特征图和所述虹膜特征图之间的按位置点乘所得到的空间交互特征图,以及,所述人脸特征图和所述虹膜特征图之间的距离来进行。应可以理解,在获得所述虹膜特征图时,通过候选框作为参考窗提取图像中的局部区域,再通过分辨率增强和显著性检测获得所述虹膜特征图,这就使得所述虹膜特征图在数据密集程度上要高于所述人脸特征图,如果直接融合所述人脸特征图f

face

和所述虹膜特征图f

iris

,可能导致融合特征图相对于所述人脸特征图和所述虹膜特征图的分类偏差。因此,在本技术的技术方案中,进一步使用基于自注意力的数据密集簇机制对虹膜特征图进行加权。

69.相应地,在一个具体示例中,首先,计算所述人脸特征图和所述虹膜特征图之间的按位置点乘以得到所述空间交互特征图。接着,计算所述所述人脸特征图和所述虹膜特征图之间欧式距离的平方根。然后,以所述空间交互特征图中各个位置的特征值分别除以所述所述人脸特征图和所述虹膜特征图之间欧式距离的平方根以得到注意力特征图。接着,计算以所述注意力特征图中各个位置的特征值为幂的自然指数函数值以得到指数注意力特征图。然后,将所述指数注意力特征图通过所述分类器以得到第一类概率指数。接着,将所述虹膜特征图通过所述分类器以得到第二类概率指数。然后,计算所述第一类概率指数和所述第二类概率指数之间的乘积作为所述虹膜特征图的加权系数。最后,以所述加权系数对所述虹膜特征图进行加权以得到所述加权后虹膜特征图。应可以理解,基于所述自注意力的数据密集簇机制使能基于参考窗的局部特征与整体特征的空间交互,并通过特征图距离表示的数据相异性的度量来表达数据密集对象实例之间的相似度。这样,通过以其对所述虹膜特征图加权后再与所述人脸特征图融合,可以通过所述虹膜特征图内的数据密集簇的自适应依赖来提升融合后的特征图对于分类目标函数的参数自适应变化性,从而提高分类准确性。

70.更具体地,在步骤s170中,融合所述加权后虹膜特征图和所述人脸特征图以得到分类特征图。应可以理解,这样,通过使用所述基于自注意力的数据密集簇机制对所述虹膜特征图加权后再与所述人脸特征图融合,可以通过所述虹膜特征图内的数据密集簇的自适应依赖来提升融合后的所述分类特征图对于分类目标函数的参数自适应变化性,从而提高分类准确性。

71.更具体地,在步骤s180和步骤s190中,将所述分类特征图通过分类器以得到分类结果,所述分类结果为待检验对象对应于数据库中的对象标签,并基于所述对象标签所关联的支付账户中的金额,支付乘车所需的费用。也就是,在本技术的技术方案中,在得到所述分类特征图后,进一步将所述分类特征图通过分类器中以获得用于表示待检验对象对应于数据库中的对象标签的分类结果,进而,基于所述对象标签所关联的支付账户中的金额,支付乘车所需的费用。相应地,在一个具体示例中,响应于所述对象标签所关联的支付账户中的金额小于所述乘车所需的费用,生成费用不足提示。

72.综上,基于本技术实施例的所述基于多重校验机制的智能支付设备的支付方法被阐明,其通过深度神经网络模型来从待校验对象的人脸图像和眼球区域图像中挖掘深层的局部隐含关联特征信息,以结合人脸识别和虹膜识别来提高支付的安全性和准确性,并且在此过程中,为了提高融合的效果以提高分类的准确性,进一步使用基于自注意力的数据密集簇机制对虹膜特征图进行加权,这样可以通过所述虹膜特征图内的数据密集簇的自适应依赖来提升融合后的特征图对于分类目标函数的参数自适应变化性以提高分类准确性,这样提高支付的安全性和便利性。

73.以上结合具体实施例描述了本技术的基本原理,但是,需要指出的是,在本技术中提及的优点、优势、效果等仅是示例而非限制,不能认为这些优点、优势、效果等是本技术的各个实施例必须具备的。另外,上述公开的具体细节仅是为了示例的作用和便于理解的作用,而非限制,上述细节并不限制本技术为必须采用上述具体的细节来实现。

74.本技术中涉及的器件、装置、设备、系统的方框图仅作为例示性的例子并且不意图要求或暗示必须按照方框图示出的方式进行连接、布置、配置。如本领域技术人员将认识到的,可以按任意方式连接、布置、配置这些器件、装置、设备、系统。诸如“包括”、“包含”、“具有”等等的词语是开放性词汇,指“包括但不限于”,且可与其互换使用。这里所使用的词汇“或”和“和”指词汇“和/或”,且可与其互换使用,除非上下文明确指示不是如此。这里所使用的词汇“诸如”指词组“诸如但不限于”,且可与其互换使用。

75.还需要指出的是,在本技术的装置、设备和方法中,各部件或各步骤是可以分解和/或重新组合的。这些分解和/或重新组合应视为本技术的等效方案。

76.提供所公开的方面的以上描述以使本领域的任何技术人员能够做出或者使用本技术。对这些方面的各种修改对于本领域技术人员而言是非常显而易见的,并且在此定义的一般原理可以应用于其他方面而不脱离本技术的范围。因此,本技术不意图被限制到在此示出的方面,而是按照与在此公开的原理和新颖的特征一致的最宽范围。

77.为了例示和描述的目的已经给出了以上描述。此外,此描述不意图将本技术的实施例限制到在此公开的形式。尽管以上已经讨论了多个示例方面和实施例,但是本领域技术人员将认识到其某些变型、修改、改变、添加和子组合。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1