神经网络训练方法、文本分类方法及文本分类系统与流程

1.本发明涉及人工智能技术领域,尤其涉及一种神经网络训练方法、文本分类方法及文本分类系统。

背景技术:

2.自从2017年transformer模型诞生以来,encoder-decoder取得的技术效果非常显著,然后2018年google又提出了bert预训练模型,又大大推动了nlp的的进步,广泛应用在nlp的各个领域里,比如对文本分类。

3.但基于bert模型也存在其难以解决的技术缺陷,主要是因为基于bert模型的文本分类算法构建的模型,参数都非常大,导致训练成本非常高,在实际使用的时候速度也比较慢,同时对于新出现的文本分类也不够准确。

技术实现要素:

4.本发明为解决现有技术中存在的技术问题,提出一种神经网络训练方法,包括步骤:

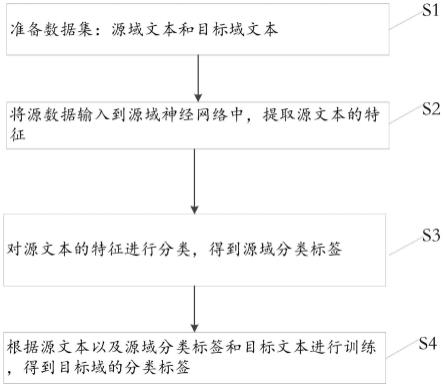

5.s1:准备数据集:源域文本和目标域文本;

6.s2:将源数据输入到源域神经网络中,提取源文本的特征;

7.s3:对源文本的特征进行分类,得到源域分类标签;

8.s4:根据源文本以及源域分类标签和目标文本进行训练,得到目标域的分类标签。

9.进一步地,步骤s4:根据源文本以及源域分类标签和目标文本进行训练,得到目标域的分类标签包括:

10.将源域神经网络训练得到的参数作为目标域神经网络训练的初始化参数;

11.分别将源域文本和目标域文本输入至各自的神经网络中进行特征提取;

12.根据提取的源域文本特征和目标域文本的特征进行训练,获得目标域的分类标签。

13.进一步地,所述根据提取的源域文本特征和目标域文本的特征进行训练,采用对抗的方法进行训练。

14.进一步地,所述源域神经网络或目标域神经网络为基于bert构建的神经网络。

15.进一步地,在步骤s4中还包括对源域神经网络和目标域神经网络的参数进行压缩处理。

16.进一步地,对源域神经网络和目标域神经网络的参数进行压缩处理的方法为知识蒸馏。

17.本发明还提供一种文本分类方法,包括步骤:

18.接收输入的文本;

19.神经网络模型对文本进行分析并分类;

20.返回输出结果,

21.所述神经网络为所述神经网络训练方法得到的神经网络模型。

22.本发明还提供一种文本分类系统,包括交互单元、处理模块,其中:

23.交互单元用以接收输入的文本;

24.处理模块用以对输入的文本进行处理并向交互单元返回分类结果,

25.所述神经网络为所述神经网络训练方法得到的神经网络模型。

26.本发明还提供一种计算机可读存储介质,所述存储介质中存储有指令或者程序,所述指令或者程序由处理器加载并执行所述的文本分类方法。

27.本发明还提供一种电子设备,包括:处理器、存储介质和总线,所述存储介质存储有所述处理器可执行的机器可读指令,当电子设备运行时,所述处理器与所述存储介质之间通过总线通信,所述处理器执行所述机器可读指令,以所述的文本分类方法。

28.本发明公开的方法和系统中所述模块,在实际应用中,即可以在一台目标服务器上部署多个模块,也可以每一模块独立部署在不同的目标服务器上,特别的,根据需要,为了提供更强大的计算处理能力,也可以根据需要将模块部署到集群目标服务器上。

29.由此可见,本发明能够实现知识领域的迁移,在文本分类上达到了又快又准的技术效果。

30.为了对本发明有更清楚全面的了解,下面结合附图,对本发明的具体实施方式进行详细描述。

附图说明

31.为了更清楚地说明本技术实施例中的技术方案,下面将对实施例描述中所需要使用的附图作简单地介绍。显而易见地,下面描述中的附图仅仅是本技术的一些实施例,对于本领域技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

32.图1为本技术实施例的神经网络训练方法流程示意图。

具体实施方式

33.本技术所述的领域,泛指在迁移学习技术中的概念中,即把一个领域(即源域)的知识,迁移到另外一个领域(即目标领域)。也包括不同的场景下的文本,比如灯光较强时候拍的文本是一种领域,灯光较弱又是另外一种领域。

34.本技术提出一种新的神经网络训练方法,既可以压缩模型参数又可以提升准确率,有效解决领域漂移问题。

35.请参阅图1,本技术的神经网络训练方法,包括步骤:

36.s1:准备数据集:源域文本和目标域文本;

37.s2:将源数据输入到源域神经网络中,提取源文本的特征;

38.s3:对源文本的特征进行分类,得到源域分类标签;

39.s4:根据源文本以及源域分类标签和目标文本进行训练,得到目标域的分类标签。

40.下面结合各种优选的实施方式说明本技术的技术方案。

41.作为一种优选的实施例,本技术的源域神经网络和目标域神经网络均采用基于bert模型构建的神经网络,使用相同的神经网络结构,方便后续的训练以及优化,作为变化

的实施例方式,源域神经网络或者目标域神经网络可以使用其他的模型来构建。

42.在所述步骤s4:根据源文本以及源域分类标签和目标文本进行训练,得到目标域的分类标签中,作为一种优选的实施方式,包括:

43.s40:将源域神经网络训练得到的参数作为目标域神经网络训练的初始化参数.

44.由于本技术实施例中,源域神经网络和目标域神经网络均采用基于bert模型构建的神经网络,使用相同的神经网络结构,可以将源域神经网络预训练得到的神经网络参数直接作为目标域神经网络训练的初始化参数,大大提高了训练的效率。

45.s41:分别将源域文本和目标域文本输入至各自的神经网络中进行特征提取;

46.s42:根据提取的源域文本特征和目标域文本的特征进行训练,获得目标域的分类标签,本技术实施例中,可以使用对抗自适应的方法进行训练,此外还可以在训练过程,加入随机噪声产生目标域文本等,也可以考虑使用对抗生成来进行训练。

47.本技术实施例中,当选择基于bert模型的神经网络作为目标域神经网络时,bert强大的功能效果是非常明显的,但由于其参数庞大,训练成本太高,而且用来测试和部署的时候,消耗的算力较大,速度较慢,不适于在一些要求快速、低成本的场景里使用。因此,作为一种优选的实施方式,本技术实施例中,在步骤s4中还包括对源域神经网络和目标域神经网络的参数进行压缩处理,比如采用知识蒸馏来实现,从而可以进一步降低了训练成本,提高速度,也扩大了应用的范围。

48.基于上述实施例,本技术还提供一种文本分类方法,包括步骤:

49.接收输入的文本;

50.神经网络模型对文本进行分析并分类;

51.返回输出结果,

52.所述神经网络为上述实施例神经网络训练方法得到的神经网络模型。

53.相应地,基于上述实施例,本技术还提供一种文本分类系统,包括交互单元、处理模块,其中:

54.交互单元用以接收输入的文本;

55.处理模块用以对输入的文本进行处理并向交互单元返回分类结果,

56.所述处理模块为上述实施例神经网络训练方法得到的神经网络模型。

57.本技术实施例还提供一种计算机可读存储介质,所述存储介质中存储有指令或者程序,所述指令或者程序由处理器加载并执行如上述的文本分类方法。

58.本技术实施例还提供一种电子设备,包括:处理器、存储介质和总线,所述存储介质存储有所述处理器可执行的机器可读指令,当电子设备运行时,所述处理器与所述存储介质之间通过总线通信,所述处理器执行所述机器可读指令,以执行如上述任一所述的文本分类方法。

59.需要说明的是,本领域普通技术人员可以理解上述实施例的各种方法中的全部或部分步骤是可以通过计算机程序来指令相关的硬件来完成,所述计算机程序可以存储于计算机可读存储介质中,所述存储介质可以包括但不限于:只读存储器(rom,read only memory)、随机存取存储器(ram,random access memory)、磁盘或光盘等。

60.对所公开的实施例的上述说明,使本领域专业技术人员能够实现或使用本发明。对这些实施例的多种修改对本领域的专业技术人员来说将是显而易见的,本文中所定义的

一般原理可以在不脱离本发明的精神或范围的情况下,在其它实施例中实现。因此,本发明将不会被限制于本文所示的这些实施例,而是要符合与本文所公开的原理和新颖特点相一致的最宽的范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1