基于ALBERT的中文电子简历命名实体识别方法

基于albert的中文电子简历命名实体识别方法

技术领域

1.本发明属于计算机技术领域,特别涉及一种基于albert的中文电子简历命名实体识别 方法。

背景技术:

2.大数据和互联网技术的发展为人们的生活带来了便捷,网络招聘与在线简历投递已成为 当下人们寻求职务的主流方式,各大企业的人力资源部门会收到海量电子简历,如何快速高 效的从这些电子简历中提取出企业感兴趣的关键信息是一个亟待解决的问题。电子简历属于 文本信息,命名实体识别可以自动从大量的非结构化文本信息中抽取出事先定义好的实体类 型。不同于通用领域的实体识别只分辨出组织、时间和位置,电子简历信息中包含的实体类 型更丰富,且较为统一,实体识别难度更高。

3.目前电子简历命名实体识别(named entity recognition,ner)的研究方法主要有三种:基 于规则和词典匹配的方法、基于统计机器学习的方法以及基于深度学习的方法。基于规则和 词典匹配的方法是由领域专家设计实体抽取规则,然后根据规则生成涵盖实体的词典,进而 对文本中的实体进行抽取。该方法只要有完整合理的语言规则或词典,就能取得良好的效果。 基于统计机器学习的方法将ner任务转换为将简历中的实体分配特定类型标签。通过分析语 料库特点,人工选定特征建立统计学习模型,在大规模语料上进行训练来完成实体标注。常 用的统计学习模型有最大熵模型(maximum entropy model,mem)、隐马尔可夫模型(hiddenmarkov model,hmm)和条件随机场(conditional random field,crf)等。当下,深度学习方法 被广泛应用到命名实体识别任务中,其以低人工参与度和高识别准确率的优势迅速在ner任 务中占领了主要地位。其中,基于规则和词典匹配的方法依赖于专家经验,规则和词典的开 发不仅需要丰富的专业知识,而且极其耗时费力,在字典中完整列出所有规则或定义所有相 关实体概念也是相当困难的,这极大地限制了此类方法的识别效果和迁移能力;基于统计机 器学习的方法虽然能解决基于规则和词典匹配方法的问题,但仍旧需要准确的特征工程和庞 大的语料库;基于深度学习的bert模型仍存在一些弊端,其具有大量的模型参数,对于模型 训练,其有效性依赖于较大的数据量和较长的时间。在某些特定领域,文本数据获取困难, 标注成本大,bert模型的效果便不再理想。

技术实现要素:

4.为此,本发明提供一种基于albert的中文电子简历命名实体识别方法,使用较少的模 型参数和较短的训练时间达到更优的电子简历命名实体识别性能,便于实际场景应用。

5.按照本发明所提供的设计方案,提供一种基于albert的中文电子简历命名实体识别方 法,包含如下内容:

6.利用已训练的albert模型对输入的电子简历中文字符进行特征提取,将中文字符

映射 为融合字特征、位置特征和文本特征的字向量;

7.通过提取字向量序列中的上下文语义信息来获取电子简历特征矩阵;

8.学习特征矩阵中相邻标签之间的依赖关系,并通过设置标签之间转移的约束条件来获取 全局最优标签序列。

9.作为本发明基于albert的中文电子简历命名实体识别方法,进一步地,albert模型 包含字嵌入层和编码层,其中,针对输入的中文字符序列,字嵌入层通过查询词汇表将每个 字符转换为字向量,并利用文本向量区分不同句子,位置向量区分输入字符序列的时序性, 将字向量、文本向量和位置向量进行相加;并利用编码层对三向量相加的结果进行训练学习 获取融合字特征、位置特征和文本特征的字向量。

10.作为本发明基于albert的中文电子简历命名实体识别方法,进一步地,albert模型 采用o(v

×

h)

→

o(v

×

e+e

×

h)当h>>e的因式分解过程来设置字向量维度,其中,e表示字 向量大小,h表示隐藏层大小,v表示词汇表大小,模型参数规模由o(v

×

h)转换为 o(v

×

e+e

×

h)。

11.作为本发明基于albert的中文电子简历命名实体识别方法,进一步地,albert模型 中共享全连接层和注意力层的全部参数,其中,共享参数过程表示为 o(12

×

l

×h×

h)

→

o(12

×h×

h),l为隐藏层数量,h表示隐藏层大小。

12.作为本发明基于albert的中文电子简历命名实体识别方法,进一步地,albert模型 中利用注意力机制将每个字向量分解为q、k、v三个子向量,利用每个字符的q子向量与 上下文字符的子向量k、子向量v,通过子向量之间的点乘运算使字符融合上下文语义信息。

13.作为本发明基于albert的中文电子简历命名实体识别方法,进一步地,子向量之间的 点乘运算表示为attention(q,k,v)=softmax(qk

t

/d

k-1/2

)v,其中,dk表示字向量维。

14.作为本发明基于albert的中文电子简历命名实体识别方法,进一步地,albert模型 中利用多头注意力机制从不同角度计算输入中文字符之间的相似度,进而依据相似度来获取 每个中文字符的动态字向量。

15.作为本发明基于albert的中文电子简历命名实体识别方法,进一步地,利用bilstm 提取字向量序列中的上下文语义信息来获取电子简历特征矩阵;并通过条件随机场crf学习 特征矩阵中相邻标签之间的依赖关系来获取全局最优标签序列。

16.作为本发明基于albert的中文电子简历命名实体识别方法,进一步地,crf中,利用 标签转移矩阵来生成标签序列概率,并通过对标签序列概率进行归一化处理来获取标签序列 条件概率;对于给定的训练样本,利用训练样本的对数似然函数的最大化求解来获取输入中 文字符的最优标签序列。

17.作为本发明基于albert的中文电子简历命名实体识别方法,进一步地,训练样本p(y,x) 的对数似然函数表示为:其中,y′k表示预设标签组合中第 k个正确标签序列。

18.本发明的有益效果:

19.本发明利用albert模型来实现电子简历中文字符特征的提取,能够减少计算参数,加 快训练速度;并进一步利用bilstm提取上下文语义信息,通过crf学习标签之间以来关系 来获取全局最优标签序列,具有较好的鲁棒性和实用性。

附图说明:

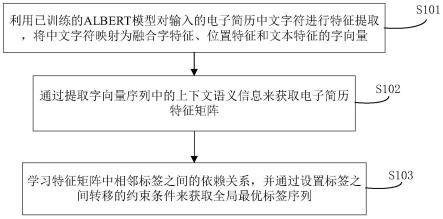

20.图1为实施例中基于albert的中文电子简历命名实体识别流程示意;

21.图2为实施例中albert嵌入层示意;

22.图3为实施例中整体模型框架示意;

23.图4为实施例中lstm单元结构示意。

具体实施方式:

24.为使本发明的目的、技术方案和优点更加清楚、明白,下面结合附图和技术方案对本发 明作进一步详细的说明。

25.针对现有电子简历实体识别准确率低,采用bert预训练语言模型虽能取得较高的准确 率,但bert模型参数量过大,训练时间长,其实际应用场景受限等的情形,本发明实施例, 参见图1所示,提供一种基于albert的中文电子简历命名实体识别方法,包含如下内容:

26.s101、利用已训练的albert模型对输入的电子简历中文字符进行特征提取,将中文字 符映射为融合字特征、位置特征和文本特征的字向量;

27.s102、通过提取字向量序列中的上下文语义信息来获取电子简历特征矩阵;

28.s103、学习特征矩阵中相邻标签之间的依赖关系,并通过设置标签之间转移的约束条件 来获取全局最优标签序列。

29.本案实施例中,利用albert模型来实现电子简历中文字符特征的提取,能够减少计算 参数,加快训练速度。

30.进一步地,albert模型包含字嵌入层和编码层,其中,针对输入的中文字符序列,字 嵌入层通过查询词汇表将每个字符转换为字向量,并利用文本向量区分不同句子,位置向量 区分输入字符序列的时序性,将字向量、文本向量和位置向量进行相加;并利用编码层对三 向量相加的结果进行训练学习获取融合字特征、位置特征和文本特征的字向量。

31.基于albert模型的字嵌入实现对语料集中字的向量化表达,参见图2所示,分为两个 部分:一部分为字嵌入层,即图中的x

t

→dt

;另一部分为transformer的编码层,即图中的 trm;字嵌入层首先通过查询词汇表将每个字符转换为字向量,即将文本序列表示为 x={x1,x2,

…

,xn},此外,还有文本向量和位置向量,文本向量用来区分输入的不同句话,分别 用0和1表示,位置向量表示输入序列的时序性,然后三特征向量相加形成d

t

,最后通过多 层transformer(trm)训练学习得到特征向量h

t

,h

t

融合了字特征、位置特征以及文本特征, 是充分学习了上下文信息的字向量。与现有bert模型相比,本案实施例中的albert可采 用嵌入向量参数因式分解、跨层参数共享等方法,能够进一步有效减少计算参数,加快训练 速度。

32.在bert模型中,词向量维度与隐藏层向量维度是相等的,但这种设置并不合理,词向 量仅包含词的信息,而隐藏层向量学习了上下文语义,融合了词向量特征、文本特征以及位 置特征,包含了更多的信息,且若训练词表过大,会造成模型达到数亿甚至数十亿的参数量, 这对硬件设备的计算能力是极高的挑战。因此,本案实施例中的albert模型采用因式分解 的方式来降低参数量,被映射到低维空间的one-hot向量通过高维矩阵分配到高维空间,如公 式(1)所示,以此来减少参数量。例如,在albert-base模型中,词向量大小等

于128,则总 参数量为12m,当词向量大小等于768时,bert-base的总参数量为108m。表1展示了在 进行嵌入向量参数因式分解后bert与albert不同版本下的参数量对比。

33.o(v

×

h)

→

o(v

×

e+e

×

h)当h>>e

ꢀꢀꢀꢀ

(1)

34.式中,e表示词向量大小,h表示隐藏层大小,v表示词表大小,模型参数规模由 o(v

×

h)转换为o(v

×

e+e

×

h),当h>>e时,参数量显著降低。

35.表1 bert和albert模型的参数分析

[0036][0037][0038]

进一步地,本案实施例中的albert采用跨层参数共享的方式来进一步减少参数量以及 提升模型稳定性。通过共享全连接层和注意力层的全部参数使训练速度大幅度提高,模型效 果稍有降低。如公式(2)所示。

[0039]

o(12

×

l

×h×

h)

→

o(12

×h×

h)

ꢀꢀꢀꢀꢀꢀꢀꢀ

(2)

[0040]

式中,l为隐藏层数量,共享隐藏层参数后,参数量从o(12

×

l

×h×

h)降为o(12

×h×

h)。

[0041]

为了弥补由于参数减少而造成的性能损失,本案实施例中的albert可将bert模型采 用的nsp(next sentence prediction)训练任务替换为sop(sentence-order prediction)。因为, nsp包含了主题预测和关系连贯性预测两个训练任务,主题预测较为简单,容易造成了下游 任务性能的降低。本案中的albert则只保留了关系连贯性预测,正样本和nsp任务中的 正样本相同,为同一篇文章中两个顺序相连的句子,负样本则通过调换正样本中两个句子的 顺序来获得。

[0042]

albert模型实为双向多层transformer的编码结构,transformer的核心为注意力机制, 首先将每个字向量分解为q(query),k(key),v(value)三个子向量,使每个字符的q 与上下文字符的k点乘,计算相似度权重,再点乘v,使该字符融合了上下文语义信息。具 体计算公式可如(3)所示。

[0043]

attention(q,k,v)=softmax(qk

t

/d

k-1/2

)v

ꢀꢀꢀ

(3)

[0044]

其中,q,k,v表示输入文本经过变换后的输入矩阵,dk表示字向量维度,为避免当字向 量维度过大时softmax操作后梯度变小的现象,使qk

t

的点乘结果除以缩放因子

[0045]

为了扩展模型关注不同位置的能力,可通过增加注意单元的“表示子空间”,transformer 采用“多头(multihead)”模式,公式如(4)和(5)所示:

[0046]

headi=attention(qw

iq

,kw

ik

,vw

iv

)

ꢀꢀꢀꢀꢀꢀꢀ

(4)

[0047]

multihead(q,k,v)=concat(head1,

…

,headk)woꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(5)

[0048]

式中,w

iq

、w

ik

、w

iv

分别表示第i个head的q、k、v,wo表示输出矩阵。

[0049]

进一步地,本案实施例中的albert通过transformer中的多头注意力机制从不同角度 计算输入字符之间的相似度,以此获得每个字符的动态词向量作为bilstm层的输入。

[0050]

参见图3所示,albert层的输入为n个字序列,在albert层将输入的每个字符映射 为字向量,通过对输入文本进行特征提取,输出为融合了字特征、位置特征和文本特征的字 向量h

t

;利用bilstm提取字向量序列中的上下文语义信息来获取电子简历特征矩阵;并通 过条件随机场crf学习特征矩阵中相邻标签之间的依赖关系来获取全局最优标签序列。其中, bilstm层为正向和反向的组合,字向量序列h

t

经 过该层提取出上下文语义信息,并得到特征矩阵p

t

;crf层通过学习标签之间的依赖关系, 为标签之间的转移添加约束条件,最终获取全局最优标签序列。

[0051]

为避免远距离依赖问题,本案实施例可采用双向lstm(long short-term memory,lstm) 网络学习上下文语义信息,lstm通过引入门的机制控制信息的记忆和遗忘比例。lstm的 隐藏层由特殊的存储单元组成。每个单元包含四个部分:循环记忆单元、处理输入信息的输 入门、控制输出信息的输出门和丢弃不重要信息的遗忘门。对于每个位置t,lstm用输入向 量h

t

和前一个状态p

t-1

计算当前隐藏状态p

t

。lstm单元结构如图4所示。其计算公式如式(6) ~式(11)所示:

[0052][0053][0054][0055][0056][0057][0058]

其中,分别表示t时刻的遗忘门、输出门、输入门和记忆单元状态。 为待学习的权重矩阵,bf,bo,bi,bc代表各个门控单元的偏 置向量。σ()和tanh()为不同神经单元的激活函数。

[0059]

在自然语言处理问题中,每个词都受到其前后词的影响,考虑文本的上下文信息对当前 词状态的判断具有重要意义。因此,本案实施例可采用bilstm进行特征提取。bilstm模 块可以同时考虑句子中每个字符的上下文信息,并将其结合起来,得到更全面的表示。bilstm 模块从嵌入层接收输入向量h=[h1,

…

,hn],进一步获取文本的序列信息,学习文本的上下文 特征,经过正向和反向对信息融合后,返回另一 个n维序列p=[p1,

…

,pn],与输入序列的每一步输入信息相对应。p

t

的最终表示如公式(12)所 示。

[0060][0061]

本案实施例中,进一步地,crf中,利用标签转移矩阵来生成标签序列概率,并通过对 标签序列概率进行归一化处理来获取标签序列条件概率;对于给定的训练样本,利用训练样 本的对数似然函数的最大化求解来获取输入中文字符的最优标签序列。

[0062]

crf层的作用为学习标签间的转移矩阵,降低错误标签出现的概率。bilstm层可以通 过softmax函数获取输入字符在各个标签类型下的得分,但是,softmax层输出的标签得分是 相互独立的,会出现一些非法的情况。例如,姓名的开头词b-name后面跟着籍贯的非开头 词i-loc等。crf层可以利用相邻标签之间的依赖信息进行句子级标签标注,通过添加标签 的转移分数矩阵计算出整体序列的最优解,得到全局最优标签。

[0063]

以序列p=[p1,p2,

…

,pn]为输入,crf层利用过去和未来标签预测出最可能的标签序列 y=(y1,y2,

…

,yn),定义转移矩阵其中l

ij

表示从标签i转移到标签j的概率,则产 生标记序列y=(y1,y2,

…

,yn)的概率为:

[0064][0065]

对于p(x,y)使用soft max函数做归一化,则得到标记序列y的条件概率为:

[0066][0067]

假设所有的标签组合为y,yj′

∈y表示y中第j个正确标签序列。则对于给定的训练样本p(y,x) 的对数似然为:

[0068][0069]

训练时通过使用维特比算法最大化对数似然函数得到针对输入序列x=(x1,x2,

…

,xn)的最优标签 序列:

[0070][0071]

除非另外具体说明,否则在这些实施例中阐述的部件和步骤的相对步骤、数字表达式和 数值并不限制本发明的范围。

[0072]

最后应说明的是:以上所述实施例,仅为本发明的具体实施方式,用以说明本发明的技 术方案,而非对其限制,本发明的保护范围并不局限于此,尽管参照前述实施例对本发明进 行了详细的说明,本领域的普通技术人员应当理解:任何熟悉本技术领域的技术人员在本发 明揭露的技术范围内,其依然可以对前述实施例所记载的技术方案进行修改或可轻易想到变 化,或者对其中部分技术特征进行等同替换;而这些修改、变化或者替换,并不使相应技术 方案的本质脱离本发明实施例技术方案的精神和范围,都应涵盖在本发明的保护范围之内。 因此,本发明的保护范围应所述以权利要求的保护范围为准。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1