一种基于无人机倾斜摄影3D模型的目标快速识别与标定方法

一种基于无人机倾斜摄影3d模型的目标快速识别与标定方法

技术领域

1.本发明涉及信息技术领域,具体为一种基于无人机倾斜摄影3d模型的目标快速识别与标定方法。

背景技术:

2.随着无人机、人工智能技术的日渐成熟,利用无人机拍摄的照片图像研究获取的视觉信息内容也日益丰富。传统方式上,通过无人机拍摄的大量二维照片,利用空三摄影测量建模方法,可以生成附带有高精度三维坐标信息的地理信息三维模型,实现对三维模型进行点、线、面、体的测量。利用无人机摄影技术可以生成大范围空间3d特定场景图。一类重要的应用是需要能够对场景图中的目标进行识别,并标定其位置和几何信息。

3.利用深度学习技术对无人机拍摄的2d图片进行车、房、树、人等物体的智能识别。,该技术虽然已经比较成熟,但是由于单帧2d图片仅仅是场景图的局部信息,并且其中的目标位置和几何信息无法直接标定,可视化效果差,无法满足行业需求。

4.而直接在3d模型数据中进行场景图目标识别与标定也存在较大的困难,通常3d模型是以3d点云数据来描述的,虽然3d点云模型能否覆盖全局的场景图,但由于三维模型在建模过程中存在模型重构,导致原有图像信息存在不同程度的丢失,影响识别效果,加上处理的数据量大,需要消耗大量的算力,时效上无法满足行业应用需求。

5.因此,需要建立一种混合机制的处理,能够利用在2d图片上的精确识别能力,融合3d模型上的坐标和几何尺寸信息,进而实现在3d全局场景图上的目标快速识别与标定方法。

技术实现要素:

6.(一)解决的技术问题

7.针对现有技术的不足,本发明提供了一种基于无人机倾斜摄影3d模型的目标快速识别与标定方法,解决了在大量大幅重叠度下的2d图片的快速目标识别、合并、拼接与统计;快速进行2d/3d坐标变换,对2d图片中的识别的目标,能够快速标定其位置和几何信息,并在3d模型中进行可视化展示的问题。

8.(二)技术方案

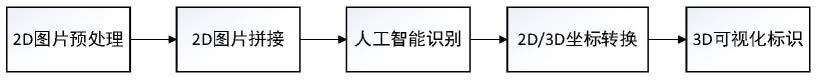

9.为实现上述目的,本发明提供如下技术方案:1.一种基于无人机倾斜摄影3d模型的目标快速识别与标定方法,包括以下步骤:

10.步骤一:2d图片预处理;

11.步骤二:2d图片拼接;

12.步骤三:人工智能识别;

13.步骤四:2d/3d坐标转换;

14.步骤五:3d可视化标识。

15.优选的,利用无人机拍摄的2d图片携带的三维坐标信息,结合重叠度对 2d图片进

行快速拼接处理,降低图片计算数据量,然后利用人工智能识别方法对感兴趣的图片内容进行智能识别,将2d图片识别结果的坐标信息通过坐标转换系统映射计算得到3d坐标值,在3d模型上标识出识别对象。

16.优选的,所述步骤一2d图片预处理的具体操作流程为:无人机在摄影测量拍摄定焦图片时,提前设置飞行区域、规划飞行路线,设定飞行重叠度,重叠度一般在70%以上才能在三维建模时得到比较好的结果,同时在采集数据时会利用北斗/gps的rtk或者ppk高精度定位系统,可得到拍摄图片时的高精度三维坐标,一般坐标系为wgs84。直接用拍摄的图片进行图像识别存在重复识别、识别速度慢的问题,本过程对图片携带的光点中心的高精度坐标进行处理,得到图片轨迹,利用轨迹中相邻最近的4张图片作为图片拼接的数据源,为图像拼接做拼接数据准备,直接利用三维坐标信息选取图片拼接顺序和拼接位置,避免出现图像拼接过程中进行逐一特征点获取匹配,然后才能选取最相近的图片进行拼接。

17.优选的,所述步骤二2d图片拼接的具体操作流程为:根据高精度三维坐标计算得到的4张拼接图片,将2d图片进行拼接合成处理,处理过程如下:输入合并图像-重叠区域计算-特征点提取-2d图像配准-投影变换-拼接计算

‑ꢀ

图像融合-生成图像。

18.优选的,所述步骤三人工智能识别的具体操作流程为:采用深度学习算法实现拼接后2d图片的智能识别,识别内容主要包括:树、农田、电线杠、池塘、汽车、房屋/地基、人、绿化带、人行道等;

19.深度学习的数据集采用现有的公开数据集如:ade20k、urban drone dataset(udd)、stanford drone dataset等进行预训练和粗调,再用无人机拍摄的图片进行增强后细调;

20.图像处理采集全景分割算法,采用transformer和多层感知机mlp解码的方式实现的开源的segformer分割算法。

21.优选的,所述步骤四2d/3d坐标转换的具体操作流程为:将人工智能图像识别的像素坐标,与物理世界的三维坐标建立快速转换模型,转换过程如下:像素坐标-图像坐标-相机坐标-wgs84坐标。

22.(三)有益效果

23.与现有技术相比,本发明提供了一种基于无人机倾斜摄影3d模型的目标快速识别与标定方法,具备以下有益效果:

24.1、该基于无人机倾斜摄影3d模型的目标快速识别与标定方法,1.降低图像拼接、识别计算数据量,提高计算识别速度,2.实现从2d识别到3d 显示的效果好的位置标定与快速可视化显示。

25.2、该基于无人机倾斜摄影3d模型的目标快速识别与标定方法,直接用拍摄的图片进行图像识别存在重复识别、识别速度慢的问题,本过程对图片携带的光点中心的高精度坐标进行处理,得到图片轨迹,利用轨迹中相邻最近的4张图片作为图片拼接的数据源,为图像拼接做拼接数据准备,直接利用三维坐标信息选取图片拼接顺序和拼接位置,避免出现图像拼接过程中进行逐一特征点获取匹配。

26.3、该基于无人机倾斜摄影3d模型的目标快速识别与标定方法,图像特征点提取是利用图片的特征描述子进行匹配,进一步找到不同图片中提取到的相同的特征点。使用opencv中内集成的surf/orb图像处理模块提取特征点,也可用用sift算法提取出一个128

维的向量作为拼接合并的特征点,通过计算欧式距离判断两个图片特征点是否匹配,匹配更加准确。

27.4、该基于无人机倾斜摄影3d模型的目标快速识别与标定方法,采用 ransac算法进行求解图像配准的单应性矩阵。如果图像拼接会造成误差的累积,可使用光束平差法进行联合优化,可以优化多个相机参数,进而得到更准确的图像位置。

附图说明

28.图1为本发明识别与标定方法流程图;

29.图2为本发明2d图片拼接处理过程图;

30.图3为本发明se-yolov5算法网络架构图;

31.图4为本发明2d/3d坐标转换过程图;

32.图5为本发明实施例数据图表;

33.图6为本发明离散图像点值与其在图像中位置的关系坐标图;

34.图7为本发明相机坐标关系图;

35.图8为本发明从相机坐标转换到wgs84坐标属于坐标的刚性变换图。

具体实施方式

36.下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

37.请参阅图1-4,一种基于无人机倾斜摄影3d模型的目标快速识别与标定方法,步骤一:2d图片预处理,无人机在摄影测量拍摄定焦图片时,提前设置飞行区域、规划飞行路线,设定飞行重叠度,重叠度一般在70%以上才能在三维建模时得到比较好的结果,同时在采集数据时会利用北斗/gps的rtk或者ppk高精度定位系统,可得到拍摄图片时的高精度三维坐标,一般坐标系为wgs84,直接用拍摄的图片进行图像识别存在重复识别、识别速度慢的问题,本过程对图片携带的光点中心的高精度坐标进行处理,得到图片轨迹,利用轨迹中相邻最近的4张图片作为图片拼接的数据源,为图像拼接做拼接数据准备,直接利用三维坐标信息选取图片拼接顺序和拼接位置,避免出现图像拼接过程中进行逐一特征点获取匹配,然后才能选取最相近的图片进行拼接。

38.步骤二:2d图片拼接,根据高精度三维坐标计算得到的4张拼接图片,将2d图片进行拼接合成处理,处理过程如图2所示,利用无人机飞行规划设定的拍摄图像重叠度,将合成的图片按照拍摄时间与拍摄的三维高精度位置计算相邻图片,确定合成拼接区域,为保障在后续图片计算资源消耗与合成拼接精度的均衡要求,加上无人机在飞行过程中受风速、气压等因素存在相机抖动问题,造成图片重叠度不是100%精准,所以在利用重叠度计算拼接区域时,保留一部分重叠区域,不能严格按照飞机飞行设定的重叠度进行截取拼接。

39.图像特征点提取是利用图片的特征描述子进行匹配,进一步找到不同图片中提取到的相同的特征点,使用opencv中内集成的surf/orb图像处理模块提取特征点,也可用用sift算法提取出一个128维的向量作为拼接合并的特征点,通过计算欧式距离判断两个图

片特征点是否匹配。

40.2d图像配准是利用得到的匹配对之后,可得到匹配对图像的相对位置,因飞机飞行高度不能保持绝对一致,需要计算拼接的两幅图片的相对位置变换,利用4个匹配点,要求任意三个不共先,采用ransac算法进行求解图像配准的单应性矩阵,如果图像拼接会造成误差的累积,可使用光束平差法进行联合优化,可以优化多个相机参数,进而得到更准确的图像位置。

41.图像投影是在得到相机的相对位置,为保证拼接图像一致连贯性,使用 opencv中的映射变换算法,可得到平面投影、柱面投影、球面投影、鱼眼投影和立方体投影,其中要把设置映射的尺度设定为相机的焦距。

42.图像拼接是在得到相邻两幅图像的拼缝位置后,在拼缝附近的若干个像素使用融合算法,对于重叠区域中远离拼缝的位置只选择一侧的图像,可以有效的去除图像之间的错位、伪像,拼接的接缝算法可选用opencv中的逐点法,动态规划法和图割法等实现。

43.图像融合是利用opencv中的羽化融合和拉普拉斯融合算法,羽化融合是对拼缝附近的位置根据与接缝的距离求出权重,加权融合,而拉普拉斯融合算法相当于求出图像不同频率的分量,然后按频率进行融合。

44.步骤三:人工智能识别

45.无人机航拍图像存在动态范围大、背景复杂、环境光复杂等问题,传统计算机视觉算法难以实现鲁棒的检测,采用深度学习算法实现拼接后2d图片的智能识别,识别内容主要包括:树、农田、电线杠、池塘、汽车、房屋/地基、人、绿化带、人行道等。

46.深度学习的数据集采用现有的公开数据集如:ade20k、urban dronedataset(udd)、stanforddronedataset等进行预训练和粗调,再用无人机拍摄的图片进行增强后细调。

47.图像处理采集全景分割算法,采用transformer和多层感知机mlp解码的方式实现的开源的segformer分割算法。

48.图像目标识别检测算法使用以yolov5作为基准,对其进行改进形成se-yolov5目标检测算法,算法网络架构如图3所示。

49.se-yolov5是将(squeeze-and-excitation,se)通道注意力机制引入 yolov5后形成的目标检测算法,相比于yolov5,精度有上升,整体架构采用 darknet作为backbone层,特征金字塔网络fpn作为neck层,卷积作为head 层,内部采用空间注意力focus、跨阶段局部网络csp、金字塔池化spp、特征聚合网络panet等技术增强层间、通道间、阶段间的信息流动,减少模型参数量,最终实现快速、鲁棒的检测和识别。

50.步骤四:2d/3d坐标转换,地球上的物体都有一个三维坐标成为三维世界坐标系统,常用的是wgs84坐标系,无人机在拍摄的时候相机有个高精度三维坐标值是相机的光中心位置,同时相机也有一个相机坐标系,光通过相机镜头有个图像坐标系统,拍摄成的图片有个像素坐标系统,做人工智能图像识别时主要使用的是像素坐标,其与物理世界的三维坐标需要建立快速转换模型,转换过程如图4所示。

51.素坐标是数字化图片在计算机存储的离散图像点值与其在图像中位置的关系坐标,通常用坐标系u-v标识,其原点为图像的左上角;图像坐标是指拍摄的物体在照片中的位置坐标,用x-y标识,其关系如图6所示:

[0052][0053]

(u0,v0)是坐标变换变换对应的常数,同样的可得到:

[0054]

x=udx-u0dx y=vdy-v0dy

[0055]

相机坐标是以摄像机光心为原点的三维坐标,其中z轴指向相机前方,即为垂直于成像面,坐标关系如图7所示:

[0056]

f为相机焦距,转换关系如下:

[0057]

x=fxc/z

c y=fyc/zc[0058]

同样反算即可得到:

[0059]

xc=xzc/f yc=yzc/f

[0060]

从相机坐标转换到wgs84坐标属于坐标的刚性变换,是坐标系进行旋转、平移即可,其坐标关系如图8所示:

[0061]

其中(x,y,z)指wgs84坐标系,如果相机坐标系只绕x轴旋转,旋转角度为θ,则可得到:

[0062]

xc=x yc=ycosθ+zsinθ zc=zcosθ-ysinθ

[0063]

同样的方法可以得到围绕y轴和z轴旋转一定角度的公式,综合得到相机坐标和wgs84坐标转换公式。

[0064]

将识别得到的结果的2d像素坐标经过坐标变换后,可直接得到3d坐标值,直接在3d模型上进行框选展示,实现高精度识别与高质量可视化展示。

[0065]

实施例

[0066]

以处理无人机飞行1个架次拍摄的500张照片为例,采用相同的人工智能识别算法,使用相同配置的计算机,照片像素为5472*3648,水平分辨率 72dpi,垂直分辨率72dpi,位深度24,分辨率单位2,颜色表示srgb,相机光圈值f/3.2,数据大小为4.10gb(4,412,289,847字节),具体如下如图 5,重叠度以80%为例。

[0067]

尽管已经示出和描述了本发明的实施例,对于本领域的普通技术人员而言,可以理解在不脱离本发明的原理和精神的情况下可以对这些实施例进行多种变化、修改、替换和变型,本发明的范围由所附权利要求及其等同物限定。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1