一种自适应图像融合数据增强的目标检测方法

1.本发明涉及图像检测技术领域,更具体的说是涉及一种自适应图像融合数据增强的目标检测方法。

背景技术:

2.高原鼠兔目标检测是对其进行种群数量统计及研究种群动态变化的基础。自然场景下的高原鼠兔图像目标尺寸小、特征不显著、背景复杂、且毛色呈现保护色,目标颜色与背景颜色相近,使得传统目标检测算法难以对其准确检测。基于深度卷积神经网络dcnn(deep convolutional neutral network,dcnn)的目标检测模型能够提取目标深层次的特征,深层次特征的提取对目标检测有利,而基于dcnn的目标检测模型需要大量的训练数据,训练数据缺乏会导致模型的检测性能下降,甚至出现过拟合的现象。自然场景下的高原鼠兔多分布于高原山地,图像采集困难,从而使得基于dcnn的高原鼠兔目标检测模型训练数据缺乏。

3.数据增强是解决训练数据缺乏的有效方法。图像数据增强通常使用图像变换、重采样等方法扩大训练数据集规模,使模型全面地学习数据特征,从而降低模型过拟合。图像变换是一种常用的数据增强方法,通常采用图像的仿射、扭曲和随机剪切等变换来扩大数据集。在目标检测领域,cutout、random erasing、ricap(random image cropping and patching)及mosaic是常用图像变换数据增强方法。cutout不仅使模型学习样本的局部特征,而且还能学习样本的全局特征,但cutout直接用0像素填充剪切区域,使图像中的有用信息丢失。random erasing随机选择图像中的矩形区域,用[0,255]之间的随机值替换选中的矩形区域像素值,生成不同遮挡等级的训练数据,从而扩大训练数据集。ricap随机选择4张图像,并从4张图像中分别剪切部分区域拼合成1张新图像,借助鲁棒性较好的低级特征(线、边缘等)扩大数据集,能够有效解决模型训练时偏向于学习局部特征而引起的过拟合。mosaic随机选择4张图像,对其分别做翻转、缩放和色域变换,将变换后的图像按上下左右的位置拼合成新图像,从而丰富了图像背景。虽然上述基于图像变换的数据增强方法能够扩大数据集规模、实现也较为简单,但容易造成目标信息的丢失,尤其对小目标信息的丢失更为严重。同时,上述基于图像变换的数据增强方法生成的新图像与原始图像数据信息相同,对数据集泛化能力提升有限,因而对模型检测性能的提升有限。

[0004]

基于深度学习的数据增强方法通常使用生成模式生成新图像,用于扩大训练数据集规模。由于生成对抗网络gan(generative adversarial networks,gan)能够很好地学习训练数据集的分布模式,生成与训练数据集同分布的新图像,因此在植物识别、建筑器械识别及公路损坏识别等领域得到了广泛的应用。zhu等人在花卉活力等级识别中使用改进的dcgan(deep convolutional generative adversarial network,dcgan)生成不同活力等级的花卉图像,并将生成的图像添加到原始训练集中训练花卉活力等级识别模型,与未使用数据增强方法训练的识别模型相比,使用数据增强方法训练的识别模型的f1(f1-score)值提升了23.43%。madsen等人在植物幼苗识别中,使用gan生成植物幼苗图像,用于扩大训

练数据集规模,对植物幼苗识别的准确率达到了68.1%。seongdeok等人在工地设备目标检测中,首先将图像中的目标提取出来并进行图像变换,其次对提取目标后的背景使用gan补全,最后将变换后的目标与补全的背景使用逐像素相加的方法融合得到新图像,用于扩大训练集规模,与未使用数据增强训练的检测模型相比,使用gan数据增强方法训练的检测模型的f1值提高了18.41%。ze等人在少样本的松果检测中,首先将松果从原始图像中剪切出来,其次使用剪切的松果图像训练began(boundary equilibrium generative adversarial network),之后使用began生成的松果图像直接替换原始图像中的松果目标,最后将生成的新图像添加到训练集中得到增强数据集训练目标检测模型,与未使用数据增强方法增强的数据集训练的检测模型相比,使用数据增强方法增强的数据集训练的检测模型ap(average precision,ap)值提高了0.9%。虽然现有技术中所提出的基于gan的数据增强方法在一定程度上提高了数据集的多样性和泛化能力,但gan生成的目标图像和背景图像融合生成新图像时采用逐像素相加或直接像素替换的融合方法会造成新图像目标边界突出,对检测模型具有较大的迷惑性,导致检测模型在训练过程中学习到的是新图像的目标边缘特征,而不是新图像的目标整体特征,导致模型查准率下降。同时,当被融合的前景目标图像和背景图像颜色差异较大时,这种数据融合方法会产生颜色与实际场景不符的目标。

[0005]

为了有效解决基于gan的数据增强方法中得到的新图像目标边界突出、目标颜色与实际场景不符的问题,本发明提出了一种基于多尺度梯度生成对抗网络msg-gan(multi-scale gradients for generative adversarial networks,msg-gan)的自适应图像融合数据增强方法,以解决基于dcnn的目标检测模型训练数据缺乏的问题。

技术实现要素:

[0006]

有鉴于此,本发明提供了一种自适应图像融合数据增强的目标检测方法,以达到丰富训练数据、提高目标图像与背景图像融合度的目的。

[0007]

为了实现上述目的,本发明采用如下技术方案:

[0008]

一种自适应图像融合数据增强的目标检测方法,具体步骤包括:

[0009]

对原始训练集进行图像提取,获得第一目标图像;

[0010]

对所述第一目标图像进行尺寸调整,获得第二目标图像;

[0011]

多尺度梯度生成对抗网络将所述第二目标图像生成为第三目标图像;

[0012]

提取所述第三目标图像和所述原始训练集中的第一背景图像,利用颜色直方图自适应地根据相似度阈值对所述第三目标图像和所述第一背景图像进行判断,得到满足阈值要求的第四目标图像和第二背景图像;

[0013]

使用泊松融合算法对所述第四目标图像和所述第二背景图像进行融合得到新图像;

[0014]

将所述新图像加入到所述原始训练集得到增强训练集;

[0015]

目标检测模型调取所述增强训练集的图像以检测图像中的目标。

[0016]

所述图像提取的具体内容为:

[0017]

通过剪切在大小为m

×

n的图像中提取出大小为p

×

q的所述第一目标图像。

[0018]

所述尺寸调整的具体内容为:

gradients for generative adversarial networks,msg-gan)的自适应图像融合数据增强方法,以解决基于dcnn的目标检测模型训练数据缺乏的问题。

附图说明

[0041]

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据提供的附图获得其他的附图。

[0042]

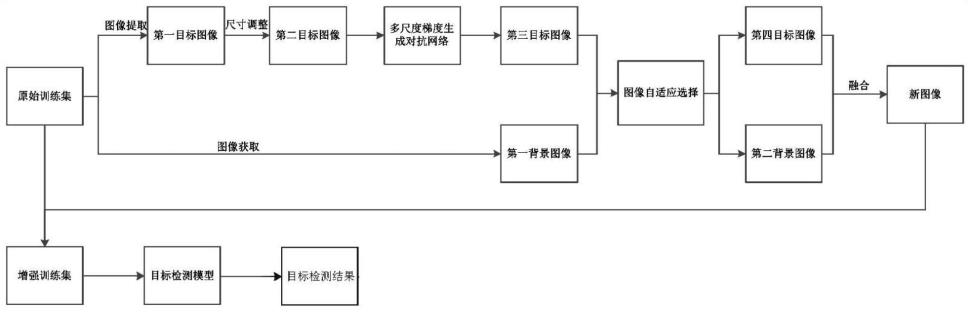

图1为本发明提供的一种自适应图像融合数据增强的目标检测方法流程图;

[0043]

图2为本发明的高原鼠兔目标检测模型结构示意图;

[0044]

图3为本发明的前景目标提取示意图;

[0045]

图4为本发明的基于stylegan的msg-gan结构示意图;

[0046]

图5为本发明的前、背景图像的直方图;

[0047]

图6为本发明的前、背景图像泊松融合示意图;

[0048]

图7为本发明的msg-gan训练时fid值的变化示意图;

[0049]

图8为msg-gan生成高原鼠兔目标图像,其中8(a)所示为用于训练msg-gan的原始目标图像,8(b)所示为msg-gan生成的64x64分辨率大小的高原鼠兔图像、8(c)所示为msg-gan生成的128x128分辨率大小的高原鼠兔图像、8(d)所示为msg-gan生成的图像256x256分辨率大小的高原鼠兔图像;

[0050]

图9为本发明的增强的高原鼠兔图像示意图;

[0051]

图10为本发明的不同训练样本下检测模型的ap值示意图;

[0052]

图11为本发明的不同增强方法对模型ap的影响示意图;

[0053]

图12为本发明测试集目标检测示例示意图,12(a)所示为未进行数据增强的目标检测结果,12(b)所示为本技术目标检测结果。

具体实施方式

[0054]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0055]

faster r-cnn具有结构相对简单、鲁棒性好的特点,但其目标检测的性能依赖于大规模的训练数据,训练数据缺乏会导致模型检测性能降低,甚至出现过拟合的现象。而自然场景下的高原鼠兔目标检测,训练数据不足,严重影响了模型的检测性能。针对目标检测模型缺乏训练数据的问题,基于gan的图像数据增强是有效的解决方法之一,但采用gan生成的目标图像与背景图像融合时,存在新图像目标边界突出、目标颜色与实际场景不符的问题,导致这种融合方法增强的数据集多样性和泛化能力不强,从而影响模型检测性能的提升。为了有效增强目标检测训练数据集,提升基于dcnn的目标检测模型的精度,本实施例提出了一种基于msg-gan的自适应图像融合数据增强方法。

[0056]

参照图1所示,本发明公开了一种自适应图像融合数据增强的目标检测方法,具体

包括以下步骤:

[0057]

对原始训练集进行图像提取,获得第一目标图像;

[0058]

对第一目标图像进行尺寸调整,获得第二目标图像;

[0059]

多尺度梯度生成对抗网络将第二目标图像生成为第三目标图像;

[0060]

提取第三目标图像和原始训练集中的第一背景图像,利用颜色直方图自适应地根据相似度阈值对第三目标图像和第一背景图像进行判断,得到满足阈值要求的第四目标图像和第二背景图像;

[0061]

使用泊松融合算法对第四目标图像和第二背景图像进行融合得到新图像;

[0062]

将新图像加入到原始训练集得到增强训练集;

[0063]

目标检测模型调取增强训练集的图像以检测图像中的目标。

[0064]

进一步的,参照图3所示,图像提取的具体内容为:

[0065]

通过剪切在大小为m

×

n的图像中提取出大小为p

×

q的第一目标图像。

[0066]

再进一步的,参照图3所示,尺寸调整的具体内容为:

[0067]

将第一目标图像的尺寸从p

×

q调整为目标尺寸。目标尺寸为固定的像素大小,比如固定为64

×

64,128

×

128,256

×

256。

[0068]

在目标检测任务中,目标在图像中的占比较低,导致gan难以直接生成目标图像。本实施例首先从m

×

n大小的高原鼠兔图像中通过剪切方式提取出大小为p

×

q的目标图像,并将目标图像的尺寸调整到固定的大小,以便采用gan直接生成目标图像。图3是本实施例方法对目标图像提取的示例。

[0069]

进一步的,参照图4所示,多尺度梯度生成对抗网络由基于stylegan的生成网络和判别网络组成;初始多尺度梯度生成对抗网络将第二目标图像生成为第三目标图像的具体内容为:

[0070]

使用第二目标图像对判别网络进行训练;

[0071]

使用生成网络将第二目标图像生成为第三目标图像,将第三目标图像输入判别网络进行真假识别,并将结果反馈至生成网络,生成网络根据反馈的信息进行更新。

[0072]

gan由生成网络g(generative model,g)和判别网络d(discriminative model,d)组成,gan能够实现无监督的图像生成任务,但当真实图像和生成图像的分布重叠较低时,会使判别网络流向生成网络的梯度信息减少,导致gan网络不能稳定训练和难以适应不同分布的数据集。针对此问题,karnewar等人提出了msg-gan,由基于stylegan的生成网络和判别网络组成,网络在训练中不仅使用生成网络和判别网络的最终输出结果进行训练,而且还使用每个阶段的输出结果进行训练,使得判别器流向生成器的梯度信息增多,从而稳定网络的训练,提高网络对不同数据集的适应度。鉴于msg-gan的上述优点,本实施例采用图4所示的msg-gan来生成新的目标图像。首先使用提取的目标图像对判别网络进行训练;然后使用生成网络生成新的目标图像,将生成的新目标图像输入判别网络进行真假识别,并将结果反馈至生成网络,生成网络根据反馈信息进行更新;如此反复进行,直至生成网络和判别网络达到纳什均衡。在达到纳什均衡后,生成网络的性能达到最优,网络参数基本不再更新,此时,经过训练的msg-gan生成的新目标图像与训练数据中的原始目标图像分布基本一致。

[0073]

进一步的,参照图4所示,获取第四目标图像和第二背景图像的具体内容为:

[0074]

第一背景图像和第三目标图像对应的第一目标图像为原始训练集中随机选取的图像;

[0075]

并分别计算第一背景图像、第三目标图像的颜色直方图;

[0076]

根据定义式(1)来判别第三目标图像和第一背景图像之间的颜色相似度;

[0077]

当相似度大于等于给定的阈值t时,则认为第三目标图像和第一背景图像颜色相近,将第三目标图像输出为第四目标图像,将第一背景图像输出为第二背景图像;

[0078]

当第一背景图像、第三目标图像相似度小于给定的阈值t时,则重新进行随机选择,直至相似度大于等于t;

[0079][0080]

式(1)中,x和y表示待判别的两副图像,k代表图像的特征取值,xk和yk表示直方图中特征k的个数,l表示特征取值的个数。

[0081]

进一步的,参照图5所示,颜色直方图的计算方法为:

[0082]

采用彩色图像的r、g、b三个分量提取第三目标图像和第一背景图像的颜色直方图。

[0083]

基于gan的数据增强方法在生成新的图像数据时,通常将gan生成的新目标图像与背景图像融合来得到新图像。在新目标图像与背景图像融合时,往往会出现被融合的目标图像和背景图像之间的颜色差异过大的问题,从而导致融合后的新图像会出现目标颜色与实际场景不符的问题,使得目标检测模型在训练时学习到的是与实际场景颜色不符的目标特征,对检测模型有较大的迷惑性。而颜色直方图作为图像直方图的一种,能反映颜色信息在颜色空间的分布情况,具有旋转不变性和尺度不变性,因此可以用来区分图像在颜色分布上的差异性。为了减小融合后的新图像中目标和背景之间的颜色差异,本实施例使用颜色直方图自适应地选择颜色相近的目标图像和背景图像进行融合,提升新图像与真实场景的一致性。

[0084]

本实施例采用彩色图像的r、g、b三个分量提取被融合的目标图像和背景图像的颜色直方图,并定义式(1)来判别两幅图像之间的颜色相似度。式(1)中x和y表示待判别的两副图像,k代表图像的特征取值,xk和yk表示直方图中特征k的个数,l表示特征可取值的个数。图5为随机选取的一张目标图像和一张背景图像的颜色直方图。

[0085]

为了自适应地选择颜色相近的目标图像和背景图像,本实施例首先随机选取一张前景目标图像和一张背景图像,并分别计算颜色直方图;然后根据式(1)计算两幅图像的相似度,当相似度大于等于给定的阈值t时,则认为两张图像颜色相近,相反,当相似度小于t时,则重新进行选择,直至相似度大于等于t;最后,将满足条件的前景图像和背景图像采用泊松图像融合的方法进行融合。在实际应用中,为了避免算法陷入死循环,可设置选择次数为n时,达到自适应选择结束条件;同时,将原始训练集中的图像作为背景图像生成新图像是对原始图像的重采样操作,过度的重采样会导致训练模型过拟合,为此,通过设置适当的重采样率r来避免过度重采样。

[0086]

进一步的,对目标图像或背景图像的r、g、b三个分量提取并进行对比的过程具体包括以下步骤:

[0087]

s1:基于读取的第一背景图像的标准图像生成标准色调直方图,并对标准色调直

方图进行平滑降噪处理,得到优化的标准色调直方图;

[0088]

s2:根据预设的阈值参数调整优化的标准色调直方图,得到优化的标准色调直方图的高阈值曲线及低阈值曲线;

[0089]

s3:基于读取的第三目标图像生成待检色调直方图,并对所述待检色调直方图进行平滑降噪处理,得到优化的待检色调直方图;

[0090]

s4:将所述待检色调直方图与所述高阈值曲线及所述低阈值曲线进行差异性度量,得到超差色调数目;

[0091]

s5:根据所述超差色调数目输出第三目标图像和第一背景图像之间的颜色差异。

[0092]

进一步的,获取第四目标图像和第二背景图像的具体步骤还包括:

[0093]

设置随机选择次数为n时,达到自适应选择结束条件,结束自适应选择,得到次选择中相似度最高的第四目标图像和第二背景图像。

[0094]

进一步的,参照图6所示,获取第四目标图像和第二背景图像的具体步骤还包括:

[0095]

设置适当的重采样率r避免过度重采样。

[0096]

进一步的,融合得到新图像的具体步骤为:

[0097]

在第二背景图像中随机地选取与第四目标图像的融合区域,并记录融合区域的位置信息和第四目标图像的边界信息,避免被融合的第四目标图像与第二背景图像中的融合区域的原始目标图像重合;

[0098]

使用梯度算子计算融合区域的梯度,得到融合区域的梯度场;

[0099]

根据梯度场引导的插值计算方法,计算融合区域的像素值,实现第四目标图像和第二背景图像的无缝融合。

[0100]

gan生成的目标图像与背景图像融合生成新图像时,通常采用逐像素相加或直接像素替换的方法,这种融合方法会造成新图像目标边界突出,使得目标检测模型在训练时学习到的是目标的边界特征,而不是目标的整体特征,对检测模型同样具有较大的迷惑性。而泊松融合算法通过构造泊松方程求解最优值,在保留原图像梯度信息的同时,能够实现目标边界与背景的无缝融合。因此,本实施例使用泊松融合算法对自适应选取的目标图像和背景图像进行融合。首先,在背景图像中随机地选取前景图像的融合区域,并记录融合区域的位置信息和前景图像的边界信息,避免被融合的前景图像在背景图像中与原始目标图像区域重合;其次,使用梯度算子计算融合区域的梯度,得到融合区域的梯度场;最后,根据梯度场引导的插值计算方法,计算融合区域的像素值,实现前景目标图像和背景图像的无缝融合。图6是本实施例图像融合过程的示例。

[0101]

进一步的,目标检测方法为:

[0102]

在增强训练集中获取待检测图像;其中,待检测图像中包括待检测目标。

[0103]

将待检测图像输入目标检测dcnn模型,根据待检测图像的图像特征确定待检测目标在待检测图像中位置。

[0104]

其中,目标检测dcnn模型为通过以下步骤生成的:

[0105]

获取初始目标检测dcnn模型及多个图像样本;其中,每个图像样本中包括目标对象。

[0106]

标记目标对象在每个图像样本中的位置,得到每个图像样本对应的标记矩形框;

[0107]

基于标记矩形框在图像样本的图像坐标系中的位置,以及预设复数平面坐标系,

确定每个图像样本对应的真值向量(x*,y*,w*,h*,α*,β*);

[0108]

其中,(x*,y*)为图像坐标系中标记矩形框中心点的坐标,w*为标记矩形框的长度,h*为标记矩形框的宽度,(α*,β*)为目标对象的朝向与预设复数平面坐标系中单位圆交点的坐标。

[0109]

标记目标对象的类型得到标记类型,并将标记类型及真值向量确定为每个图像样本对应的标定标签;

[0110]

将每个图像样本输入初始目标检测dcnn模型,根据每个图像样本的图像特征进行检测,得到每个图像样本包括的目标对象的预测类型及预测向量,作为每个图像样本的预测标签;

[0111]

基于预测标签及对应的图像样本的标定标签的差异,调整初始目标检测dcnn模型的参数,直到初始目标检测dcnn模型收敛,停止训练,得到目标检测dcnn模型。

[0112]

在一个具体实施例中,对本技术目标检测结果同未进行数据增强的目标检测结果进行比较,具体内容如下:

[0113]

1.实验数据及平台

[0114]

实验数据为课题组在青藏高原东北部(东经101

°

35

ˊ

36

″

~102

°

58

ˊ

15

″

,北纬33

°

58

ˊ

21

″

~34

°

48

ˊ

48

″

)甘南草原采集的高原鼠兔图像,总共1000张,按8:2的比例划分为训练集和测试集。数据集格式与pascal voc数据集格式一致。实验在挂载nvidia tian v和nvidia geforce 2080ti的图形操作站上完成,操作系统是ubuntu lts 16.04,深度学习框架为pytorch1.1和tensorflow1.14,使用python3.5.2编程。

[0115]

2.msg-gan生成高原鼠兔目标图像

[0116]

本实施例在训练msg-gan时,首先从训练集中裁剪出目标图像,并将其尺寸分别调整到64x64、128x128和256x256分辨率的大小,然后使用尺寸调整后的图像训练msg-gan。图7为对msg-gan训练时fid(frechet

′

inception distance,fid)值随迭代次数的变化,随着迭代次数的增加,模型的fid也随之降低,这表明msg-gan可以学习训练数据的分布模式。图8(a)所示为用于训练msg-gan的原始目标图像,图8(b)、8(c)和8(d)所示为msg-gan生成的64x64、128x128和256x256分辨率大小的高原鼠兔图像。从图8可以看出,msg-gan可以生成高原鼠兔目标图像,且生成的新目标图像在目标形态、姿态等方面与原始图像相比均有一定的变化,这表明msg-gan可以生成新的目标图像,因而可以丰富高原鼠兔训练集的多样性,进而提高训练数据集的泛化能力。此外,从图8可知,分辨率为64x64时生成的图像质量更高、目标形态轮廓也更加清晰,这是由于自然场景下的高原鼠兔图像目标尺寸小,原始数据集中的目标尺寸普遍在64x64左右。

[0117]

图9所示为采用颜色直方图自适应选择目标图像和背景图像后,对所选择的图像采用泊松融合生成的新图像,从图9可以看出,新图像目标边界过渡平滑,无明显的突出边界,这是因为本实施例采用的泊松融合方法,不仅能够有效保留原目标图像的梯度信息,而且还能够实现目标边界与背景图像的无缝融合。同时,新图像的目标颜色和背景颜色相近,这是因为本实施例采用颜色直方图,自适应地选取颜色相近的目标图像和背景图像进行融合,避免了被融合的目标图像和背景图像颜色差异较大而产生颜色与实际场景不符目标的问题。

[0118]

3.高原鼠兔目标检测

[0119]

为了说明本实施例所提出的数据增强方法的有效性,本实施例用增强后的数据集对高原鼠兔目标检测模型进行训练,通过模型的检测性能来对比分析数据增强方法的性能。首先,在原始数据集上对高原鼠兔目标检测模型进行训练,然后用训练后的模型对高原鼠兔进行检测,之后采用本实施例所提出的数据增强方法对原始训练数据进行增强,得到增强数据集后对目标检测模型进行训练并对高原鼠兔进行检测,并对检测性能进行对比分析。

[0120]

3.1原始数据集上的目标检测结果

[0121]

本实施例使用平均精度ap(average precision,ap)评估模型的检测性能。当训练样本数为100时,模型的ap值为37.14%,当训练样本数为800时,模型的ap值为86.5%,这表明了基于dcnn的目标检测模型随训练样本数的增加,模型的检测精度也相应提高。

[0122]

3.2增强数据集上的目标检测结果

[0123]

采用本实施例一中1.1~1.4的方法对原始训练集进行数据增强后,将增强数据添加到原始训练集中,得到增强训练集,并在增强训练集上对目标检测模型训练。在实验时,将t、n和r的值分别设置为0.5、100和2。

[0124]

为了说明本实施例数据增强方法的有效性,将本实施例提出的数据增强方法增强后的数据集训练的高原鼠兔目标检测模型与cutout方法、random erasing方法、kinstal的方法和maeda的方法增强后的数据集训练的高原鼠兔目标检测模型的检测性能进行对比分析,结果如图11所示。

[0125]

从图11可知,本实施例数据增强方法训练的检测模型的ap值为89.3%,分别高出未数据增强模型、cutout、random erasing和kinstal的方法训练的检测模型2.8%、2.1%、1.4%、1.4%和2%,这是因为本实施例数据增强方法不仅扩大了训练数据集规模,同时因为使用msg-gan生成了与原始训练集同分布的高原鼠兔图像,提高了数据集的多样性和泛化能力,进而提高了模型的泛化能力。本实施例数据增强方法和maeda的方法相比,尽管都采用生成对抗网络生成目标图像和采用泊松融合算法融合目标图像和背景图像,但本实施例数据增强方法在融合msg-gan生成的目标图像和背景图像时,采用颜色直方图对前景目标图像和背景图像的颜色相似度进行判别,选择颜色差异小的前景目标图像和背景图像进行融合,生成了与真实场景一致的新图像,进一步提升了新图像的质量。

[0126]

图12是高原鼠兔目标检测的示例,从图12可知,在原始训练集上训练的目标,检测模型将石块误检成了高原鼠兔目标,图12(a)所示为未进行数据增强的目标检测结果,而使用本实施例数据增强方法对训练数据增强后,训练的目标检测模型可以对目标正确检测,这是因为前者训练样本不足,导致了模型的误检,而本实施例数据增强方法不仅能够生成新的训练数据,扩大训练数据集的规模,而且还能提升数据集的多样性和泛化能力,图12(b)所示为本技术目标检测结果。

[0127]

本说明书中各个实施例采用递进的方式描述,每个实施例重点说明的都是与其他实施例的不同之处,各个实施例之间相同相似部分互相参见即可。对于实施例公开的装置而言,由于其与实施例公开的方法相对应,所以描述的比较简单,相关之处参见方法部分说明即可。

[0128]

对所公开的实施例的上述说明,使本领域专业技术人员能够实现或使用本发明。对这些实施例的多种修改对本领域的专业技术人员来说将是显而易见的,本文中所定义的

一般原理可以在不脱离本发明的精神或范围的情况下,在其它实施例中实现。因此,本发明将不会被限制于本文所示的这些实施例,而是要符合与本文所公开的原理和新颖特点相一致的最宽的范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1