一种舆情监控方法及存储介质与流程

1.本发明涉及语义识别处理领域,尤其涉及一种人工智能自动进行舆情监控的方法及装置。

背景技术:

2.舆情是“舆论情况”的简称,是指在一定的社会空间内,围绕事件的发生、发展和变化,群众对其产生和持有的社会态度。网络舆情是社会舆情在互联网空间的映射,是社会舆情的直接反映。网络舆情主要以网络为载体,事件为核心,是广大网民情感、态度、意见、观点的表达。

3.随着互联网信息量的不断增大,搭建舆情数据中台对网民舆情的提取、归纳也成为了高效处理互联网信息的重要方案手段。网络传媒作为一种新的信息传播方式,深入人们的日常生活。网民的言论活跃已达到很高的程度,不论是国内还是国际重大事件,都能马上形成网上舆论,通过网络来表达观点、传播思想,进而形成舆论压力,对任何部门、机构都是无法忽视的。舆情数据中台系统针对互联网类新兴媒体,通过中台分析系统,相关部门可以及时了解网络舆情动态,关注网络舆情的状态,从而产生舆情预警,及时纠正或引导网络上的负面舆情影响,或是得到舆情的整体状况,从而根据舆情状况修改决策。

技术实现要素:

4.为此,需要提供一种能够进行舆情监控的方法,从而更好地进行大数据过程中语义识别的技术效果。

5.为实现上述目的,发明人提供了一种舆情监控方法,包括如下步骤,

6.s1、建设预处理的文本语料库;

7.s2、搭建构建分类网络模型,包括以下结构:

8.词嵌入层,将输入的半结构化语料进行词嵌入训练,将语料转化为结构化向量;

9.第一转换层,所述第一转换层用于获取词向量的上下文信息并传入下一层;

10.第二转换层,所述第二转换层用于获取所述第一转换层的输出,并对所述第一转换层的输出进行self-attention计算后传入下一层;

11.双向lstm层,用于获得词向量的上下文信息并输出;

12.向量跳远连接层,用于将所述第一转换层和所述第二转换层的输出与双向lstm网络的输出进行拼接,使用可训练的权重进行加权融合;

13.单向lstm层,接收加权融合后的向量;

14.最大池化层,使用最大池化方式对矩阵向量降维;

15.softmax层,输出分类结果;

16.s3、将所述构建好的文本语料库送入所述分类网络模型,对所述分类网络模型进行训练和优化;

17.s4、基于训练完成的所述分类网络模型,对所述舆情数据进行计算分析,输出其文

本情感、态度、分类标签。

18.在一些具体的实施例中,所述词嵌入层的输入为(64,100,1)的训练数据,将每个分词表征为128维的词向量,该层输出为(64,128,128)的向量。

19.在一些具体的实施例中,所述第一转换层的输入为(64,128,128)的向量,参数设置为:encoder:数量为6,head:数量设为8,特征数量为128,该层输出为(64,128,128)的向量。

20.在一些具体的实施例中,所述第二转换层的输入为(64,128,128)的向量,参数设置为:encoder:数量为6,head:数量设为8,特征数量为128,该层输出为(64,128,128)的向量。

21.在一些具体的实施例中,所述向量跳远连接层用于将所述双向lstm输出与所述第一转换层的输出和所述第二转换层的输出进行拼接,输出为(64,128,512)的向量。

22.一种舆情监控存储介质,存储有计算机程序,所述计算机程序在被运行时将执行包括如下步骤,

23.s1、建设预处理的文本语料库;

24.s2、搭建构建分类网络模型,包括以下结构:

25.词嵌入层,将输入的半结构化语料进行词嵌入训练,将语料转化为结构化向量;

26.第一转换层,所述第一转换层用于获取词向量的上下文信息并传入下一层;

27.第二转换层,所述第二转换层用于获取所述第一转换层的输出,并对所述第一转换层的输出进行self-attention计算后传入下一层;

28.双向lstm层,用于获得词向量的上下文信息并输出;

29.向量跳远连接层,用于将所述第一转换层和所述第二转换层的输出与双向lstm网络的输出进行拼接,使用可训练的权重进行加权融合;

30.单向lstm层,接收加权融合后的向量;

31.最大池化层,使用最大池化方式对矩阵向量降维;

32.softmax层,输出分类结果;

33.s3、将所述构建好的文本语料库送入所述分类网络模型,对所述分类网络模型进行训练和优化;

34.s4、基于训练完成的所述分类网络模型,对所述舆情数据进行计算分析,输出其文本情感、态度、分类标签。

35.在一些具体的实施例中,所述词嵌入层的输入为(64,100,1)的训练数据,将每个分词表征为128维的词向量,该层输出为(64,128,128)的向量。

36.在一些具体的实施例中,所述第一转换层的输入为(64,128,128)的向量,参数设置为:encoder:数量为6,head:数量设为8,特征数量为128,该层输出为(64,128,128)的向量。

37.在一些具体的实施例中,所述第二转换层的输入为(64,128,128)的向量,参数设置为:encoder:数量为6,head:数量设为8,特征数量为128,该层输出为(64,128,128)的向量。

38.在一些具体的实施例中,所述向量跳远连接层用于将所述双向lstm输出与所述第一转换层的输出和所述第二转换层的输出进行拼接,输出为(64,128,512)的向量。

39.通过上述方案,利用设计的双向lstm输出、第一转换层和第二转换层配合使用,进行自注意力算法能够让模型学习跨层的信息,能够让文本获取到更丰富的特征,最终达到针对舆情内容进行更好地处理的分析系统。

附图说明

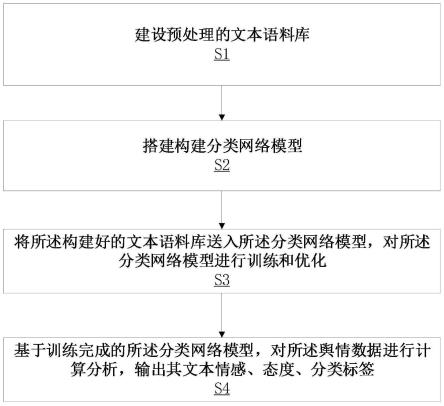

40.图1为本发明一实施方式所述的舆情分析方法流程图;

41.图2为本发明一实施方式所述的舆情分析方法图;

42.图3为本发明一实施方式所述的舆情分析存储介质;

43.图4为本发明一实施方式所述的舆情分析中台系统;

44.图5为本发明一实施方式所述的改进算法结果对比图。

具体实施方式

45.为详细说明本技术可能的应用场景,技术原理,可实施的具体方案,能实现目的与效果等,以下结合所列举的具体实施例并配合附图详予说明。本文所记载的实施例仅用于更加清楚地说明本技术的技术方案,因此只作为示例,而不能以此来限制本技术的保护范围。

46.在本文中提及“实施例”意味着,结合实施例描述的特定特征、结构或特性可以包含在本技术的至少一个实施例中。在说明书中各个位置出现的“实施例”一词并不一定指代相同的实施例,亦不特别限定其与其它实施例之间的独立性或关联性。原则上,在本技术中,只要不存在技术矛盾或冲突,各实施例中所提到的各项技术特征均可以以任意方式进行组合,以形成相应的可实施的技术方案。

47.除非另有定义,本文所使用的技术术语的含义与本技术所属技术领域的技术人员通常理解的含义相同;本文中对相关术语的使用只是为了描述具体的实施例,而不是旨在限制本技术。

48.在本技术的描述中,用语“和/或”是一种用于描述对象之间逻辑关系的表述,表示可以存在三种关系,例如a和/或b,表示:存在a,存在b,以及同时存在a和b这三种情况。另外,本文中字符“/”一般表示前后关联对象是一种“或”的逻辑关系。

49.在本技术中,诸如“第一”和“第二”之类的用语仅仅用来将一个实体或者操作与另一个实体或操作区分开来,而不一定要求或者暗示这些实体或操作之间存在任何实际的数量、主次或顺序等关系。

50.在没有更多限制的情况下,在本技术中,语句中所使用的“包括”、“包含”、“具有”或者其他类似的表述,意在涵盖非排他性的包含,这些表述并不排除在包括所述要素的过程、方法或者产品中还可以存在另外的要素,从而使得包括一系列要素的过程、方法或者产品中不仅可以包括那些限定的要素,而且还可以包括没有明确列出的其他要素,或者还包括为这种过程、方法或者产品所固有的要素。

51.与《审查指南》中的理解相同,在本技术中,“大于”、“小于”、“超过”等表述理解为不包括本数;“以上”、“以下”、“以内”等表述理解为包括本数。此外,在本技术实施例的描述中“多个”的含义是两个以上(包括两个),与之类似的与“多”相关的表述亦做此类理解,例如“多组”、“多次”等,除非另有明确具体的限定。

52.在本技术实施例的描述中,所使用的与空间相关的表述,诸如“中心”“纵向”“横向”“长度”“宽度”“厚度”“上”“下”“前”“后”“左”“右”“竖直”“水平”“垂直”“顶”“底”“内”“外”“顺时针”“逆时针”“轴向”“径向”“周向”等,所指示的方位或位置关系是基于具体实施例或附图所示的方位或位置关系,仅是为了便于描述本技术的具体实施例或便于读者理解,而不是指示或暗示所指的装置或部件必须具有特定的位置、特定的方位、或以特定的方位构造或操作,因此不能理解为对本技术实施例的限制。

53.除非另有明确的规定或限定,在本技术实施例的描述中,所使用的“安装”“相连”“连接”“固定”“设置”等用语应做广义理解。例如,所述“连接”可以是固定连接,也可以是可拆卸连接,或成一体设置;其可以是机械连接,也可以是电连接,也可以是通信连接;其可以是直接相连,也可以通过中间媒介间接相连;其可以是两个元件内部的连通或两个元件的相互作用关系。对于本技术所属技术领域的技术人员而言,可以根据具体情况理解上述用语在本技术实施例中的具体含义。

54.如图1所示的实施例中,展示了一种舆情监控方法,包括如下步骤,

55.s1、建设预处理的文本语料库;

56.s2、搭建构建分类网络模型,包括以下结构:

57.词嵌入层,将输入的半结构化语料进行词嵌入训练,将语料转化为结构化向量;

58.第一转换层,所述第一转换层用于获取词向量的上下文信息并传入下一层;

59.第二转换层,所述第二转换层用于获取所述第一转换层的输出,并对所述第一转换层的输出进行self-attention计算后传入下一层;

60.双向lstm层,用于获得词向量的上下文信息并输出;

61.向量跳远连接层,用于将所述第一转换层和所述第二转换层的输出与双向lstm网络的输出进行拼接,使用可训练的权重进行加权融合;向量拼接难点在于融合权重的设计本专利采用了权重自学习的方式将权重作为一个网络可学习的参数参与到网络的反向传播中从而更新权重。

62.单向lstm层,接收加权融合后的向量;

63.最大池化层,使用最大池化方式对矩阵向量降维;

64.softmax层,输出分类结果;

65.s3、将所述构建好的文本语料库送入所述分类网络模型,对所述分类网络模型进行训练和优化;

66.s4、基于训练完成的所述分类网络模型,对所述舆情数据进行计算分析,输出其文本情感、态度、分类标签。

67.其中self-attention计算又称self-attention算法、self-attention机制,能够通过设置相同的输入输出维度在层间提取信息进行信息的加强。

68.长短期记忆网络(lstm,longshort-termmemory)是一种时间循环神经网络,是为了解决一般的rnn(循环神经网络)存在的长期依赖问题而专门设计出来的,所有的rnn都具有一种重复神经网络模块的链式形式。它可以记忆不定时间长度的数值,区块中有一个gate能够决定输入是否重要到能被记住及能不能被输出。

69.softmax逻辑回归模型是logistic回归模型在多分类问题上的推广,在多分类问题中,类标签y可以取两个以上的值。

70.通过上述设计好的神经网络模型的层级设置,能够达到利用设计的双向lstm输出、第一转换层和第二转换层配合使用,进行自注意力算法能够让模型学习跨层的信息,能够让文本获取到更丰富的特征,最终达到针对舆情内容进行更好地处理分析的技术效果。

71.在一些具体的实施例中,所述词嵌入层的输入为(64,100,1)的训练数据,将每个分词表征为128维的词向量,该层输出为(64,128,128)的向量。嵌入层的维度可以选择32、64、128、256维度,每个分词表征可以为32、64、128、256维的词向量。通过上述方案设计词嵌入层为输入为(64,100,1)的训练数据,将每个分词表征为128维的词向量,能够在保证运算效率的情况下提升对词向量的信息提取能力。

72.在一些具体的实施例中,所述第一转换层的输入为(64,128,128)的向量,参数设置为:编码器encoder:数量为6,注意力头head:数量设为8,特征数量为128,该层输出为(64,128,128)的向量。第一转换层的特征数量可以选为32、64、128、256。选为128能够在不占用过多运算资源的情况下,通过上述方案提升第一转换层对文字特征的特征提取能力。

73.在一些具体的实施例中,所述第二转换层的输入为(64,128,128)的向量,参数设置为:编码器encoder:数量为6,注意力头head:数量设为8,特征数量为128,该层输出为(64,128,128)的向量。第二转换层的特征数量可以选为32、64、128、256。选为128能够在不占用过多运算资源的情况下,通过上述方案提升第一转换层对文字特征的特征提取能力。

74.在一些具体的实施例中,所述向量跳远连接层用于将所述双向lstm输出与所述第一转换层的输出和所述第二转换层的输出进行拼接,输出为(64,128,512)的向量。通过设计向量跳远连接层能够让模型学习到跨层设置的信息,让模型学习到更加丰富的文本表征,最终达到更好地进行舆情识别的技术效果。

75.其他一些综合的如图2所示的实施例中,还具体进行步骤:1.使用分布式爬虫技术爬取各大门户论坛的文本语料并进行预处理,生成半结构化的语料集存储于数据中台;即建设预处理的文本语料库。

76.2.在中台上搭建构建分类网络模型。中台可以是进行舆情分析的监控系统。

77.3.利用数据中台所收集的语料,对搭建好的分类网络模型进行训练和优化;

78.4.基于训练完成的分类网络,对舆情数据中台上的舆情数据进行计算分析,输出其文本情感、态度、分类标签。

79.采用的改进后的transformer+rcnn网络,包括如下设置:

80.1.embedding层(词嵌入层),输入为(64,100,1)的训练数据,将每个分词表征为128维的词向量,该层输出为(64,128,128)的向量;

81.2.transformer_1层(第一转换层),输入为(64,128,128)的向量,参数设置为encoder数量为6,head数量设为8,特征数量为128,该层输出为(64,128,128)的向量;

82.3.transformer_2层(第二转换层),输入为(64,128,128)的向量,参数设置为encoder数量为6,head数量设为8,特征数量为128,该层输出为(64,128,128)的向量;

83.4.双向lstm层,输出为两个(64,128,128)的向量;

84.5.向量跳远连接层,双向lstm输出与transformer_1、transformer_2的输出进行拼接,输出为(64,128,512)的向量;

85.6.卷积层,输入为(64,128,512)的向量,输出为(64,128,128)的向量;

86.7.最大池化层,输入为(64,128,128)的向量,输出为(64,128)的向量;

87.8.softmax层,输入为(64,128)的向量,输出为(64,15)的向量。

88.通过上述设计好的神经网络模型的层级设置,能够达到利用设计的双向lstm输出、第一转换层和第二转换层配合使用,进行自注意力算法能够让模型学习跨层的信息,能够让文本获取到更丰富的特征,最终达到针对舆情内容进行更好地处理的技术效果。

89.在如图3所示的实施例中,还公开了一种舆情监控存储介质30,存储有计算机程序,所述计算机程序在被运行时将执行包括如下步骤,

90.s1、建设预处理的文本语料库;

91.s2、搭建构建分类网络模型,包括以下结构:

92.词嵌入层,将输入的半结构化语料进行词嵌入训练,将语料转化为结构化向量;

93.第一转换层,所述第一转换层用于获取词向量的上下文信息并传入下一层;

94.第二转换层,所述第二转换层用于获取所述第一转换层的输出,并对所述第一转换层的输出进行self-attention计算后传入下一层;

95.双向lstm层,用于获得词向量的上下文信息并输出;

96.向量跳远连接层,用于将所述第一转换层和所述第二转换层的输出与双向lstm网络的输出进行拼接,使用可训练的权重进行加权融合;

97.单向lstm层,接收加权融合后的向量;

98.最大池化层,使用最大池化方式对矩阵向量降维;

99.softmax层,输出分类结果;

100.s3、将所述构建好的文本语料库送入所述分类网络模型,对所述分类网络模型进行训练和优化;

101.s4、基于训练完成的所述分类网络模型,对所述舆情数据进行计算分析,输出其文本情感、态度、分类标签。

102.在一些具体的实施例中,所述词嵌入层的输入为(64,100,1)的训练数据,将每个分词表征为128维的词向量,该层输出为(64,128,128)的向量。

103.通过上述设计好的神经网络模型的层级设置,能够达到利用设计的双向lstm输出、第一转换层和第二转换层配合使用,进行自注意力算法能够让模型学习跨层的信息,能够让文本获取到更丰富的特征,最终达到针对舆情内容进行更好地处理的分析系统。

104.在一些具体的实施例中,所述第一转换层的输入为(64,128,128)的向量,参数设置为:encoder:数量为6,head:数量设为8,特征数量为128,该层输出为(64,128,128)的向量。

105.在一些具体的实施例中,所述第二转换层的输入为(64,128,128)的向量,参数设置为:encoder:数量为6,head:数量设为8,特征数量为128,该层输出为(64,128,128)的向量。

106.在一些具体的实施例中,所述向量跳远连接层用于将所述双向lstm输出与所述第一转换层的输出和所述第二转换层的输出进行拼接,输出为(64,128,512)的向量。

107.在其他一些如图4所示的实施例中,展示了运用舆情监控方法的中台系统,包括:数据获取、处理、存储模块;模型训练、预测模块;以及数据统计分析、展示模块。上述中台能够达到利用设计的双向lstm输出、第一转换层和第二转换层配合使用,进行自注意力算法能够让模型学习跨层的信息,能够让文本获取到更丰富的特征,最终达到针对舆情内容进

行更好地处理分析的技术效果。

108.图5所示的实施例中还提供了改进前后的算法模型结果对比图。

109.需要说明的是,尽管在本文中已经对上述各实施例进行了描述,但并非因此限制本发明的专利保护范围。因此,基于本发明的创新理念,对本文所述实施例进行的变更和修改,或利用本发明说明书及附图内容所作的等效结构或等效流程变换,直接或间接地将以上技术方案运用在其他相关的技术领域,均包括在本发明的专利保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1