一种基于迁移学习的配电网时变拓扑状态估计方法

1.本发明属于配电网状态估计技术领域,更为具体地讲,涉及一种基于迁移学习的配电网时变拓扑状态估计方法。

背景技术:

2.配电网作为保障用户用电安全的关键环节,随着分布式能源大规模接入,以及电动汽车等新型负荷的占比增加,造成“源—荷”的不确定性问题日渐严峻。配电网馈线开关动作更加频繁,导致配电网网络结构发生变化。而在历史数据库中难以包含所有拓扑数据信息。当拓扑发生改变时,新拓扑下已知数据很少,传统的依靠历史数据进行训练的数据驱动方法会造成过拟合。因此,需要发明一种能够弥补由于新拓扑样本数据少造成的状态估计困难问题。

3.状态估计方法分为基于物理模型方法和数据驱动方法。传统物理模型以wls为代表通过拓扑结构以及参数信息构建量测方程,通过高斯牛顿迭代法求得方程的最优解,即为待估计的状态量。但在实际应用中,配电网的拓扑结构参数信息通常会发生改变,造成估计结果失准。

4.数据驱动方法通过分析历史数据的时空关联特性,进而建立多断面数据驱动模型,能够有效提高状态估计的精度和收敛性。因此,基于数据驱动的状态估计方法已成为当前状态估计领域的研究热点。但数据驱动模型往往需要大量历史数据进行训练,而当拓扑发生突变时,新拓扑可利用信息较少,传统数据驱动会造成过拟合,难以达到准确结果。

技术实现要素:

5.本发明的目的在于克服现有技术的不足,提供一种基于迁移学习的配电网时变拓扑状态估计方法,通过贝叶斯岭回归迁移学习器实现拓扑时变下数据集较少情况下的配电网状态估计。

6.为实现上述发明目的,本发明一种基于迁移学习的配电网时变拓扑状态估计方法,其特征在于,包括以下步骤:

7.(1)、采集源拓扑历史量测数据;

8.将配电网已知拓扑作为源拓扑,然后采集源拓扑中各个节点在不同时刻t的量测数据和状态数据,其中,量测数据包括:节点注入有功功率pi(t)和无功功率qi(t),部分支路流入的有功功率p

ij

(t)和无功功率q

ij

(t),其中,t=1,2,

…

,t,t为采样时刻数,i,j表示源拓扑中的节点;状态数据包括:电压v(t)和相角

9.(2)、构建训练数据集;

10.将量测数据{pi(t),qi(t),p

ij

(t),q

ij

(t)}和状态数据进行归一化处理,然后对归一化的数据随机添加20%的误差,从而构成训练数据集;

11.(3)、构建源拓扑状态估计模型;

12.将k个并联的深度残差神经网络模型作为源拓扑状态估计模型,其中每一个深度残差神经网络模型均由输入层、整形层、若干残差块和输出层串行连接组成;

13.假设共有2n个残差块,每相邻两个残差块通过外部添加跳跃连接方式等效成一个扩展残差块,具体连接方式为:从第l个残差块开始,第l个残差块的输入与第l+1个残差块的输出相加取均值作为第l+2个残差块的输入;第l+2个残差块的输入与第l+3个残差块的输出相加取均值作为第l+4个残差块的输入;然后以此类推,其余残差块依旧保持串行连接,即第l+1个残差块的输入为第l个残差块的输出,第2n个残差块的输出与第2n-1个残差块的输入,以及第一个残差块的输入共同相加取均值再经过dropout和整形层然后输出估计值;其中,l=1,3,5,

…

,2n-1,n为自然数;

14.(4)、离线训练源拓扑状态估计模型

15.(4.1)、在训练数据集中依次将一批次中不同时刻的量测数据和状态数据通过输入层同时输入至k个深度残差神经网络模型,在每一个深度残差神经网络模型内,通过整形层提取数据特征,并映射到高维空间转为张量形式输入至串联的残差块;

16.(4.2)、在串联的残差块中,遍历每一个残差块,其中第一个残差块的输入是由整形层直接输入,当流经第i个残差块时,i=3,5,

…

,2n-1,将第i-2个残差块的输入张量为x

(i-3)

,与第i-1个残差块的输出张量相加取均值,得到第i个残差块的输入张量average表示均值运算;

17.输入张量x

(i-1)

进入第i个残差块后分为两条支路,在第i个残差块的左侧支路中,输入张量x

(i-1)

经过全连接层提取特征,然后经过权重归一化、relu激活函数,再经过第二层全连接层后进行权重归一化,得到左侧分支的输出张量f(x

(i-1)

);在右侧支路中,输入张量x

(i-1)

直接与左侧支路的输出张量f(x

(i-1)

)相加,再经过激活函数得到第i个残差块的输出activation表示求和运算;

18.当流经第j个残差块时,j=2,4,6,

…

,2n,第j个残差块的输入为第j-1个残差块的输出张量

19.当遍历到最后一个残差块即第2n个残差块时,第2n个残差块的输出与第2n-1个残差块的输入,以及第一个残差块的输入共同相加取均值再经过dropout,整形层然后输出状态数据估计值;

20.(4.3)、计算平均绝对误差mae和平均绝对百分比误差mape作为损失函数值;

[0021][0022][0023]

其中,m为每一批次中训练数据样本个数,zi为训练数据集中输入的状态数据的真实值,为深度残差神经网络模型预测的状态数据估计值;

[0024]

(4.4)、判断k个深度残差神经网络模型的损失函数值mae和mape是否同时满足预设阈值,如果满足,则迭代停止,得到k个训练完成的深度残差神经网络模型;否则,采用

adam优化器优化网络参数,再返回步骤(4.1),进行下一轮训练,直至k个深度残差神经网络模型都收敛;

[0025]

(5)、源拓扑状态估计模型的迁移学习;

[0026]

(5.1)、采集新拓扑的小样本数据,包括量测数据以及状态数据,构建输入数据x

target

;

[0027]

(5.2)、将输入数据x

target

输入到源拓扑状态估计模型中,得到k个状态数据估计值z=(z1,z2,

…

,zi,

…

,zk),zi表示第i个深度残差神经网络输出的状态数据估计值;

[0028]

(5.3)、将k个状态数据估计值z=(z1,z2,

…

,zi,

…

,zk)输入到贝叶斯岭回归迁移学习器中,得到各个深度残差神经网络模型的权重wi;

[0029]

(6)、实时估计新拓扑的状态;

[0030]

实时采集新拓扑的量测数据,然后输入到分配了权重的源拓扑状态估计模型中,得到状态估计值

[0031]

本发明的发明目的是这样实现的:

[0032]

本发明基于迁移学习的配电网时变拓扑状态估计方法,先采集几种有代表性的源拓扑量测数据以及对应状态数据信息,进行数据预处理,以满足神经网络的输入需求;然后构建深度残差神经网络对源拓扑状态估计,得到多个深度残差网络模型。然后采集新拓扑少量数据,利用贝叶斯岭回归方法进行训练确定组合模型权重,来实现对新拓扑进行状态估计。

[0033]

同时,本发明基于迁移学习的配电网时变拓扑状态估计方法还具有以下有益效果:

[0034]

(1)、本发明采用深度残差神经网络模型作为单拓扑状态估计模型,可以解决深度学习梯度消失和梯度爆炸的问题,有效提升单一拓扑下数据驱动方式的准确性;

[0035]

(2)、本发明贝叶斯岭回归的方法实现对新拓扑的迁移学习,同时结合贝叶斯以及岭回归的优点,同时利用组合模型的方法,能够减少负迁移带来的影响,从而得到准确的状态估计模型;

[0036]

(3)、传统的深度残差神经网络模型直接经过若干个残差块得到输出结果,而本发明对深度残差神经网络模型进行改进,将每两个残差块外部添加跳跃连接等效成一个扩展残差块,通过增加跳跃连接的方式可以有效减少训练过程中的信息损耗等问题。

[0037]

(4)、本发明对残差块的结构也进行了改进,传统残差块中经过一个卷积层,而本发明为了提高非线性能力,在残差块中经过两个全连接层,由于时间序列数据不像图像数据一样复杂,因此采用全连接层即可训练二维数据集。

附图说明

[0038]

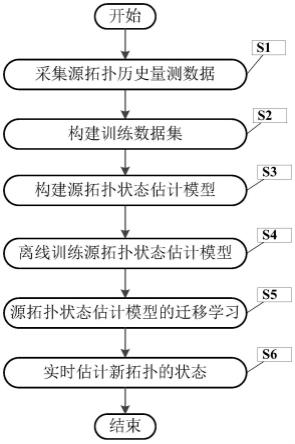

图1是本发明基于迁移学习的配电网时变拓扑状态估计方法流程图;

[0039]

图2是深度残差神经网络模型的结构图;

[0040]

图3是本发明与其他几种方法的拓扑状态估计对比曲线,其中(a)是电压曲线,(b)是相角曲线。

具体实施方式

[0041]

下面结合附图对本发明的具体实施方式进行描述,以便本领域的技术人员更好地理解本发明。需要特别提醒注意的是,在以下的描述中,当已知功能和设计的详细描述也许会淡化本发明的主要内容时,这些描述在这里将被忽略。

[0042]

实施例

[0043]

图1是本发明基于迁移学习的配电网时变拓扑状态估计方法流程图。

[0044]

在本实施例中,仿真在ieee33节点标准配电网上展开,如图1所示,本发明一种基于迁移学习的配电网时变拓扑状态估计方法,包括以下步骤:

[0045]

s1、采集源拓扑历史量测数据;

[0046]

将配电网已知拓扑作为源拓扑,然后采集源拓扑中各个节点在不同时刻t的量测数据和状态数据,其中,量测数据包括:节点注入有功功率pi(t)和无功功率qi(t),部分支路流入的有功功率p

ij

(t)和无功功率q

ij

(t),其中,t=1,2,

…

,t,t为采样时刻数,i,j表示源拓扑中的节点;状态数据包括:电压v(t)和相角在本实施例中,采样时间间隔设置为5分钟,选取32组节点注入有功功率pi(t)和无功功率qi(t),10条支路流入的有功功率p

ij

(t)和无功功率q

ij

(t),共84个输入量测数据。

[0047]

s2、构建训练数据集;

[0048]

由于各量测信息涉及的量测量各自数值与单位之间存在较大差异,为减少影响,需要将量测数据{pi(t),qi(t),p

ij

(t),q

ij

(t)}和状态数据进行归一化处理,为了提升模型鲁棒能力,需要对归一化的数据随机添加20%的误差,从而构成训练数据集;

[0049]

s3、构建源拓扑状态估计模型;

[0050]

将k个并联的深度残差神经网络模型作为源拓扑状态估计模型,其中每一个深度残差神经网络模型均由输入层、整形层、若干残差块和输出层串行连接组成;在本实施例中,k取6,即选择6个并联拓扑作为源域。

[0051]

残差块包括两个分支,i=2,3,

…

,2n,2n代表残差块总数量;其中,左侧支路是前一个残差块的输出张量分别经过全连接层、权重归一化、激活函数、全连接层和权重归一化之后再得到左侧输出张量;右侧支路是前一个残差块的输出张量直接与左侧输出张量相加,再经过激活函数后得到残差块的输出张量。

[0052]

在本实施例中,假设共有2n个残差块,每相邻两个残差块通过外部添加跳跃连接方式等效成一个扩展残差块,扩展残差块为借鉴单残差块的结构,在两个残差块之间添加快捷连接,从而减少信息损耗。具体连接方式为:从第l个残差块开始,第l个残差块的输入与第l+1个残差块的输出相加取均值作为第l+2个残差块的输入;第l+2个残差块的输入与第l+3个残差块的输出相加取均值作为第l+4个残差块的输入;然后以此类推,其余残差块依旧保持串行连接,即第l+1个残差块的输入为第l个残差块的输出,第2n个残差块的输出与第2n-1个残差块的输入,以及第一个残差块的输入共同相加取均值再经过dropout和整形层然后输出估计值;其中,l=1,3,5,

…

,2n-1,n为自然数;

[0053]

在本实施例中,例如,第三个残差块的输入为第一个残差块的输入与第二个的输出相加取均值,第四个残差块的输入即为第三个残差块的输出;第五个残差块的输入为第三个残差块的输入与第四个残差块的输出相加取均值,第六个残差块的输入为第五个残差

块的输出;第七个残差块的输入为第五个残差块的输入与第六个残差块的输出相加取均值,第八个残差块的输入为第七个残差块的输出;

[0054]

s4、离线训练源拓扑状态估计模型

[0055]

s4.1、在训练数据集中依次将一批次中不同时刻的量测数据和状态数据通过输入层同时输入至k个深度残差神经网络模型,在每一个深度残差神经网络模型内,通过整形层提取数据特征,并映射到高维空间转为张量形式输入至串联的残差块;

[0056]

s4.2、在串联的残差块中,遍历每一个残差块,其中第一个残差块的输入是由整形层直接输入,当流经第i个残差块时,i=3,5,

…

,2n-1,将第i-2个残差块的输入张量为x

(i-3)

,与第i-1个残差块的输出张量相加取均值,得到第i个残差块的输入张量average表示均值运算;

[0057]

输入张量x

(i-1)

进入第i个残差块后分为两条支路,在第i个残差块的左侧支路中,输入张量x

(i-1)

经过全连接层提取特征,然后经过权重归一化、relu激活函数,再经过第二层全连接层后进行权重归一化,得到左侧分支的输出张量f(x

(i-1)

);在右侧支路中,输入张量x

(i-1)

直接与左侧支路的输出张量f(x

(i-1)

)相加,再经过激活函数得到第i个残差块的输出activation表示求和运算;

[0058]

当流经第j个残差块时,j=2,4,6,

…

,2n,第j个残差块的输入为第j-1个残差块的输出张量

[0059]

当遍历到最后一个残差块即第2n个残差块时,第2n个残差块的输出与第2n-1个残差块的输入,以及第一个残差块的输入共同相加取均值再经过dropout,整形层然后输出状态数据估计值;

[0060]

s4.3、计算平均绝对误差mae和平均绝对百分比误差mape作为损失函数值;

[0061][0062][0063]

其中,m为每一批次中训练数据样本个数,zi为训练数据集中输入的状态数据的真实值,为深度残差神经网络模型预测的状态数据估计值;

[0064]

s4.4、判断k个深度残差神经网络模型的损失函数值mae和mape是否同时满足预设阈值,如果满足,则迭代停止,得到k个训练完成的深度残差神经网络模型;否则,采用adam优化器优化网络参数,再返回步骤(4.1),进行下一轮训练,直至k个深度残差神经网络模型都收敛;

[0065]

s5、源拓扑状态估计模型的迁移学习;

[0066]

s5.1、采集新拓扑的小样本数据,包括量测数据以及状态数据,构建输入数据x

target

;

[0067]

s5.2、将输入数据x

target

输入到源拓扑状态估计模型中,得到k个状态数据估计值z=(z1,z2,

…

,zi,

…

,zk),zi表示第i个深度残差神经网络输出的状态数据估计值;

[0068]

s5.3、将k个状态数据估计值z=(z1,z2,

…

,zi,

…

,zk)输入到贝叶斯岭回归迁移学习器中,得到各个深度残差神经网络模型的权重wi;

[0069]

s6、实时估计新拓扑的状态;

[0070]

实时采集新拓扑的量测数据,然后输入到分配了权重的源拓扑状态估计模型中,得到状态估计值

[0071]

表1对比了几种不同方法小样本条件下电压幅值状态估计结果,表2对比了电压、相角状态估计结果。其中支持向量机svm,长短时记忆神经网络lstm仅在小样本条件下训练,可以看出当数据样本少时,仅靠少样本进行数据驱动方法难以得到满意的精度要求,这也证明了本发明利用源拓扑历史数据与新拓扑数据存在相似性进行迁移学习的可行性。与采用线性回归组合模型res-lr的方法相比,本发明使用的贝叶斯岭回归可以充分利用有限样本信息,同时引进l2正则化改良线性回归,从而得到更准确的估计结果。这也意味着本发明可以进一步用于实际工程中。对测试集样本随机采样,电压幅值和相角估计结果分别如图3(a)和(b)所示。从图中可看出,本发明方法的幅值和相角状态估计值在连续时刻中明显更接近实际值,这代表本发明方法相比与其他方法有着更高的估计精度。

[0072]

表1.不同模型电压幅值表现

[0073] svmlstmres-lr本发明mae0.0310.0110.00350.0028

[0074]

表2.不同模型电压相角表现

[0075] svmlstmres-lr本发明mae0.1180.1000.1580.076

[0076]

尽管上面对本发明说明性的具体实施方式进行了描述,以便于本技术领域的技术人员理解本发明,但应该清楚,本发明不限于具体实施方式的范围,对本技术领域的普通技术人员来讲,只要各种变化在所附的权利要求限定和确定的本发明的精神和范围内,这些变化是显而易见的,一切利用本发明构思的发明创造均在保护之列。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1