一种基于自适应聚类分层的个性化联邦学习方法及系统

1.本发明属于分布式机器学习技术领域,具体涉及一种基于自适应聚类分层的个性化联邦学习方法及系统。

背景技术:

2.随着云时代的来临和边缘设备(如智能手机和智能穿戴设备等)的普及,数据无时无刻不在产生,甚至呈井喷式增长。这些丰富的数据为机器学习应用提供了巨大的机会,例如在语音识别、计算机视觉中,深度神经网络可借助大量的训练数据有效地提取所需信息。但随着社会各界越来越关注数据隐私,在边缘设备或组织(如医院、公司、法院)中产生的大量数据无法收集到中央服务器中,这给深度学习带来了巨大的挑战。

3.联邦学习是一种深度学习框架,客户可以在中央服务器的协调下协作地训练一个共享的全局模型来处理他们的数据,同时保持数据的私有化,降低了系统性隐私风险和通信成本。现有的大多数训练方法都是联邦平均的变体,传统的联邦学习侧重于通过学习参与客户的本地数据,获得一个高质量且通用的全局模型。然而在存在数据统计异质性的情况下(例如非独立同分布和不平衡数据),联邦学习很难训练出对所有客户都适用的单一模型。单独优化全局模型可能会导致局部模型的性能较差,因为全局模型并不适应每一个客户。随着不同客户的本地数据之间的差异越来越大,这个问题进一步加剧。

4.为了缓解数据统计异质性使联邦学习性能下降的问题,个性化联邦学习成为一种解决方案。个性化联邦学习旨在为不同的客户训练独特的个性化模型,这个模型可以结合全局模型的泛化特性和局部模型的分布匹配特性,但挑战在于如何在局部模型的特定知识和全局模型的共享知识之间取得细微平衡。近年来,在个性化联邦学的探索中,许多工作聚焦于两种可能的解决方案:基于聚类的个性化和基于分层的个性化。基于聚类的个性化方法将具有相似数据分布的客户聚类分组,为每个聚类组训练专用模型。基于分层的个性化方法对局部模型的某些层进行个性化处理,而其他层则从全局模型种派生出来。

5.虽然这两种方案都可以通过个性化提高联邦学习的性能,但是仍存在着不可忽视的问题。目前基于聚类的个性化方法很少关注组之间的模型共享,因此,它们可能会影响全局模型的泛化性能。同时,现有的基于层的个性化方法通常采用人为预定义的分层方案,缺乏灵活性和适应性。因此,它们可能最终得到次优解,从而导致全局模型和局部模型的性能不平衡。

6.申请号为202210511356.6的发明中提供了一种联邦学习方法及系统,包括:s1,将初始全局模型发送给所有客户端,客户端上传初始本地模型至中央服务系统;s2,根据客户端上传的初始本地模型对客户端进行聚类获得一个以上客户端类;s3,对全局模型进行多轮迭代训练直到达到迭代停止条件,第t轮迭代训练:从每个客户端类中选取至少一个客户端参与训练;基于客户端返回的第t轮本地模型和第t轮损失函数值判断参与第t轮迭代训练的客户端之间是否存在梯度冲突,并根据梯度冲突情况获取累积模型差异;利用累积模型差异更新第t轮全局模型。将模型不公平性原因分为外部矛盾和内部矛盾两类进行消除,

提高选取客户端的代表性和公平性,减少训练轮次和通信成本,加快收敛。但该发明也无法解决全局模型和局部模型的性能不平衡、以及全局模型的泛化性能差的问题。

技术实现要素:

7.解决的技术问题:本发明提供了一种基于自适应聚类分层的个性化联邦学习方法及系统,解决了联邦学习中数据统计异质性问题以及个性化联邦学习中全局模型和局部模型的性能不平衡的问题,通过集成客户聚类方法和自适应分层融合算法,利用客户的性能反馈进行聚类分组和自适应分层融合,灵活的为特定的联邦学习任务制定个性化策略,达到了在不损害全局泛化能力的前提下大幅提高客户局部模型的个性化性能的技术效果。

8.技术方案:

9.一种基于自适应聚类分层的个性化联邦学习方法,所述个性化联邦学习方法包括以下步骤:

10.s1,客户端准备预测任务的训练数据集和测试数据集,全局参数服务器随机初始化全局模型参数;

11.s2,全局参数服务器将全局模型参数下发给客户端,令客户端将接收到的全局模型参数作为本地模型初始参数,采用本地训练数据集对模型进行当前轮次的训练,且在训练完成后采用测试数据集评估模型预测效果,并计算梯度,将计算得到的梯度上传至参数服务器;参数服务器对接收到的所有客户端的梯度进行加权平均处理,采用计算得到的平均梯度调整全局模型参数;

12.s3,重复执行步骤s2,直至训练轮次达到第一阶段最大通信轮次,转入步骤s4;

13.s4,参数服务器根据最近一轮所有客户端上传的梯度计算客户端之间的相似度,根据计算结果对所有客户端进行聚类分组,为每个客户组选取一个组服务器,并为每个客户组生成组内分层的个性化权重向量;

14.s5,参数服务器将最新全局模型参数发送至所有组服务器,由组服务器迭代执行组内个性化联邦学习训练,将得到的最新组内模型参数上传至参数服务器;参数服务器将接收到的所有客户组发送的最新组内模型参数加权平均聚合后得到新的全局模型;

15.s6,重复执行步骤s5,直至训练轮次达到最大轮次或者模型已经收敛,结束流程。

16.进一步地,步骤s2中,全局参数服务器将全局模型参数下发给客户端,令客户端将接收到的全局模型参数作为本地模型初始参数,采用本地训练数据集对模型进行当前轮次的训练,且在训练完成后采用测试数据集评估模型预测效果,并计算梯度,将计算得到的梯度上传至参数服务器的过程包括以下步骤:

17.s21,全局参数服务器将模型wg的第t轮参数下发给参与联邦学习训练的k个客户端;t∈[1,t

pre

],其中,t

pre

为第一阶段最大通信轮次,第1轮参数由全局参数服务器随机初始化模型得到;

[0018]

s22,在每个接收模型wg的第t轮参数的客户端上并行执行以下训练步骤:

[0019]

s221,客户端将模型wg的第t轮参数作为初始模型参数,记为表示第k个客户端本地模型的第t轮初始模型参数;

[0020]

s222,基于初始模型参数和从客户持有的原始数据中随机抽取的n个样本组成的训练数据集客户端对本地模型进行训练优化,使用随机梯度下降法进行e轮本地迭代,得到优化后的模型参数

[0021]

s223,客户端使用优化后的模型参数对测试数据集进行预测推理,评估预测效果,并计算梯度

[0022]

s224,客户端将梯度gk发送给全局参数服务器。

[0023]

进一步地,步骤s222中,采用下述公式计算得到优化后的模型参数

[0024][0025][0026]

其中,表示所抽样训练数据集的样本数量,为损失值,x和y分别表示数据集中单个样本的特征和对应标签,表示模型输出结果与真实值y之间的损失,η表示学习率,表示对于的梯度。

[0027]

进一步地,步骤s2中,参数服务器对接收到的所有客户端的梯度进行加权平均处理,采用计算得到的平均梯度调整全局模型参数的过程包括以下步骤:

[0028]

全局参数服务器根据客户端训练数据集中的样本数量nk计算客户端k所占权重比例γk=nk/∑

k∈k

nk;

[0029]

采用联邦平均算法fedavg加权聚合所有参与联邦学习训练的k个客户端的梯度,得到t+1轮的模型参数

[0030][0031]

进一步地,步骤s4中,参数服务器根据最近一轮所有客户端上传的梯度计算客户端之间的相似度,根据计算结果对所有客户端进行聚类分组,为每个客户组选取一个组服务器的过程包括以下步骤:

[0032]

s41,参数服务器根据第t

pre

轮所有客户端上传的梯度{gk}

k∈k

,通过计算每两个客户端梯度间的余弦相似度sc,获得相似度矩阵ρ;其中ρ

i,j

=sc(i,j),sc(i,j)=(gi·gj

)/(||gi||

·

|gj||);

[0033]

s42,基于相似度矩阵ρ,使用自顶向下的层次聚类算法将k个客户端聚类为m个客户组,记为

[0034]

s43,为每个客户组选取一个组服务器,用来协调组内客户的训练;

[0035]

s44,令每个客户组的组服务器复制一份全局参数服务器中模型wg的第t

pre

轮参数作为客户组服务器模型wm的参数其中m∈{1,2,

…

,m}。

[0036]

进一步地,步骤s4中,为每个客户组生成组内分层的个性化权重向量的过程包括以下步骤:

[0037]

根据组内客户端的梯度计算组内平均梯度

[0038][0039]

将平均梯度按模型参数层展开,表示为其中l为模型参数层的总数;

[0040]

对平均梯度逐层计算欧几里得距离,得到一个1

×

l维向量δm:

[0041][0042]

定义一个超参数β用以调节个性化程度,将δm归一化后乘以β得到组内分层的个性化模型权重ψm:

[0043]

ψm=β

·

δm/max(δm)。

[0044]

进一步地,步骤s5中,参数服务器将最新全局模型参数发送至所有组服务器,由组服务器迭代执行组内个性化联邦学习训练,将得到的最新组内模型参数上传至参数服务器的过程包括以下步骤:

[0045]

s51,全局参数服务器将模型wg的第t轮参数下发给m个客户组服务器;t∈(t

pre

,t

total

),其中,t

pre

,t

total

分别为第一阶段最大通信轮次和第二阶段最大通信轮次;

[0046]

s52,在每个客户组服务器上并行执行以下步骤:

[0047]

s521,组服务器收到参数服务器发来的全局模型wg的第t轮参数

[0048]

s522,组服务器将第t轮全局模型wg的参数与组模型wm的参数使用组内分层的个性化模型权重ψm逐层的加权融合,将组模型wm的参数更新为加权融合过程先将和按层分解为和再对每层的参数进行融合,具体公式为:

[0049][0050][0051]

其中表示中第n层的参数,表示中第n层的参数,n∈{1,2,

…

,l};

[0052]

s523,组服务器将组模型wm的参数下发给组内的客户端;

[0053]

s53,在每个接收组模型wm的第t轮参数的客户端上并行执行以下训练步骤:

[0054]

s531,客户端将组模型wm的第t轮参数作为初始模型参数,记为表示第k个客户端本地模型的第t轮初始模型参数;

[0055]

s532,基于初始模型参数和从客户持有的原始数据中随机抽取的n个样本组成的训练数据集客户端对本地模型进行训练优化,使用随机梯度下降法sgd进行e轮本地迭代,得到优化后的模型参数

[0056]

s534,客户端使用优化后的模型参数对测试数据集进行预测推理,评估预测效果,并计算梯度

[0057]

s535,客户端将梯度gk发送给相应的组服务器;

[0058]

s54,每个组服务器根据组内客户端训练数据集中的样本数量nk计算客户端k在组内所占权重比例使用联邦平均算法fedavg加权聚合组内客户端的梯度,更新组服务器模型wm的参数具体计算公式为:

[0059][0060]

s55,判断迭代次数是否达到第二阶段最大通信轮次,若满足条件,则执行s56,否则继续执行s523至s54;

[0061]

s56,将组服务器模型wm更新后的参数记为组服务器将组服务器模型wm的参数发送给全局参数服务器。

[0062]

进一步地,步骤s5中,参数服务器将接收到的所有客户组发送的最新组内模型参数加权平均聚合后得到新的全局模型的过程包括以下步骤:

[0063]

全局参数服务器使用联邦平均算法fedavg加权聚合所有组服务器发送的模型参数得到模型wg的t+1轮的参数具体计算公式为:

[0064][0065]

本发明还公开了一种基于自适应聚类分层的个性化联邦学习系统,所述个性化联邦学习系统包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,其中,所述处理器执行所述程序时实现如前所述的基于自适应聚类分层的个性化联邦学习方法的步骤。

[0066]

有益效果:

[0067]

第一,本发明的基于自适应聚类分层的个性化联邦学习方法,由于集成了客户聚类方法,可在不获取客户真实数据的前提下将客户按数据分布的相似性进行分组,客户可加入相应的联网学习系统进行模型的训练与推理。

[0068]

第二,本发明的基于自适应聚类分层的个性化联邦学习方法,由于集成了自适应分层融合方案,客户可获得最适合自己的个性化模型,同时本发明能够维护一个具有良好泛化性能的全局模型,以方便新的客户加入或使用相应的个性化联邦学习系统。

[0069]

第三,本发明的基于自适应聚类分层的个性化联邦学习方法,解决了联邦学习中数据统计异质性问题以及个性化联邦学习中全局模型和局部模型的性能不平衡的问题,达到了在不损害全局泛化能力的前提下大幅提高客户局部模型的个性化性能的技术效果。

附图说明

[0070]

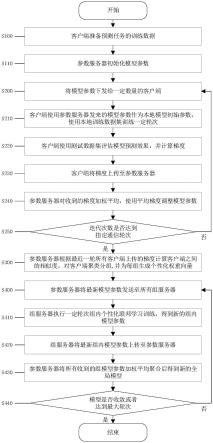

图1为本发明实施例的一种基于自适应聚类分层的个性化联邦学习方法整体过程示意图。

[0071]

图2为本发明实施例的一种基于自适应聚类分层的个性化联邦学习方法组内训练过程示意图。

[0072]

图3为本发明实施例的一种基于自适应聚类分层的个性化联邦学习方法第一阶段原理示意图。

[0073]

图4为本发明实施例的一种基于自适应聚类分层的个性化联邦学习方法第二阶段原理示意图。

[0074]

图5为本发明实施例的一种基于自适应聚类分层的个性化联邦学习系统的结构示意图。

具体实施方式

[0075]

下面的实施例可使本专业技术人员更全面地理解本发明,但不以任何方式限制本发明。

[0076]

本实施例公开了一种基于自适应聚类分层的个性化联邦学习方法,所述个性化联邦学习方法包括以下步骤:

[0077]

s1,客户端准备预测任务的训练数据集和测试数据集,全局参数服务器随机初始化全局模型参数;

[0078]

s2,全局参数服务器将全局模型参数下发给客户端,令客户端将接收到的全局模型参数作为本地模型初始参数,采用本地训练数据集对模型进行当前轮次的训练,且在训练完成后采用测试数据集评估模型预测效果,并计算梯度,将计算得到的梯度上传至参数服务器;参数服务器对接收到的所有客户端的梯度进行加权平均处理,采用计算得到的平均梯度调整全局模型参数;

[0079]

s3,重复执行步骤s2,直至训练轮次达到第一阶段最大通信轮次,转入步骤s4;

[0080]

s4,参数服务器根据最近一轮所有客户端上传的梯度计算客户端之间的相似度,根据计算结果对所有客户端进行聚类分组,为每个客户组选取一个组服务器,并为每个客户组生成组内分层的个性化权重向量;

[0081]

s5,参数服务器将最新全局模型参数发送至所有组服务器,由组服务器迭代执行组内个性化联邦学习训练,将得到的最新组内模型参数上传至参数服务器;参数服务器将接收到的所有客户组发送的最新组内模型参数加权平均聚合后得到新的全局模型;

[0082]

s6,重复执行步骤s5,直至训练轮次达到最大轮次或者模型已经收敛,结束流程。

[0083]

另一方面,本发明实施例提供了一种基于自适应聚类分层的个性化联邦学习系统,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,其中,所述处理器执行所述程序时实现前述基于自适应聚类分层的个性化联邦学习方法的步骤。

[0084]

本实施例通过提供了一种基于自适应聚类分层的个性化联邦学习方法及系统,解决了联邦学习中数据统计异质性问题以及个性化联邦学习中全局模型和局部模型的性能不平衡的问题,通过集成客户聚类方法和自适应分层融合算法,利用客户的性能反馈进行聚类分组和自适应分层融合,灵活的为特定的联邦学习任务制定个性化策略,达到了在不损害全局泛化能力的前提下大幅提高客户局部模型的个性化性能的技术效果。

[0085]

如图1所示,本实施例提供了一种基于自适应聚类分层的个性化联邦学习方法,具体的,分为两个阶段,包括以下步骤:

[0086]

第一阶段,原理示意图如图3所示:

[0087]

s100:所有客户端准备预测任务的训练数据集和测试数据集。

[0088]

s110:全局参数服务器随机初始化模型wg的第1轮参数

[0089]

s200:全局参数服务器将模型wg的第t轮参数下发给参与联邦学习训练的k个客户端;t∈[1,t

pre

],其中,t

pre

为指定通信轮次。

[0090]

s210:在每个接收模型wg的第t轮参数的客户端上并行执行以下训练步骤:

[0091]

客户端将模型wg的第t轮参数作为初始模型参数,记为表示第k个客户端本地模型的第t轮初始模型参数;

[0092]

基于初始模型参数和从客户持有的原始数据中随机抽取的n个样本组成的训练数据集客户端对本地模型进行训练优化,使用随机梯度下降法(stochastic gradient descent,sgd)进行e轮本地迭代,得到优化后的模型参数

[0093]

s220:客户端使用优化后的模型参数对测试数据集进行预测推理,评估预测效果,并计算梯度

[0094]

s230:客户端将梯度gk发送给全局参数服务器。

[0095]

s240:全局参数服务器根据客户端训练数据集中的样本数量nk计算客户端k所占权重比例γk=nk/∑

k∈k

nk;继而使用联邦平均算法fedavg加权聚合所有参与联邦学习训练的k个客户端的梯度,得到t+1轮的模型参数具体计算公式为:

[0096][0097]

s250:判断迭代次数是否达到指定通信轮次,若满足条件,则执行s300,否则继续执行s200至s250。

[0098]

s300:参数服务器根据第t

pre

轮所有客户端上传的梯度{gk}

k∈k

,通过计算每两个客户端梯度间的余弦相似度sc,获得相似度矩阵ρ;其中ρ

i,j

=sc(i,j),

[0099]

sc(i,j)=(gi·gj

)/(||gi||

·

|gj||)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(2);

[0100]

基于相似度矩阵ρ,使用自顶向下的层次聚类算法将k个客户端聚类为m个客户组,记为为每个客户组选取一个组服务器,用来协调组内客户的训练;每个客户组服务器复制一份全局参数服务器中模型wg的第t

pre

轮参数作为客户组服务器模型wm的参数其中m∈{1,2,

…

,m}。

[0101]

进一步的,在每个客户组中,组服务器执行以下计算:

[0102]

根据组内客户端的梯度计算组内平均梯度dm:

[0103][0104]

将平均梯度按模型参数层展开,表示为其中l为模型参数层的总数;

[0105]

对平均梯度逐层计算欧几里得距离,得到一个1

×

l维向量δm,计算公式如下:

[0106][0107]

定义一个超参数β用以调节个性化程度,将δm归一化后乘以β得到组内分层的个性化模型权重ψm,具体计算公式为:

[0108]

ψm=β

·

δm/max(δm)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(5)。

[0109]

第二阶段,原理示意图如图4所示:

[0110]

s400:全局参数服务器将模型wg的第t轮参数下发给m个客户组服务器;t∈(t

pre

,t

total

),其中,t

pre

,t

total

为指定通信轮次。

[0111]

s410:如图2所示,在每个客户组服务器上并行执行以下步骤:

[0112]

s411:组服务器收到参数服务器发来的全局模型wg的第t轮参数

[0113]

s412:组服务器将第t轮全局模型wg的参数与组模型wm的参数使用组内分层的个性化模型权重ψm逐层的加权融合,将组模型wm的参数更新为加权融合过程先将和按层分解为和再对每层的参数进行融合,具体公式为:

[0114][0115][0116]

其中表示中第n层的参数,表示中第n层的参数,n∈{1,2,

…

,l}。

[0117]

s413:组服务器将组模型wm的参数下发给组内的客户端;

[0118]

在每个接收组模型wm的第t轮参数的客户端上并行执行以下训练步骤:

[0119]

s414:客户端将组模型wm的第t轮参数作为初始模型参数,记为表示第k个客户端本地模型的第t轮初始模型参数。

[0120]

基于初始模型参数和从客户持有的原始数据中随机抽取的n个样本组成的训练数据集客户端对本地模型进行训练优化,使用随机梯度下降法sgd进行e轮本地迭代,得到优化后的模型参数

[0121]

s415:客户端使用优化后的模型参数对测试数据集进行预测推理,评估预测效果,并计算梯度

[0122]

s416:客户端将梯度gk发送给相应的组服务器。

[0123]

s417:每个组服务器根据组内客户端训练数据集中的样本数量nk计算客户端k在组内所占权重比例继而使用联邦平均算法fedavg加权聚合组内客户端的梯度,更新组服务器模型wm的参数具体计算公式为:

[0124][0125]

s418:判断迭代次数是否达到指定通信轮次,若满足条件,则执行s420,否则继续执行s413至s418。

[0126]

s420:将组服务器模型wm更新后的参数记为组服务器将组服务器模型wm的参数发送给全局参数服务器。

[0127]

s430:全局参数服务器使用联邦平均算法fedavg加权聚合所有组服务器发送的模型参数得到模型wg的t+1轮的参数具体计算公式为:

[0128]

[0129]

s440:判断模型是否收敛或者迭代次数是否达到指定通信轮次,若满足某一条件,则结束训练,所有客户端使用其相应的组模型对客户端测试数据集进行测试;否则继续执行s400至s440。

[0130]

在s210和s414中,所述的基于初始模型参数和训练数据集对客户端本地模型进行训练优化,得到优化后的初始模型参数具体计算公式为:

[0131][0132][0133]

其中,表示所抽样训练数据集的样本数量,为损失值,x和y分别表示数据集中单个样本的特征和对应标签,表示模型输出结果与真实值y之间的损失,η表示学习率,表示对于的梯度。

[0134]

本技术实施例中提供的一个或多个技术方案,至少具有如下技术效果或优点:

[0135]

由于集成了客户聚类方法,本实施例可在不获取客户真实数据的前提下将客户按数据分布的相似性进行分组,客户可加入本实施例系统进行模型的训练与推理;由于集成了自适应分层融合方案,客户可通过本实施例获得最适合自己的个性化模型,同时本实施例维护一个具有良好泛化性能的全局模型,以方便新的客户加入或使用本实施例的个性化联邦学习系统。本实施例解决了联邦学习中数据统计异质性问题以及个性化联邦学习中全局模型和局部模型的性能不平衡的问题,达到了在不损害全局泛化能力的前提下大幅提高客户局部模型的个性化性能的技术效果。

[0136]

下面参考图5来描述本技术实施例的电子设备,基于与前述实施例中一种基于自适应聚类分层的个性化联邦学习方法相同的发明构思,本技术实施例还提供了一种基于自适应聚类分层的个性化联邦学习系统,包括:处理器,所述处理器与存储器耦合,所述存储器用于存储程序,当所述程序被所述处理器执行时,使得系统以执行第一方面任一项所述的方法。

[0137]

该电子设备300包括:处理器302、通信接口303、存储器301。可选的,电子设备300还可以包括总线架构304。其中,通信接口303、处理器302以及存储器301可以通过总线架构304相互连接;总线架构304可以是外设部件互连标(peripheral component interconnect,简称pci)总线或扩展工业标准结构(extended industry standard architecture,简称eisa)总线等。所述总线架构304可以分为地址总线、数据总线、控制总线等。为便于表示,图5中仅用一条粗线表示,但并不表示仅有一根总线或一种类型的总线。

[0138]

处理器302可以是一个cpu,微处理器,asic,或一个或多个用于控制本技术方案程序执行的集成电路。

[0139]

通信接口303,使用任何收发器一类的装置,用于与其他设备或通信网络通信,如以太网,无线接入网(radio access network,ran),无线局域网(wireless local area networks,wlan),有线接入网等。

[0140]

存储器301可以是rom或可存储静态信息和指令的其他类型的静态存储设备,ram或者可存储信息和指令的其他类型的动态存储设备,也可以是电可擦可编程只读存储器

(electrically erasable programmable read-only memory,eeprom)、只读光盘(compact discread-only memory,cd-rom)或其他光盘存储、光碟存储(包括压缩光碟、激光碟、光碟、数字通用光碟、蓝光光碟等)、磁盘存储介质或者其他磁存储设备、或者能够用于携带或存储具有指令或数据结构形式的期望的程序代码并能够由计算机存取的任何其他介质,但不限于此。存储器可以是独立存在,通过总线架构304与处理器相连接。存储器也可以和处理器集成在一起。其中,存储器301用于存储执行本技术方案的计算机执行指令,并由处理器302来控制执行。处理器302用于执行存储器301中存储的计算机执行指令,从而实现本技术上述实施例提供的一种基于自适应聚类分层的个性化联邦学习方法。

[0141]

以上仅是本发明的优选实施方式,本发明的保护范围并不仅局限于上述实施例,凡属于本发明思路下的技术方案均属于本发明的保护范围。应当指出,对于本技术领域的普通技术人员来说,在不脱离本发明原理前提下的若干改进和润饰,应视为本发明的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1