基于多任务学习的无人机视觉深度估计网络及其估计方法

1.本发明属于无人机视觉导航技术领域,具体涉及一种基于多任务学习的无人机视觉深度估计网络及其估计方法。

背景技术:

2.视觉导航是无人机主要的导航手段之一,可与卫星导航、惯性导航组合应用,为无人机提供所需的导航参量。视觉导航主要分为图像获取、图像处理、图像识别与匹配定位等步骤。由于无人机的飞行速度快,且视觉导航的图像处理时延大,因而无法达到无人机对于导航精度的需求。现有的深度估计方法只采用了深度估计子网络进行无监督的回归得到深度值,而导致对图像中有阴影或遮挡的区域的深度估计不准确。

技术实现要素:

3.本发明的目的是提供一种基于多任务学习的无人机视觉深度估计网络及其估计方法,以解决现有深度估计方法对图像中有阴影或遮挡的区域的深度估计不准确的问题。

4.本发明采用以下技术方案:基于多任务学习的无人机视觉深度估计方法,包括:按照以下步骤实施:

5.步骤s1、无人机传感器采集环境信息,再获得环境信息中的三张单帧图像的语义分割结果,三张单帧图像分别为前一帧图像、当前帧图像和后一帧图像;

6.其中,获得每一张单帧图像的语义分割结果的方法相同,具体为:

7.将一张单帧图像输入至适配器,适配器对单帧图像的不同区域特征进行提取,得到单帧图像的不同结构的图像特征;将单帧图像的图像特征输入到语义分割子网络,通过标签松弛得到一张单帧图像的语义分割结果;

8.步骤s2、将三张单帧图像的语义分割结果均反馈给适配器,以反馈调整适配器;

9.步骤s3、将步骤s1中的三张单帧图像发送至经步骤2反馈调整后的适配器,得到三张单帧图像的图像特征,将三张图像特征发送至深度估计子网络,以估计得到当前时刻场景中的标记物相对无人机的深度。

10.进一步的,适配器包括不同尺度的特征提取算子。

11.进一步的,标签松弛方法为:针对同一目标内与不同目标边界上的像素进行区分处理。

12.进一步的,深度估计子网络包括depth network网络和posenetwork网络。

13.本发明采用的第二种技术方案是,一种基于多任务学习的无人机视觉深度估计网络,基于一种基于多任务学习的无人机视觉深度估计方法,包括:

14.一适配器,用于接收无人机传感器采集的图像,并对图像的不同区域特征进行提取,得到图像特征;

15.一语义分割子网络,与适配器连接,用于接收适配器发送来的图像特征,并通过标签松弛方法得到对应图像的语义分割结果;还用于将语义分割结果反馈至适配器;

16.一深度估计子网络,用于接收经过语义分割结果反馈处理的适配器发送来的图像特征,并估计场景中的标记物相对无人机的深度。

17.本发明的有益效果,本发明的语义分割子网络采用ssar算法,对无人机获取的图像进行实时处理,提升了图像处理的速度,提升了实时性,满足视觉匹配对于图像实时处理的需求。在无人机视觉导航任务需求下,将语义分割的ssar算法与深度估计组合应用,将二者结果进行多任务学习,两个任务之间互补,使深度估计对阴影和遮挡区域更准确,最终得到完整准确的视觉导航深度信息,解决了现有深度估计方法对图像中有阴影或遮挡的区域的深度估计不准确的问题。本发明的方法不改变飞机现有的电子设备,只是通过软件方式,采用多任务的语义分割结合深度估计的算法,对传感器获取的图像进行端到端的处理,实现简单,还可以有效解决无人机视觉导航速度慢的问题。

附图说明

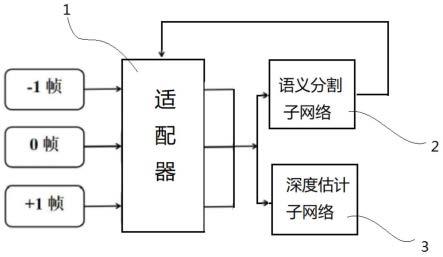

18.图1为本发明的结构示意图。

19.图中,1.适配器,2.语义分割子网络,3.深度估计子网络。

具体实施方式

20.下面结合附图和具体实施方式对本发明进行详细说明。

21.本发明提供了一种基于多任务学习的无人机视觉深度估计方法,如图1所示,按照以下步骤实施:

22.步骤s1、无人机传感器采集环境信息,再获得所述环境信息中的三张单帧图像的语义分割结果,三张所述单帧图像分别为前一帧图像、当前帧图像和后一帧图像;

23.其中,获得每一张所述单帧图像的语义分割结果的方法相同,具体为:

24.将一张所述单帧图像输入至适配器1,所述适配器1对所述单帧图像的不同区域特征进行提取,得到所述单帧图像的不同结构的图像特征;将所述单帧图像的图像特征输入到语义分割子网络2,通过标签松弛得到一张所述单帧图像的语义分割结果。

25.语义分割技术可以将图像中不同的物体进行分类并赋予标签,而ssar算法在原有语义分割诸多算法基础上,更加注重图像处理的实时性,提升图像处理的效率。目前无人机上都配备了实现视觉导航所必须的传感器,传感器可以感知动态环境并获取丰富的在线环境信息。获取的环境信息送入处理器内,经过采样,提取图像中的特征信息,通过匹配得到无人机当前的位置信息。无人机传感器获得环境信息,经过不同层次的下采样,送入不同的适配器1中,适配器1聚合来自不同层次的采样结果,再采用标签松弛法,首先从标签映射中创建一个热点标签,扩大每个单热点标签通道,将其转化为沿边界的多热点标签,通过多次判定后确定不同的区域所需的采样率大小,目的是使边界区域采样率更高,能够清晰分辨不同物体,相而同物体内部区域采样率较低,减少处理像素数量,最后输出,匹配后得到视觉导航的结果。适配器1聚合不同层次的空间信息,促进了梯度从更深层次到较浅层次的流动。本发明的目的在于采用语义分割的ssar算法,处理传感器获取的图像,提升了图像处理的速度,提升了实时性。这种方式不改变飞机现有的电子设备,只是通过软件方式,方法简单易行,且可以有效解决无人机视觉导航速度慢的问题。

26.步骤s2、将三张所述单帧图像的语义分割结果均反馈给所述适配器1,以反馈调整

适配器1;

27.步骤s3、将所述步骤s1中由无人机传感器采集的三张单帧图像再次发送至经步骤2反馈调整后的所述适配器1,得到三张所述单帧图像的图像特征,将三张所述图像特征发送至深度估计子网络3,通过深度估计得到当前时刻场景中的标记物相对无人机的深度。

28.在一些实施例中,适配器1包括不同尺度的特征提取算子。适配器1是一个特征融合算子,用于融合三个不同尺度的信息,将不同的采样率特征进行融合,其是语义分割子网络2的核心模块。ssar算法对一幅图像进行不同尺度的采样,然后对不同尺度的图通过适配器1进行特征融合,在融合过程中,针对不同区域的像素采用的尺度不同,对区域比较均匀的区域采用尺度较大的采样,不同类别的边缘区域采用尺度小的采样,对语义分割结果进行约束,也就是标签松弛,不同区域的标签松弛尺度不同。这种标签松弛的方式通常是用于处理图像中不同的纹理结构。

29.在一些实施例中,标签松弛方法为:针对同一目标内与不同目标边界上的像素进行区分处理。

30.在一些实施例中,深度估计子网络3包括depth network网络和posenetwork网络。

31.深度估计子网络3由两个网络组成,分别是depth network和pose network。depth network用来预测图像的深度,在传统的单目深度估计中,是利用unet算法单独完成图像深度的预测,主要依靠其中的编码器和解码器来完成预测。但是,由于无人机视觉导航也存在航拍图像处理的需求,所以在前期研究的基础上,ssar算法就已经达成了depth network的目标。ssar算法相较于unet算法,不仅具有多层的编码器和解码器结构,而且,ssar算法的图像处理精度要远远高于unet算法,能够对深度进行更精确高效的预测。pose network是一个视觉定位的网络,原理是计算拍摄点的变换,可以获得6自由度的位置姿态信息,作用是预测同一物体在不同帧的变换,主要解决由于物体运动而出现的边界被遮挡的情况,现有的定位精度还要略优于gps。

32.深度估计子网络3工作时,将输入的图像记为第0帧,还需要输入前一帧和后一帧,记为-1帧和+1帧。先通过depth network对三帧连续图像进行预测,再将-1帧和+1帧的预测结果作为输入送到pose network之中,经过计算得到两帧图像的位置姿态变换结果。在这个过程中,网络中的编码器之间可以共享信息,以便于特征信息的预测。编码器是适配器1的一部分,三幅图片的编码特征可以共享。本发明可以通过三帧连续图像的预测深度计算得到重建后的图像。

33.本发明还提供了一种基于多任务学习的无人机视觉深度估计网络,如图1所示,包括:

34.一适配器1,用于接收无人机传感器采集的图像,并对图像的不同区域特征进行提取,得到图像特征;

35.一语义分割子网络2,与所述适配器1连接,用于接收所述适配器1发送来的图像特征,并通过标签松弛方法得到对应图像的语义分割结果;还用于将所述语义分割结果反馈至所述适配器1;

36.一深度估计子网络3,用于接收经过语义分割结果反馈处理的所述适配器1发送来的图像特征,并估计场景中的标记物相对无人机的深度。

37.深度估计与语义分割同属于计算机深度学习的分支,且都主用于视觉领域。其技

术原理是根据图像中像素位置的相对运动关系,去估计图像中像素距离拍摄点距离的深度学习技术。如果在不同的拍摄点对同一物体进行连续拍照,像素坐标位置前后差异较大,则说明拍摄点距离物体较近,像素坐标位置前后差异较小,则说明拍摄点距离物体较远。深度估计主要有单目深度估计与双目深度估计两种。单目深度估计是利用同一台拍摄设备在不同时刻、不同地点对同一物体进行连续的拍照,对图像进行处理得到深度估计结果,其优点是成本低、体积小、能耗少。双目深度估计是模仿人眼的成像原理,利用不同的拍摄设备在不同地点对同一物体进行拍照,再依据光沿直线传播的原理,就可以确定物体的位置,存在的主要问题是容易造成物体的几何边界模糊,丢失细节信息。因为无人机自身机动性能较差,如果配备两套视觉传感器完成双目深度估计,就会增加无人机的体积与重量,这会使无人机的缺点进一步放大,飞行速度更慢,灵活性更低,整体作战性能都会受到很大影响。且单目深度估计可以依靠一架无人机自身实现,如果是利用两台无人机实现双目深度估计,那么还需要解决无人机之间的协同问题,在两架无人机进行信息交互的过程中容易被侦测到并易被干扰。因此,单目深度估计更加适用于无人机。

38.在传统的自监督单目深度估计子网络中,在处理图像的重投影误差时,一般采用先将三帧连续图像的误差计算出来,而后取平均值的方法。这种方法在遇到物体被遮挡的情况时,重建后的图像依然会存在遮挡,这样误差就会变得不可控,从而影响全局的精度。在其基础上本发明将所有图像中误差最小值当做第0帧的误差,最大限度减少了重建后图像的遮挡,也减少了图像的损失。

39.本发明由语义分割子网络2和深度估计子网络两部分组成。语义分割子网络2输入无人机航拍图像,通过ssar算法对像素分配标签,得到分割结果,然后将提取到的特征信息与地图库进行匹配,就可以得到无人机当前所处的区域位置信息。深度估计子网络则是输入连续的航拍图像,先由pose network完成图像的重建,得到物体被遮挡损失最小的图像,再通过预测网络得出图像中物体距离无人机的距离,且由多次预测得到的同一物体距离信息可以得到无人机当前运行的方向。通过多任务学习,就可以建立语义分割任务与深度估计任务之间的联系。语义分割子网络可以为深度估计子网络提供额外的语义信息,辅助深度估计得到距离信息的同时也能使距离信息更精准,这样就能在一定程度上克服自监督深度估计无标签的问题,使得预测效果更鲁棒。同时,多任务学习有着较强的泛化效果,通过同时完成两个任务,可以将得到的特征更好的泛化到其他物体类别上,有助于无人机在陌生环境下也能通过多任务模型学习到精准的信息。将两个网络输出的结果进行多任务学习之后,就得到了无人机视觉深度估计的结果,可以为无人机视觉导航提供极大的辅助作用。

40.本发明的语义分割子网络采用ssar算法,对无人机获取的图像进行实时处理,提升了图像处理的速度,提升了实时性,满足视觉匹配对于图像实时处理的需求。在无人机视觉导航任务需求下,将语义分割的ssar算法与深度估计组合应用,将二者结果进行多任务学习,两个任务之间互补,使深度估计对阴影和遮挡区域更准确,最终得到完整准确的视觉导航深度信息,解决了现有深度估计方法对图像中有阴影或遮挡的区域的深度估计不准确的问题。本发明的方法不改变飞机现有的电子设备,只是通过软件方式,采用多任务的语义分割结合深度估计的算法,对传感器获取的图像进行端到端的处理,实现简单,还可以有效解决无人机视觉导航速度慢的问题。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1