一种融合监督学习的智能决策方法与流程

1.本发明属于深度强化学习领域,特别涉及该领域中的一种融合监督学习的智能决策方法。

背景技术:

2.随着科学技术的不断进步,强化学习和深度学习相结合,形成了深度强化学习领域,其在游戏、无人机编队、自动驾驶和物流调配等场景下表现出超越人类的水准。深度强化学习技术的核心思想是智能体在运行环境中自主试探,然后逐渐从自身所犯“错误”以及所获得的“奖励”信息中学习知识,从本质上来讲就是在不断增加对环境的探索程度或者说认知程度。这种训练方式在相对简单的环境中,智能体可以通过大量尝试,也即回合数目较多的训练,从而对环境中所包含的知识进行学习。但是随着环境复杂度的增加,尤其是在多智能体环境中,会使得环境中所包含的知识急剧膨胀,从而使得智能体探索和学习变得十分困难,需要进一步的引导才能使智能体学习到有用知识。

3.目前已有通过迁移加速多智能体深度强化学习训练的方式,如a3c使用迁移搭配分布式训练的方法,提升了训练速度和模型性能;impala使用迁移搭配分布式进行训练数据采集,实现了训练数据高效收集;epc通过迁移搭配课程学习的方法,使得多智能体团队可以实现规模快速扩张;maddpg-en通过迁移搭配维度表征的方法,使得多智能体团队可以在一定程度上适应智能体规模的变化。尽管深度强化学习迁移研究已经在多方面取得了卓越成果,比如通过迁移实现智能体规模扩充,通过任务间映射实现智能体策略和知识迁移、通过泛化性的提升实现迁移性的提升等等,但是现有的深度强化学习算法在面对多智能体环境时,仍存在一定缺陷:大部分是先在简单源任务中进行训练,然后再迁移到目标任务中,但是不论源任务场景有多简单,其训练仍是使用深度强化学习来进行的。这种加速方式对训练速度的提升极其有限,对源任务的设计和挑选也是一个耗时费力的过程,此外这种方式也无法保证被训练的智能体含有在目标任务中有效的知识。

技术实现要素:

4.本发明所要解决的技术问题就是提供一种融合监督学习的智能决策方法,实现监督学习和强化学习的融合,通过对监督学习网络的设计达到知识通用并完成迁移,使智能体具备一定的先验知识,完成快速有效的前期学习过程,以此加强智能体训练的速度和效率,提升智能体对环境的基础认知能力,极大提升算法的收敛速度。

5.本发明采用如下技术方案:

6.一种融合监督学习的智能决策方法,其改进之处在于,包括如下步骤:

7.步骤1,构建深度强化学习网络:

8.针对环境建立强化学习算法,构建深度强化学习网络,确定深度强化学习网络的输入、输出以及网络结构,并同时随机初始化深度强化学习网络参数;

9.将监督学习思想与强化学习算法ddpg结合,深度强化学习网络训练方式遵照ddpg

算法的训练模式进行;

10.步骤2,分析环境,提取环境特征:

11.依据环境特征制作环境模拟器并同时赋予模拟器专家经验o

exp

→aexp

和随机经验o

others

→aothers

;

12.设环境e,智能体在该环境中的观测维度为no,动作维度为na,在该环境中存在正确的专家经验,也就是存在正确的观测动作对,记o

exp

→aexp

,其中o

exp

的维度为no,a

exp

的维度为na,对环境中剩余的观测o

others

随机生成观测动作对,记做o

others

→aothers

;

13.步骤3,构建与深度强化学习网络actor部分结构相同的监督学习网络,并使用环境模拟器生成数据训练监督学习网络:

14.构建与深度强化学习网络actor部分结构相同的监督学习网络,并随机初始化网络参数θ,使用训练集o

exp

→aexp

和o

others

→aothers

训练监督学习网络sv直到网络收敛,记此监督学习网络参数为θ

′

;

15.监督学习网络更新方式如下:

16.先计算其中,on∈{o

exp

→aexp

}∪{o

others

→aothers

},代表在观察on下监督学习网络预测出来的动作,也就是预测标签,softmax()是一种把输出值转换至[0,1]范围内、且输出值和为1的函数,w是权重,b是偏置,

[0017]

然后使用梯度下降法,最小化损失函数l(θ):

[0018][0019]

其中,θ是监督学习网络的初始化网络参数,n是该网络的训练批次,an是在集合{o

exp

→aexp

}∪{o

others

→aothers

}中on的实际映射,也就是真实标签;

[0020]

训练完成后的监督学习网络参数θ

′

中包含正确的专家经验,也就是包含正确的观测动作对o

exp

→aexp

;

[0021]

步骤4,将训练完成后的监督学习网络参数θ

′

迁移给深度强化学习网络actor部分并开启强化学习训练:

[0022]

将网络参数θ

′

迁移赋值给深度强化学习网络actor部分,使用网络参数θ

′

来初始化环境e中actor-critic框架深度强化学习网络的actor部分,使深度强化学习网络的actor部分同样包含专家经验o

exp

→aexp

;

[0023]

步骤5,训练评价网络:

[0024]

开启深度强化学习网络critic部分的更新,并同时关闭深度强化学习网络actor部分的更新,训练critic直至网络收敛,critic网络与actor网络匹配,该部分网络更新公式为:

[0025][0026]

其中,j(w)为critic网络损失函数,m为批次大小,y是目标值,q()是值函数,φ(s)是全局状态s的特征,a表示所有动作,w为critic网络的参数;

[0027]

步骤6,深度强化学习整体训练:

[0028]

当critic网络达到收敛之后,开启actor网络更新,进行整体深度强化学习的训练,直至网络收敛,训练更新公式为:

[0029][0030]

其中,j(θ)为actor网络损失函数,s是特定智能体的状态,a是特定智能体的动作。

[0031]

本发明的有益效果是:

[0032]

本发明所公开的方法,通过迁移手段加快模型训练速度,在保证智能体包含有效知识方面,提出了融合监督学习的深度强化学习方法,通过“监督预训练->知识迁移->强化学习”的流程,实现预先为模型输入一些已有的专家经验,从基础上极大的提升了模型对环境的认知。

[0033]

本发明方法依赖监督学习加快强化学习的训练和收敛速度,结构简单清晰,易于实现,能较为便利的迁移到不同场景下进行智能体学习。对于生活中常见的无人机编队、自动驾驶、交通路口规划、智能体群体协同等问题都有实际参考意义。

[0034]

本发明方法针对复杂环境下智能体难以快速训练的问题进行了定制化设计,较好的解决了这一问题,能结合任意强化学习算法进行效率和速度方面的性能提升,具有先进性、稳定性和实用性。应用范围广泛,经过融合监督学习训练的智能体比使用纯强化学习算法训练耗时缩短25%,比先在相近环境下训练,再迁移至目标环境下训练的强化学习方法耗时缩短40%。

附图说明

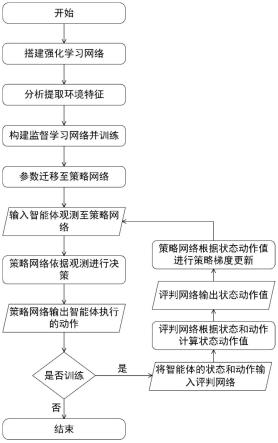

[0035]

图1是本发明方法的流程示意图;

[0036]

图2是本发明方法的模型结构图。

具体实施方式

[0037]

为了使本发明的目的、技术方案及优点更加清楚明白,以下结合附图和实施例,对本发明进行进一步详细说明。应当理解,此处所描述的具体实施例仅仅用以解释本发明,并不用于限定本发明。

[0038]

本发明在训练和执行期间的流程不同,主要区别在于训练期间评判网络根据智能体的动作和状态衡量其动作价值,在执行期间智能体则依赖策略网络根据自身观测进行决策,利用监督学习加快训练速度。

[0039]

实施例1,如图1,2所示,本实施例公开了一种融合监督学习的智能决策方法,每个智能体具备负责自身决策的策略网络和负责评判自身决策价值的评判网络;以及预先设计的监督学习网络。所有网络均由深度神经网络实现。包括如下步骤:

[0040]

步骤1,构建深度强化学习网络:

[0041]

针对环境建立强化学习算法,构建深度强化学习网络,确定深度强化学习网络的输入、输出、隐藏层以及网络结构,并同时随机初始化深度强化学习网络参数;

[0042]

将监督学习思想与强化学习算法ddpg结合,深度强化学习网络训练方式遵照ddpg算法的训练模式进行;本发明的融合机制可以与任意强化学习算法结合。

[0043]

步骤2,分析环境,提取环境特征(提取出环境中主要特点以及影响智能体决策行

动的主要因素):

[0044]

依据环境特征制作环境模拟器并同时赋予模拟器专家经验o

exp

→aexp

和随机经验o

others

→aothers

;

[0045]

设环境e,智能体在该环境中的观测维度为no,动作维度为na,在该环境中存在正确的专家经验,也就是存在正确的观测动作对,记o

exp

→aexp

,其中o

exp

的维度为no,a

exp

的维度为na,对环境中剩余的观测o

others

随机生成观测动作对,记做o

others

→aothers

;

[0046]

步骤3,构建与深度强化学习网络actor部分结构相同的监督学习网络,并使用环境模拟器生成数据训练监督学习网络:

[0047]

构建与深度强化学习网络actor部分结构相同的监督学习网络,并随机初始化网络参数θ,使用训练集o

exp

→aexp

和o

others

→aothers

训练监督学习网络sv直到网络收敛,记此监督学习网络参数为θ

′

;

[0048]

监督学习网络更新方式如下:

[0049]

先计算其中,on∈{o

exp

→aexp

}∪{o

others

→aothers

},代表在观察on下监督学习网络预测出来的动作,也就是预测标签,softmax()是一种把输出值转换至[0,1]范围内、且输出值和为1的函数,w是权重,b是偏置,

[0050]

然后使用梯度下降法,最小化损失函数l(θ):

[0051][0052]

其中,θ是监督学习网络的初始化网络参数,n是该网络的训练批次,an是在集合{o

exp

→aexp

}∪{o

others

→aothers

}中on的实际映射,也就是真实标签;

[0053]

训练完成后的监督学习网络参数θ

′

中包含正确的专家经验,也就是包含正确的观测动作对o

exp

→aexp

;

[0054]

步骤4,将训练完成后的监督学习网络参数θ

′

迁移给深度强化学习网络actor部分并开启强化学习训练:

[0055]

将网络参数θ

′

迁移赋值给深度强化学习网络actor部分,使用网络参数θ

′

来初始化环境e中actor-critic框架深度强化学习网络(以ddpg算法网络为例)的actor部分,使深度强化学习网络的actor部分同样包含专家经验o

exp

→aexp

;

[0056]

步骤5,训练评价网络:

[0057]

开启深度强化学习网络critic部分的更新,并同时关闭深度强化学习网络actor部分的更新,训练critic直至网络收敛,critic网络与actor网络匹配,该部分网络更新公式为:

[0058][0059]

其中,j(w)为critic网络损失函数,m为批次大小,y是目标值,q()是值函数,φ(s)是全局状态s的特征,a表示所有动作,w为critic网络的参数;

[0060]

步骤6,深度强化学习整体训练:

[0061]

当critic网络达到收敛之后,开启actor网络更新,进行整体深度强化学习的训

练,直至网络收敛,训练更新公式为:

[0062][0063]

其中,j(θ)为actor网络损失函数,s是特定智能体的状态,a是特定智能体的动作。

[0064]

综上所述,经过监督学习提前指导的强化学习方法能更好的了解环境,利用先验知识进一步加快学习和探索速度,提升训练效果和效率。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1