一种基于深度自适应度量学习的面部表情识别方法

本发明属于人工智能算法和计算机视觉,尤其涉及一种基于深度自适应度量学习的面部表情识别方法。

背景技术:

1、随着人工智能的发展,情感计算已经成为人工智能情感化的关键一步,面部表情显然是传达人类情感最直接的方式。具体来说,这些基本情绪状态主要包括高兴、生气、悲伤、恐惧、厌恶、惊讶和中性。由于面部表情识别(fer)在医疗辅助、驾驶员监控、智能教育、电商等领域的广泛应用,已成为计算机视觉领域一个活跃的研究课题。例如,商家通过记录消费者在浏览商品时的表情预测产品销量,为下一期的产品设计做好准备。

2、现有的大多数面部表情识别方法主要针对受控的实验室环境,不能很好地适应复杂的自然环境。在非受控的自然环境下,面部遮挡和姿势变化是影响识别性能的两个关键问题,它们导致了显著的类间相似性和类内差异性,同时产生了类别分布不平衡的特点。在现有方案中,面部表情识别方法主要分为以下几种方式:

3、(1)使用传统方法进行表情识别:传统的表情识别方法多为先手工设计特征或进行浅层学习,例如局部二值模式(local binary pattern,lbp)、非负矩阵分解(nonnegative matrix factorization,nmf)和稀疏学习等,而后再选择分类器进行表情分类,主要有决策树、支持向量机(svm)、k最邻近(knn)和adaboost等。虽然所需数据量较小,但在实际应用中准确率不高。在传统的表情识别方法中,人工特征提取方法对某些特定数据往往能有较好的效果,但是这种提取方法并不通用,当面对不同的数据集或数据规模较大时,其准确性会下降。它的主要问题在于其针对某种数据库提取的特征和训练的分类器的泛化能力不强,由于自然环境中存在光照、姿势、变形、遮挡等复杂情形,最终输入的测试样本跟训练样本可能存在巨大的差异,这就导致了最终的识别结果不能让人满意。

4、(2)使用深度学习方法进行识别:近年来,随着人工智能的发展,深度学习技术得到了广泛应用,各个领域的研究也开始转向使用深度学习方法。基于深度学习的人脸识别、目标检测、姿态估计取得了显著的效果,这对表情识别有一定的借鉴意义。将深度学习技术运用到人脸表情识别中,使用卷积神经网络以“端到端”的方式完成特征提取和分类,能够提取更深层的表情特征,从而提高面部表情分类识别性能,使用深度学习方法进行表情识别的精度较高。该方法大多使用经典的分类模型,可以有效的识别面部表情,准确率较高。虽然利用深度学习能自动地获得表征能力和泛化性更强的特征,有效避免了传统方法的不足,但现有模型仍存在两个主要缺陷:1)卷积神经网络以平等方式处理图像中所有元素,对表情信息丰富的面部关键区域关注不足;2)使用经典损失函数训练模型无法控制表情类内差异性和数据分布不平衡带来的影响,不能为表情识别任务提供足够的鉴别信息。

5、中国专利文献(cn 113792572 a)公开了一种基于局部表征的表情识别算法,称为表情运动单元卷积神经网络,为提取面部的局部特征,该文首先根据获取的人脸68个特征点将整体面部图像划分成43个子区域,随后选择肌肉运动区域与面部显著器官所覆盖的8个局部候选区域作为卷积神经网络的输入。为均衡局部候选区域的特征,采用8个并行的特征提取分支,每个分支支配不同维全连接层。分支的输出按照注意力自适应地连接,以突出不同局部候选区域的重要程度,最后经softmax函数将表情分为中性、愤怒、厌恶、惊讶、高兴、悲伤和恐惧七类。但该发明中识别的表情仅为设定的七类,且不能很好地适应复杂的自然环境。

6、因此,针对此问题,有必要提出一种基于深度自适应度量学习的面部表情识别方法,从非平衡表情数据中学习更具辨别力的情感表征,能够较好地进行表情特征学习,具有对不同类表情特征进行分类的能力,对未知表情特征也可以较好的进行分类识别,极大改善了识别模型的鲁棒性和泛化性,提高自然环境下表情识别的性能。

技术实现思路

1、本发明的目的是解决在复杂的自然环境中如何准确地识别面部表情提出了一种基于深度自适应度量学习的面部表情识别方法,能够较好地进行表情特征学习,具有对不同类表情特征进行分类的能力,对未知表情特征也可以较好的进行分类识别,极大改善了识别模型的鲁棒性和泛化性,提高复杂的自然环境下表情识别的性能。

2、为了解决上述技术问题,本发明采用的技术方案为:该基于深度自适应度量学习的面部表情识别方法,具体包括以下步骤:

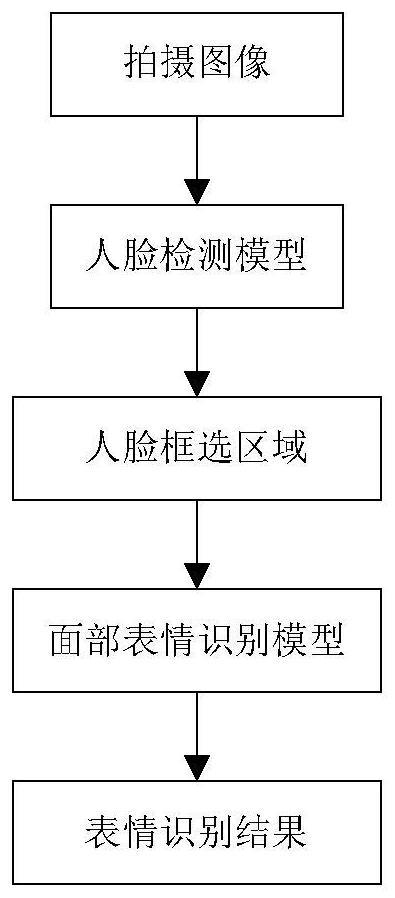

3、s1:通过摄像装置拍摄人脸图像,并使用人脸检测模型对人脸图像进行人脸检测;

4、s2:构建表情识别主干模型,使用轻量级resnet18作为网络的骨干网,用上下文卷积代替普通卷积,并采用协调注意(coordination attention,ca)模块对各个阶段获得的空间信息进行调制,经过全局平均池化层,得到嵌入特征向量,获得空间特征图;

5、s3:构建自适应注意模块,利用自适应注意模块对骨干网提取的特征进行编码,有区分地对待不同人脸特征;

6、s4:利用自适应注意模块生成的权值对中心损耗中每个维度的欧氏距离进行加权,过滤掉不相关的特征,提取与表情识别有关的人脸特征训练表情识别模型;

7、s5:使用步骤s4中训练得到的表情识别模型进行面部表情检测,输出识别结果。

8、采用上述技术方案,首先进行人脸检测,提取到每个单独的人脸图像,然后使用resnet18作为骨干模型,提取图像特征;然而,该模型的性能很大程度取决于其在训练过程中对数据特征的学习能力,但自然环境下的表情数据往往存在数据分布不平衡,类间特征相似度高和类内特征差异性大的特点,经典深度学习模型对少数样本的学习强度不够,难以捕获细微的表情变化,因此无法学习到具有辨别力的表情特征。

9、因此本发明提出将resnet18中的普通卷积替换成上下文卷积,并在每个阶段使用了协调注意力模块进行调制,以此来增强特征表征能力;与resnet18的大部分不同,用多级上下文卷积来整合面部表情的上下文空间信息,在不增加网络复杂度的情况下提取出更鲁棒的面部特征,但上下文卷积虽然可以提高fer的精度,但也增加了空间信息的冗余,因此,嵌入了协调注意(ca)模块来关注显著特征。为了更好的学习表情相关特征而不受其它因素的干扰,提出自适应注意模块,产生注意力权重加权各类特征与其中心之间的欧氏距离,捕捉对细微的表情变化更敏感的特征,滤除不相关信息,大大增加了模型学习特征的准确性。该方法能够较好地进行表情特征学习,具有对不同类表情特征进行分类的能力,对未知表情特征也可以较好的进行分类识别,极大改善了识别模型的鲁棒性和泛化性,提高复杂的自然环境下表情识别的性能。

10、作为本发明的优选技术方案,所述步骤s1的具体步骤为:

11、s11:通过摄像装置拍摄人脸图像,获取人脸图像;

12、s12:将人脸图像中的人脸区域使用矩形框进行框选,去除多余背景,只保留人脸区域;

13、s13:然后对用矩形框框选的区域输入面部表情识别模型。因度量学习方法属于图像识别领域,因此需要将图像中的人脸区域使用矩形框进行框选,去除多余背景,只保留人脸区域。

14、作为本发明的优选技术方案,所述步骤s3的具体步骤为:

15、s31构建自适应注意力模块:利用随机注意力构建自适应注意力模块;

16、s32计算动态权重:将来自步骤s2中的获得的空间特征图作为输入,利用自适应注意力模块生成潜在特征表示,并使用多个二进制分类器计算每个人脸特征元素上的权重值;由于同时关注所有特征可能会包含一些不相关的特征,最终会降低学习算法的泛化能力,因此构建一个自适应注意力模块(aam)来对主干网提取的特征进行编码;以及利用aam生成的权值对中心损耗中每个维度的欧氏距离进行加权,过滤掉不相关的特征。具体为:利用随机注意力(sa)变换特征排列顺序,通过堆叠三个可训练的完全连接线性层,在上下文空间中提取相关信息,计算编码特征;然后将来自resnet18的空间特征图作为输入,aam生成潜在特征表示,并使用多个二进制分类器估计相关权重。

17、作为本发明的优选技术方案,所述步骤s31利用随机注意力构建自适应模块的具体步骤为:

18、s311对输入特征进行分组:对于输入的空间特征图x∈rc×h×w,其中c、h、w分别表示通道数、空间高度和宽度,随机注意力sa首先将x沿通道维数划分为g组,即x=[x1,…,xg],xk∈rc/g×h×w,其中每个子特征xk在训练过程中逐渐捕捉到特定的语义响应;然后,通过注意模块为每个子特征xk生成相应的重要系数;

19、s312捕获通道间的依赖关系:首先嵌入全局信息,使用全局平均池化(gap)生成通道级统计信息,即c∈rc/2g×1×1;再通过门控机制与sigmoid激活函数,得到通道注意的最终输出;

20、s313获取空间位置信息:采用群范数生成空间统计量,生成类似于通道分支的紧凑特征。

21、作为本发明的优选技术方案,所述步骤s311中通过注意模块为每个子特征xk生成相应的重要系数具体步骤为:在每个注意单元开始时,xk的输入沿着通道维度被分成两个分支,即xk1,xk2∈rc/2g×h×w;其中一个分支xk1来产生一个通道注意力来利用通道间的相互关系,而另一分支xk2用于利用空间位置间的关系特性生成一个空间注意力地图。

22、作为本发明的优选技术方案,在其中一个分支xk1上,通过使用全局平均池化(gap)来嵌入全局信息,生成所述步骤s312中的通道级统计信息c∈rc/2g×1×1,通过空间维数h×w收缩xk1来计算通道级统计信息c,公式为:

23、

24、其中,xk1表示该分支上的特征,fqp表示全局平均池化操作;

25、通过门控机制与sigmoid激活函数得到通道注意的最终输出表示为:

26、x′k1=σ(fc(s))·xk1=σ(w1+b1)·xk1 (2);

27、其中,fc表示缩放和移位操作,w1∈rc/2g×1×1和b1∈rc/2g×1×1是用于缩放和移位通道级统计信息c的参数,w1表示缩放尺度,b1表示移位大小;σ表示sigmoid激活函数;

28、在另一个分支xk2上,采用步骤s313中通过群范数成类似于通道分支的紧凑特征,生成一个空间注意力图获取空间位置信息,作为对通道信息的补充,公式为:

29、x′k2=σ(w2·gn(xk2)+b2)·xk2 (3);

30、其中,xk2表示该分支上的特征,gn表示计算xk2的群范数,w2和b2是形状为rc/2g×1×1的缩放和移位参数,σ表示sigmoid激活函数;

31、然后,再将分支xk1和分支xk2串联起来,使通道数与输入数保持一致,即x′k=[x′k1,x′k2]∈rc/g×g×w。

32、作为本发明的优选技术方案,所述步骤s32的具体步骤为:s321:将空间特征图作为输入,通过堆叠三个可训练的完全连接线性层,从上下文空间中提取相关信息,计算编码特征,公式为:

33、

34、其中,是自适应注意力模块的输出特征图,即第i个样本的上下文特征,wl和bl分别是第l个线性层的权重和偏差,其中l=1,2,3;在分层中插入批量归一化bn(.)和整流线性单元relu(.),以捕获层之间的非线性关系;最后的双曲正切函数tanh(.)作为单元的非线性保留了正的和负的激活值,以在网络中获得更平滑的梯度流;

35、s322:再在最后的线性层上附加多个二进制分类器,并在d个线性单元之间共享潜在维数特征向量s,再将softmax函数应用于每个二分类器的输出,得到相应的注意权重aij,公式为:

36、

37、其中,分别表示xi中第j维的包含和排除分数,ej和bj是每个分类头的可学习权重和偏差,下标in表示包含,下标ex表示排除。

38、作为本发明的优选技术方案,所述步骤s4中采用结合平衡损失和稀疏中心损失的联合损失函数用于监督模型学习,具体步骤为:

39、s41用于类失衡的平衡损失:对交叉熵损失进行泰勒展开,公式为:

40、

41、其中,pt为面部表情识别模型对目标表情类的预测概率;1/j为系数;

42、在使用梯度下降法优化交叉熵损失时,应对pt取梯度,而因1/j抵消了公式(5)中的多项式基的j次幂,因此交叉熵损失的梯度为多项式(1-pt)j的和,即公式为:

43、

44、其中,pt为面部表情识别模型对目标表情类的预测概率;表示对pt取梯度;将损失函数设为多项式的线性组合,如下式所示:

45、

46、然后,在交叉熵损失中修正每一项的多项式系数αj,而其余的保持不变,从而对式(8)进行简化得到最终的平衡损失,如下式所示:

47、

48、其中,θ表示系数修正参数,n为交叉熵损失的泰勒展开式项数;

49、s42用于特征细化的稀疏中心损失函数:将获得的各个维度的距离进行加权,从而建立稀疏中心损失,过滤掉不相关的特征,其公式为:

50、

51、其中,⊙为元素级乘法,aij表示上下文空间中第i个深度特征沿第j维的注意力权重;xij为上下文空间中第i个深度特征在第j维上的特征元素;为各类的特征中心;m为训练过程中的批量大小;d为特征向量维度大小。

52、由于交叉熵损失不能解决自然环境下fer的类不平衡和类内差异化问题,同时,其优化能力不足,不能有效提高模型的性能,而模型的训练需要有良好的目标函数,因此构建联合损失函数约束网络学习过程,包括平衡损失和稀疏中心损失,一方面,平衡损失将交叉熵损失扩展为多项式组合,并调整不同多项式基的重要程度,从而在增大各类特征间的距离同时增加对少数样本的学习强度;另一方面,通过计算各类别表情特征的与其中心特征的相似度,内聚类内特征。

53、作为本发明的优选技术方案,所述步骤s1中使用yolov5预训练模型对拍摄图像中的人脸进行检测。

54、与现有技术相比,本发明具有的有益效果为:

55、(1)将resnet18中的普通卷积替换成上下文卷积,并在每个阶段使用了协调注意力机制,以此来增强特征表征能力;

56、(2)利用随机注意力(sa)构建自适应注意模块,产生注意力权重加权各类特征与其中心之间的欧氏距离,捕捉对细微的表情变化更敏感的特征,滤除不相关信息,大大增加了模型学习特征的准确性;

57、(3)构建联合损失函数约束网络学习过程,包括平衡损失和稀疏中心损失,一方面,平衡损失将交叉熵损失扩展为多项式组合,并调整不同多项式基的重要程度,从而在增大各类特征间的距离同时增加对少数样本的学习强度;另一方面,通过计算各类别表情特征的与其中心特征的相似度,内聚类内特征。

- 还没有人留言评论。精彩留言会获得点赞!