移动机器人目标定位方法及系统

1.本技术涉及目标识别技术领域,特别是涉及移动机器人目标定位方法及系统。

背景技术:

2.随着人工智能的发展,人们对智能移动机器人的研究越来越广泛。目前,在目标识别方面多采用传统的目标识别方法,由于形态、光照、背景的多样性使得识别效果不好,准确率不高。而基于深度卷积神经网络的目标检测方法鲁棒性强,识别准确率高。在正确识别目标后,实现目标的姿态估计也较为关键。

3.kinect是一种深度摄像机,kinect v2包含了一个彩色摄像机color camera、一个深度(红外)摄像机depth sensor、一个红外投影机ir emitters和麦克风阵列microphone array,彩色摄像机用于拍摄视角范围内的彩色视频、图像,红外投影机用于投射近红外线光谱,深度(红外)摄像机用于分析红外光谱,通过从投射的红外线反射后返回的时间来取得深度信息,创建可视范围内的人体、物体的深度图像,是一种成本合理,能够用于不同领域、不同场景且精度也比较精确的深度摄像机,精度在2mm~4mm左右,距离越近精度越高。现有的移动机器人目标定位方法通常是通过kinect v2摄像机同时获取场景的彩色图像和深度图像来完成目标的定位。

4.如专利cn112136505a所公开的,现有的目标识别定位方法在彩色图像与深度图像配准部分中,大多是使用sdk(software development kit)提供的映射函数完成两者之间的配准,实现两者信息融合,但是该方法灵活度不够,且因为深度摄像机与彩色摄像机不重合,深度图上的一部分在实际场景中不能被彩色摄像机捕获,配准效果不好,为了深度图像的显示,往往会扩大深度图像数据一定倍数,也导致配准结果不准确;其配准原理主要是将深度摄像机坐标转换到rgb摄像机坐标,再把rgb摄像机坐标转换到rgb平面坐标,更多局限于从深度图像到彩色图像的配准。

5.若反之,从彩色图像到深度图像进行配准,由于kinect v2摄像机的ccd像面单位长度对应的图像像素个数n

x

和ny无法通过查找资料得到,因此,现有技术无法在未知任何深度信息下直接推导出配准关系,缺少配准关系,即便获得彩色图像的像素值,也不能获得深度图像上的坐标值,无法实现目标场景准确目标定位。

技术实现要素:

6.本技术实施例提供了一种移动机器人目标定位方法及系统,以至少解决相关技术中彩色图像到深度图像配准的问题,实现仅依靠kinect v2摄像机进行目标识别和定位,降低运行成本,简单便捷。

7.第一方面,本技术实施例提供了一种移动机器人目标定位方法,包括:目标识别步骤,采集目标彩色图像及深度图像,通过一预训练后的mobilenetv3-ssd模型识别所述目标彩色图像得到目标在所述彩色图像的彩色区域框,得到目标类别及像素坐标(u

rgb

,v

rgb

);

深度信息获取步骤,建立kinect v2摄像机模型并进行摄像机标定,得到彩色摄像机、深度摄像机的内参数、畸变参数及外参数,以建立彩色图像向深度图像转换的配准关系,并基于一优化误差函数对所述配准关系进行迭代优化,基于优化后的配准关系得到目标在深度图像的深度区域框,所述优化误差函数通过以下计算模型计算得到:,其中,是迭代i次后的目标点在彩色图像平面的彩色投影坐标,p

rgb0

为目标点在彩色图像上真实像素坐标,i=1,2,

…

,n,n为迭代次数;点云数据获取步骤,通过遍历所述深度区域框获取其内所有有效深度数据,基于一预设避障范围选取所述有效深度数据中的避障目标深度数据,并获取目标在深度摄像机坐标系下的点云数据;目标定位步骤,将所述点云数据转换至彩色摄像机坐标系以确定目标在彩色摄像机坐标系下的位姿,拟合得到所述移动机器人的避障目标区域。

8.在其中一些实施例中,所述深度信息获取步骤包括:配准关系建立步骤,建立kinect v2摄像机模型并进行摄像机标定,得到彩色摄像机和深度摄像机的内参数a

rgb

和a

depth

、畸变参数、彩色摄像机的外参数r

rgb

和t

rgb

及深度摄像机的外参数r

depth

及t

depth

,从而计算出彩色摄像机和深度摄像机坐标系之间的旋转矩阵和平移向量,建立彩色图像向深度图像转换的配准关系,所述配准关系基于如下计算模型计算得到:ρ1p

depth

=ρ2a

depthrdepthrrgb-1argb-1

p

rgb

+a

depth

(t

depth-r

depthrrgb-1

t

rgb

),其中,ρ1为深度图像中的深度信息,ρ2为彩色图像中的深度信息,p

rgb

为目标点在彩色图像平面的彩色投影坐标,p

depth

为目标点在深度图像平面的深度投影坐标;配准迭代优化步骤,基于kinect v2中彩色摄像机和深度摄像机标定后的真实旋转平移关系以及kinect v2摄像机模型,对配准进行迭代优化。

9.在其中一些实施例中,所述配准迭代优化步骤进一步包括:深度值获取步骤,使彩色摄像机和深度摄像机处于设定近似平行关系后旋转深度摄像机使彩色摄像机和深度摄像机处于真实旋转平移关系,分别采集对应关系下所述目标点在深度图像的深度值,得到初始深度值ρ

10

=z

depth0

及更新深度值ρ

11

=z

depth1

;优化误差函数建立步骤,根据所述真实旋转平移关系及深度摄像机坐标系和彩色摄像机坐标系各自的外参数将深度摄像机坐标p

depth1

转换得到彩色投影坐标p

rgb1

,并建立所述优化误差函数;优化误差函数迭代步骤,配置迭代范围对深度值ρ

1i

=z

depthi

进行迭代,得到误差函数最小的深度值并将对应深度投影坐标经坐标系转换得到所述目标点的彩色摄像机坐标,实现所述目标点彩色图像向深度图像的配准。

10.在其中一些实施例中,所述有效深度数据通过将深度图像转换为灰度图像后,基于如下计算模型计算得到:depth_value=k

×

gray_value

其中,k为尺度因子;gray_value为灰度值。

11.在其中一些实施例中,所述点云数据通过如下计算模型计算得到:,其中,(u,v)用于深度图像上的坐标点,d为坐标点的深度值,f

x

、fy表示深度摄像机的焦距f在x、y方向上像素度量,c

x

、cy表示光轴对于投影平面坐标中心的偏移量。

12.在其中一些实施例中,所述移动机器人的避障目标区域为球面,通过构造一目标函数并对所述目标函数的向量求解偏导数为0求解所述球面;其中,所述球面表示为:;所述目标函数表示为:。

13.在其中一些实施例中,所述避障目标区域还包括一检测得到的避障目标最远距离构成的平面,所述避障目标区域通过如下计算模型计算得到:,其中,z

max

为所述目标最远距离,δ为预设避障安全裕度。

14.第二方面,本技术实施例提供了一种移动机器人目标定位系统,用于实现如上第一方面所述的移动机器人目标定位方法,包括:目标识别模块,用于采集目标彩色图像及深度图像,通过一预训练后的mobilenetv3-ssd模型识别所述目标彩色图像得到目标在所述彩色图像的彩色区域框,得到目标类别及像素坐标(u

rgb

,v

rgb

);深度信息获取模块,用于建立kinect v2摄像机模型并进行摄像机标定,得到彩色摄像机、深度摄像机的内参数、畸变参数及外参数,以建立彩色图像向深度图像转换的配准关系,并基于一优化误差函数对所述配准关系进行迭代优化,基于优化后的配准关系得到目标在深度图像的深度区域框;点云数据获取模块,用于通过遍历所述深度区域框获取其内所有有效深度数据,基于一预设避障范围选取所述有效深度数据中的避障目标深度数据,并获取目标在深度摄像机坐标系下的点云数据;目标定位模块,用于将所述点云数据转换至彩色摄像机坐标系以确定目标在彩色摄像机坐标系下的位姿,拟合得到所述移动机器人的避障目标区域。

15.在其中一些实施例中,所述深度信息获取模块包括:配准关系建立模块,用于建立kinect v2摄像机模型并进行摄像机标定,得到彩色摄像机和深度摄像机的内参数a

rgb

和a

depth

、畸变参数、彩色摄像机的外参数r

rgb

和t

rgb

及深度摄像机的外参数r

depth

及t

depth

,从而计算出彩色摄像机和深度摄像机坐标系之间的旋转矩阵和平移向量,建立彩色图像向深度图像转换的配准关系,所述配准关系基于如下计算模

型计算得到:ρ1p

depth

=ρ2a

depthrdepthrrgb-1argb-1

p

rgb

+a

depth

(t

depth-r

depthrrgb-1

t

rgb

),其中,ρ1为深度图像中的深度信息,ρ2为彩色图像中的深度信息,p

rgb

为目标点在彩色图像平面的彩色投影坐标,p

depth

为目标点在深度图像平面的深度投影坐标;配准迭代优化模块,用于基于kinect v2中彩色摄像机和深度摄像机标定后的真实旋转平移关系以及kinect v2摄像机模型,对配准进行迭代优化。

16.在其中一些实施例中,所述配准迭代优化模块进一步包括:深度值获取模块,用于使彩色摄像机和深度摄像机处于设定近似平行关系后旋转深度摄像机使彩色摄像机和深度摄像机处于真实旋转平移关系,分别采集所述目标点在深度图像的深度值,得到初始深度值ρ

10

=z

depth0

及更新深度值ρ

11

=z

depth1

;优化误差函数建立模块,用于根据所述真实旋转平移关系及深度摄像机坐标系和彩色摄像机坐标系各自的外参数将深度摄像机坐标p

depth1

转换得到彩色投影坐标p

rgb1

,并建立优化误差函数;优化误差函数迭代模块,用于配置迭代范围对深度值ρ

1i

=z

depthi

进行迭代,得到误差函数最小的深度值并将对应深度投影坐标经坐标系转换得到所述目标点的彩色摄像机坐标,实现所述目标点彩色图像向深度图像的配准。

17.相比于相关技术,本技术实施例提供的移动机器人目标定位方法及系统,不依赖于sdk工具包即可实现彩色图像到深度图像的配准优化,实现两者信息融合,降低运行成本且简单便捷;基于卷积神经网络算法进行目标识别,提高了目标识别的准确率和鲁棒性,进一步提高了移动机器人视觉系统的识别准确率。

18.本技术的一个或多个实施例的细节在以下附图和描述中提出,以使本技术的其他特征、目的和优点更加简明易懂。

附图说明

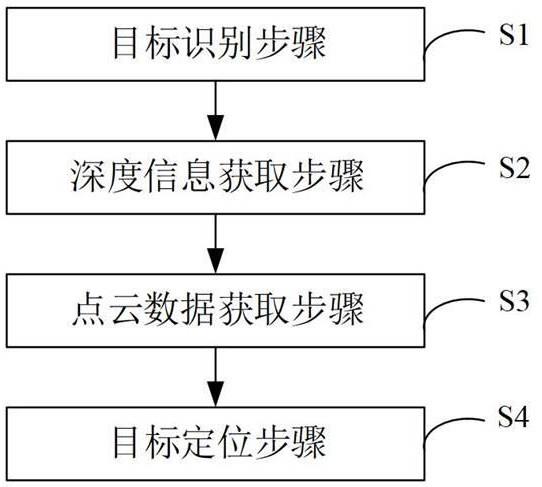

19.此处所说明的附图用来提供对本技术的进一步理解,构成本技术的一部分,本技术的示意性实施例及其说明用于解释本技术,并不构成对本技术的不当限定。在附图中:图1是根据本技术实施例的移动机器人目标定位方法的流程图;图2是根据本技术实施例的移动机器人目标定位方法的分步骤流程图;图3是根据本技术优选实施例的移动机器人目标定位方法的流程图;图4是根据本技术实施例的识别的区域框示意图;图5是根据本技术实施例的摄像机模型示意图;图6是根据本技术实施例的配准原理示意图;图7是根据本技术实施例的配准优化原理示意图;图8是根据本技术实施例的避障目标区域示意图;图9是根据本技术实施例的移动机器人目标定位系统的结构框图。

20.图中:1、目标识别模块;2、深度信息获取模块;3、点云数据获取模块;4、目标定位模块;

21、配准关系建立模块;22、配准迭代优化模块;221、深度值获取模块;222、优化误差函数建立模块;223、优化误差函数迭代模块。

具体实施方式

21.为了使本技术的目的、技术方案及优点更加清楚明白,以下结合附图及实施例,对本技术进行描述和说明。应当理解,此处所描述的具体实施例仅仅用以解释本技术,并不用于限定本技术。基于本技术提供的实施例,本领域普通技术人员在没有作出创造性劳动的前提下所获得的所有其他实施例,都属于本技术保护的范围。

22.显而易见地,下面描述中的附图仅仅是本技术的一些示例或实施例,对于本领域的普通技术人员而言,在不付出创造性劳动的前提下,还可以根据这些附图将本技术应用于其他类似情景。此外,还可以理解的是,虽然这种开发过程中所作出的努力可能是复杂并且冗长的,然而对于与本技术公开的内容相关的本领域的普通技术人员而言,在本技术揭露的技术内容的基础上进行的一些设计,制造或者生产等变更只是常规的技术手段,不应当理解为本技术公开的内容不充分。

23.在本技术中提及“实施例”意味着,结合实施例描述的特定特征、结构或特性可以包含在本技术的至少一个实施例中。在说明书中的各个位置出现该短语并不一定均是指相同的实施例,也不是与其它实施例互斥的独立的或备选的实施例。本领域普通技术人员显式地和隐式地理解的是,本技术所描述的实施例在不冲突的情况下,可以与其它实施例相结合。

24.除非另作定义,本技术所涉及的技术术语或者科学术语应当为本技术所属技术领域内具有一般技能的人士所理解的通常意义。本技术所涉及的“一”、“一个”、“一种”、“该”等类似词语并不表示数量限制,可表示单数或复数。本技术所涉及的术语“包括”、“包含”、“具有”以及它们任何变形,意图在于覆盖不排他的包含;例如包含了一系列步骤或模块(单元)的过程、方法、系统、产品或设备没有限定于已列出的步骤或单元,而是可以还包括没有列出的步骤或单元,或可以还包括对于这些过程、方法、产品或设备固有的其它步骤或单元。本技术所涉及的“连接”、“相连”、“耦接”等类似的词语并非限定于物理的或者机械的连接,而是可以包括电气的连接,不管是直接的还是间接的。本技术所涉及的“多个”是指两个或两个以上。“和/或”描述关联对象的关联关系,表示可以存在三种关系,例如,“a和/或b”可以表示:单独存在a,同时存在a和b,单独存在b这三种情况。字符“/”一般表示前后关联对象是一种“或”的关系。本技术所涉及的术语“第一”、“第二”、“第三”等仅仅是区别类似的对象,不代表针对对象的特定排序。

25.mobilenet v3网络:是谷歌发布于2019年的训练网络架构,包括第一卷积层conv2d、多个bneck结构、第二卷积层conv2d、池化层pool、第三卷积层conv2d及第四卷积层conv2d。

26.本技术主要针对室内环境下移动机器人的目标定位问题,采用kinect v2摄像机作为移动机器人的感知传感器,在进行目标定位过程中,通过彩色图像识别目标并通过摄像机模型的建立、摄像机标定实现彩色图像与深度图像的配准和优化,进而进行彩色图像到深度图像的配准,与现有技术相比,本技术实施例的配准方法无需依赖sdk进行配准,而

且可以实现从彩色图像到深色图像的配准,解决了现有技术无法直接推导出配准关系缺陷。

27.本技术实施例提供了一种移动机器人目标定位方法,图1-图3是根据本技术实施例的移动机器人目标定位方法的流程图,如图1-图3所示,该流程包括如下步骤:目标识别步骤s1,采集目标彩色图像及深度图像,通过一预训练后的mobilenetv3-ssd模型识别目标彩色图像得到目标在彩色图像的彩色区域框,如图4所示,以得到目标类别及像素坐标(u

rgb

,v

rgb

);其中,mobilenetv3-ssd模型使用ssd网络作为元结构,通过将mobilenetv3网络的池化层及池化层之后的卷积层去掉后增加四个特征提取层形成,从而通过选择六个特征提取层生成一系列尺寸固定的区域框,并对框中存在的类别进行评分,并采用非极大抑制方法解决检测结果中区域重叠问题。

28.需要说明的是,本技术的mobilenetv3-ssd模型使用pytorch框架搭建,使用pascal voc 2007+2012数据集进行训练与测试,其中,pascal voc数据集共有20个类别。训练数据是使用voc2007和2012的训练集和测试集,共16551张图像;测试数据是使用voc2007测试集,共4952张图像。在训练过程中,使用gpu进行训练,设置输入网络的图像大小是512

×

512,共训练12k步。

29.深度信息获取步骤s2,建立kinect v2摄像机模型并进行摄像机标定,得到彩色摄像机、深度摄像机的内参数、畸变参数及外参数,以建立彩色图像向深度图像转换的配准关系,并基于一优化误差函数对配准关系进行迭代优化,基于优化后的配准关系得到目标在深度图像的深度区域框。

30.在其中一些实施例中,深度信息获取步骤s2包括:配准关系建立步骤s21,建立kinect v2摄像机模型并进行摄像机标定,得到彩色摄像机和深度摄像机的内参数a

rgb

和a

depth

、畸变参数、彩色摄像机的外参数r

rgb

和t

rgb

及深度摄像机的外参数r

depth

及t

depth

,从而计算出彩色摄像机和深度摄像机坐标系之间的旋转矩阵和平移向量,建立彩色图像向深度图像转换的配准关系;配准迭代优化步骤s22,基于kinect v2中彩色摄像机和深度摄像机标定后的真实旋转平移关系以及kinect v2摄像机模型,对配准进行迭代优化。

31.本技术实施例的配准关系建立步骤s21中,根据小孔成像及投射投影原理,建立kinect v2摄像机模型,该摄像机模型如图5所示。其中,根据透射原理,图像坐标系oxy到像素坐标系ouv的转换关系如下表达式:,(1)其中,n

x

和ny是与摄像机ccd(charge-coupled device)像面单位长度对应的图像像素的个数。

32.摄像机坐标系ocxcyczc到图像坐标系oxy的转换关系如下表达式:

,(2)其中,ρ为比例系数,f为摄像机焦距。

33.基于如上表达式(1)(2)可计算得到摄像机坐标系ocxcyczc到像素坐标系ouv的转换关系,该转换关系如下表达式:,(3)其中,为内参数矩阵。

34.继续参考图5所示,世界坐标系owx

wywzw

到摄像机坐标系ocxcyczc的转换关系如下表达式:,(4)其中,为旋转矩阵,为平移向量,该旋转矩阵和平移向量是可以计算求得的。

35.在摄像机成像系统中,由于存在镜头畸变,获得的图像坐标存在一定的误差,可根据畸变补偿公式(5)进行纠正。

36.,(5)其中,(ud,vd)是图像的实际坐标,(u,v)为补偿之后的坐标,k1、k2分别是图像的一阶、二阶畸变补偿系数,。

37.建立如上式(1)~式(5)所示的摄像机模型后,本技术实施例进行彩色摄像机、深度摄像机标定。可选的,本技术采用张正友标定法进行标定,标定板选用5

×

7规格的棋盘格,其相邻的两个格子的间距为30mm。使用kinect v2在不同距离、不同角度拍摄25种姿态的标定板,分别获取25张彩色图像和深度图像。由于kinect v2中深度图像和红外图像由同一摄像机获得,可使用清晰的红外图像进行深度图像的标定,提取标定图像的角点,通过相关的计算,即可完成两个摄像机的标定,得到彩色摄像机和深度摄像机的内参数a

rgb

和a

depth

、畸变参数、彩色摄像机的外参数r

rgb

和t

rgb

及深度摄像机的外参数r

depth

及t

depth

。

38.进一步的,基于上述参数计算出彩色摄像机和深度摄像机坐标系之间的旋转矩阵和平移向量,建立彩色图像向深度图像转换的配准关系。具体的:设定一目标点在深度摄像机坐标系和彩色摄像机坐标系的摄像机坐标并求得其在深度图像和彩色图像平面的彩色投影坐标,也即其在深度像素坐标系、彩色像素坐标系的坐标,目标点的深度摄像机坐标表示为、目标点的彩色摄像机坐标表示为,目标点的深度投影坐标表示为,目标点的彩色投影坐标表示为。其中,深度摄像机坐标系和彩色摄像机坐标系满足如下式示出的转换关系:,(6)其中,r

depth_rgb

为式(6)的旋转矩阵,t

depth_rgb

为式(6)的平移向量。

39.基于双目立体视觉模型,在彩色摄像机与深度摄像机的公共视场范围内,两个摄像机可以同时捕捉到目标物体,如图6所示,且该物体在世界坐标系下的坐标是唯一的。因此,设定目标物体的世界坐标为pw=(x

w,yw

,zw)

t

,基于如式(4)所示的世界坐标系到摄像机坐标系的转换关系,该世界坐标对应的深度摄像机坐标及彩色摄像机坐标表示为下式(7):(7)将公式(7)中的pw消除,可得如上公式(6)中的旋转矩阵r

depth_rgb

及平移向量t

depth_rgb

,具体表示为下式(8):(8)基于摄像机坐标系到像素坐标系的转换关系,如公式(3)所示,可建立如下计算关系:,其中,ρ1为深度图像中的比例系数,ρ2为彩色图像中的比例系数。

40.基于该计算关系结合公式(6)~(8)可建立从彩色图像向深度图像转换的配准关系

如下式所示:ρ1p

depth

=ρ2a

depthrdepthrrgb-1argb-1

p

rgb

+a

depth

(t

depth-r

depthrrgb-1

t

rgb

)

ꢀꢀꢀꢀꢀꢀ

(9)进而,为了在未知深度信息的前提下,本技术基于kinect v2中彩色摄像机和深度摄像机标定后的真实旋转平移关系以及摄像机模型,对配准进行迭代优化。结合图6所示,配准迭代优化步骤s22具体包括:深度值获取步骤s221,使彩色摄像机和深度摄像机处于设定近似平行关系后旋转深度摄像机使彩色摄像机和深度摄像机处于真实旋转平移关系,分别采集对应关系下目标点在深度图像的深度值;其中,设定彩色摄像机和红外摄像机在结构上为近似平行关系时,两者的旋转关系表示为:;平移关系为:,此时,ρ1=ρ2+tz,对应的目标点的彩色投影坐标记为,目标点的深度投影坐标记为,此时,初始深度值为ρ

10

=z

depth0

,进而基于公式(2)计算得到其深度摄像机坐标;随后,基于旋转矩阵r

depth_rgb

对深度摄像机进行旋转使彩色摄像机和深度摄像机处于真实旋转平移关系,旋转后的深度摄像机坐标为:,此时,得到更新深度值ρ

11

=z

depth1

。

41.优化误差函数建立步骤s222,根据彩色摄像机与深度摄像机标定得到的旋转矩阵r

depth_rgb

、平移向量t

depth_rgb

及公式(6)示出的深度摄像机坐标系和彩色摄像机坐标系转换关系将深度摄像机坐标p

depth1

转换得到彩色投影坐标p

rgb1

,其中,、;并建立优化误差函数,优化误差函数通过以下计算模型计算得到:,(11)其中,是迭代i次后的彩色投影坐标,p

rgb0

为目标物体在彩色图像上真实像素坐标,该真实像素坐标即为上述近似平行关系下的目标点的彩色投影坐标,i=1,2,

…

,n,n为迭代次数。

42.优化误差函数迭代步骤s223,配置迭代范围对深度值ρ

1i

=z

depthi

进行迭代,得到误差函数最小的深度值并将对应深度投影坐标经坐标系转换得到目标点的彩色摄像机坐标,实现目标点彩色图像向深度图像的配准。其中,考虑到真实深度信息位于ρ

11

附近,本技术基于kinect v2及旋转矩阵r

depth_rgb

,对ρ1进行迭代,迭代范围是根据kinect v2的可检测的范围配置的,如图7所示,基于该迭代范围,迭代次数n是有限的。

43.优化误差函数迭代步骤s223中,迭代过程中,迭代后的深度值和更新深度值成比

例关系,因此设比例因子j=z

depthi

/z

depth1

,基于该比例因子计算得到迭代后的坐标(x

depth

,y

depth

,z

depth

)i。重复优化误差函数迭代步骤,并求解对应的(u

rgb

,v

rgb

)i,直到e

min

=min{e(i)|i=1,2,

…

,n}。

44.基于如上步骤,本技术利用kinect v2获取室内场景的彩色图像,利用mobilenetv3-ssd模型检测彩色图像中的室内物体后,构建彩色图像和深度图像的配准优化模型,实现彩色图像向深度图像的配准优化,融合彩色图像和深度图像的图像信息,从而估计得到物体的初始深度信息,其中,mobilenetv3-ssd模型是轻量级神经网络mobilenetv3与ssd(single shot multibox detector)算法结合生成。

45.本技术实施例利用前述实施例的深度信息修正红外摄像机的姿态后,基于双目立体视觉模型迭代优化完成深度信息的优化,获取较为精确的物体深度信息,利用该物体深度信息,本技术还进一步基于物体深度信息通过彩色摄像机与红外摄像机的转换关系得到物体在彩色摄像机坐标系下的位姿点云,以实现估计移动机器人的避障区域。具体还包括如下流程:点云数据获取步骤s3,通过遍历深度区域框获取其内所有有效深度数据,基于一预设避障范围[0,

∂

]选取有效深度数据中的避障目标深度数据,并获取目标在深度摄像机坐标系下的点云数据;其中,有效深度数据通过将深度图像转换为灰度图像后,基于如下计算模型计算得到:depth_value=k

×

gray_value(12)其中,k为尺度因子,具体的,k=4095/255,4095为kinect v2检测的深度最大值;gray_value为灰度值。

[0046]

点云数据通过如下计算模型计算得到:(13)其中,(u,v)用于深度图像上的坐标点,d为坐标点的深度值,f

x

、fy表示深度摄像机的焦距f在x、y方向上像素度量,c

x

、cy表示光轴对于投影平面坐标中心的偏移量。

[0047]

目标定位步骤s4,将点云数据转换至彩色摄像机坐标系以确定目标在彩色摄像机坐标系下的位姿,拟合得到移动机器人的避障目标区域,移动机器人的避障目标区域为球面,通过构造一目标函数并对目标函数的向量求解偏导数为0求解球面;其中,球面表示为:;目标函数表示为:。

[0048]

对目标函数的x0、y0、z0、r求偏导数并使其等于0,如下式:

(14)结合公式(14)将在彩色摄像机坐标系的点云数据代入求解x0、y0、z0、r。

[0049]

在其中一些实施例中,为了保证避障准确率,避障目标区域还包括一检测得到的避障目标最远距离构成的平面,如图8所示,避障目标区域通过如下计算模型计算得到:(15)其中,z

max

为目标最远距离,δ为预设避障安全裕度。

[0050]

基于如上步骤,本技术实施例在目标位姿估计过程中,基于物体深度信息通过彩色摄像机与红外摄像机的转换关系得到物体在彩色摄像机坐标系下的位姿点云,以实现估计移动机器人的避障区域。

[0051]

需要说明的是,在上述流程中或者附图的流程图中示出的步骤可以在诸如一组计算机可执行指令的计算机系统中执行,并且,虽然在流程图中示出了逻辑顺序,但是在某些情况下,可以以不同于此处的顺序执行所示出或描述的步骤。

[0052]

本实施例还提供了一种移动机器人目标定位系统,该系统用于实现上述实施例及优选实施方式,已经进行过说明的不再赘述。如以下所使用的,术语“模块”、“单元”、“子单元”等可以实现预定功能的软件和/或硬件的组合。尽管以下实施例所描述的装置较佳地以软件来实现,但是硬件,或者软件和硬件的组合的实现也是可能并被构想的。

[0053]

图9是根据本技术实施例的移动机器人目标定位系统的结构框图,如图9所示,该系统包括:目标识别模块1,用于采集目标彩色图像及深度图像,通过一预训练后的mobilenetv3-ssd模型识别目标彩色图像得到目标在彩色图像的彩色区域框,得到目标类别及像素坐标(u

rgb

,v

rgb

);深度信息获取模块2,用于建立kinect v2摄像机模型并进行摄像机标定,得到彩色摄像机、深度摄像机的内参数、畸变参数及外参数,以建立彩色图像向深度图像转换的配准关系,并基于一优化误差函数对配准关系进行迭代优化,基于优化后的配准关系得到目标在深度图像的深度区域框;点云数据获取模块3,用于通过遍历深度区域框获取其内所有有效深度数据,基于一预设避障范围[0,

∂

]选取有效深度数据中的避障目标深度数据,并获取目标在深度摄像机坐标系下的点云数据;目标定位模块,用于将点云数据转换至彩色摄像机坐标系以确定目标在彩色摄像机坐标系下的位姿,拟合得到移动机器人的避障目标区域。

[0054]

在其中一些实施例中,深度信息获取模块2包括:配准关系建立模块21,用于建立kinect v2摄像机模型并进行摄像机标定,得到彩色摄像机和深度摄像机的内参数a

rgb

和a

depth

、畸变参数、彩色摄像机的外参数r

rgb

和t

rgb

及深

度摄像机的外参数r

depth

及t

depth

,从而计算出彩色摄像机和深度摄像机坐标系之间的旋转矩阵和平移向量,建立彩色图像向深度图像转换的配准关系,配准关系基于上述公式(9)计算得到;配准迭代优化模块22,用于基于kinect v2中彩色摄像机和深度摄像机标定后的真实旋转平移关系以及kinect v2摄像机模型,对配准进行迭代优化。

[0055]

在其中一些实施例中,配准迭代优化模块22进一步包括:深度值获取模块221,使彩色摄像机和深度摄像机处于设定近似平行关系后旋转深度摄像机使彩色摄像机和深度摄像机处于真实旋转平移关系,分别采集所述目标点在深度图像的深度值,得到初始深度值ρ

10

=z

depth0

及更新深度值ρ

11

=z

depth1

;优化误差函数建立模块222,用于根据真实旋转平移关系,即彩色摄像机与深度摄像机标定得到的旋转矩阵r

depth_rgb

、平移向量t

depth_rgb

,及公式(6)示出的深度摄像机坐标系和彩色摄像机坐标系转换关系将深度摄像机坐标p

depth1

转换得到彩色投影坐标p

rgb1

,并建立优化误差函数,优化误差函数通过上述公式(11)。

[0056]

优化误差函数迭代模块223,用于配置迭代范围对深度值ρ

1i

=z

depthi

进行迭代,得到误差函数最小的深度值并将对应深度投影坐标经坐标系转换得到目标点的彩色摄像机坐标,实现目标点彩色图像向深度图像的配准。

[0057]

需要说明的是,上述各个模块可以是功能模块也可以是程序模块,既可以通过软件来实现,也可以通过硬件来实现。对于通过硬件来实现的模块而言,上述各个模块可以位于同一处理器中;或者上述各个模块还可以按照任意组合的形式分别位于不同的处理器中。

[0058]

综上所述,本技术实施例解决了在室内环境下移动机器人的快速、准确避障问题,能够在降低成本、提高工作效率的前提下,通过能够应用在嵌入式平台的基于轻量级卷积神经网络的mobilenetv3-ssd模型完成室内环境下物体的快速识别;同时通过配准优化算法,将彩色图像中物体的位置对应到深度图像中的位置,获得物体的深度信息,进而通过摄像机模型完成目标的位姿估计,满足机器人对物体感知的精度以及速度要求,保证机器人实时避障的有效性。

[0059]

以上所述实施例仅表达了本技术的几种实施方式,其描述较为具体和详细,但并不能因此而理解为对发明专利范围的限制。应当指出的是,对于本领域的普通技术人员来说,在不脱离本技术构思的前提下,还可以做出若干变形和改进,这些都属于本技术的保护范围。因此,本技术专利的保护范围应以所附权利要求为准。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1