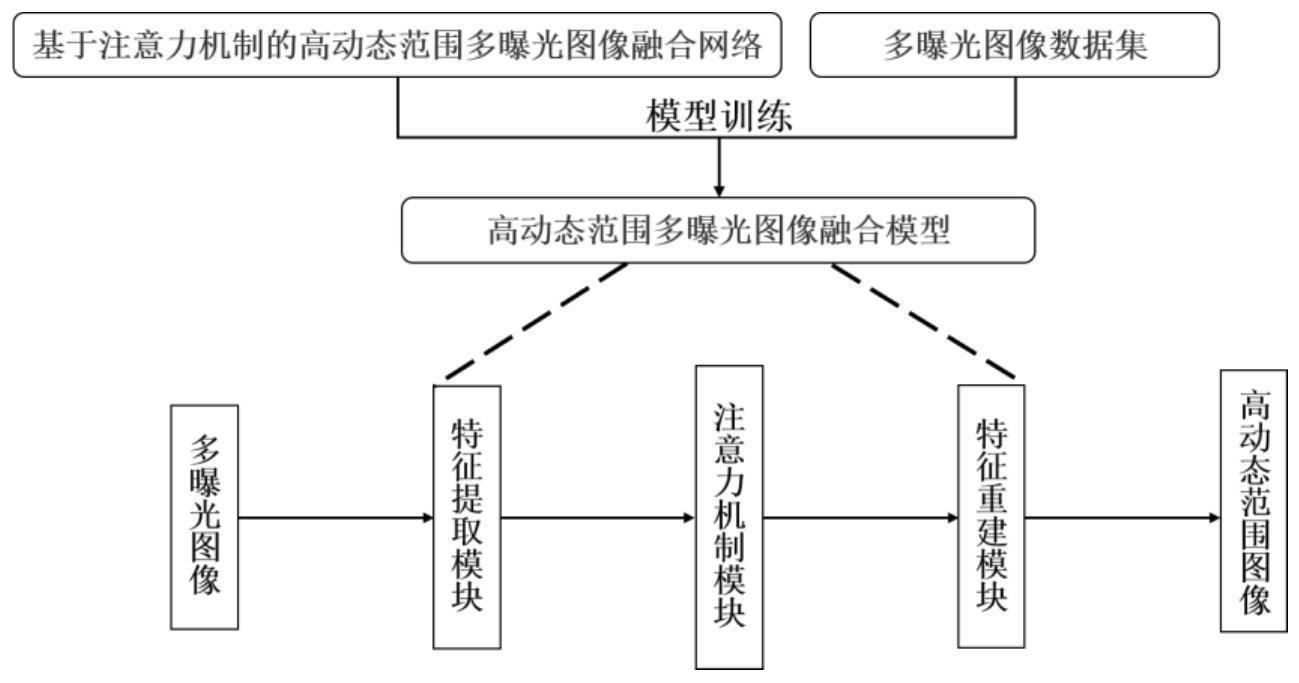

基于注意力机制的高动态范围多曝光图像融合模型及方法

本发明涉及一种高动态范围成像的多曝光图像融合模型及方法,属于图像处理。

背景技术:

1、自然场景有很宽广的动态范围,如微弱星光亮度约为10-4cd/m2,恒星强光亮度范围为105~109cd/m2,通过数码单反相机拍摄记录时,往往因为数码相机动态范围受限,导致拍摄的照片出现过曝光和欠曝光。高动态范围多曝光图像融合技术旨在扩大图像动态范围,解决由数码相机动态范围受限无法捕获高动态范围图像而产生的问题。近年来,随着算力水平的提升,高动态范围多曝光图像融合方法研究从传统的基于变换的方法,逐渐转向基于深度学习的方法。传统的基于变换的方法通常利用某种图像变换(拉普拉斯金字塔、小波变化、稀疏表示等)将输入图像转换为特征图,根据人工定义的融合策略进行特征融合,得到包含丰富信息的高动态范围图像。而基于深度学习的方法解决了传统高动态范围多曝光图像融合方法不能自适应学习图像特征的不足,生成比传统方法细节更丰富的高动态范围图像。但多曝光图像由于曝光时间不同,同一场景不同曝光图像中的物体具有信息互补,以及亮度,色度,结构对应关系复杂的特点。因此,已有的基于深度学习的高动态范围多曝光图像融合方法仍存在图像失真、细节丢失,以及无法突出融合有利图像特征等问题。

技术实现思路

1、要解决的技术问题

2、针对已有高动态范围多曝光图像融合方法存在图像失真、细节丢失,以及源图像序列互补信息无法充分利用等问题,本发明提出了一种基于注意力机制的高动态范围多曝光图像融合模型及方法,所提方法进一步提高了高动态范围多曝光图像融合的质量和鲁棒性。

3、技术方案

4、一种基于注意力机制的高动态范围多曝光图像融合模型,其特征在于包括特征提取模块、注意力机制模块以及特征重建模块,将目标场景两张不同曝光图像分别输入到结构相同的两组特征提取模块中,获得目标场景两张不同曝光图像对应的两组高维特征图;随后将上述两组高维特征图作为输入分别送入相应的注意力机制模块,得到重建融合图像所需的纯净高维特征;特征重建模块将注意力机制模块输出的两组不同曝光图像的高维特征融合重建为高动态范围图像。

5、一种基于注意力机制的高动态范围多曝光图像融合方法,其特征在于步骤如下:

6、步骤1:读取训练的欠曝光图像u和过曝光图像o;将读取的u和o剪切成若干个子图像m,m的大小为w×h×c,w和h表示m的宽和高,c表示m的通道数,再将剪裁的子图像m进行数据增强;

7、步骤2:以子图像m作为输入源,通过特征提取模块构建单层卷积神经网络层,其中卷积核大小为w×h,通过卷积神经层分别将u和o转化为64维的特征f1,f1的大小为w×h×64,计算方法如下:

8、f1=c1(m)(1)

9、式中,c1表示对应卷积操作;

10、步骤3:以f1为输入源,输入到unet网络进行图像特征的多尺度特征提取,得到确定包含64通道的高维多尺度特征f2,f2大小为w×h×64,计算方法如下:

11、f2=u(f1)(2)

12、式中,u表示unet网络的卷积操作;

13、步骤4:构建两个结构相同的注意力机制模块a,使用注意力机制模块a分别对unet网络输出的不同曝光图像的特征图f2进行squeeze操作,采用全局平均池化方式将通道上整个空间特征编码为全局特征,计算公式如下:

14、

15、式中,fsq(·)表示squeeze操作,i,j表示像素点,rc表示c维度,fc为squeeze操作的结果;然后对全局特征采用excitation操作,为了降低模型复杂度以及提升泛化能力,采用两个全连接操作,全连接之间使用relu激活函数进行非线性处理,最后通过归一化函数sigmoid输出权值向量,excitation操作使得网络学习各通道间的关系,也得到不同通道的权值f3,计算方式如下:

16、f3=fex(fc,w)=σ(g(fc,w))=σ(w2relu(w1fc)) (4)

17、式中,表示w1维度为表示w2维度为r为缩放因子;

18、步骤5:运用乘法运算将unet网络输出的图像特征f2与注意力机制学习到的各通道权值f3相乘得到最终图像特征f4,计算方法如下:

19、f4=fscale(f2,f3)=f2·f3 (5)

20、式中,·表示矩阵相乘运算;

21、步骤6:通过拼接操作欠曝和过曝图像的高维图像特征fu,4,fo,4得到特征图f0,f0的大小为w×h×128,计算方式如下:

22、f0=concat(fu,4+fo,4) (6)

23、式中,fu,4和fo,4分别表示欠曝光图像,过曝光图像经过注意力机制后得到的图像特征,concat表示特征拼接操作;

24、步骤7:以f0为输入源,通过特征重建模块得到高动态范围图像,特征重建模块首先利用单层卷积神经网络层将拼接的特征图f0转化成64通道的特征图f1,f1大小为w×h×64,其次将特征图f1提供给drdb单元输出特征图f2,其中drdb单元是基于扩张卷积改进残差稠密单元得到的,最后利用2个卷积层依次卷积特征图f2得到特征图f3,最后得到高动态范围图像,其中f3的大小为w×h×16,计算方法如下:

25、f1=c1(f0) (7)

26、f2=drdb(f1) (8)

27、f3=c2(f2) (9)

28、hdr=c3(f3) (10)

29、式中,drdb表示扩张残差稠密单元卷积操作,c1,c2,c3表示单层卷积层,hdr表示高动态范围图像;

30、步骤8:设计损失函数,进行迭代,更新模型,所述的损失函数为:

31、loss=λlssim+lcontent (16)

32、lssim=αossimo,f+αussimu,f (12)

33、lcontent=βolo,f+βulu,f (15)

34、其中,ssimo,f,ssimu,f分别表示过曝图像o和欠曝图像u与融合图像f的结构相似性,λ表示超参数,αo和αu分别为过曝图像o和欠曝图像u的权重系数,βo和βu分别为过曝图像o和欠曝图像u的权重系数,lo,f、lu,f分别表示过曝图像o和欠曝图像u与融合图像f的内容相似性;

35、步骤9:读取需要处理的欠曝光u和过曝光图像o,通过参数完备的训练模型得到高动态范围图像hdr。

36、优先地:步骤1中所述的w=256,h=256,c=3。

37、优先地:步骤1中数据增强通过旋转、水平翻转、垂直翻转方式。

38、优先地:步骤2中所述的w=3,h=3。

39、优先地:步骤8中采用adam优化器实现模型更新。

40、有益效果

41、本发明提出了一种新的端到端基于注意力机制的高动态范围多曝光图像融合模型及方法,提升了融合质量和鲁棒性。

42、1、利用权重分离的双通道特征提取模块提取目标场景在欠曝光和过曝光图像的特征,获得纹理信息表征能力更强的特征图;

43、2、将注意力机制引入到多曝光图像任务中,从局部到全局对欠曝光和过曝光图像的局部细节和全局特征进行聚焦,突出对融合有利的图像特征;

44、3、为了更精确重建融合图像,以l2范数和结构相似性ssim作为神经网络的约束准则设计损失函数,获得源图像序列和融合图像之间更小的相似性差异,实现神经网络模型更精准的收敛。

45、上述操作使得本发明网络可以捕捉更多细节信息,生成质量更好的高动态范围多曝光融合图像。

- 还没有人留言评论。精彩留言会获得点赞!