强化学习紧急直流功率支援的频率稳定系统及方法

1.本发明涉及电力系统频率控制技术领域,更具体地,涉及一种强化学习紧急直流功率支援的频率稳定系统及方法。

背景技术:

2.目前,伴随“双碳”战略的推进,大力发展新能源发电成为加快降低碳排放,引导绿色技术创新,持续推进产业结构和能源结构调整的不可或缺的重要因素。但具有波动性和随机性的新能源取代众多同步发电机组,导致电力系统中系统惯量下降,同时伴随着大型交直流混联电网的形成,进而使功率扰动引发的频率波动问题更大,系统抗扰动能力下降,非常容易引发脱网问题,且易引发连锁故障,电网的频率稳定控制显得尤为重要。

3.传统的低频减载速度较慢,切负荷控制经济性低,因此紧急直流功率支援作为一种能够兼顾动作速度和经济性的控制手段在当今复杂电网的频率稳定控制中具有明显优势。

4.目前紧急直流功率支援策略多是通过系统的物理模型和特性制定数据模型,受限于考虑因素的全面性,当系统工况复杂多变时制定策略准确性低,存在策略制定的计算量巨大、过程繁琐、工况难覆盖的问题。

技术实现要素:

5.针对上述问题本发明提出了一种强化学习紧急直流功率支援的频率稳定系统及方法,提高了电力系统发生扰动时控制策略的准确性,减少了电力系统的控制策略求解的计算量,提高了复杂电力系统下的频率安全稳定性。

6.本发明所提出的强化学习紧急直流功率支援的频率稳定系统,包括:

7.初始化模块,用于配置基于邻近优化策略算法的强化学习网络的网路参数、设置交互间每次循环的最大交互次数和所要训练的循环数,读取预设的紧急直流功率支援指令集合及电力系统的特征电气量集合;

8.交互模块,用于执行以下操作:在电力系统运行一个交互间隔步长后读取一次特征电气量数据,若强化学习网络有紧急直流功率支援的指令输出,则将指令传递给电力系统;

9.数据处理模块,用于将交互模块所读取的特征电气量分为以下三类:决策措施电气量、控制效果电气量和安全约束电气量;

10.评判模块,用于根据直流系统两端的交流母线频率值,利用奖励函数得到奖励值;

11.决策模块,用于将所述决策措施电气量作为强化学习网络的输入数据传入至强化学习网络,将紧急直流功率支援指令作为强化学习网络的输出,使得直流系统能够在电力系统发生扰动时给出相应的紧急直流功率支援措施使得系统频率恢复到安全范围;

12.学习模块,用于根据控制效果电气量判断频率恢复效果及根据安全约束电气量判断是否触发电力系统安全约束,并在此基础上结合评判模块得到的奖励值更新强化学习网

络的网路参数。

13.所述基于邻近优化策略算法的强化学习网络包含两个神经网络,分别为策略神经网络和价值神经网络,其中策略神经网络的输入为实时的直流系统两端的交流母线频率值及其变化率,输出为紧急直流功率支援指令;价值神经网络的输入为实时的直流系统两端的交流母线频率值及其变化率和所述紧急直流功率支援指令,输出为用于更新策略神经网络和价值神经网络的神经网络权重;所述特征电气量包括最近的一个或多个交互间隔内若干时间点的直流系统两端的交流母线频率值及其变化率、直流系统逆变侧换流母线电压、直流电流、逆变侧换流变漏抗、逆变侧换流变变比、逆变侧关断角、超前触发角和邻近直流系统的线路功率;所述基于邻近优化策略算法的强化学习网络的网络参数包括学习率、批大小、梯度裁剪大小和折扣因子大小;所述紧急直流功率支援指令集合由电力系统中参与紧急直流功率支援的设备和允许的紧急直流功率支援范围构建而成;所述紧急直流功率支援的设备即所控制的电力系统中能够进行紧急直流功率支援的直流系统;所述允许的紧急直流功率支援范围即整个电力系统或单个直流系统所允许输出功率的最低值和最高值,允许的紧急直流功率支援范围为直流联网线路额定传输功率的20%至50%。

14.所述交互间隔为强化学习网络每隔多久与电力系统进行一次交互的时间,设定每个交互间隔为1秒。

15.所述决策措施电气量包括直流系统两端的交流母线频率值及其变化率,决策措施电气量用于作为强化学习网络的输入值;所述控制效果电气量包括直流系统两端的交流母线频率值,通过频率的恢复程度判断上一个交互间隔内强化学习网络给出的紧急直流功率支援指令控制效果;安全约束电气量包括直流系统两端的交流母线频率、直流系统逆变侧换流母线电压、直流电流、逆变侧换流变漏抗、逆变侧换流变变比、逆变侧关断角、超前触发角和邻近直流系统的线路功率。

16.所述决策模块中强化学习网络的输入为决策措施电气量,输出为紧急直流功率支援指令,紧急直流功率支援指令包括所要进行紧急直流功率支援的设备和紧急直流功率支援的支援量。

17.所述奖励函数设置如下:

18.若频率恢复值在49.8hz~50.5hz之间,则奖励值为10000;

19.若频率恢复值小于49.8hz,则奖励值为当前频率值与理想频率值差值的绝对值的负值;

20.若频率恢复值大于50.5hz,则奖励值为-10000;

21.同时若观测到直流系统逆变侧换流母线电压低于安全阈值或线路功率超过安全功率约束,则奖励值会被减去10000。

22.本发明提出的强化学习紧急直流功率支援的频率稳定方法,包括:

23.步骤一、提取电力系统节点模型的多个历史时刻的特征电气量作为强化学习中的状态值以构建观测数据,特征电气量包括最近的一个或多个交互间隔内若干时间点的直流系统两端的交流母线频率值及其变化率、直流系统逆变侧换流母线电压、直流电流、逆变侧换流变漏抗、逆变侧换流变变比、逆变侧关断角、超前触发角和邻近直流系统的线路功率;

24.步骤二、构建基于邻近优化策略算法的强化学习网络

25.所述基于邻近优化策略算法的强化学习网络包含两个神经网络,分别为策略神经

网络和价值神经网络,其中策略神经网络的输入为实时的直流系统两端的交流母线频率值及其变化率,输出为紧急直流功率支援指令;价值神经网络的输入为实时的直流系统两端的交流母线频率值及其变化率和所述紧急直流功率支援指令,输出为用于更新策略神经网络和价值神经网络的神经网络权重;

26.步骤三、对提取的特征电气量进行分析和分类;

27.特征电气量分为决策措施电气量、控制效果电气量和安全约束电气量;所述决策措施电气量包括直流系统两端的交流母线频率值及其变化率,决策措施电气量用于作为强化学习网络的输入值;所述控制效果电气量包括直流系统两端的交流母线频率值,通过频率的恢复程度判断上一个交互间隔内强化学习网络给出的紧急直流功率支援指令控制效果;安全约束电气量包括直流系统两端的交流母线频率、直流系统逆变侧换流母线电压、直流电流、逆变侧换流变漏抗、逆变侧换流变变比、逆变侧关断角、超前触发角和邻近直流系统的线路功率;

28.步骤四、利用所构建的基于邻近优化策略算法的强化学习网络对各类特征电气量数据进行优化训练生成策略模型;

29.步骤五、提取电力系统实时的决策措施电气量,作为策略模型的输入,输出为紧急直流功率支援指令,将输出的指令下发给电力系统执行,使得直流系统能够在线针对不同工况给出相应的紧急直流功率支援措施。

30.步骤四中,所述的策略模型即为训练完成的基于邻近优化策略算法的强化学习网络中策略神经网络结构和参数,输入层为决策措施电气量,输出为紧急直流功率支援指令。

31.通过上述设计方案,本发明可以带来如下有益效果:本发明将基于邻近策略优化算法的强化学习模型作为决策主体,实际电力系统作为环境,通过提取电力系统节点模型的多个历史时刻的特征电气量作为强化学习中的状态值以构建观测数据;构建基于邻近策略优化算法的强化学习网络;对电气量进行分析和分类,一部分电气量作为强化学习网络的输入,另一部分电气量用于更新强化学习网络参数,紧急直流功率支援措施作为强化学习网络的输出,通过强化学习进行优化训练生成策略模型;通过对策略模型的提取,直流系统能够在电力系统发生扰动时快速、准确的给出相应的紧急直流功率支援措施使得系统频率恢复到安全范围。本发明提高了当今新型电力系统处于复杂工况时紧急直流功率支援策略的准确性,减少了新型电力系统的控制策略求解的计算量,提高了复杂电力系统下的频率安全稳定性。

附图说明

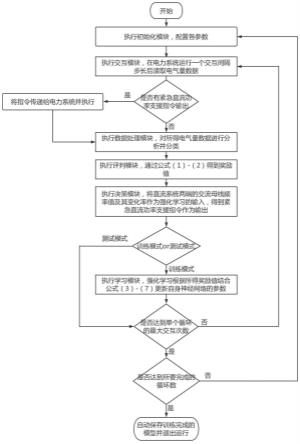

32.图1是本发明所提出的强化学习紧急直流功率支援的频率稳定方法的流程图;

33.图2是实例演示所用的39节点系统算例;

34.图3是实例展示所得的平均奖励图;

35.图4是实例展示的在本发明提出的强化学习紧急直流功率支援的频率稳定方法下电力系统频率恢复曲线。

具体实施方式

36.为使得本发明的目的、特征、优点能够更加的明显和易懂,下面结合本发明的实施

例中的附图,对本发明中的技术方案进行清楚完整地描述。显然,本发明不受下述实施例的限制,可根据本发明的技术方案与实际情况来确定具体的实施方式。为了避免混淆本发明的实质,公知的方法、过程、流程、元件和电路并没有详细叙述。

37.本发明所提出的强化学习紧急直流功率支援的频率稳定方法,包括:

38.1)提取电力系统节点模型的多个历史时刻的特征电气量作为强化学习中的状态值以构建观测数据,特征电气量包括最近的一个或多个交互间隔内若干时间点的直流系统两端的交流母线频率值及其变化率、直流系统逆变侧换流母线电压、直流电流、逆变侧换流变漏抗、逆变侧换流变变比、逆变侧关断角、超前触发角和邻近直流系统的线路功率;

39.2)根据电力系统中参与紧急直流功率支援的设备和允许的紧急直流功率支援范围构建强化学习网络输出指令集合;

40.3)构建基于邻近优化策略算法的强化学习网络,强化学习网络的网络结构包含两个神经网络,分别为策略网络和价值网络;

41.策略神经网络的输入层输入为实时的直流系统两端的交流母线频率值及其变化率,隐含层为4层且每层64个通道,输出层输出为紧急直流功率支援指令;

42.价值神经网络的输入层输入为实时的直流系统两端的交流母线频率值及其变化率和紧急直流功率支援指令,隐含层为4层且每层64个通道,输出层输出为用于更新策略神经网络和价值神经网络的神经网络权重;

43.4)对提取的特征电气量进行分析,直流系统两端的交流母线频率值及其变化率作为基于邻近优化策略算法的强化学习网络输入层的输入数据,基于邻近优化策略算法的强化学习网络用于输出紧急直流功率支援指令;邻近直流系统的线路功率用于避免直流功率支援导致邻近直流系统的线路过载;直流系统逆变侧换流母线电压、直流电流、逆变侧换流变漏抗、逆变侧换流变变比、逆变侧关断角和超前触发角用于计算避免直流换相失败的最小逆变侧换流母线电压u

aci

,其公式如下:

[0044][0045]

式中:i

dc

为直流电流;x

t

为逆变侧换流变漏抗;ti为逆变侧换流变变比;γ为逆变侧关断角;β为超前触发角;

[0046]

5)根据直流系统两端的交流母线频率值计算奖励值,若频率恢复值在49.8hz~50.5hz之间,则奖励值为10000;

[0047]

若频率恢复值小于49.8hz,则奖励值为当前频率值与理想频率值差值的绝对值的负值;

[0048]

若频率恢复值大于50.5hz,则奖励值为-10000;

[0049]

计算奖励值的公式如下:

[0050][0051]

式中:f

aci

为直流系统两端的交流母线频率值;f0为理想频率值,一般为50hz;

[0052]

同时若观测到直流系统逆变侧换流母线电压低于最小逆变侧换流母线电压或线路功率超过安全功率约束,则奖励值会被减去10000;

[0053]

6)策略

[0054]

策略为状态到动作的映射,指的是给定状态时,动作集上的一个分布,也即在每个状态s指定一个动作概率;

[0055]

7)在最开始电力系统处于某种初始状态s0下,调度中心系统的强化学习网络根据策略分布π对电网下达动作a0,确定下一阶段各直流系统的输出有功功率,将动作指令与环境交互,环境状态发生改变,并反馈给调度中心系统作为下一决策阶段的状态s1,计算奖励r0,循环进行这一过程直至最后一个决策阶段;

[0056]

将上述过程采用深度强化学习算法求解,得到最优的紧急直流功率支援决策;

[0057]

8)所用深度强化学习算法为邻近优化策略算法,邻近优化策略算法中包括策略神经网络和价值神经网络;

[0058]

策略神经网络的输入为状态s

t

,输出为动作的正态分布均值与标准差,也即策略分布π

θ

(a

t

|s

t

),进而采样得到动作a

t

,总奖励函数为:

[0059][0060][0061][0062]

其中,t代表强化学习和电力系统第t次交互;θ为策略神经网络参数;π

θold

(a

t

|s

t

)为更新前的策略神经网络参数;t为一次循环的总交互次数;r

t

(θ)为新旧策略中状态s

t

下动作a

t

被选中的概率比;λ为早期学习值的引导程度,意味着在更多偏差(低λ)和更多方差(高λ)之间进行权衡;q(s

t

,a

t

)为实际的采样折扣奖励,表示在状态s

t

下,执行动作a

t

的价值;v(s

t

)为拟合的折扣奖励,表示状态s

t

的价值,也可表示在状态s

t

,执行所有动作的平均价值;v(s

t

)为一次循环的折扣奖励;σ为折扣因子,在强化学习中用来调节近远期影响,范围为[0,1]优为势函数,表示当前动作与平均动作相比的优势;r(t)为t时刻的奖励值;ε为梯度裁剪度,通常取0.2,clip代表使policy更新前后kl散度控制在1-ε到1+ε之间,超出该范围的梯度直接被忽略。

[0063]

价值神经网络的输入为状态s

t

,输出为神经网络权重用于更新策略神经网络和价值神经网络;

[0064]

评价网络的损失函数l(θ):

[0065]

l(θ)=e[(δ)2]=e[(z-v(s

t

))2]

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(6)

[0066]

z=r

t

+σv(s

t

+1)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(7)

[0067]

其中,δ为td误差,评价网络通过最小化td误差更新网络参数;z为折扣累计奖励;e代表数学期望;v(s

t

)为拟合的折扣奖励。

[0068]

9)基于邻近优化策略算法的强化学习紧急直流功率支援流程包括如下步骤:

[0069]

步骤1:神经网络权重与偏置初始化;学习率、批大小batch、梯度裁剪大小ε、折扣因子大小γ等参数初始化,环境初始化,训练交互步数置0;

[0070]

步骤2:读取时刻t的观测状态s

t

,包括:最近的一个或多个交互间隔内若干时间点的直流系统两端的交流母线频率值及其变化率、直流系统逆变侧换流母线电压、直流电流、逆变侧换流变漏抗、逆变侧换流变变比、逆变侧关断角、超前触发角和部分线路功率;

[0071]

步骤3:将观测数据输入至策略神经网络,策略神经网络输出对应的策略,也即动作分布,对该分布采样得到紧急直流功率支援指令;

[0072]

步骤4:将紧急直流功率支援指令应用在t至t+1时刻的实时电力系统中,动作与环境交互后环境更新,得到t+1时刻的观测状态s

t+1

,根据公式(1)-(2)计算即时奖励r

t

;

[0073]

步骤5:存储s

t

、a

t

、r

t

;更新状态观测值s

t

=s

t

+1;

[0074]

步骤6:更新时间t=t+1,循环步骤2至步骤5,直到到达指定交互步数;

[0075]

步骤7:将观测状态s

t+1

输入至价值神经网络中,价值神经网络输出拟合的折扣奖励v(s

t

);根据步骤5存储的奖励r

t

,根据公式(5)中的q(s

t

,a

t

),计算每个时刻对应的累计折扣奖励;

[0076]

步骤8:存储每次交互的状态s

t

、动作a

t

、折扣奖励q(s

t

,a

t

),形成一个batch的数据,并以此batch的数据更新策略神经网络和价值神经网络;更新步骤:

[0077]

①

计算优势函数。将batch内的状态s

t

输入至价值神经网络,价值神经网络输出该batch的v(s

t

);根据公式(5)以及batch的q(s

t

,a

t

),计算batch内每个状态的优势函数;

[0078]

②

更新策略神经网络:根据公式(3),以及批数据状态s

t

、动作a

t

;策略神经网络需最小化损失函数,因此将目标函数取负作为损失函数,反向传递更新策略神经网络的参数;

[0079]

③

更新价值神经网络:根据公式(6),以及批数据状态s

t

、折扣奖励q(s

t

,a

t

)计算损失函数l(θ),并反向传递更新价值神经网络参数;

[0080]

步骤9:交互次数加一,再循环步骤2至步骤8,直到到达指定交互次数,停止训练;

[0081]

步骤10:保存策略与价值神经网络模型,并进行测试,保存测试数据。

[0082]

10)当电力系统发生扰动时,提取最近的一个或多个交互间隔内若干时间点的直流系统两端的交流母线频率值及其变化率作为紧急直流功率支援策略模型输入,能够输出该状态下最优的紧急直流功率支援指令。

[0083]

如图1所示,一种强化学习紧急直流功率支援的频率稳定方法的具体实施流程如下:

[0084]

s1、执行初始化模块,配置基于邻近策略优化算法的强化学习参数;设置交互间每次循环的最大交互次数和所要训练的循环数,读取预设的紧急直流功率支援指令集和需要观测哪些电气量数据的集合;

[0085]

s2、执行交互模块,在电力系统运行一个交互间隔步长后读取一次电气量数据,若强化学习网络有紧急直流功率支援的指令输出则将指令传递给电力系统;

[0086]

s3、执行数据处理模块,强化学习将步骤s2所得电气量数据分类为控制效果电气量、决策措施电气量和安全约束电气量;

[0087]

s4、执行评判模块,通过公式(1)-(2)得到奖励值;

[0088]

s5、执行决策模块,将直流系统两端的交流母线频率值及其变化率作为强化学习网路的输入,得到紧急直流功率支援指令作为输出;

[0089]

s6、执行学习模块,强化学习网络根据步骤s4所得奖励值结合公式(3)-(7)更新自身神经网络的参数,使得若所得奖励值高则增加在步骤s2的电力系统工况下步骤s5所给出的紧急直流功率支援指令被选择的概率,反之则减少;

[0090]

s7、判断是否达到单个循环的最大交互次数,若否,重复s2至s6步骤,反之,则结束当前循环;

[0091]

s8、判断是否达到所要完成的循环数,若否,则返回步骤s1,反之,则自动保存训练完成的模型并退出运行;

[0092]

s9、应用阶段则为调用训练完成的强化学习网络重复s1至s5步骤,保证电力系统的频率稳定。

[0093]

实例演示

[0094]

为展示发明效果,构建了如图2所示的39节点电力系统,其发明相关设置如下:

[0095]

1)紧急直流功率支援设备:高压直流输电系统

[0096]

2)紧急直流功率支援幅度:200mw至500mw;

[0097]

3)训练故障场景:同步机g04退出运行、同步机g09退出运行、风电场1退出运行、光伏场退出运行;

[0098]

4)故障发生时间:2秒;

[0099]

5)每个循环的最大交互次数:20;

[0100]

6)交互间隔:1秒;

[0101]

7)观测的电气量:母线39的频率值及其变化率、母线39的电压、直流电流、逆变侧换流变漏抗、逆变侧换流变变比、逆变侧关断角、超前触发角,线路1-2的有功功率;

[0102]

8)训练循环数:200000;

[0103]

9)强化学习参数:学习率为0.000636、批大小为256、梯度裁剪大小为0.2、折扣因子大小为0.9。

[0104]

奖励函数设置如下所示:

[0105][0106]

式中:faci为母线39的频率值;f0为理想频率值,为50hz。

[0107]

同时若观测到母线39的电压低于最小逆变侧换流母线电压,或线路功率超过350mw,则奖励值会被减去10000。

[0108]

图3为强化学习训练时每个循环的平均奖励值,排除每个训练集前几步动作后的频率恢复时间,理想情况下每个训练集的平均奖励值应该低于200000,实际平均奖励值在170000左右,是符合预期的。

[0109]

经过利用强化学习在电力系统发生扰动时进行紧急直流功率支援决策,如图4所示,证明了本发明提出的强化学习紧急直流功率支援的频率稳定方法对于电力系统频率稳定恢复的有效性。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1