一种智能写作方法、装置、设备及介质与流程

1.本技术涉及智能写作技术领域,特别涉及一种智能写作方法、装置、设备及介质。

背景技术:

2.在日常办公等写作领域,资料的查找、收集、分类、引用都较为繁琐,耗费大量的人力和时间。智能写作能满足这一领域对于劳动力解放的需求。近年来,智能写作已经从规则、模板写作发展到了以深度神经网络模型为核心的智能化创作,从辅助创作逐渐走向自动化,新的预训练语言模型被不断提出,如openai的gpt(即generative pre-training,生成式预训练)-3、ernie、t5等模型,技术人员试图利用这些大模型的原始生成能力来解决不同场景下文本生成问题。

3.目前,基于预训练模型生成短文本的能力尚可,但是生成长文本(如长段落或篇章)的能力欠缺,比较常见的是文本重复问题,现有的解决文本重复的问题通常是人工进行参数调节,这种方式比较耗时,人工成本较高,难以保障准确性。

技术实现要素:

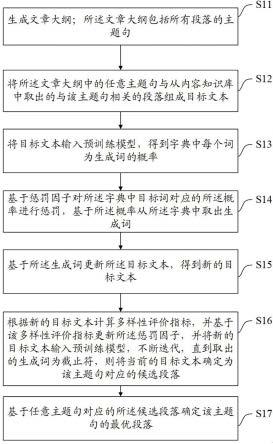

4.有鉴于此,本技术的目的在于提供一种智能写作方法、装置、设备及介质,能够在解决文本重复问题的情况下,减少人工成本并提升参数调节的准确度。其具体方案如下:第一方面,本技术公开了一种智能写作方法,包括:生成文章大纲;所述文章大纲包括所有段落的主题句;将所述文章大纲中的任意主题句与从内容知识库中取出的与该主题句相关的段落组成目标文本;将目标文本输入预训练模型,得到字典中每个词为生成词的概率;基于惩罚因子对所述字典中目标词对应的所述概率进行惩罚,基于所述概率从所述字典中取出生成词;其中,所述目标词为在目标文本中存在的词;基于所述生成词更新所述目标文本,得到新的目标文本;根据新的目标文本计算多样性评价指标,并基于该多样性评价指标更新所述惩罚因子,并将新的目标文本输入预训练模型,不断迭代,直到取出的生成词为截止符,则将当前的目标文本确定为该主题句对应的候选段落;基于任意主题句对应的所述候选段落确定该主题句的最优段落。

5.可选的,所述生成文章大纲,包括:基于用户选择的写作类型、输入的写作主题内容以及第一关键词生成文章大纲。

6.可选的,所述基于用户选择的写作类型、输入的写作主题内容以及第一关键词生成文章大纲,包括:从用户选择的写作类型对应的内容知识库中检索与写作所述主题内容最相关的模板文件;将所述模板文件中每个段落输入预训练模型,生成每个段落的主题句以及第二关

键词;分别将每个段落的主题句以及第二关键词、所述第一关键词按照预设方式组成模型输入数据,并将模型输入数据输入预训练模型,生成每个段落对应的新的主题句;将每个段落的所述新的主题句组合,得到文章大纲。

7.可选的,所述从用户选择的写作类型对应的内容知识库中检索与所述写作主题内容最相关的模板文件,包括:从用户选择的写作类型对应文件名知识库中检索与所述写作主题内容最相关的文件名;从用户选择的写作类型对应的内容知识库中查找该文件名对应的模板文件。

8.可选的,还包括:创建知识库池;其中,所述知识库池中包括各写作类型对应的文件名知识库和内容知识库;所述内容知识库包括各模板文件,所述文件名知识库包括各模板文件的文件名。

9.可选的,所述基于惩罚因子对所述字典中目标词对应的所述概率进行惩罚,包括:基于惩罚因子调整参数以及惩罚因子对所述字典中目标词对应的所述概率进行惩罚。

10.可选的,还包括:统计目标词在目标文本中出现的次数,得到该目标词对应的所述惩罚因子调整参数;或,获取配置参数,作为目标词对应的所述惩罚因子调整参数。

11.可选的,所述根据新的目标文本计算多样性评价指标,包括:从所述新的目标文本中去除原始目标文本,得到计算文本;所述原始目标文本为文本大纲中的主题句与从内容知识库中取出的段落组成的目标文本;根据所述计算文本计算多样性评价指标。

12.可选的,所述基于该多样性评价指标更新所述惩罚因子,包括:计算该多样性评价指标以及上一次迭代得到的多样性评价指标之间的指标差值;基于所述指标差值更新所述惩罚因子。

13.可选的,在所述基于任意主题句对应的所述候选段落确定该主题句的最优段落之前,还包括:计算任意主题句对应的所述候选段落中每句话与上一句话以及该主题句之间的语义相似度,得到第一语义相似度和第二语义相似度;若所述第一语义相似度和第二语义相似度均大于预设相似度阈值,则保留该句话,否则删除该句话以及该句话后面的文本,得到删除后文本;若所述删除后文本的字数大于预设字数阈值,则将该删除后文本作为该主题句对应的候选段落,否则基于所述删除后文本重新生成该主题句对应的候选段落。

14.可选的,所述基于任意主题句对应的所述候选段落确定该主题句的最优段落,包括:对于任意主题句,基于预设评分标准分别对每个候选段落打分,并将分数最高的候选段落确定为该主题句对应的最优段落。

15.可选的,所述基于任意主题句对应的所述候选段落确定该主题句的最优段落之

后,还包括:利用预设检测和修改逻辑对所述最优段落进行错误检测和修改。

16.第二方面,本技术公开了一种智能写作装置,包括:文章大纲生成模块,用于生成文章大纲;所述文章大纲包括所有段落的主题句;目标文本构建模块,用于将所述文章大纲中的任意主题句与从内容知识库中取出的与该主题句相关的段落组成目标文本;生成词概率获取模块,用于将目标文本输入预训练模型,得到字典中每个词为生成词的概率;目标词概率惩罚模块,用于基于惩罚因子对所述字典中目标词对应的所述概率进行惩罚;其中,所述目标词为在目标文本中存在的词;生成词取出模块,用于基于所述概率从所述字典中取出生成词;目标文本更新模块,用于基于所述生成词更新所述目标文本,得到新的目标文本;多样性评价指标计算模块,用于根据新的目标文本计算多样性评价指标;惩罚因子更新模块,用于基于该多样性评价指标更新所述惩罚因子,相应的,所述装置还用于触发生成词概率获取模块将新的目标文本输入预训练模型,不断迭代,直到生成词取出模块取出的生成词为截止符,则将当前的目标文本确定为该主题句对应的候选段落;最优段落确定模块,用于基于任意主题句对应的所述候选段落确定该主题句的最优段落。

17.第三方面,本技术公开了一种电子设备,包括存储器和处理器,其中:所述存储器,用于保存计算机程序;所述处理器,用于执行所述计算机程序,以实现前述的智能写作方法。

18.第四方面,本技术公开了一种计算机可读存储介质,用于保存计算机程序,其中,所述计算机程序被处理器执行时实现前述的智能写作方法。

19.可见,本技术先生成文章大纲,所述文章大纲包括所有段落的主题句,之后将所述文章大纲中的任意主题句与从内容知识库中取出的与该主题句相关的段落组成目标文本,并将目标文本输入预训练模型,得到字典中每个词为生成词的概率,基于惩罚因子对所述字典中目标词对应的所述概率进行惩罚,基于所述概率从所述字典中取出生成词,所述目标词为在目标文本中存在的词,基于所述生成词更新所述目标文本,得到新的目标文本,根据新的目标文本计算多样性评价指标,并基于该多样性评价指标更新所述惩罚因子,并将新的目标文本输入预训练模型,不断迭代,直到取出的生成词为截止符,则将当前的目标文本确定为该主题句对应的候选段落,之后基于任意主题句对应的所述候选段落确定该主题句的最优段落。也即,本技术先生成文章大纲,对于文章大纲中的任意主题句,生成候选段落并从候选段落中选出最佳段落,在生成候选段落的过程中,利用多样性评价指标指导重复度的惩罚因子自适应的调整,能够在解决文本重复问题的情况下,减少人工成本并提升参数调节的准确度。

附图说明

20.为了更清楚地说明本技术实施例或现有技术中的技术方案,下面将对实施例或现

有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本技术的实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据提供的附图获得其他的附图。

21.图1为本技术公开的一种智能写作方法流程图;图2为本技术公开的一种具体的知识库池示意图;图3为本技术公开的一种具体的最优段落生成示意图;图4为本技术公开的一种具体的候选段落生成示意图;图5为本技术公开的一种智能写作装置结构示意图;图6为本技术公开的一种电子设备结构图。

具体实施方式

22.下面将结合本技术实施例中的附图,对本技术实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本技术一部分实施例,而不是全部的实施例。基于本技术中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本技术保护的范围。

23.随着自然语言处理技术的不断发展,人工智能从“大炼模型”逐步迈向了“炼大模型”的阶段,利用先进的算法,整合大规模的数据,汇聚大量算力,训练出巨量人工智能模型,如gpt-3、ernie、t5等。这些预训练模型在不同的应用场景下都具有较好原始生成能力。其中,gpt3是一种自回归生成式的预训练语言模型,可以根据给定的文本信息来生成具有一定语义相关度的文本信息,例如回答问题,续写文章等。gpt主要利用了transformer(即转换器)的解码器部分来进行生成式的单向语言模型建模,根据已经出现的若干词语来预测当前输出词的概率分布。

24.目前,基于预训练模型生成短文本的能力尚可,但是生成长文本(如长段落或篇章)的能力欠缺,比较常见的是文本重复问题,现有的解决文本重复的问题通常是人工进行参数调节,这种方式比较耗时,人工成本较高,难以保障准确性。为此,本技术提供了一种智能写作方案,能够在解决文本重复问题的情况下,减少人工成本并提升参数调节的准确度。

25.参见图1所示,本技术实施例公开了一种智能写作方法,包括:步骤s11:生成文章大纲;所述文章大纲包括所有段落的主题句。

26.在一种实施方式中,可以基于用户选择的写作类型、输入的写作主题内容以及第一关键词生成文章大纲。具体的,可以从用户选择的写作类型对应的内容知识库中检索与写作所述主题内容最相关的模板文件;将所述模板文件中每个段落输入预训练模型,生成每个段落的主题句以及第二关键词;分别将每个段落的主题句以及第二关键词、所述第一关键词按照预设方式组成模型输入数据,并将模型输入数据输入预训练模型,生成每个段落对应的新的主题句;将每个段落的所述新的主题句组合,得到文章大纲。可以理解的是,模型输入数据为prompt(即提示)。

27.其中,本技术实施例可以从用户选择的写作类型对应文件名知识库中检索与所述写作主题内容最相关的文件名;从用户选择的写作类型对应的内容知识库中查找该文件名对应的模板文件。在一种实施方式中,可以利用bm25算法从用户选择的写作类型对应文件名知识库中检索与所述写作主题内容最相关的文件名。

28.并且,本技术实施例可以创建知识库池;其中,所述知识库池中包括各写作类型对应的文件名知识库和内容知识库;所述内容知识库包括各模板文件,所述文件名知识库包括各模板文件的文件名。模板文件可以为txt文件。

29.本技术实施例可以根据用户提供或通过网络获取的最新参考材料构建多场景知识库池,这样,利用最新参考资料构建知识库,检索相关知识,并与主题句组成prompt,输入预训练模型生成文本,使预训练模型学会最新知识并能对其进行分析,解决预训练模型不能跟进最新动态发展的问题。例如,参见图2所示,图2为本技术实施例公开的一种具体的知识库池示意图。本根据不同的应用场景对知识库分类构建,可以包括公文写作、新闻资讯、广告营销等多个写作类型,每个写作类型包括txt文件名知识库和txt内容知识库;每个txt的文件名与其内容的标题一致,txt文件名知识库就是由所有标题构建的;txt内容知识库由所有txt文件内容组成,每个txt是一篇最新参考文章,文章中的一段占txt中的一行。

30.进一步的,自动生成文章大纲的具体实现流程可以为:输入用户选择的写作类型、想写作的主题内容以及关键词k

new

(即第一关键词)。根据主题内容在写作类型下的txt文件名知识库中检索最相关的一条,根据检索到的文件名在txt内容知识库中找到对应的模板文件。(本技术实施例可以通过bm25okapi类中get_top_n函数实现),之后将模板文件按段输入预训练模型,生成每段的主题句及关键词k

old

(即第二关键词)。分别将旧关键词k

old

、每段主题句与新关键词k

new

按一定方式组合为prompt,输入预训练模型,生成新的主题句。最后,将所有段落主题句组合在一起作为文章大纲。例如,组成prompt的方法为:以“旧关键词”为关键词的主题句:“旧主题句”。以“新关键词”为关键词的主题句:需要指出的是,bm25算法是一种用来评价搜索词和文档之间相关性的算法,它是一种基于概率检索模型提出的算法,例如,有一个query(询问)和一批文档ds,现在要计算query和每篇文档d之间的相关性分数,先对query进行切分,得到单词,然后单词的分数由3部分组成:单词和d之间的相关性;单词和query之间的相关性;每个单词的权重。最后对于每个单词的分数做一个求和,就得到了query和文档之间的分数。

31.步骤s12:将所述文章大纲中的任意主题句与从内容知识库中取出的与该主题句相关的段落组成目标文本。

32.也即,本技术实施例对文章大纲中的每个主题句分别处理,分别得到每个主题句对应的目标文本,以得到每个主题句的最佳段落。

33.在具体的实施方式中,将所述文章大纲中的任意主题句与从用户选择的写作类型对应的内容知识库中取出的与该主题句相关的段落组成目标文本。可以理解的是,内容知识库为预先创建的保存模板文件的知识库。并且,可以检索出最相关的n个段落,n为大于等于1的正整数,比如1、2、3、4、5等。n个段落中每个与该主题句相关的段落分别与该主题句组成目标文本,以生成每个相关的段落对应的候选段落,得到n个候选段落。采用的检索方法可以为bm25算法。

34.步骤s13:将目标文本输入预训练模型,得到字典中每个词为生成词的概率。

35.步骤s14:基于惩罚因子对所述字典中目标词对应的所述概率进行惩罚,基于所述概率从所述字典中取出生成词;其中,所述目标词为在目标文本中存在的词。

36.在具体的实施方式中,可以基于惩罚因子调整参数以及惩罚因子对所述字典中目标词对应的所述概率进行惩罚。并且,在一种实施方式中,可以统计目标词在目标文本中出

现的次数,得到该目标词对应的所述惩罚因子调整参数,在另一种实施方式中,可以获取配置参数,作为目标词对应的所述惩罚因子调整参数。也即,惩罚因子调整参数可以为目标词在目标文本中出现的次数,也可以配置的常数。

37.并且,可以采用解码规则(比如temperature(温度)、topk、topp采样策略)从字典中基于概率选取生成词。选取时依据的概率为惩罚后的概率。

38.需要指出的是,重复惩罚的目的在于解决重复问题,通过惩罚因子将出现过词的概率变小或者强制不使用重复词来解决。合理设置惩罚因子能够避免重复,增加创新性,但是设置过大,生成长文本时起反作用。可以基于词出现的次数进行惩罚(frequency penalty),出现的次数越多,该词在后文出现的概率越低,同时增强后文的创造性。也可以基于词是否出现过进行惩罚(response penalty),对出现过的词进行惩罚,降低其在后文出现的概率,同时增强后文的创造性。与frequency penalty原理一致,只是多了对已输出token(词)去重,只保留出现一次。也可以重复词去除,大于等于1时起作用,表示输出中不包含长度为no_repeat_ngram_size的重复词。

39.进一步的,为了解决搜索生成缺乏多样性问题,可以通过采样策略来增加随机性。其中,temperature采样:通过强化顶部词的概率,只对最有可能的一些词进行采样,这样就能够在增加随机性的同时,又保证不出现一般性的错误。强化顶部词概率,可以通过对模型输出的logits除以一个小于1的温度(temperature,t)。

40.f(i)表示模型输出第i个词的初始概率,表示对词表中所有词都计算求和,p(i)表示强化后第i个词的概率。这样通过softmax后使得分布更加尖锐,大概率的词概率更大。之后根据获得概率对顶部词先进行挑选,然后再采样,直接杜绝了低概率词出现的可能性。

41.topk采样:挑选概率最高k个token,然后重新过softmax算概率,之后根据获得概率进行采样,接着进行下一步生成,不断重复。但关于topk有可能会出现一个问题,假如模型对当前生成非常肯定,比如概率最高的token的概率0.9,而其余的token概率都很低。这时如果只用topk采样的话,就会导致采样到低概率情况仍然发生。因此需要对顶部token的累计概率进行限制,这就是topp采样。

42.topp采样:先设置一个概率界限,比如说p=0.9,然后从最大概率的token往下开始取,同时将概率累加起来,当取到大于等于p也就是0.9时停止。如果最大token概率就已经有0.9了,那么就只取最大的一个token。

43.步骤s15:基于所述生成词更新所述目标文本,得到新的目标文本。

44.步骤s16:根据新的目标文本计算多样性评价指标,并基于该多样性评价指标更新所述惩罚因子,并将新的目标文本输入预训练模型,不断迭代,直到取出的生成词为截止符,则将当前的目标文本确定为该主题句对应的候选段落。

45.在具体的实施方式中,可以从所述新的目标文本中去除原始目标文本,得到计算文本;所述原始目标文本为文本大纲中的主题句与从内容知识库中取出的段落组成的目标

文本;根据所述计算文本计算多样性评价指标。

46.并且,可以计算该多样性评价指标以及上一次迭代得到的多样性评价指标之间的指标差值;基于所述指标差值更新所述惩罚因子。

47.需要指出的是,在nlp(即natural language processing,自然语言处理)领域中,多样性评价指标(distinct)用于判断机器回复的多样性,distinct指标判断是否出现大量的通用性、重复性回复。distinct的定义如下:distinct(n)=(count(unique ngram))/count(word),其中,count(unique ngram)表示回复中不重复的ngram数量,count(word)表示回复中ngram词语的总数量。distinct(n)越大表示生成回复的多样性越高。本技术实施例利用多样性评价指标调节惩罚因子。

48.进一步的,本技术实施例可以计算任意主题句对应的所述候选段落中每句话与上一句话以及该主题句之间的语义相似度,得到第一语义相似度和第二语义相似度;若所述第一语义相似度和第二语义相似度均大于预设相似度阈值,则保留该句话,否则删除该句话以及该句话后面的文本,得到删除后文本;若所述删除后文本的字数大于预设字数阈值,则将该删除后文本作为该主题句对应的候选段落,否则基于所述删除后文本重新生成该主题句对应的候选段落。可以理解的是,若候选段落为多个,分别执行前述步骤。也即,本技术实施例利用语义相似度检测并删除偏离主题的文本,重新生成符合条件的候选段落。

49.其中,语义相似度的具体计算流程为:首先对句子进行分词,然后对分好的每一个词获取其对应的vector(向量),然后将所有vector相加并求平均,得到句子vector,最后再利用如下公式计算其夹角余弦值即可。余弦值越接近1(即夹角越小)表示相似度越高。

50.其中,θ为向量x和y之间的夹角,xi和yi分别代表向量x和y的各分量,可以利用word2vec(产生词向量的模型)模型计算vector,是将所有的词向量化,这样词与词之间就可以定量的去度量他们之间的关系,挖掘词之间的联系。

51.步骤s17:基于任意主题句对应的所述候选段落确定该主题句的最优段落。

52.在具体的实施方式中,对于任意主题句,基于预设评分标准分别对每个候选段落打分,并将分数最高的候选段落确定为该主题句对应的最优段落。

53.在一种实施方式中,本技术实施例可以采用ppl指标分别对每个候选段落打分。ppl指的是语言模型中的perplexity(即困惑度),是衡量一句话是否通顺的指标。定义为:其中,表示根据上文词语预测第i个词的概率,n代表句子长度。ppl值越小,说明模型生成的文本越自然、语句越通顺。通过ppl来评价文本质量,可以避免模型生成的文本有乱序、前后颠倒的情形。

54.进一步的,本技术实施例可以利用预设检测和修改逻辑对所述最优段落进行错误检测和修改。

55.例如,参见图3所示,图3为本技术实施例公开的一种具体的最优段落生成示意图。具体包括以下步骤:

(a)输入用户选择的写作类型、所有段落的主题句、所有段落主题句的数目n、i的初始值1;(b)判断i《n+1,若是则获取当前第i个主题句,若否转到步骤(g);(c)采用bm25算法在写作类型对应的txt内容知识库中检索topn(即最相关的n个)相关段落;(d)将topn相关段落分别与主题句拼接组成prompt;(e)将n个prompt输入预训练模型生成n个符合主题的备选段落;(f)分别对n个备选段落基于ppl指标(1/score

ppl

)进行打分,选择最高分对应段落作为最佳段落输出至结果列表中,i+=1,转至步骤(b);(g)结果列表输出保存成txt文件。最终,结果列表中包括文章大纲中所有主题句对应的最佳段落。

56.进一步的,前述步骤(e)中主题句+相关段落组成prompt输入预训练模型,生成文本容易出现重复问题,包括生成内容本身重复和与输入重复两方面。本技术实施例采用惩罚参数自适应调整来解决该问题。参见图4所示,图4为本技术实施例公开的一种具体的候选段落生成示意图。具体包括以下步骤:(1)输入文本(即目标文本)i

in

,初始值为相关段落+主题句组成的prompt i0;(2)文本输入预训练模型,输出字典中所有词的概率;(3)对输入文本对应词进行惩罚,采用公式如下:其中,xi表示字典中任意一个词,若该词在输入文本i

in

中,则对该词对应的概率进行惩罚,n表示xi在输入文本中出现的次数或者常数1均可(根据不同场景设置),p是惩罚因子,初始值为1;(4)根据解码规则(可以为temperature、topk、topp采样策略)从字典中选取生成词t

new

;(5)更新输入文本i

in

+=t

new

,即将新生成词拼接在原输入文本后即可;根据新生成文本(即i

in

中去掉初始值i0)计算distinct(即多样性)指标,d

now

=(distinct(m)+distinct(m+1))/2,其中,m表示ngram的大小,需要根据不同场景设置不同值;(6)计算

∆

d,

∆

d=d

pre ‑ꢀdnow

,其中,d

pre

初始值为1,d

pre

= d

now

;(7)更新惩罚因子p,p=max(1,p+

∆

d);(8)继续步骤(2)直到生成截止符《eod》。

57.需要指出的是,其它的如temperature、topk、topp等参数也可参考惩罚因子的调整方案采用自适应调整策略。

58.进一步的,步骤(e)还需要解决长文本主题偏移问题,分别对所有备选段落进行如下操作:(a)获取一个备选答案;(b)利用训练好的word2vec模型计算候选答案中的每句话与主题句以及该句话前一句的语义相似度;(c)若两个相似度均大于设定阈值s则保留,否则删除该句及后面的文本;(d)统计备选段落字数,若大于设定阈值t则保留输出答案,否则基于剩余文本重新输入预训练模型生成,继续步骤(b)。

59.并且,智能写作生成的文章可能包含错别字、敏感词以及语法错误等,本技术实施

例可以检测并修改这些错误,最后人工对文章审核、发布。

60.需要指出的是,现有技术中,直接使用预训练语言模型不能跟进最新动态发展,由于预训练模型参数量巨大,即使finetune(微调)需要的数据和算力成本也会比较高。并且,基于预训练模型生成短文本(如一句话)的能力尚可,但是生成长文本(如长段落或篇章)的能力欠缺,最常见的是主题偏移和文本重复问题。而本技术利用最新参考资料构建知识库,检索相关知识,并与主题句组成prompt,输入预训练模型生成文本,通过该方法使预训练模型学会最新知识并能对其进行分析;利用文本多样性评价指标指导重复度惩罚参数自适应调整,节约人工调参的成本;利用语义相似度检测并删除偏离主题的文本,重新生成符合条件的候选段落。

61.下面,以公文写作为例,阐述本技术提供的智能写作方案:首先,构建公文写作知识库,以gpt3为例进行说明,gpt3于2020年发布,那么训练它的数据集是收集2020年及以前的,那么要让gpt3基于2021年到现在的最新动态生成文章,需要将相关资料其构建知识库。用户想通过智能写作自动撰写某公司的某个经济专项规划,收集最新材料。将各种形式的材料(pdf、word或图片)转换成txt文本,并构建公文写作的文件名知识库和内容知识库。数据库的构建方法可以采用python软件包rank_bm25中bm25okapi类实现。

62.进一步的,自动生成文章大纲:用户选择公文写作类型,输入的想写作的主题内容:请根据数字经济发展规划材料,撰写xx公司经济专项规划。通过bm25算法根据主题内容在文件名知识库中检索最相关的一条文件名,将对应的txt文件按段输入预训练模型,生成每段的主题句。然后分别将每段主题句与关键字组合prompt输入预训练模型,生成新的主题句。

63.prompt输入举例:以“智慧交通”为关键词的主题句:推进智慧交通建设。以“云中心”为关键词的主题句:预训练模型生成:推进云中心建设。

64.由于自动生成的文章大纲整体与检索模板一致,而实际应用中需要的大纲与模板还是有一定差距,需要人工干预修改。

65.然后生成最佳段落:假设某段主题为:a。可以采用bm25算法在文本知识库中检索获取得分最高的三个段落:top1、top2、top3。分别将top1、top2、top3与主题句拼接组成prompt,输入预训练模型,输出3个候选答案(即候选段落)。采用ppl指标作为评分标准,选取最高分者作为最优答案。在生成候选答案的过程中,采用惩罚参数自适应调整方法解决生成重复问题。其主要原理为当生成内容重复度升高时,增大惩罚因子,即加大模型对已生成词的惩罚力度,模型生成偏向未出现过的词。当生成内容重复度降低时,减小惩罚因子,即减小模型对已生成词的惩罚力度,防止模型生成因惩罚力度过大导致偏离主题。在生成候选答案的过程中,利用训练好的word2vec模型计算答案中的每句话与主题句的语义相似度,删除跑题语句,并补充符合语义的语句。

66.进一步的,人工审核、发布,使用github开源项目pycorrector(文本纠错开源工具)作为后处理模块,实现对生成的文章的错别字、敏感词、语法错误检测和修改;需要注意的是,本实施例以公文写作为例进行说明,但在实际应用中不仅局限于此,其它诸如新闻资讯、故事续写等领域的写作均可以此方式进行改进。

67.这样,为了解决基于预训练模型生成的文本内容缺乏对最新动态的分析问题,本技术基于最新参考资料构建知识库,通过检索算法检索与主题句相关知识,并与主题句组成prompt,输入预训练模型生成文本,通过此方案使模型学习与主题相关的最新知识。为了解决预训练模型生成文本容易重复但人工调参难问题,利用文本多样性评价指标指导重复度惩罚参数自适应调整,增大生成内容的多样性,减少人工调参的耗时费力,保证生成的文本既不重复又不会矫枉过正。为了解决预训练模型生成长文本易偏离主题问题,本技术将生成的每句话分别与主题句、前一句话进行语义相似度匹配,删除偏离主题语句,生成符合条件答案。进一步的,还细化了智能写作的整体实现方案及系统,进一步提高智能写作的自动化程度。

68.参见图5所示,本技术实施例提供了一种智能写作装置,包括:文章大纲生成模块11,用于生成文章大纲;所述文章大纲包括所有段落的主题句;目标文本构建模块12,用于将所述文章大纲中的任意主题句与从内容知识库中取出的与该主题句相关的段落组成目标文本;生成词概率获取模块13,用于将目标文本输入预训练模型,得到字典中每个词为生成词的概率;目标词概率惩罚模块14,用于基于惩罚因子对所述字典中目标词对应的所述概率进行惩罚;其中,所述目标词为在目标文本中存在的词;生成词取出模块15,用于基于所述概率从所述字典中取出生成词;目标文本更新模块16,用于基于所述生成词更新所述目标文本,得到新的目标文本;多样性评价指标计算模块17,用于根据新的目标文本计算多样性评价指标;惩罚因子更新模块18,用于基于该多样性评价指标更新所述惩罚因子,相应的,所述装置还用于触发生成词概率获取模块将新的目标文本输入预训练模型,不断迭代,直到生成词取出模块取出的生成词为截止符,则将当前的目标文本确定为该主题句对应的候选段落;最优段落确定模块19,用于基于任意主题句对应的所述候选段落确定该主题句的最优段落。

69.可见,本技术实施例先生成文章大纲,所述文章大纲包括所有段落的主题句,之后将所述文章大纲中的任意主题句与从内容知识库中取出的与该主题句相关的段落组成目标文本,并将目标文本输入预训练模型,得到字典中每个词为生成词的概率,基于惩罚因子对所述字典中目标词对应的所述概率进行惩罚,基于所述概率从所述字典中取出生成词,所述目标词为在目标文本中存在的词,基于所述生成词更新所述目标文本,得到新的目标文本,根据新的目标文本计算多样性评价指标,并基于该多样性评价指标更新所述惩罚因子,并将新的目标文本输入预训练模型,不断迭代,直到取出的生成词为截止符,则将当前的目标文本确定为该主题句对应的候选段落,之后基于任意主题句对应的所述候选段落确定该主题句的最优段落。也即,本技术实施例先生成文章大纲,对于文章大纲中的任意主题句,生成候选段落并从候选段落中选出最佳段落,在生成候选段落的过程中,利用多样性评价指标指导重复度的惩罚因子自适应的调整,能够在解决文本重复问题的情况下,减少人工成本并提升参数调节的准确度。

70.文章大纲生成模块11,具体用于基于用户选择的写作类型、输入的写作主题内容以及第一关键词生成文章大纲。

71.进一步的,文章大纲生成模块11,具体用于包括:模板文件检索单元,用于从用户选择的写作类型对应的内容知识库中检索与写作所述主题内容最相关的模板文件;模型生成单元,用于将所述模板文件中每个段落输入预训练模型,生成每个段落的主题句以及第二关键词;新主题句生成单元,用于分别将每个段落的主题句以及第二关键词、所述第一关键词按照预设方式组成模型输入数据,并将模型输入数据输入预训练模型,生成每个段落对应的新的主题句;文章大纲生成单元,用于将每个段落的所述新的主题句组合,得到文章大纲。

72.其中,模板文件检索单元,具体用于从用户选择的写作类型对应文件名知识库中检索与所述写作主题内容最相关的文件名;从用户选择的写作类型对应的内容知识库中查找该文件名对应的模板文件。

73.进一步的,所述装置还包括:知识库池创建模块,用于创建知识库池;其中,所述知识库池中包括各写作类型对应的文件名知识库和内容知识库;所述内容知识库包括各模板文件,所述文件名知识库包括各模板文件的文件名。

74.其中,目标词概率惩罚模块14,具体用于基于惩罚因子调整参数以及惩罚因子对所述字典中目标词对应的所述概率进行惩罚。

75.目标词概率惩罚模块14,还用于统计目标词在目标文本中出现的次数,得到该目标词对应的所述惩罚因子调整参数;或,获取配置参数,作为目标词对应的所述惩罚因子调整参数。

76.多样性评价指标计算模块17,具体用于从所述新的目标文本中去除原始目标文本,得到计算文本;所述原始目标文本为文本大纲中的主题句与从内容知识库中取出的段落组成的目标文本;根据所述计算文本计算多样性评价指标。

77.惩罚因子更新模块18,具体用于计算该多样性评价指标以及上一次迭代得到的多样性评价指标之间的指标差值;基于所述指标差值更新所述惩罚因子。

78.所述装置,还包括主题偏移纠正单元,用于:计算任意主题句对应的所述候选段落中每句话与上一句话以及该主题句之间的语义相似度,得到第一语义相似度和第二语义相似度;若所述第一语义相似度和第二语义相似度均大于预设相似度阈值,则保留该句话,否则删除该句话以及该句话后面的文本,得到删除后文本;若所述删除后文本的字数大于预设字数阈值,则将该删除后文本作为该主题句对应的候选段落,否则基于所述删除后文本重新生成该主题句对应的候选段落。

79.最优段落确定模块19,具体用于对于任意主题句,基于预设评分标准分别对每个候选段落打分,并将分数最高的候选段落确定为该主题句对应的最优段落。

80.所述装置还包括检测和修改模块,用于在所述基于任意主题句对应的所述候选段落确定该主题句的最优段落之后,利用预设检测和修改逻辑对所述最优段落进行错误检测

和修改。

81.参见图6所示,本技术实施例公开了一种电子设备20,包括处理器21和存储器22;其中,所述存储器22,用于保存计算机程序;所述处理器21,用于执行所述计算机程序,前述实施例公开的智能写作方法。

82.关于上述智能写作方法的具体过程可以参考前述实施例中公开的相应内容,在此不再进行赘述。

83.并且,所述存储器22作为资源存储的载体,可以是只读存储器、随机存储器、磁盘或者光盘等,存储方式可以是短暂存储或者永久存储。

84.另外,所述电子设备20还包括电源23、通信接口24、输入输出接口25和通信总线26;其中,所述电源23用于为所述电子设备20上的各硬件设备提供工作电压;所述通信接口24能够为所述电子设备20创建与外界设备之间的数据传输通道,其所遵循的通信协议是能够适用于本技术技术方案的任意通信协议,在此不对其进行具体限定;所述输入输出接口25,用于获取外界输入数据或向外界输出数据,其具体的接口类型可以根据具体应用需要进行选取,在此不进行具体限定。

85.进一步的,本技术实施例还公开了一种计算机可读存储介质,用于保存计算机程序,其中,所述计算机程序被处理器执行时实现前述实施例公开的智能写作方法。

86.关于上述智能写作方法的具体过程可以参考前述实施例中公开的相应内容,在此不再进行赘述。

87.本说明书中各个实施例采用递进的方式描述,每个实施例重点说明的都是与其它实施例的不同之处,各个实施例之间相同或相似部分互相参见即可。对于实施例公开的装置而言,由于其与实施例公开的方法相对应,所以描述的比较简单,相关之处参见方法部分说明即可。

88.结合本文中所公开的实施例描述的方法或算法的步骤可以直接用硬件、处理器执行的软件模块,或者二者的结合来实施。软件模块可以置于随机存储器(ram)、内存、只读存储器(rom)、电可编程rom、电可擦除可编程rom、寄存器、硬盘、可移动磁盘、cd-rom、或技术领域内所公知的任意其它形式的存储介质中。

89.以上对本技术所提供的一种智能写作方法、装置、设备及介质进行了详细介绍,本文中应用了具体个例对本技术的原理及实施方式进行了阐述,以上实施例的说明只是用于帮助理解本技术的方法及其核心思想;同时,对于本领域的一般技术人员,依据本技术的思想,在具体实施方式及应用范围上均会有改变之处,综上所述,本说明书内容不应理解为对本技术的限制。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1