一种基于双向注意力机制的文本摘要生成方法

本发明涉及文本摘要,具体为一种基于双向注意力机制的文本摘要生成方法。

背景技术:

1、随着互联网技术的快速发展,计算机和智能手机等设备的普及,信息媒体和传播方式已经发生了巨大的变化,人们越来越青睐于从互联网上获取他们需要的信息。2018年年初,来自中国互联网络信息中心的一份网络调查报告显示,截至到2017年年底,中国网民数量离8亿又更近一步,2017年一年新增网民四千多万人;普及率更是超过了55%,在2016年底的基础上,增长超过两个百分点[1。同时,上网使每个人都成为了信息的生产者、传播者、获取者,网上资源指数增长,信息铺天盖地,人们应接不暇。很多时候,人们发现,面对网络上的大量数据,选择并找到自己需要的或重要的一些相关信息,要浪费掉很多的时间和精力。换句话说,互联网时代是一个信息超载的时代。丰富的信息资源使人们获得更全面的信息成为可能,同时人们在获取有效资源的过程中也面临着许多挑战。一端是海量的数据,一端是人们殷切的需求,如何快速精准定位所需信息,如何帮助用户有效地浏览和查阅海量的网上资源,如何有效地对文档做摘要,过滤掉不重要的信息,是一个刻不容缓、急需解决的问题。

2、文本摘要技术是从大量文本(如文本文档、文章或博客)中生成简洁而重要的信息的方法。摘要是描述一组段落或文本文件的一小段总结性的句子,文本摘要旨在消除文档冗余内容,同时保留原始文档的关键内容,对指定文档提取简洁而重要的信息。生成的摘要通常少于原始文本数据的40%,对于较长的文本,这个比例会进一步减少。摘要应保留文件中存在的重要数据,应该是可控、简短和简洁的。根据单词和句子的位置等各种参数,以多种方式对文本数据进行概括。在网上冲浪时,这些经过概括的少量语句,提供了简洁明确的重要信息;用户可以将摘要看作原来的文本信息的一个替代。通过文本摘要,用户不需要逐个点击所有文档,方便获取喜爱的信息,从而减少信息干扰,加快阅读速度。在搜索引擎的搜索和索引中,使用短小精悍的摘要代替检索全文,或简单地对抽象文本进行索引,大大提高了处理效率。文本摘要技术也被用于搜索引擎查询结果的显示,并呈现给用户通过返回一个简单的搜索结果的摘要,允许用户选择是否要点击结果摘要跳转到原始的网页。

3、然而重症患者在进行护理时,通常需要将患者进行移位,如果直接将患者抬起,无疑会增加患者的痛苦,而且对于有些患者,轻易将其抬起都会造成二次伤害,为此,我们提出一种基于双向注意力机制的文本摘要生成方法。

技术实现思路

1、本发明的目的在于提供一种基于双向注意力机制的文本摘要生成方法,以解决上述背景技术中提出的问题。

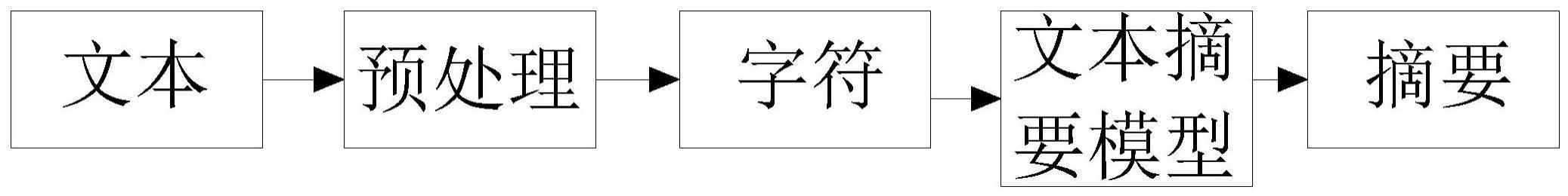

2、为实现上述目的,本发明提供如下技术方案:一种基于双向注意力机制的文本摘要生成方法,包括以下步骤;

3、步骤一、预处理,预处理步骤一般就是分词,去噪,词数字化;

4、步骤二、词嵌入,自然语言处理和机器学习结合时,都将面临将符号、符号序列或符号结构转换为机器学习能使用的向量的问题;

5、步骤三、第一种结构类似于前馈nnlm,去掉非线性隐层,所有的词(不只是投影权重矩阵)共享投影层;

6、步骤四、连续词袋模型,第一种结构类似于前馈nnlm,去掉非线性隐层,所有的词(不只是投影权重矩阵)共享投影层;

7、步骤五、word2vec的skip-gram模型,第二种体系结构类似于cbow,但它不是基于上下文预测当前单词,而是尝试基于同一句子中的另一个单词来最大化单词的分类;

8、步骤六、知识迁移技术,在许多机器学习和数据挖掘算法中,一个重要的假设就是目前的训练数据和将来的训练数据,一定要在相同的特征空间并且具有相同的分布。

9、优选的,它通过将机器摘要与人类撰写的摘要进行比较来自动确定摘要质量,计算人类撰写的理想摘要与计算机生成的摘要之间的重叠单位数,例如n-gram,单词序列和单词对。

10、优选的,序列z=[zi,z2,....,zn]是另一个序列x=[x1,x2,...,xm]的子序列,如果x的所有索引比如j=1,2,....,k,存在严格的递增序列[i,i,..,i],那么,xij=z[39]。给定两个序列x和y,x和y具有最大长度的公共子序列被称为为最长公共子序列(lcs),lcs已被用于在从平行文本中,找出最好的n元翻译词汇,melamed40]使用两个单词的lcs长度与两个单词中较长单词的长度之间的比率(lcsr)来衡量它们之间的同源性,他使用lcs作为近似字符串匹配算法,saggion等人[37l使用归一化成对lcs来比较自动摘要评估中两个文本之间的相似性。

11、优选的,字符组成词,词形成句子,句子形成文档,词作为文档的最小语义单位,词向量可以用作各种自然语言处理任务中的特征,在文档分类和文档摘要任务中扮演着至关重要的角色,第二章介绍了word2vec技术,可知由word2vec训练的词向量,训练集越大训练得到的词向量质量越高,说明可以通过增大训练集来改善词向量,本章针对训练集问题采用了知识迁移技术,利用外部数据集维基百科来扩充词向量训练的数据集。第二章介绍了tfidf等传统特征,这些特征曾在词嵌入技术出现之前被广泛应用在词特征表示上,因此,本章考虑把这些特征和知识迁移后的词特征做融合,来进一步改善词向量表示,从而采用基于知识迁移融合多种特征的文档词向量表示方法,为后续的文本摘要任务奠定基础。

12、优选的,首先用外部数据集(维基百科)训练词向量,准备做知识迁移;接着在训练集做知识迁移,继续训练词向量,同时,从训练集获得词其它传统语言特征,如词性标记,命名实体标记,tf和idf,以及tf-idf组合特征;最后对于源文档中的每个单词,查找其词嵌入和传统特征,并将它们连接成一个长向量,完成特征融合,组成新的词向量,用于后续任务。

13、优选的,数据集的大小对词嵌入的质量起着决定性作用,为了解决nlp任务中,训练数据不够充裕而影响词嵌入的质量,这里引入外部数据集来做知识迁移辅助训练词向量,这里选择维基百科的数据作为外部数据集,然后利用了gensim里的维基百科处理类wikicorpus,通过get_texts将维基里的每篇文章转换位1行text文本,并且去掉了标点符号等内容,繁简体,分词等预处理,最后跑word2vec模型,训练得到外部数据集(这里指维基百科文本)词向量。

14、优选的,用gensim加载训练好的外部数据集词向量,以及参数,对nlp任务比如文本分类,摘要等的训练集,用结巴分词,去停用词等预处理,加载预处理后的训练数据,更新词表,继续训练词向量,保存知识迁移后的词向量。

15、优选的,对任务训练集预处理,用hanlp等工具包进行词性标注,命名实体识别,再对词性标注,命名实体识别进行哑变量处理,变成数字表示好做后面的融合,同时编程计算每个词的tf,idf,tf-idf值,编程实现时,这里要注意,由于数据集大,词语词典达到几十万之多,建立向量空间模型时注意记得采用scipy的行列压缩的稀疏矩阵,不然会报内存溢出。

16、与现有技术相比,本发明的有益效果是:为了更好的提取文本特征,设计了基于知识迁移融合多种特征的文档词向量。一方面,为了得到更高质量的词嵌入,加入外部知识集进行训练,再迁移在训练集上做增量训练;另一方面,为了融入好的传统特征,对增量训练完的词嵌入和传统特征进行融合,为后续nlp任务,如文本分类、文本摘要等提供了好的底层特征,在文本摘要任务中,为了获取文本上下文依赖关系,采用了两层双向lstm编码,从词和句子层面捕获语义特征,引入注意力机制,动态生成上下文语境,让工作方式更接近人类,在文本摘要任务中,为了防止关键内容重复生成以及摘要更通顺,模型引入了覆盖机制,对已生成过的词进行惩罚,解决内容重复生成;模型采用了混合指针生成器网络,使文本摘要更通顺,进一步提高了文本摘要的效果,基于本文的采用的模型,设计并实现了基于注意力机制的文本摘要原型系统。

- 还没有人留言评论。精彩留言会获得点赞!