基于样本增强和自训练的低资源文本智能评阅方法和装置与流程

1.本发明公开基于样本增强和自训练的低资源文本智能评阅方法和装置,属于自然语言处理的技术领域。

背景技术:

2.文本智能评阅是人工智能和自然语言处理研究领域的重要问题,是指对于给定知识点的参考答案文本、若干学生答案文本以及预先定义的分数段类型,采用神经网络模型对学生答案所属分数类型进行判定。由于专业领域文本内容需要专家评阅,获取标记数据成本高昂,导致只有极少量样本可用的低资源情况。智能评阅能够降低人工评阅成本,去除个体偏见,具有重要实用价值。

3.现有文本理解技术主要采用深度学习,依赖大量样本以监督学习方式训练模型,较少的样本则会严重影响模型性能。针对样本数量少的情况,相关工作通常采用数据增强技术来增强初始少量样本的信息量。

4.例如中国专利文献cn115048940a公开基于实体词属性特征和回译的中文金融文本数据增强方法,其中使用“回译”和专业词汇替换对文本进行增强。但是“回译”数据增强技术受限于翻译模型的翻译质量,尤其对于专业文本的“回译”增强效果不佳。对于文本对形式的专业领域评阅样本,“回译”并不能有效增强文本对的交互信息,仅可增强单文本的语义信息。

5.另外,基于初始少量样本并引入大量无标记数据进行模型自训练也是突破极少样本限制进而提升模型性能的有效方式,例如中国专利文献cn114357153a公开一种文本分类模型训练方法、装置、文本分类方法及装置,其中利用初始少量样本训练模型后预测无标记数据的伪标记,并对大量伪样本进行监督学习以增强模型性能。自训练技术利用现有模型对无标记数据标注伪标记后扩充到原有训练集中进行训练,故伪标记的准确性对后续自训练模型的性能影响较大。自训练技术中标注伪标记的策略需要被精心设计,以缓解可能存在的错误累积问题。

6.综上,在现有技术中,怎样在低资源专业文本智能评阅中摆脱样本数量受限成为新的技术突破思路。

技术实现要素:

7.本发明公开一种基于样本增强和自训练的低资源文本智能评阅方法本发明还公开一种实现上述评阅方法的装置。

8.本发明的技术方案如下:基于样本增强和自训练的低资源文本智能评阅方法,其特征在于,包括:(1)样本增强:用于完成对输入的评阅样本的增强任务,得到增强后的评阅样本;(2)样本困难性评价:用于在评阅模型微调和自训练过程中计算每个样本的困难性,根据困难性为样本施加不同优化权重,以降低简单样本和噪音样本的优化力度,提升困

难样本的优化力度;(3)评阅模型微调及自训练:用于基于样本增强后的评阅样本对评阅模型进行微调训练;然后引入大量同源无标记数据进行伪标记预测并扩充到原训练集中,对评阅模型进行自训练。

9.根据本发明优选的,所述步骤(1)所述样本增强的具体方法包括,对输入的少量评阅样本进行增强:初始少量评阅样本包括多个知识点上的若干文本推理样本;每个知识点上的样本表示为的集合,其中为包含代表该知识点的参考答案文本和学生答案文本的文本对形式,推理标记表示文本对的蕴含和非蕴含两种推理关系;其中,蕴含关系表示学生答案文本在参考答案文本所关联的知识点上与参考答案文本语义一致,非蕴含关系则表示不一致;(1-1)利用少量评阅样本构建nli任务的蕴含、矛盾、中立三分类样本来进行样本增强,所述nli任务是指类似自然语言推理任务,nli是英文natural language inference的缩写,nli任务识别输入的《前提,假设》文本对的推理关系属于蕴含、矛盾、中立中的一种;本发明所述样本增强方法,使得不同知识点间以及相同知识点内的学生答案文本的语义也可以得到交互,可用于在评阅模型微调及自训练时对输入的训练用评阅样本进行增强,形式如表1所示:(1-1-1)构造蕴含样本,使得同知识点中两个语义一致的单文本得到信息交互,从单个知识点的样本中采样构造,包含两类构造方式:参考答案文本和呈蕴含关系的学生答案文本组成的文本对;同参考答案文本呈蕴含关系的任意两个学生答案文本组成的文本对,其标签,表蕴含;(1-1-2)构造矛盾样本,使得同知识点中两个语义不一致的单文本得到信息交互,从单个知识点的样本中采样构造,包含两类构造方式:参考答案文本和呈非蕴含关系的学生答案文本组成的文本对;同参考答案文本分别呈蕴含和非蕴含关系的任意两个学生答案文本组成的文本对,其标签,表矛盾;(1-1-3)构造中立样本,使得不同知识点(文本关注点不同)中的单文本的语义信息得到交互,从不同知识点采样进行构造,包括某一个知识点的参考答案文本或学生答案文本,和另一知识点的学生答案文本的交互文本对或,其标签,表中立;(1-2)评阅模型对参考答案文本和学生答案文本位置调换的文本对样本进行预测时,其预测结果不变,为保证模型鲁棒性,将包含参考答案文本的文本对进行翻转增强,其标签不变;定义蕴含、矛盾、中立三类增强样本的构造比例分别为,许可一般情况,,,且,优选的,、、,具体比例见表1,为保证增强前的少量样本中的信息被充分包含,其中与不使用随机采样方式构造,而是直接使用增强前的全部样本,占比,故增强后数据集大小是增强前的

倍:表1.样本增强构造方式及比例根据本发明优选的,所述步骤(2)中样本困难性评价的具体方法,包括:评阅模型输入样本进行监督学习,由于数据集中可能存在噪音样本且样本的推理难度存在差异,对此,根据评阅模型微调时计算样本优化的梯度大小来评价样本困难性,并设计难度敏感(difficulty sensitive)损失通过在微调时对样本产生的交叉熵损失进行加权,来提高对困难样本的优化力度,降低模型对简单样本以及噪音样本的优化力度;为了使评阅模型反向传播的梯度能有效反映样本困难性;(2-1)使用交叉熵损失函数训练评阅模型,经过若干轮训练让评阅模型拟合简单样本;交叉熵损失如公式(i):(i)其中,为类别标签的独热向量;为评阅模型预测的概率分布;(2-2)计算评阅模型优化每个样本时反向传播的梯度大小来量化样本的困难性:评阅模型通过多分类器输出概率分布,为神经网络给分类器的输入,推导梯度知分别是的第元素值;定义样本困难性量化值为梯度模长之和的一半:为梯度模长之和的一半:其中,样本困难性量化值;为表示样本类别的标签集合,为样本所属类别的标签;为概率分布的第元素值,代表着评阅模型预测出样本为第类的概率;由于先用交叉熵损失函数训练使得评阅模型可以较好拟合简单样本,反向传播时简单样本产生的梯度较小,困难样本产生梯度较大,噪音样本产生梯度最大,综上,利用样本困难性量化值值大小反应样本难易,越大样本越困难,且值越靠近1的有较大概率为噪音样本;

公式(iii)所示正态分布函数为加权函数,优选的,::::其中,加权函数如附图1所示,横坐标为值,纵坐标为正态分布函数的值,由图像可知值接近0和1时函数值较小;根据困难性量化值利用函数对样本的交叉熵损失进行加权,得到如公式(iv)所示难度敏感损失函数,达到重点优化困难样本,降低简单样本和噪音样本优化力度的目的;样本困难性评价利用和两阶段损失函数训练评阅模型,在下述评阅模型微调及自训练中用于训练评阅模型。

10.根据本发明优选的,所述步骤(3)评阅模型微调及自训练中:微调是指对评阅模型参数进行微调,将评阅样本中的文本对输入给所述评阅模型,利用评阅模型的输出和样本标签计算损失函数值,利用损失函数值计算评阅模型参数的梯度,采用梯度下降的方式对参数进行微调;在专业领域考试中,易获取大量未评阅学生答案文本及对应参考答案文本作为无标记数据,在评阅模型微调后引入大量无标记数据参与评阅模型自训练。

11.根据本发明优选的,所述评阅模型微调涉及的评阅样本为样本增强后的评阅样本,损失函数为样本困难性评价中的两阶段损失函数;采用验证集早停机制结束模型微调,早停轮数设置为5;采用adam优化器对评阅模型参数进行优化,学习率设置为;评阅模型采用基于bert(bidirectionalencoder representations from transformers)编码的文本对分类模型bert-softmax,即评阅模型为bert-softmax评阅模型;bert编码器在大规模通用语料库上进行掩码语言模型(mask language model, mlm)和下一句预测(nextsentence prediction, nsp)任务的预训练,能有效编码文本对语义应用于专业文本智能评阅任务;将文本对以分类模型bert-softmax所需格式输入,选择位置的输出向量作为文本对语义交互表示向量,输入多层感知机。

12.根据本发明优选的,所述感知机层数设置为2,如公式(v)和(vi)所示,感知机第一层权重及偏置项为和、经非线性激活输出表示向量,第二层权重及偏置项为和,输出表示向量,后经过分类器得到标签集合上的预测概率分布,预测类别为;;;;;;

。

13.根据本发明优选的,所述步骤(3)评阅模型微调及自训练的具体方法,在专家标注的初始样本集上,为其中每个知识点样本集都引入同批次考试的大量未评阅学生答案文本作为同源的无标记数据,表示为文本对的集合,为对应知识点的参考答案文本,为对应知识点的无标记学生答案文本;采用投票方式获取高置信伪样本,并将所述伪样本加入到评阅模型自训练过程中;输入bert-softmax评阅模型、初始样本集中多个知识点的无标记数据集合,微调及自训练步骤如下:(3-1)样本增强及评阅模型微调:采用步骤(1)的样本增强方法对进行增强得到增强样本集,作为训练用标记数据,对bert-softmax评阅模型进行微调得到评阅模型;(3-2)隐式特征计算:对于初始样本集中一个知识点的样本集,与对应知识点的无标记数据中的无标记学生答案文本组成文本库;对学生答案文本,计算学生答案文本的tf-idf向量,使用主成分分析法(principalcomponent analysis, pca)分析tf-idf向量的主要特征并进行降维,得到学生答案文本的隐式特征向量为,优选的,隐式向量特征维度选取为32;(3-3)伪标记预测及置信伪样本采样:对于无标记数据,构造关于的敏感文本对集合:;其中,为隐式特征向量最靠近隐式特征向量的个带蕴含标签的学生答案文本;使用评阅模型进行关系预测,得到个预测结果,相应的预测类别为;采用众数投票方式,得的伪标记为;计算第次推理的概率分布对伪标记的预测概率与最大非伪标记预测概率之差,作为第次推理对于伪标记的置信度,越大置信度越高,其中::综合次置信度量,得文本的伪标记置信度量化值为::其中,越大,无标记数据的伪标记越置信;从中根据值从大到小不放回采样伪样本,采样和原相同的数据量,扩充至中得到样本集,对每个

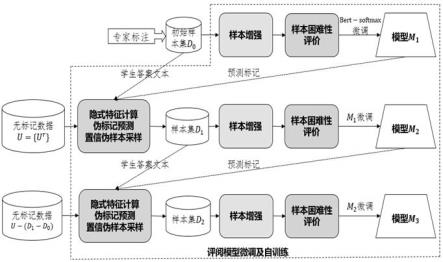

知识点对应样本集经过上述扩充过程后,原样本集扩充为新样本集;(3-4)回到步骤(3-1),以样本集在评阅模型上继续微调,为不放回采样后剩下的无标记数据集合;重复步骤(3-1)至步骤(3-3)共轮,每轮训练用样本量扩充为原先的两倍,即,最终通过上述自训练过程得到评阅模型,优选的,自训练轮数设为3,评阅模型三轮自训练过程如附图2所示。

14.一种实现上述评阅方法的装置,其上存储有计算机程序,其特征在于,该计算机程序被处理器执行时实现本发明记载的任一项所述方法的步骤。

15.本发明的技术优势在于:1)本发明所提出的评阅样本增强方法,能够更好地增加文本对中参考答案文本和学生答案文本或学生答案文本之间的交互信息量,相较于现有工作基于单文本的语义增强技术,能更好适合于评阅样本数量有限的情况,提升了样本增强效果和模型的鲁棒性。

16.2)本发明所提出的样本困难性评价方法,能够针对性地提高困难样本的优化力度,降低简单样本和噪音样本的优化力度,相较于基于交叉熵损失函数的监督训练,能增强评阅模型在训练数据中存在噪音样本和简单样本时的性能。

17.3)本发明所提出的评阅模型微调及自训练,能够有效提升评阅模型在少量样本情况下的评阅性能。其中提出了基于投票的伪标记预测方法以及基于置信度的伪样本采样方法,相比于使用模型单次预测结果作为伪标记以及单次预测概率作为伪标记置信度的方法,能够提升伪标记的准确率,缓解自训练过程中基于伪样本进行监督学习时存在的错误累积问题。

附图说明

18.图1为本发明中所述的加权函数的图像;图2为本发明评阅模型经历三轮自训练过程示意图,其中。

具体实施方式

19.下面结合实施例和说明书附图对本发明做详细的说明,但不限于此。

20.实施例1、基于样本增强和自训练的低资源文本智能评阅方法,包括:(1)样本增强:用于完成对输入的评阅样本的增强任务,得到增强后的评阅样本;(2)样本困难性评价:用于在评阅模型微调和自训练过程中计算每个样本的困难性,根据困难性为样本施加不同优化权重,以降低简单样本和噪音样本的优化力度,提升困难样本的优化力度;(3)评阅模型微调及自训练:用于基于样本增强后的评阅样本对评阅模型进行微调训练;然后引入大量同源无标记数据进行伪标记预测并扩充到原训练集中,对评阅模型进行自训练。

21.所述步骤(1)所述样本增强的具体方法包括,对输入的少量评阅样本进行增强:

初始少量评阅样本包括多个知识点上的若干文本推理样本;每个知识点上的样本表示为的集合,其中为包含代表该知识点的参考答案文本和学生答案文本的文本对形式,推理标记表示文本对的蕴含和非蕴含两种推理关系;其中,蕴含关系表示学生答案文本在参考答案文本所关联的知识点上与参考答案文本语义一致,非蕴含关系则表示不一致;(1-1)利用少量评阅样本构建nli任务的蕴含、矛盾、中立三分类样本来进行样本增强,所述nli任务是指类似自然语言推理任务,nli是英文natural language inference的缩写,nli任务识别输入的《前提,假设》文本对的推理关系属于蕴含、矛盾、中立中的一种;本发明所述样本增强方法,使得不同知识点间以及相同知识点内的学生答案文本的语义也可以得到交互,可用于在评阅模型微调及自训练时对输入的训练用评阅样本进行增强,形式如表1所示:(1-1-1)构造蕴含样本,使得同知识点中两个语义一致的单文本得到信息交互,从单个知识点的样本中采样构造,包含两类构造方式:参考答案文本和呈蕴含关系的学生答案文本组成的文本对;同参考答案文本呈蕴含关系的任意两个学生答案文本组成的文本对,其标签,表蕴含;(1-1-2)构造矛盾样本,使得同知识点中两个语义不一致的单文本得到信息交互,从单个知识点的样本中采样构造,包含两类构造方式:参考答案文本和呈非蕴含关系的学生答案文本组成的文本对;同参考答案文本分别呈蕴含和非蕴含关系的任意两个学生答案文本组成的文本对,其标签,表矛盾;(1-1-3)构造中立样本,使得不同知识点(文本关注点不同)中的单文本的语义信息得到交互,从不同知识点采样进行构造,包括某一个知识点的参考答案文本或学生答案文本,和另一知识点的学生答案文本的交互文本对,其标签,表中立;(1-2)评阅模型对参考答案文本和学生答案文本位置调换的文本对样本进行预测时,其预测结果不变,为保证模型鲁棒性,将包含参考答案文本的文本对进行翻转增强,其标签不变;定义蕴含、矛盾、中立三类增强样本的构造比例分别为,许可一般情况,优选的,,具体比例见表1,为保证增强前的少量样本中的信息被充分包含,其中不使用随机采样方式构造,而是直接使用增强前的全部样本,占比,故增强后数据集大小是增强前的倍:表1.样本增强构造方式及比例

所述步骤(2)中样本困难性评价的具体方法,包括:评阅模型输入样本进行监督学习,由于数据集中可能存在噪音样本且样本的推理难度存在差异,对此,根据评阅模型微调时计算样本优化的梯度大小来评价样本困难性,并设计难度敏感(difficulty sensitive)损失sensitive)损失sensitive)损失通过在微调时对样本产生的交叉熵损失进行加权,来提高对困难样本的优化力度,降低模型对简单样本以及噪音样本的优化力度;为了使评阅模型反向传播的梯度能有效反映样本困难性;(2-1)使用交叉熵损失函数训练评阅模型,经过若干轮训练让评阅模型拟合简单样本;交叉熵损失如公式(i):简单样本;交叉熵损失如公式(i):其中,为类别标签的独热向量;为评阅模型预测的概率分布;(2-2)计算评阅模型优化每个样本时反向传播的梯度大小来量化样本的困难性:评阅模型通过多分类器输出概率分布,为神经网络给分类器的输入,推导梯度知分别是的第元素值;定义样本困难性量化值为梯度模长之和的一半:为梯度模长之和的一半:其中,样本困难性量化值;为表示样本类别的标签集合,为样本所属类别的标签;为概率分布的第元素值,代表着评阅模型预测出样本为第类的概率;由于先用交叉熵损失函数训练使得评阅模型可以较好拟合简单样本,反向传播时简单样本产生的梯度较小,困难样本产生梯度较大,噪音样本产生梯度最大,综上,利用样本困难性量化值值大小反应样本难易,越大样本越困难,且值越靠近1的有较大概率为噪音样本;公式(iii)所示正态分布函数为加权函数,优选的,::

其中,加权函数如附图1所示,横坐标为值,纵坐标为正态分布函数的值,由图像可知值接近0和1时函数值较小;根据困难性量化值,利用函数对样本的交叉熵损失进行加权,得到如公式(iv)所示难度敏感损失函数,达到重点优化困难样本,降低简单样本和噪音样本优化力度的目的;样本困难性评价利用和两阶段损失函数训练评阅模型,在下述评阅模型微调及自训练中用于训练评阅模型。

22.所述步骤(3)评阅模型微调及自训练中:微调是指对评阅模型参数进行微调,将评阅样本中的文本对输入给所述评阅模型,利用评阅模型的输出和样本标签计算损失函数值,利用损失函数值计算评阅模型参数的梯度,采用梯度下降的方式对参数进行微调;在专业领域考试中,易获取大量未评阅学生答案文本及对应参考答案文本作为无标记数据,在评阅模型微调后引入大量无标记数据参与评阅模型自训练。

23.实施例2、如实施例1所述基于样本增强和自训练的低资源文本智能评阅方法,所述评阅模型微调涉及的评阅样本为样本增强后的评阅样本,损失函数为样本困难性评价中的两阶段损失函数;采用验证集早停机制结束模型微调,早停轮数设置为5;采用adam优化器对评阅模型参数进行优化,学习率设置为;评阅模型采用基于bert(bidirectionalencoder representations from transformers)编码的文本对分类模型bert-softmax,即评阅模型为bert-softmax评阅模型;bert编码器在大规模通用语料库上进行掩码语言模型(mask language model, mlm)和下一句预测(nextsentence prediction, nsp)任务的预训练,能有效编码文本对语义应用于专业文本智能评阅任务;将文本对以分类模型bert-softmax所需格式输入,选择位置的输出向量作为文本对语义交互表示向量,输入多层感知机。

24.所述感知机层数设置为2,如公式(v)和(vi)所示,感知机第一层权重及偏置项为和、经非线性激活输出表示向量,第二层权重及偏置项为,输出表示向量,后经过分类器得到标签集合上的预测概率分布,预测类别为;;;;;;;;。

25.实施例3、如实施例1所述基于样本增强和自训练的低资源文本智能评阅方法,所述步骤(3)

评阅模型微调及自训练的具体方法,输入bert-softmax评阅模型、初始样本集中多个知识点的无标记数据集合,微调及自训练步骤如下:(3-1)样本增强及评阅模型微调:采用步骤(1)的样本增强方法对进行增强得到增强样本集,作为训练用标记数据,对bert-softmax评阅模型进行微调得到评阅模型;(3-2)隐式特征计算:对于初始样本集中一个知识点的样本集,与对应知识点的无标记数据中的无标记学生答案文本组成文本库;对学生答案文本,计算学生答案文本的tf-idf向量,使用主成分分析法(principal component analysis, pca)分析tf-idf向量的主要特征并进行降维,得到学生答案文本的隐式特征向量为,优选的,隐式向量特征维度选取为32;(3-3)伪标记预测及置信伪样本采样:对于无标记数据,构造关于的敏感文本对集合:;其中,为隐式特征向量最靠近隐式特征向量的个带蕴含标签的学生答案文本;使用评阅模型进行关系预测,得到个预测结果,相应的预测类别为;采用众数投票方式,得的伪标记为;计算第次推理的概率分布对伪标记的预测概率与最大非伪标记预测概率之差,作为第次推理对于伪标记的置信度,越大置信度越高,其中::综合次置信度量,得文本的伪标记置信度量化值为::其中,越大,无标记数据的伪标记越置信;从中根据值从大到小不放回采样伪样本,采样和原相同的数据量,扩充至中得到样本集,对每个知识点对应样本集经过上述扩充过程后,原样本集扩充为新样本集;(3-4)回到步骤(3-1),以样本集在评阅模型上继续微调,为不放回采样后剩下的无标记数据集合;重复步骤(3-1)至步骤(3-3)共轮,每轮训练用样本量扩充为原先的两倍,即,最终通过上述自训练过程得到评阅模型,优选的,自训练轮数设为

3,评阅模型三轮自训练过程如附图2所示。模型均为bert-softmax评阅模型的多次模型参数迭代版本。

26.实施例4、一种实现如实施例1、2、3所述评阅方法的装置,其上存储有计算机程序,该计算机程序被处理器执行时实现本发明记载的任一项所述方法的步骤。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1