基于多尺度深度学习的自适应航拍目标检测方法与流程

本发明属于模式识别与智能计算、图像处理,特别涉及一种基于多尺度深度学习的自适应航拍目标检测方法。

背景技术:

1、无人驾驶飞机是利用无线电遥控设备、自动驾驶仪和程序控制装置操纵的不载人飞机。近年来,无人机技术逐渐走向成熟,因其具有体积小、造价低、使用方便、生存能力较强等优点在民用市场被广泛应用。

2、无人机对无人机所拍摄图像进行目标检测是无人机经常执行的任务之一。随着人工智能技术的飞速发展,无人机智能化的发展得到了突飞猛进的进步,研究人员们将深度学习网络应用于无人机航拍目标检测中。早些的研究人员将fast r-cnn和faster r-cnn用于无人机拍摄图像中的车辆检测,通过调整特征图的分辨率和锚定框的大小来提升目标检测的准确率。但是由于无人机所拍摄图片包含的尺度范围大,多种类型的目标经常出现在同一图片中,使得小目标在图片中占比极小,提供的分辨率有限,使无人机对小目标检测会产生漏报误报等情况,导致传统的卷积神经网络对小目标检测并不精准。因此基于深度学习对于无人机航拍小目标检测的准确率的研究成为当下无人机的热点研究问题。

3、近年来,国内外针对无人机对小目标检测准确率偏低的问题提出了一些算法进行改进。一些研究人员设计了一个特征金字塔网络(fpn),实现了语义信息丰富的顶层特征和细节偏多的底层特征的融合,使得小目标检测性能有所提升。又一些研究人员使用改进的inception模块来代替fpn中的横向连接来加强特征传播,也很好的提升了小目标的检测效果。虽然这些方法都可以提高小目标检测的准确率,但是这些方法却增加了计算成本。

4、随着深度学习网络的不断发展,相关研究人员提出了yolof网络,针对fpn可以将多个尺度的特征图融合以及依据目标的不同尺度在不同级别的特征图上检测目标的核心收益进行优化。其优点在于对编码器的结构进行了适当的设计,以提取不同尺度目标的多尺度上下文特征,弥补多尺度特征的不足;然后,采用均衡匹配机制来解决单特征图中稀疏关键点引起的正样本不平衡问题。该实验结果表明了yolof网络具有比fpn更强的高效性。

5、如专利申请202110925053.4公开了一种基于深度学习的列车侧部裙板丢失故障的检测方法,它属于列车侧部裙板丢失故障检测技术领域。本发明解决了传统故障识别算法的泛化能力差的问题。本发明在列车轨道周围搭建高清成像设备,当列车通过设备后即可获取高清图像;将车轴的位置作为参考,获得侧部转向架处小裙板所在区域图像和非转向架处的裙板所在区域图像,然后利用训练好的yolof网络结构对获得的侧部裙板所在区域图像进行丢失故障的检测,最后对裙板丢失的故障进行上传报警,工作人员根据识别结果进行相应的处理,保证列车安全运行。该专利申请利用yolof网络结构对区域图像进行丢失故障的检测,提出了一种应用实例。

6、然而,对于小目标的检测,目前尚未见yolof网络的应用报道。

技术实现思路

1、基于此,因此本发明的首要目地是提供一种基于多尺度深度学习的自适应航拍目标检测方法,该方法提高了特征提取的能力,增强了小目标的检测效果,有效的提高了航拍图像目标检测准确率,具有良好的泛化能力和适用范围。

2、本发明的另一个目地在于提供一种基于多尺度深度学习的自适应航拍目标检测方法,该方法提出了基于多尺度特征融合的目标预测网络方法,增强了网络提取特征的能力,使提取的特征更完整,可以获得更多小目标的信息;同时通过阶梯插值方法得到更加平滑的高分辨率特征图,增强了小目标的语义特征,有利于检测小目标。

3、为实现上述目的,本发明的技术方案为:

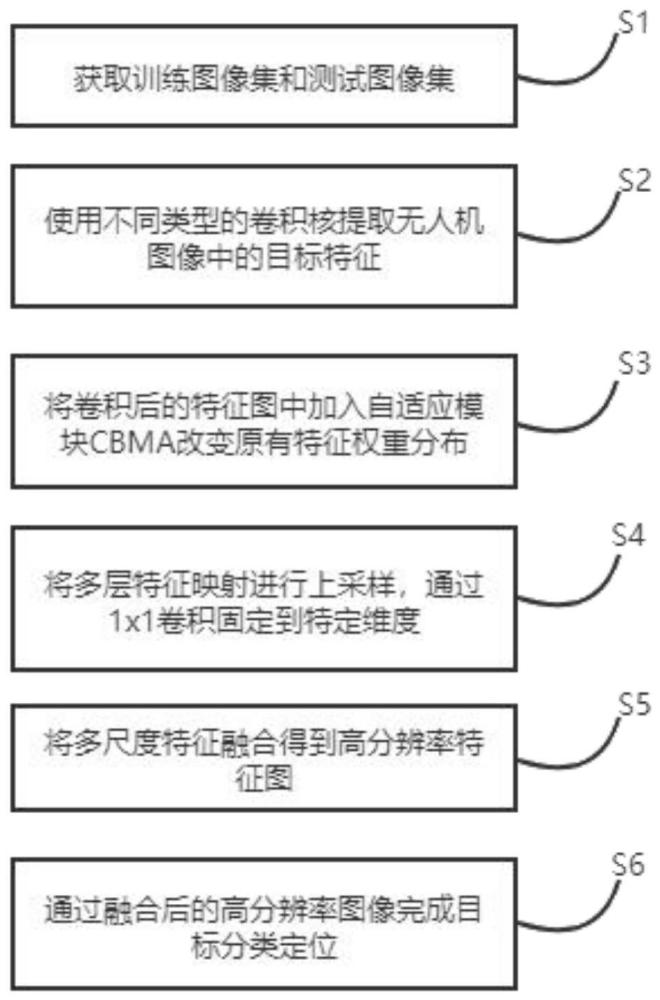

4、一种基于多尺度深度学习的自适应航拍目标检测方法,其特征在于包括以下步骤:

5、s1:获取训练图像集和测试图像集;

6、s2:使用多卷积提取无人机图像中的目标特征;

7、s3:将卷积后的特征图中加入自适应模块cbma改变原有特征权重分布;

8、s4:将多层特征映射进行上采样,通过1x1卷积固定到特定维度;

9、s5:将多尺度特征融合得到高分辨率特征图;

10、s6:通过融合后的高分辨率图像完成目标分类定位。

11、进一步,s1:获取训练图像集和测试图像集;

12、将图片进行旋转、拉伸、翻转操作,得到更全面的图像集。

13、s2:使用金字塔卷积提取无人机图像中的目标特征;

14、多尺度的卷积结构能在不增加计算复杂或参数量的前提下,针对输入特征图中不同目标的大小选择不同类型的卷积核进行特征提取,增强网络的特征提取能力,提取到更完整、更有效的特征信息。

15、假设输入特征图维度a×b×di,msconv的输入包含di个通道数,随着卷积核层级加深,卷积核尺寸不断减小,采用分组卷积方式,将每个尺寸卷积核通道数进行分组,使卷积核深度不断加深,msconv每一层的卷积核尺寸为其中n1<n2<......<nn,卷积核深度为di1,di2,......,din,在多尺度卷积过程中,卷积核尺寸随着深度渐加深逐渐减小,对应的输出特征维度为do1,do2,......,don。即经过多尺度卷积后的输出特征图维度为h×w×do。msconv参数量的计算公式:

16、

17、复杂度计算公式为:c=p×(h×w),其中do1+do2+......+don=do。

18、s3:将卷积后的特征图中加入自适应模块cbma改变原有特征权重分布;

19、cbma模块结合了空间注意力机制模块和通道机制注意力模块,分别在空间和通道两个维度,学习或提取特征中的权重分布,使网络能更多的关注感兴趣的目标区域,增强有效特征,抑制无效特征或噪声,尤其是对于小目标区域,能获取更多的小目标的细节信息。

20、具体分为以下3个小步骤:

21、s3.1:对输入特征f先进行全局平均池化和最大池化得到两个1×1×c的特征图,送入两层的神经网络,将得到的两个特征相加后经过sigmoid激活函数得到通道权重系数mc;

22、s3.2:在通道维度进行平均池化和最大池化得到两个h×w×1的特征图,按照通道维度拼接在一起,经过7×7卷积和sigmoid函数激活得到空间权重系数ms;

23、s3.3:将权重系数分别和原来的特征f相乘得到新特征映射,计算公式为:

24、

25、

26、其中f为输入特征,σ(·)表示激活函数,w1和w0分别表示层神经网络,两层网络参数共享,和分别表示在通道注意力阶段对输入特征进行平均池化和最大池化,f7*7表示7x7的卷积层,保证特征的完整性,和分别表示在空间注意力阶段对输入特征进行平均池化和最大池化。

27、s4:将多层特征映射进行上采样,通过1x1卷积固定到特定维度;

28、s5:将多尺度特征融合得到高分辨率特征图;

29、选取骨干网络yolof网络中多层级映射c1,c2,c3,c4,分别来自卷积模块conv_2,conv_3,conv_4,conv_5;

30、l1=conv(c1)

31、l2=μ1up(l1)+ω1c2

32、l3=μ2up(l3)+ω2c3

33、l4=μ3up(l4)+ω3c4

34、其中up()表示上采样函数,conv()表示1x1卷积操作,l1,l2,l3,l4分别表示经过上采样后特征映射,c1,c2,c3,c4分别表示不同卷积模块输出的特征映射。μ1,ω1,μ2,ω2,μ3,ω3分别表示各层权重系数,为了避免特征融合过程中的信息冗余,设置层融合权重系数之和为1,取值分别为0.7,0.3,0.6,0.4,0.4,0.6,因为浅层特征图中包含细节特征较多,相对权重占比较大,所以随着c4,c3,c2特征层级的加深,包含细节信息减少,权重ω1,ω2,ω3也相应减小。

35、s6:通过融合后的高分辨率图像完成目标分类定位。

36、目标检测的主要任务是准确输出图像中目标的类别及所在位置,因此需要进行位置回归和分类的训练,损失函数作为深度神经网络对误检样本评判的依据,同时为目标检测网络的训练提供优化方向,该算法的损失函数主要包含两部分:lf=lfc+lfl。其中分类损失函数lfc负责评估分类代价,定位损失函数lfl负责评估回归代价。

37、具体分为以下2个小步骤:

38、s6.1:生成定位损失函数,需要使生成的包围框中心尽量贴近目标中心。

39、1)设真实目标框为(ar,br,lr,wr),目标包围框的映射为(at,bt,lt,wt),其中a和b表示目标的中心坐标,l和w分别表示包围框的长和宽。

40、2)由于ciou损失充分考虑了目标与预测包围框的重叠面积、中心点距离以及包围框的宽高比等因素,使预测包围框和真实包围框的宽高比尽量保持一致。因此采用ciou计算方式:

41、

42、其中前两项为传统的iou loss,后两项为惩罚项,用于修正真实目标框与预测包围框的长宽比,ρ表示目标真实中心坐标与预测包围框中心坐标的欧氏距离,d为真实坐标框和预测包围框的对角线距离,γ用来衡量长宽比的相似性,θ为正权重系数。

43、s6.2:生成分类定位损失,需要预测每个目标的类别和置信度。

44、3)设(ar,br,λlr,σwr)和(at,bt,λlt,σwt)分别作为预测包围框中心区域和外围背景区域,中心区域为目标特征的集中区域,这部分特征具有很好的旋转不变性,有利于小目标特征的检测,其中λ和σ取值分别为0.2和0.5。以中心区域为正样本,背景区域为负样本。

45、4)采用focal loss进行分类分支进行训练。focal loss通过增加类别权重和样本难度权重调节因子来修改ce loss,目的是解决样本类别不平衡和样本分类难度不平衡等问题。其中focal loss函数计算公式为:

46、fl=-α(1-y’)γlogy’,y=1

47、fl=-(1-α)y’γlog(1-y’),y=0

48、其中,y为真实样本,y’为经过sigmoid的预测输出,α=0.25,γ=2。

49、本发明的有益效果如下:

50、本发明在检测小目标方面,提出了基于多尺度特征融合的目标预测网络方法,增强了网络提取特征的能力,使提取的特征更完整。然后加入了注意力模块,优化了特征在在空间和通道维度上的权重,增强了有效特征,抑制了无效特征,可以获得更多小目标的信息。最后通过阶梯插值方法得到更加平滑的高分辨率特征图,有利于不同层级特征图的融合,得到包含更多特征细节和语义信息的高分辨率特征图,增强了小目标的语义特征,有利于检测小目标。

51、实验表明本发明提高了特征提取的能力,增强了小目标的检测效果。有效的提高了航拍图像目标检测准确率,具有良好的泛化能力和适用范围。

- 还没有人留言评论。精彩留言会获得点赞!