融合CNN和深度学习变形器的目标检测方法

本发明属于计算机视觉,具体涉及一种融合cnn和深度学习变形器的目标检测方法。

背景技术:

1、由于大数据和人工智能的发展,计算机视觉技术得到了空前的提高和发展。目标检测广泛应用于安防、交通、监控和医疗领域,深度卷积神经网络(cnn)由于其强大的提取局部特征信息的能力而被应用到目标检测任务中,但是缺乏对于颜色、纹理、形状等全局信息的获取。深度学习变形器(transformer)由于其对于长短距信息的整合能力表现突出的能力,因而被广泛引用于自然语言处理,同样的,图像全局特征的信息也可以利用深度学习变形器进行提取。

2、孙剑等人于2016年收录于《计算机视觉和模式识别》文章超快速区域提案卷积神经网络(faster-rcnn),提出了区域候选网络(rpn),利用输入图形进行整体卷积形成的特征图再次进行卷积来生成候选区域,且rpn的卷积层与检测网络共享,这使得faster r-cnn的检测速度大为提升。虽然检测性能得到显著增强,但是由于仅仅依靠卷积神经网络,无法提取全局信息,对于全局信息的提取还是比较匮乏的。

3、alexey等人2020年收录于《计算机视觉和模式识别》文章应用于图像识别的深度学习变形器(vit),由于transformer中只能输入一维信息,很难输入图像等二维信息。vit利用patch(斑)的概念,将图像分成若干个小块信息,然后转置为一维度信息,从而输入transformer网络里,获得图像的长短距离信息。尽管vit得到了长短距离信息,获得了图像的全局信息,但是由于没有提取局部特征,因此很难全面反应图像的特征信息。另外,vit的参数量巨大,模型复杂,训练以及推理时间都很长。

4、因此,单独的cnn或者深度学习变形器(transformer)网络很难提取图像的全部特征,因此利用cnn和transformer的联合网络可以很好的获取图像的全局和局部信息,很大程度上整合图像的全部特征信息,从而为计算机视觉任务提供有用的信息支持。

5、深度网络的一个缺点是参数量过大,会导致训练和前向推理时间增加,cnn和深度学习变形器的结合会进一步增大网络的参数量,不利于硬件实现和实际部署。因此网络的压缩是一个必要的环节。不同的卷积层之间存在着参数依赖关系,可以通过利用参数之间的相关性减少参数冗余起到网络压缩的作用。

6、目标检测中的标签分布会很大程度上影响检测的准确精度,最优传输理论是一个全局优化方法,可以很好的解决供需者之间的关系。利用sinkhorn-knopp迭代可以优化求解此问题。

技术实现思路

1、本发明的目的在于提出一种高效、快速的结合cnn和深度学习变形器的目标检测方法。

2、本发明提出的结合cnn和深度学习变形器的目标检测方法,包括cnn和深度学习变形器组合模型构建、组合模型参数压缩、标签分配、损失函数设计四部分;具体为:

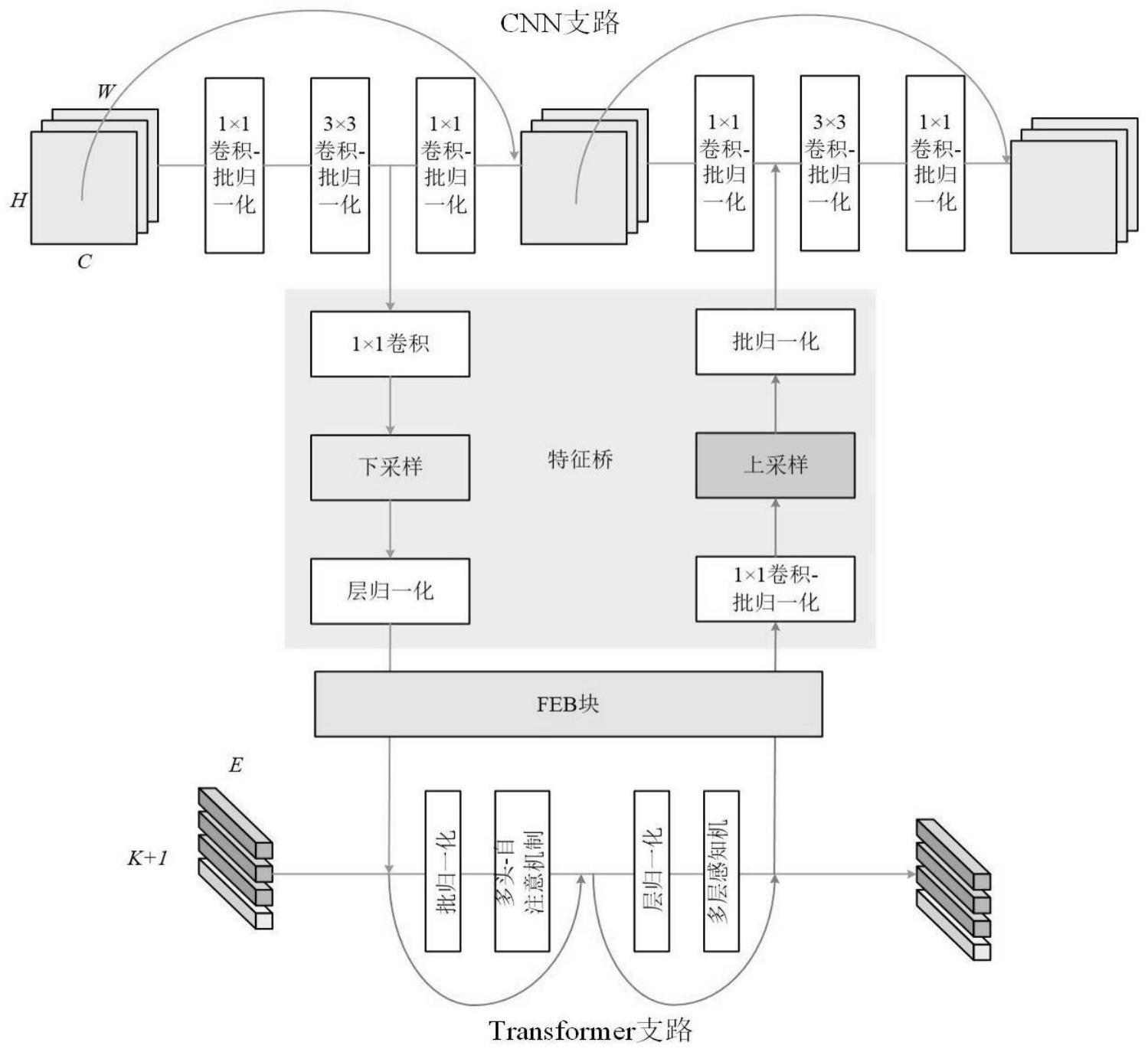

3、(1)cnn和深度学习变形器组合模型构建。如图1,组合模型主要包含cnn支路、深度学习变形器支路和特征桥三部分:

4、a.cnn支路:cnn支路主要包含6个卷积层,具体为1×1卷积、3×3卷积、1×1卷积、1×1卷积、3×3卷积、1×1卷积,这六个卷积层后都接有一个批归一化层。利用残差网络(resnet)结构进行特征提取,防止网络出现梯度消失或者梯度爆炸;

5、b.深度学习变形器支路:深度学习变形器支路包括批归一化、多头-自注意机制、层归一化和多层感知机四部分,同样的,类似于cnn支路,也采用残差网络结构进行特征提取;

6、c.特征桥:在cnn支路到深度学习变形器支路的信息流动中间,包含1×1卷积、下采样、层归一化操作;在深度学习变形器到cnn支路的信息流动中间,包含1×1卷积、批归一化操作。

7、(2)组合模型的参数压缩。就是通过设置共享子层,实现不同卷积层的参数共享。传统卷积神经网络是利用卷积核进行卷积操作。本发明把传统卷积核称为原卷积,为了减少参与卷积运算的卷积核数量,将卷积核进行分解,也就是变为卷积原子和共享子层,其中卷积原子和共享子层进行矩阵乘积可以得到原卷积。即通过共享子层的方法,减少实际参与卷积运算的参数量。设卷积核有k层,cin为输入通道数,cout为输出通道数,w、h为卷积核宽和高,原卷积核尺寸k×cin×cout×w×h。设计共享参数n,则利用矩阵乘积原理,现有网络减少k×n×w×h,其中共享参数越大,则减少的参数越多。如图2所示,s为不同卷积层的共享子层,a为卷积原子,c为原卷积。则现在进行卷积的是s,先由s进行卷积操作,然后卷积后乘积a得到卷积后的特征信息。由于s的参数量小于c的参数量,因此可以很大程度上减少参与卷积的参数量。

8、通过步骤(1)cnn和深度学习变形器组合模型构建,以及步骤(2)组合模型的参数压缩,可以得到模型的整体结构和参数。输入的图片经过模型可以得到特征信息。然后通过以下步骤(3)标签分配实现对于待检测目标的分类和位置回归。

9、(3)标签分配。将每个真值(gt)当作可以提供一定数量待检测信息标签的提供者si,而每个分配锚(anchor)可以看作是需要唯一待检测信息标签的提供者si,如果某个分配锚从gt那儿获得足够的测信息标签,那么这个分配锚就是此gt的一个正样本。设计提供者si到需求者di的传输方案:

10、p={p(i,j)|i=1,2,…,m;j=1,2,…,n}, (1)

11、则优化目标为:

12、

13、

14、tij≥0,i=1,2,…,m,j=1,2,…,n;

15、其中,m,n分别为分配锚中样本数量和真值样本数量。cij,tij分别为每个分配过程中分配者和需求者样本信息信息量。公式(1)代指从i到j的整体分配方案。公式(2)代表最小化代价函数,也就是从每一个分配者到需求者样本信息量的信息总和最小。公式(3)指代的是tij所代表的意义。利用sinkhorn-knopp迭代可以进行求解优化结果。由此可以得到目标检测过程中待检测目标的类别和回归位置。

16、(4)损失函数设计;

17、标签分配中的成本函数包含两部分,即正面标签和负面标签,对于正面标签,来自真值gti到检测锚aj代价是分类损失和回归损失之和:

18、

19、其中,lcls为分类损失,lreg为回归损失,为分配方案的分类信息,为分类信息的真值;为分配方案中的回归信息,为真实的回归信息,α为权重参数。

20、确定公式4中损失函数比例系数α的具体过程如下,首先,如图3,设置不同的α值共七组,分别取0.3,0.5,1,2,3。利用ms-coco数据集进行100个epoch的训练,得到收敛时损失函数值最小的一组,采用0.5作为最终的比值α。

21、则总的损失函数l包含四部分,cnn的分类损失ccls,cnn的回归损失creg,transformer的分类损失tcls,transformer的回归损失treg:

22、

23、其中,β为深度学习变形器和cnn损失函数的比例值。步骤(4)介绍模型训练过程中所需要的损失函数构成,仅在训练过程中使用,在确定好模型参数后不涉及损失函数。

24、确定公式(5)中损失函数比例系数β的具体过程如下,首先,如图4,设置不同的β值共七组,分别取0.25,0.33,0.5,1,2,3,4。利用ms-coco数据集进行12个epoch的训练,得到收敛时损失函数值最小的一组,采用3作为最终的比值β。

25、本发明将cnn和深度学习变形器结合,利用cnn来进行局部特征增强,利用深度学习变形器建立全局上下文模块来增强级联网络。其中,局部特征增强用于增加特征提取的范围,全局上下文建模用于捕获特征地图的全局信息。特征桥促进特征信息在cnn和深度学习变形器两支之间进行流动。但是由于cnn和深度学习变形器的融合会增加模型的参数量,提升模型的复杂度,不利于模型训练和正常的预测推理过程。为了降低模型复杂性,设计共享子层以实现相邻卷积层或交叉卷积层之间的权重参数共享,从而减少卷积权重参数的数量,这样可以减少模型的复杂度,从而提升目标检测的推理预测速度。但是模型的压缩会影响模型的表达能力,影响目标检测的准确性。为了在不增加网络参数的情况下有效提高神经网络的检测性能,提出了最优传输分配方法来解决标签分配问题,通过优化标签分布过程,提升目标检测的检测精度。通过这多方面协同作用,大大提升目标检测的效果和速度。

26、本发明设计的结合cnn和深度学习变形器的道路图像特征信息提取模型,可以结合整体和局部的特征信息,可得到模型的更好的表现能力。同时共享参数的设计可以减少由于cnn和深度学习变形器结合的参数冗余,从而对模型进行压缩,加快模型训练和前项预测的速度。提取特征的模型确定好后,为了进一步提升目标检测的精度,利用最优传输方案优化目标检测过程中的标签分布,提升目标检测分类和位置回归的准确性。利用公开数据集ms-coco进行测试,可以得到76.23%的平均精度值。

- 还没有人留言评论。精彩留言会获得点赞!