一种基于样本空间划分构建深度ReLU神经网络局部最优解的图像分类方法

本发明属于人工智能领域,更具体来说深度学习方向的一种基于样本空间划分构建深度relu神经网络局部最优解的图像分类方法。

背景技术:

1、近年来,人工智能在各行各业中均得到了广泛的应用,尤其是在图像分类领域,已经达到甚至超越了人类的平均水平,这很大程度上归功于深度学习技术的飞速发展。随着大数据时代的到来,针对于具体图像分类问题,人们可以收集大量的样本构成数据集。而深度学习技术就是通过构建不同形式的深度神经网络拟合数据集,实现对未知样本的精准预测。其本质就是通过添加非线性激活函数并对网络参数进行随机初始化,使得神经网络的输出为一个高维非线性函数,然后根据反向传播算法不断训练优化,最终使得网络输出的函数能够较好的拟合数据集中的样本点。此时对于同类型的新问题,就可以通过训练好的深度神经网络进行精准预测。

2、深度学习技术在图像分类领域的优势十分明显,其相比于传统人工智能技术,有着处理的问题更复杂、精度更高等优势,但是由于深度神经网络的参数量非常庞大,并且需要大量的数据进行训练优化,所以在网络训练的过程中,对于计算机的运算能力提出了很高的要求,耗时较长,有的深度模型的训练时间甚至会达到数月之久。为了解决深度学习的这一缺陷,人们提出了很多的解决思路,例如谷歌推出了计算神经网络专用芯片tpu,从硬件角度提升计算机的运算能力;有研究对梯度下降算法进行优化,使得深度学习模型能够更快的训练拟合;还有人对深度学习模型的剪枝方法进行研究,降低模型的复杂度,进而缩短模型的训练时间。这些方法对神经网络训练效率的提升有着较大的提升,但仍然需要耗费一定的计算资源以及时间,才能寻找到网络的局部最优解或全局最优解。因此,如何跳过神经网络的训练过程,在网络参数初始化时,就找到局部最优解甚至全局最优解,成为了一个值得深入思考的重要问题。

3、受上述问题的启发,本发明提出了一种基于样本空间划分构建深度relu神经网络局部最优解的图像分类方法。

技术实现思路

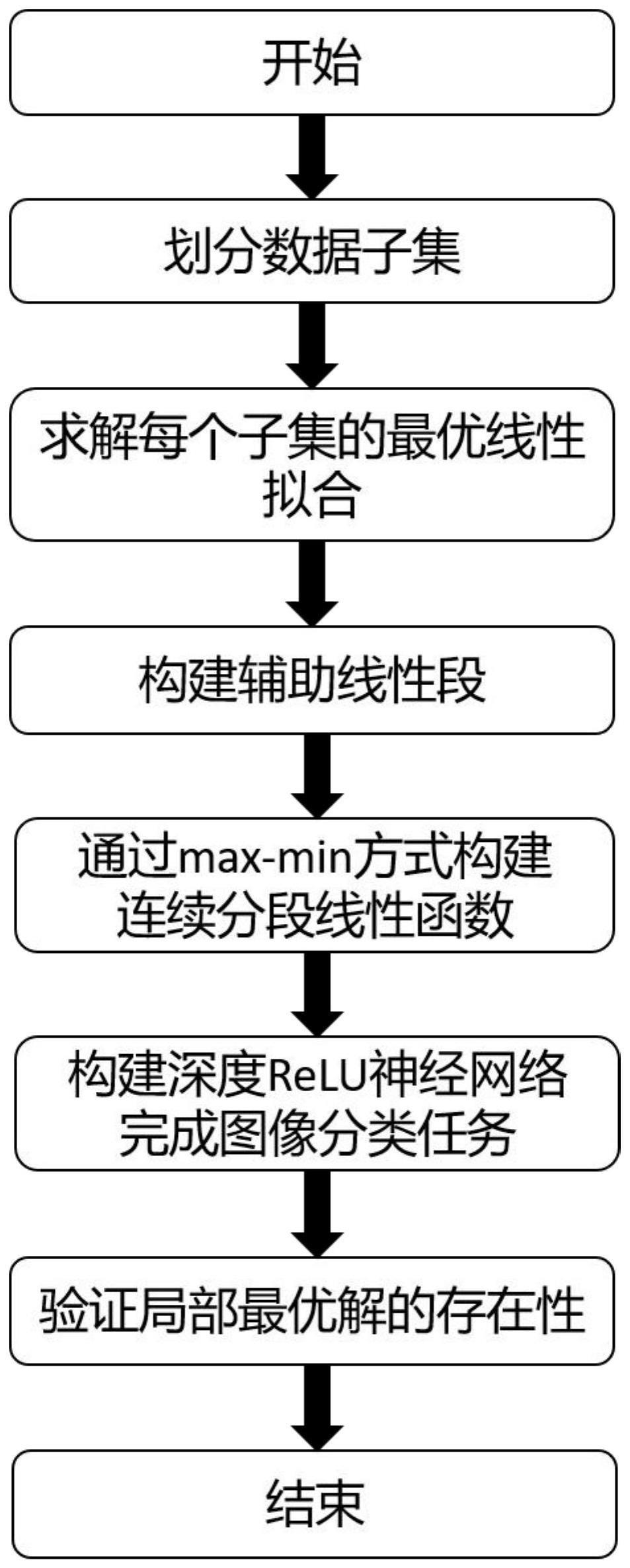

1、本发明要解决的问题是:深度学习模型收敛到局部最优需要经历模型训练的过程,通过梯度下降算法不断微调参数值,耗费大量的计算资源和时间。针对上述问题,本发明对深度relu神经网络展开研究,根据relu激活函数的性质,深度relu神经网络的输出为连续分段线性函数,相当于将数据集划分为了若干不相交的子集,每个子集均由对应的线性段进行拟合,而网络训练的过程就是各个线性段不断微调的过程。从这个思路进行逆向分析,如果将数据集人为划分为若干不相交子集,对每个子集进行最优线性拟合,然后将这些线性段构成连续分段线性函数,再构建深度relu网络,使得其输出为此函数。由于每个线性段都是当前子集的最优线性拟合,且对网络权值添加微扰不会改变子集的划分方式,因此这样构造出来的深度relu神经网络为局部极小值点。

2、本发明主要分为三个部分:

3、(1)将数据集划分为n(1<n≤m)个不相交子集,m为数据集中样本点的数量,并计算每个子集对应的最优线性拟合函数。

4、(2)将每个子集的最优拟合函数构建连续分段线性函数,并通过在两个子集之间的区域添加辅助线性段,保证构成连续分段线性函数后,每个线性段负责拟合的样本点区域不变。

5、(3)设计网络结构,构建深度relu神经网络,根据relu激活函数的性质,使得网络的输出为上述连续分段线性函数,完成图像分类任务。

6、本发明提出的方法具体技术方案共包括5个步骤:

7、1、图像数据集的预处理。如果数据集中的样本为图像特征,则其形式为一维向量,后续直接使用即可。如果样本为图像本身,则需对图像进行降维处理。以cifar10图像数据集为例,其中的每张图像均为彩色rgb图像,尺寸为32*32,共有十个分类。将图像的像素矩阵进行降维,拉伸为一维向量,分类标签保持不变,留待后续使用。

8、2、数据集子集的划分。根据图像数据集的分布情况,人为将图像数据集d划分为n个不相交的子集,即:其中di表示划分后的第i个子集,对应的样本区域为将子集的划分方式进行保存,留待后续使用。

9、3、对每个子集中的样本点进行最优线性拟合。确定损失函数,寻找线性超平面能够最优拟合子集中的所有样本点,即整体的损失最小。对于图像分类问题,则一般采用交叉熵损失函数,此时可以构建两层神经网络,网络只有输入层和输出层,不使用激活函数,输出层神经元的个数对应于最优线性超平面输出维度的数量,将网络参数随机初始化,通过梯度下降算法找到子集所对应的最优线性超平面。由于网络的参数量很少,所以运算速度非常快。将每个子集的最优线性超平面及其对应的子集范围进行保存。

10、4、将各个子集对应的最优线性片相连,构成连续分段线性函数,验证此时获得的连续分段线性函数是一个局部最优解。对于3中获得的各个子集对应的最优线性拟合函数{fj,j∈[1,n]},可以通过max-min方式获得其所对应的连续分段线性函数l*。即:

11、

12、其中,计算ψi时,fj需满足在子集di所对应的样本区域中,任一点处的值均大于等于ti,fi为子集di所对应的最优线性拟合函数。ki表示在中满足上述条件的线性函数fj的数量。ψi表示在中由所有满足条件的函数fj通过求解最小值所构成的连续分段线性函数。l*为最终的目标连续分段线性函数。

13、由于数据集中样本点为离散分布,所以在相邻子集之间,一定存在没有样本点的区域,称其为空白区域。当相邻线性片的交点不处于两子集间的空白区域时,会使得连续分段线性函数中线性段对应的样本点发生变化,继而改变数据集d的整体损失。为解决这一问题,本方法在空白区域构建辅助线性片,使其连接相邻子集的最优线性片。由于空白区域中没有样本点存在,所以辅助线性片不会对整体的经验损失造成影响,此时可以保证构成连续分段线性函数后,数据集d的整体损失与各个子集di中最优线性片计算的损失之和相等,即:

14、考虑对连续分段线性函数f的参数w添加任意方向微扰δw,当微扰足够小时,f(w+δw)中每个线性段fi(w+δw)仍负责之前所对应的样本区域由于fi(w)为数据子集di所对应的最优线性拟合,所以区域的经验风险ri(w+δw)>ri(w)。数据集d的整体经验风险由此可得:r(w+δw)>r(w)。说明当前所获得的连续线性分段函数f(w)是一个局部最优解。

15、5、确定神经网络结构及参数。根据relu激活函数的性质,可以将其嵌套使用,表示4中max-min形式的连续分段线性函数。通过relu激活函数求解两个常数最大值和最小值的公式如下所示:

16、max(a,b)=σ(σ(a)+σ(b-a)),a,b≥0

17、min(a,b)=σ(σ(b)-σ(b-a)),a,b≥0

18、其中,a,b为两个任意常数,满足a,b≥0,σ表示relu激活函数。

19、使用relu神经网络模块表示max和min函数时,网络架构一致,均为单隐层神经网络,输入层两个神经元,隐藏层两个神经元,输出层一个神经元,只是网络参数有一定的差别。

20、对于max函数,输入层的两个神经元分别表示两个常数a,b,隐藏层两个神经元对应的参数为(1,0),(-1,1),并对神经元进行relu激活,两个神经元的输出分别对应公式中的σ(a)和σ(b-a);输出层的神经元参数为(1,1),并对神经元进行relu激活,输出对应于公式中的σ(σ(a)+σ(b-a)),即此神经网络模块的输出为max(a,b)。

21、对于min函数,其输入层于max函数一致,隐藏层两个神经元对应的参数为(-1,1),(0,1),并对神经元进行relu激活,两个神经元的输出分别对应公式中的σ(b-a)和σ(b);输出层的神经元参数为(-1,1),并对神经元进行relu激活,输出对应于公式中的σ(σ(b)-σ(b-a)),即此神经网络模块的输出为min(a,b)。

22、求解两个函数f1,f2在某一具体区间所构成的连续分段线性函数max(f1,f2)或min(f1,f2)时,也可使用上述公式,但需在求解前对两个函数分别加上一个足够大的正数q,保证f1+q,f2+q在区间范围内的值均≥0。在计算完成后再对结果减去q,即可获得max(f1,f2)或min(f1,f2)。

23、具体来说,对于构建的深度relu神经网络,第一隐藏层的输出为连续分段线性函数f(w)中的各个线性段fi(w)。即第一隐藏层神经元的数量等于数据集d所划分子集di的个数(包括辅助线性段所在的空白区域个数),每个神经元的参数对应于di的最优线性拟合函数fi(w)。网络中其余隐藏层根据max(f1,f2)和min(f1,f2)的relu模块构建方式,将第一隐藏层中每个神经元输出的线性函数fi按照max-min形式构建为连续分段线性函数,最终网络的输出即为4中所构建出的连续分段线性函数f(w)。此时深度relu神经网络的参数对应于参数空间中的一个局部最优解。

24、有益效果

25、本发明提出了一种依据数据集划分,无需训练即可获得深度relu神经网络局部最优解的图像分类方法。该方法从连续分段线性函数的基本性质出发,不受数据集的约束,适用范围广。通过数学方法构建神经网络的局部最优解。很大程度上解决了神经网络通过梯度下降等方法迭代优化到局部最优解所造成的计算资源以及时间耗费等问题。

- 还没有人留言评论。精彩留言会获得点赞!