一种基于残差全连接神经网络的电阻抗成像方法

本发明涉及电阻抗断层成像,具体涉及一种基于残差全连接神经网络的电阻抗成像方法。

背景技术:

1、电阻抗断层成像技术(eit,electrical impedance tomography)是一种无创的成像技术。eit技术是通过向被测物体施加微小的激励电流,利用放置在其表面的电极测量其边界电压,将得到的电压信息经过重建算法得到被测物体的内部的电导率分布,进而重建出物体的电阻抗分布图像。与核磁共振成像(mri,magnetic resonance imaging)和计算机断层成像(ct,computed tomography)等成像技术相比,eit具有非侵入、低成本和无辐射等优势,在工业、化学以及生物医学等领域有着广阔的发展前景。

2、然而,由于eit逆问题固有的非线性和不适定性,测量数据的一点小变化(例如电噪声)可能会导致重建中的大变化,导致eit重建的图像质量差,该病态问题可以通过正则化解决,但是由于正则化平滑了电导率变化,影响了重构电导率,使得图像分辨率低。因此,提高图像重建质量仍然是一个具有挑战性的问题。

3、深度学习是人工智能领域近几年兴起的研究热点,被广泛应用于图像分割、分类和目标检测。神经网络在电阻抗图像重建算法的发展中起到了重要作用,神经网络是由神经元链接构成的,其输入输出之间存在复杂的非线性关系,只要有足够的数据,经过网络的训练和调优,神经网络就能建立数学模型,较准确地输出结果。

4、卷积神经网络(cnn)是目前应用最广泛的神经网络之一,已经在许多图像处理领域取得了卓越的成果,包括电阻抗图像重建问题。然而,cnn在电阻抗图像重建问题上仍然存在一些缺陷。cnn需要大量的训练数据才能发挥其优势,为了训练一个具有较好性能的cnn模型,需要大量的数据,这增加了计算成本和复杂度,且cnn模型在处理电阻抗图像时往往会忽略图像的边界信息。这是因为cnn模型使用卷积层进行特征提取时,会通过滑动窗口的方式将特征向量应用于整张图像,导致特征提取过程忽略了边界处的信息。而在电阻抗图像重建问题中,边界信息对于准确重建物体形状和大小至关重要。

5、虽然cnn在电阻抗图像重建问题上已经取得了显著的进展,但还是存在一些局限性。因此,现阶段还需研究更加先进和灵活的神经网络模型,以进一步提高电阻抗图像重建的准确性和稳定性。

技术实现思路

1、本发明的目的是为解决现有技术中存在的上述问题,提出了一种基于残差全连接神经网络的电阻抗成像方法。

2、本发明为解决上述技术问题采用以下技术方案:

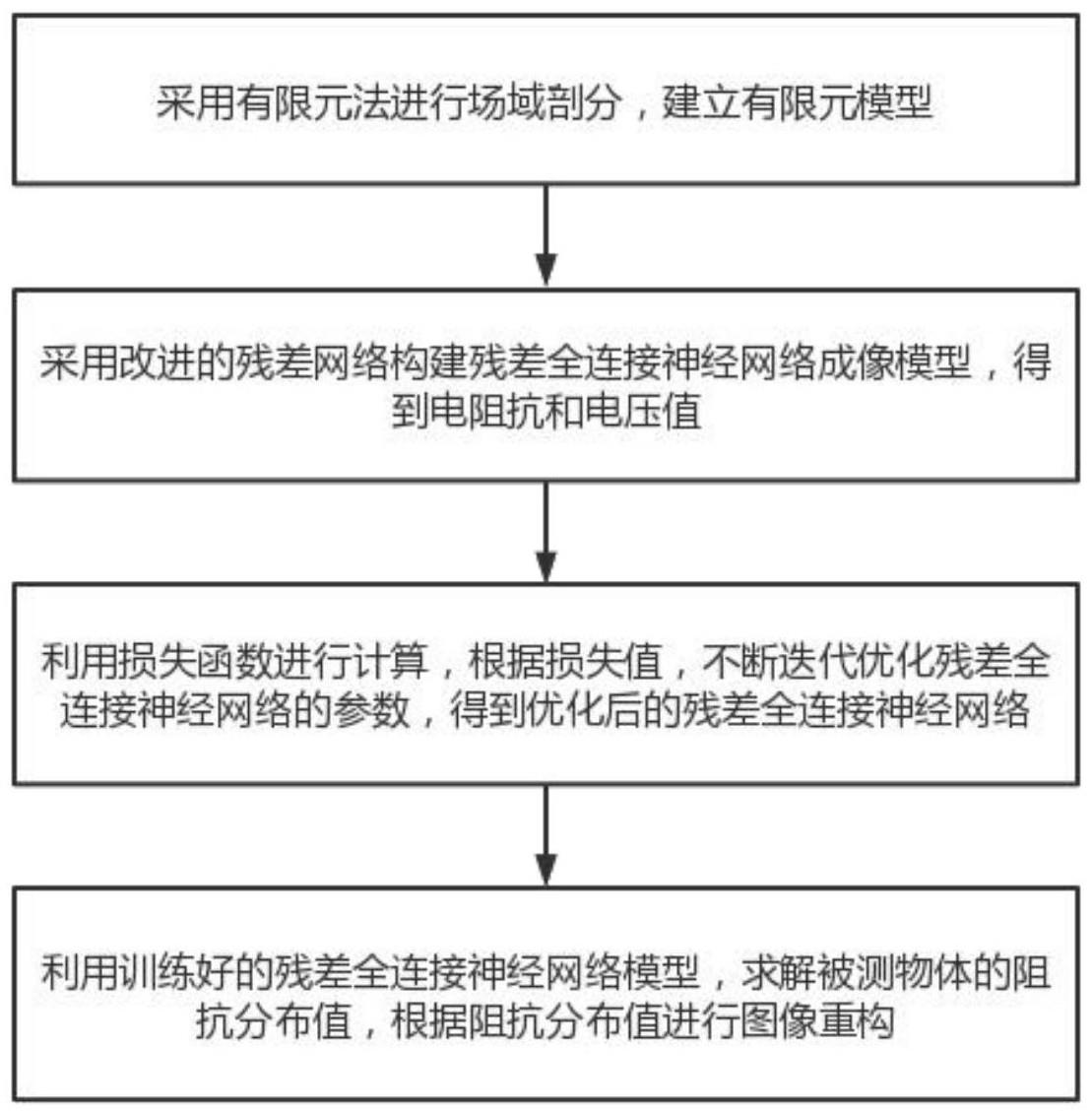

3、一种基于残差全连接神经网络的电阻抗成像方法,包括以下步骤:

4、s1:对场域采用三角形为剖分单元的有限元方法进行剖分,建立有限元模型;

5、s2:采用改进的残差网络构建残差全连接神经网络成像模型,得到电阻抗和电压值;

6、s3:将仿真数据和s2步骤得到的电阻抗和电压值输入到网络模型中,利用损失函数进行计算,根据损失值,不断迭代优化残差全连接神经网络的参数,得到优化后的残差全连接神经网络。

7、s4:利用训练好的残差全连接神经网络模型,求解被测物体的阻抗分布值,根据阻抗分布值进行图像重构。

8、优选地,所述步骤s1中,场域采用二维圆模型,将圆模型剖分成比较均匀的三角形网格,建立有限元模型,假定每个单元上的电导率是常数。在背景场域内随机位置指定个数的目标物体,设置目标物体的阻抗值,根据有限元模型数据和阻抗分布数据,使用有限元法计算出边界电压值,得到训练数据集。

9、优选地,所述s2步骤中所述残差全连接神经网络,包括:输入层、残差模块、输出层。

10、s2中所述残差全连接神经网络的输入层为电阻抗成像正问题采用有限元法计算出的边界电压值。

11、s2中所述残差全连接神经网络的残差模块为三层改进的残差网络。

12、优选地,所述改进的残差网络是在传统的残差网络中引入全连接层,用于替代卷积层。改进的残差网络由三个全连接层组成,其中第一个全连接层将输入数据进行升维,将输入映射到一个新的特征空间,第二个全连接层对特征空间中的每个元素进行非线性变换,对数据的特征进行提取和预测,第三个全连接层进行降维操作将变换后的特征映射回原始特征空间。通过使用残差连接技术,将输入数据与第三个全连接层的输出进行相加形成残差得到最终的特征表示。

13、s2中所述残差全连接神经网络的输出层为逆问题求解结果电阻抗分布。

14、优选地,所述s3步骤中所述损失函数为一范式和focal loss两个损失函数相结合,其中,一范式用于计算预测框的置信度得分,focal loss用于计算预测框的位置和类别得分。

15、残差全连接神经网络的损失函数的公式为:

16、

17、其中,pt是模型位置预测的概率,γ是控制难易样本权重的调节参数,f(σ)是预测值,v是真实值。

18、一范式损失函数是计算预测值与真实值之间的差值的绝对值,focal loss是当模型的预测概率pt越接近1时,对应的损失值会越小;当pt越接近0时,对应的损失值会越大,通过调整focal loss的权重,使得容易被错误分类的样本获得更大的损失值,从而使得网络更关注难分类的样本。

19、优选地,将一范式和focal loss相结合,可以兼顾值的准确性和位置的准确性。在训练过程中,根据损失函数的值来调整模型参数,从而不断迭代优化模型,直到损失函数收敛,得到优化的残差全连接神经网络。

20、优选地,在所述s4步骤中,输入待测物体的边界电压数据,通过训练好的神经网络计算求得被测物体的阻抗分布值,再根据输出的阻抗分布值获得阻抗成像图。

21、本发明的采用以上技术方案与现有技术相比,具有以下技术效果:

22、1.本发明采用基于残差全连接神经网络的方法进行电阻抗成像逆问题的图像重建,使用了多层全连接层来处理输入数据,不需要使用滑动窗口的方式进行目标检测,可以捕捉更多的特征,提高了模型的性能;使用残差连接技术,将输入数据与第三个全连接层的输出进行相加,形成残差,用于消除梯度消失和梯度爆炸等问题,提高了模型的鲁棒性和泛化能力。

23、2.用focal loss和一范式两种损失函数不断迭代优化各网络层参数,得到最优的深度学习网络模型。该损失函数通过一范式和focal loss两个损失函数相结合,可以有效地处理分类问题中的类别不平衡,同时考虑值和位置的重要性,改善模型的收敛速度和性能,从而提高模型的效果。

技术特征:

1.一种基于残差全连接神经网络的电阻抗成像方法,其特征在于:包括以下步骤:

2.根据权利要求1所述的一种基于残差全连接神经网络的电阻抗成像方法,其特征在于,s2步骤中所述残差全连接神经网络,包括:输入层、残差模块、输出层。

3.根据权利要求2所述的一种基于残差全连接神经网络的电阻抗成像方法,其特征在于,所述残差模块包含三层改进的残差网络,改进的残差网络是在传统的残差网络中引入全连接层,用于替代卷积层。改进的残差网络由三个全连接层组成,其中第一个全连接层将输入数据进行升维,将输入映射到一个新的特征空间,第二个全连接层对特征空间中的每个元素进行非线性变换,对数据的特征进行提取和预测,第三个全连接层进行降维操作将变换后的特征映射回原始特征空间。使用残差连接技术,将输入数据与第三个全连接层的输出进行相加,形成残差,用于消除梯度消失和梯度爆炸等问题。

4.根据权利要求1所述的一种基于残差全连接神经网络的电阻抗成像方法,其特征在于,s3步骤中所述损失函数为一范式和focal loss两个损失函数相结合,其中,一范式用于计算预测框的置信度得分,focal loss用于计算预测框的位置和类别得分。

技术总结

本发明公开了一种基于残差全连接神经网络的电阻抗成像方法,该方法包括一下步骤:S1:对场域采用三角形为剖分单元的有限元方法进行剖分,建立有限元模型;S2:采用改进的残差网络构建残差全连接神经网络成像模型,得到电阻抗和电压值;S3:将仿真数据和S2步骤得到的电阻抗和电压值输入到网络模型中,利用损失函数进行计算,根据损失值,不断迭代优化残差全连接神经网络的参数,得到优化后的残差全连接神经网络。S4:利用训练好的残差全连接神经网络模型,求解待测物体的阻抗分布值,根据阻抗分布值进行图像重构。本发明使用残差全连接神经网络以及一范式和FocalLoss相结合的损失函数,相比较于传统成像方法,经过训练的神经网络精度高,鲁棒性强,能够有效提升电阻抗成像的精确度。

技术研发人员:汪杰君,林泽姿,许川佩,张宇涛,李腾飞

受保护的技术使用者:桂林电子科技大学

技术研发日:

技术公布日:2024/1/13

- 还没有人留言评论。精彩留言会获得点赞!