基于视频内容细粒度信息的视频时刻检索方法

本发明属于网络检索,具体涉及基于视频内容细粒度信息的视频时刻检索方法。

背景技术:

1、近些年来,文本、图像和视频等多模态数据迅速增长。用户难以有效地搜索感兴趣的信息,同时也衍生了各种各样的搜索技术。传统的搜索技术主要是单一模态内检索,例如基于关键字的检索,主要是执行单一模态内容的相似性搜索。而随着互联网技术的发展和智能手机的普及,用户对于跨模态数据检索的要求越来越高。而跨模态视频检索技术便是其中的一项关键技术,通过给定自然语言描述的查询语句,在完整的视频中确定最符合描述语句的时间片段的起止时间。跨模态视频检索除了要挖掘视频中包含的丰富的视觉、文本和语音信息,还需要确定不同模态之间的内容相似性。现阶段的跨模态视频检索技术主要可以分为两大类:基于排序的方法和基于定位的方法。

2、基于排序的方法的核心在于对候选片段进行排序.特点是实施简单,易于解释和理解。进一步根据产生候选片段的过程可以分为预设候选片段的方法和有指导地生成候选片段的方法。前者是在无查询语句信息的情况下,手工切分视频生成候选片段,然后按照与查询语句的相关程度对它们进行排序。后者则以查询语句或视频本身为指导,首先利用模型排除掉大多数无关的候选片段,然后再对生成的候选片段排序。有指导地生成候选片段的方法大多使用了弱监督学习或强化学习。基于定位的这类方法不以候选视频片段为处理单位,而是以整个视频为处理单位,直接以片段时间点作为预测目标。由于该任务的特别性和复杂性,目前的跨模态视频时刻检索技术仍有很大的不足,返回的结果往往不太准确,精度仍然不能让用户满意。

3、申请公布号为cn202011575231,名称为“基于跨模态动态卷积网络的跨模态视频时刻检索方法”的专利申请,公开了一种基于跨模态动态卷积网络的跨模态视频时刻检索方法,该方法先构建基于注意力机制的层级视频特征提取模块和文本特征提取模块的网络结构,分别提取视频和文本的特征,然后采用跨模态融合机制对两种模态的特征进行融合,最后使用基于跨模态卷积神经网络的时刻定位模块完成时刻检索。该方法使用融合特征和文本特征来动态地生成卷积核,并使用基于跨模态卷积神经网络的时刻定位模块完成时刻检索。但该方法的不足之处在于没有充分提取视频和文本中的细粒度信息,同时无法将视频和文本中的细粒度信息匹配。从而导致检索的准确率和速度下降。

4、在人工进行视频时刻检索时,人们最直观确定视频内容的方法往往是对视频内物体进行分辨,同时对应上查询语句内的物体,再辨别视频中相关的动作是否与查询语句相关联,便可以大致确定查询时刻位置。这就说明查询数据中的细粒度信息,比如视频中存在哪些物体和语句描述中有哪些物体,对视频时刻检索会起到关键的作用。然而现有的很多视频时刻检索方法在处理细粒度内容时存在缺陷,往往没有很好地利用文本信息来帮助识别视频中的物体和动作。对于一个视频的描述语句,其中可能包含着一些关键词,这些关键词能够帮助确定视频中的物体和动作以及细粒度的信息,缺乏对这些信息的利用会导致视频时刻检索模型不能更好地分辨视频内容中的信息。

技术实现思路

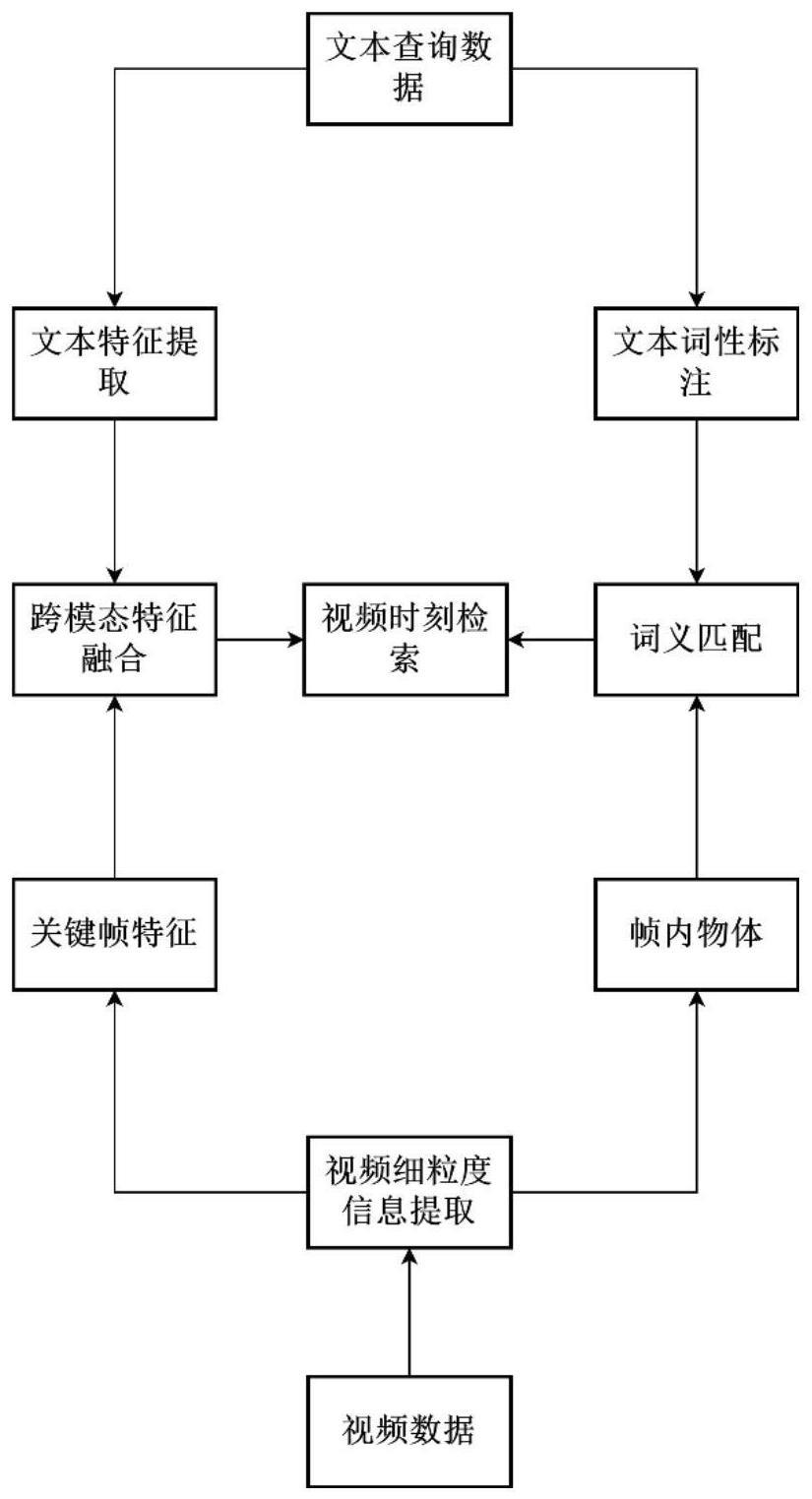

1、为了克服以上现有技术存在的问题,本发明的目的在于提供基于视频内容细粒度信息的视频时刻检索方法,通过目标检测网络提取视频中的细粒度信息,构建一个跨模态的检索模型,能够提高视频时刻检索准确性。

2、为了实现上述目的,本发明采用的技术方案是:

3、基于视频内容细粒度信息的视频时刻检索方法,包括以下步骤;

4、步骤1,选取charades-sta数据集构建训练集和测试集,并选取原始视频v;

5、步骤2,构建视频细粒度信息提取模块,使用yolov5目标检测网络对原始视频v进行特征预提取,得到原始视频v的关键帧特征fc和帧内物体oc;

6、步骤3,构建文本特征提取模块,使用预训练词嵌入模型来将查询语句s映射到嵌入空间中,完成特征提取,并得到文本特征q:

7、步骤4,构建文本词性标注模块,标注查询语句s中的名词h;

8、步骤5,构建跨模态特征融合模块,将步骤2中的视频关键帧fc特征和步骤3中的文本特征q进行融合,得到跨模态细粒度内容特征fa;

9、步骤6,构建词义匹配模块,通过步骤2中的帧内物体oc和步骤4中查询语句中提取的名词h,通过词义匹配生成相关性权重y;

10、步骤7,通过跨模态内容细粒度特征fa和相关性权重y构建时刻检索指导模块计算整个视频对应的相关性内容细粒度特征fa。

11、所述步骤1中,charades-sta数据集是基于charades数据集进行时间标注构建的,charades数据集包括动作种类,视频和“查询,视频片段”对;在部分视频中,需要做结构化的复杂查询,即每个查询包含至少两个子句,并且“查询,视频片段”对时间跨度小于视频长度的一半。

12、所述步骤2具体为:

13、步骤2.1,对原始视频按照间隔τ帧进行等间隔采样,视频的总帧数为t,取出的关键帧图片为其中nc为取出的总帧数;

14、步骤2.2,使用yolov5目标检测网络提取关键帧特征fc和帧内物体oc。

15、进一步的,步骤2.2.1,将关键帧图片c送入yolov5目标检测网络,主干网络采用cspnet,通过将卷积分为两个阶段,并利用跨阶段的特征复用和信息融合减少模型的参数量和计算复杂度,提高了模型的速度和精度;通过主干网络得到19×19大小的特征图m1;

16、步骤2.2.2,将特征图m1送入自顶向下特征金字塔结构,提取强语义特征,通过上采样输出特征图m2;

17、步骤2.2.3,将特征图m2通过自底向上的特征金字塔结构,提取强定位特征,输出特征图m3;

18、步骤2.2.4,将特征图m3作为三层卷积块的检测头,通过对三个不同尺度的特征进行操作来进行目标检测任务;网络输出帧内包含的帧内物体g为帧内物体的数量,同时在空间金字塔池化的输出得到多尺度关键帧特征f1c,f2c,和f3c。

19、所述步骤3具体为:

20、步骤3.1,使用glove预训练词嵌入模型将查询语句s映射到嵌入空间中,完成文本特征q提取,文本特征q提取的过程表示如下:

21、

22、其中,m为句子中的单词数量,dq为提取出文本特征的维度,q为文本特征,s为具体的查询语句,q为具体的文本特征。

23、所述步骤4具体为:

24、步骤4.1,使用nltk将查询语句s分割为单独的单词;

25、步骤4.2,利用nltk构建隐马尔可夫模型,通过词形还原,词汇消歧,对每个单词词性进行标注,提取出查询语句中的名词h={h1,...,hu}作为与视频内容进行匹配的关键字,其中u为该语句中名词的数量。

26、所述步骤5具体为:

27、在步骤2中yolov5模型输出的三个内容特征f1c,f2c,和f3c的大小分别为80×80×256、40×40×512和20×20×1024,文本特征q的大小为m×dq,m为查询语句中单词数量,dq为文本特征维度;

28、步骤5.1,将文本特征q在第一个维度进行填充对齐,将q的大小转变为m'×dq,其中m'>m;

29、步骤5.2,对文本特征q增加维度,并在第二维进行复制扩张,将文本特征q的大小转化为m'×m'×dq的文本特征该过程可用如下公式表示:

30、

31、步骤5.3,将多尺度关键帧特征f1c,使用池化层将内容特征的大小转化为的特征该过程公式如下所示:

32、

33、步骤5.4,对扩张后的文本特征分别使用三个输入大小为dq,输出大小为的全连接层进行维度变换,将文本特征q变成了三个大小为的特征qi′;

34、

35、其中,fc()为全连接层操作;

36、步骤5.5,将内容特征和文本特征利用哈达玛积进行融合;

37、

38、步骤5.6,对三个融合特征进行拼接,对拼接后的特征在通过全连接层进行特征提取和维度变换,进一步提升特征的表达能力,使得特征更具有区分度,最后得到长度为dv的一个跨模态细粒度内容特征fa,dv为时刻检索网络中融合向量对应的维度,以上过程公式如下表示:

39、

40、其中,fc()为全连接层操作。

41、所述步骤6具体为:

42、步骤6.1,计算词向量两两之间的余弦相似度;

43、

44、其中w1w2为任意两个词向量,similarity(w1,w2)为相似度。

45、步骤6.2,对于帧内物体词组和语句中的名词其中g为帧内物体的数量,u为语句中名词的数量,通过计算平均相似度来计算两组词语键的相关性权重y,具体的计算公式如下:

46、

47、所述步骤7具体为:

48、步骤7.1,将步骤5中计算得到的跨模态内容细粒度特征fa和相关性权重y相乘,得到当前第i帧的用于指导时刻检索网络的相关性内容细粒度特征

49、

50、其中nc为视频中关键帧的数量。

51、步骤7.2,将视频中所有关键帧的相关性内容细粒度特征进行拼接,得到整个视频对应的相关性内容细粒度特征fa:

52、

53、其中nc为视频中关键帧的数量;

54、步骤7.3,将内容细粒度特征fa通过双向门控循环单元,得到时刻定位的起始位置tbegin和时刻定位的结束位置tend。

55、一种电子设备,包括处理器、存储器和通信总线,其中,处理器、存储器通过通信总线完成相互间的通信;

56、存储器,用于存放计算机程序;

57、处理器,用于执行存储器上所存放的程序时,实现上述所述的基于视频内容细粒度信息的视频时刻检索方法。

58、本发明的有益效果:

59、本发明充分提取视频中的细粒度特征,并通过词性标注,将关键帧与查询语句进行跨模态匹配。构建了基于视频内容细粒度信息的视频时刻检索模型。利用目标检测网络提取视频的细粒度特征,以及利用查询语句词性标注与视频关键帧物体的跨模态信息匹配方法。

60、本发明了提取视频中的细粒度信息,并通过关键帧匹配,相似度计算,降低了检索时长,实现了更高的视频时刻检索精度。

61、且本模型的可移植形强,通过和现有的基于无锚框方法的模型进行融合,可以显著提高模型的检测精度。

- 还没有人留言评论。精彩留言会获得点赞!