一种基于视觉感知的移动目标检测方法

本发明涉及目标检测技术,具体是一种基于视觉感知的移动目标检测方法。

背景技术:

1、在传统的车道和内河监控系统中,一般都需要专门的工作人员根据固定摄像头所传输的视频图像进行主观判断,在发生险情事故发生后才会告知相关部门去处理。这样不仅加大人工成本,为第一时间抢险救援或打击犯罪留下时间也十分紧张。车道和内河航道监控环境和目标十分复杂,首先车道和内河环境背景复杂使得检测算法针对目标难以在低可视环境(雾天、夜晚)、背景杂乱下表征以及适应导致检查精确率不高,然后在车道中行驶的车辆和内河航道中航行的船舶大小尺寸不一,这对于目标检测网络对多尺度车辆或船舶特征提取带来了不小的挑战。

2、对于车道中的车辆和内河附近的船舶而言,低可视环境下全局特征提取困难,如何从全局视角对全局上下文建模,捕获长距离依赖关系是提升车辆和船舶目标检测精度的关键。还有车道和内河航道目标检测中有楼房、树木等背景信息干扰严重。若要提升检测精度,此时更需要保留丰富的语义信息、减少局部信息的丢失以及获得更大的感受野才能更好的定位检测车辆或船舶目标。另外车道和内河监控图像中目标普遍大小不一。如何改善多尺度融合方式和提升模型检测能力是避免检测过程中漏检误检,是提升目标检测精度的关键。

3、由于低可视环境下(雾天、夜晚)以及内陆地区强散射的干扰。在低可视环境下车辆或船舶目标检测领域中,因为在卷积神经网络中卷积只能在局部区域进行上下文建模,使得感受野受限,如果网络提取特征的方式若只有简单的卷积堆砌,这种情况类似于一直重复某类函数,会导致网络提取特征语义信息的缺失,不利于低可视环境下车辆或船舶目标特征提取。

4、在yolov5的backbone层,输入图片经过多次卷积运算之后,进入sppf模块后使用相同大小的最大池化层获取不同感受野特征,实现全局特征与局部特征的融合。但卷积操作提取特征再进行池化下采样的操作会导致局部信息的丢失,并且卷积操作提取复杂背景图像特征的能力有限,进而特征提取和特征融合能力下降导致检测精度不佳。

5、在卷积神经网络中,浅层网络可有效对细节信息进行表征,可以捕捉更多小尺度车辆或船舶信息,然而无法达到较强的特征语义信息表征能力。而深层网络的细节信息表征能力不佳,却对于特征语义信息的表征能力较强,可以捕获更多中、大尺度车辆或船舶信息。因此将深、浅网络多尺度特征信息进行融合,集成浅层以及深层网络的优势,从而可以提升车辆或船舶目标检测中目标定位以及分类的精度。yolov5 中的neck结构是由fpn和在此基础上增加了一条自底向上的路径pan构成了的panet结构。panet结构在特征图处理方面利用了语义以及细节特征信息,从而实现车辆或船舶多尺度特征融合。然而这种方式依然有一定的不足,主要是pan的输入信息全部是由fpn处理过的,难以采用主干网络得到的原始信息参与融合,在目标检测中随着卷积网络深度增大的同时,小尺度车辆或船舶语义信息更难保留,这会导致网络学习受限,在一定程度上影响到了检测结果的精度。

6、yolov5网络的层次较深,在不断执行卷积下采样过程之后可以通过输入图像中提取得到抽象的语义特征,然而也降低了特征图的尺寸,这对于小尺寸车辆或船舶可能带来的影响是特征信息的丢失,无法保留足够多的特征信息。结合上述分析可知,在小目标预测时采用深层特征难以满足要求。从yolov5结构上来看,yolov5的检测头有3个,依次在20×20、40×40、80×80的特征图中进行目标检测。由于我国车道和内河航道情况复杂导致检测到的图片中车辆或船舶大小不一,若一个车辆或船舶在图像中的像素尺寸占8个像素,根据输入图像的尺寸为640像素,即使在尺度最大80×80的特征图中,目标物所占据的尺度也仅有1像素;而如果目标物尺度小于8像素,则整个目标都会在特征图中消失,那么之前80×80尺寸检测层可能无法完成对图像中更小车辆或船舶的精准检测。

技术实现思路

1、本发明的目的是针对现有技术中存在的不足,而提出一种基于视觉感知的移动目标检测方法。这种方法检测精度高,在可视化图片或视频的车辆或船舶目标检测中能减少漏检误检。

2、实现本发明目的的技术方案是:

3、一种基于视觉感知的移动目标检测方法,包括如下步骤:

4、s1在特征提取层将gc模块替换为c3模块;

5、s2构建ac-sppf模块;

6、s3特征融合网络panet替换为bifpn结构;

7、s4增加四尺度检测头,检测目标。

8、所述步骤s1中在特征提取层将gc模块替换为c3模块的具体步骤为:

9、s1-1图像通过预处理后进入特征提取层bcakbone;

10、s1-2将gc模块直接替换为c3模块;

11、s1-3使用gc模块把特征提取层backbone的特征图从浅层到深层提取特征;

12、s1-4每个gc模块输出连接在特征融合neck层。

13、所述步骤s2中构建ac-sppf模块的具体步骤为:

14、s2-1经过层层卷积将特征送入sppf模块,进行特征提取和信息融合;

15、s2-2 sppf模块融合acmix模块,采用构建残差结构方式构建ac-sppf模块;

16、s2-3 输入特征图经过卷积操作后,再经过acmix加强信息聚合,以削弱复杂背景信息的干扰;

17、s2-4 然后将步骤s2-3的特征图经过卷积核大小为1×1的cbs卷积,降低通道数,然后通过3个最大池化层获取不同感受野特征,实现全局特征与局部特征的融合;

18、s2-5 再经过卷积核大小为1×1的cbs卷积模块对通道进行调整,恢复到原特征的通道数,最后通过残差结构与原始特征图相加融合,保留原特征中丰富的局部信息,然后输出特征。

19、所述步骤s3中特征融合网络panet替换为bifpn结构的具体步骤为:

20、s3-1 首先将原特征融合网络panet替换为加权双向特征金字塔网络bifpn;

21、s3-2 将步骤s2-5的特征送入bifpn结构特征融合层;

22、s3-3 此时主干网络的原始信息通过两个跳跃连接和两个跨尺度连接参与融合;

23、s3-4 通过bfconcat 层设置可学习权重参数,实现深浅层特征双向融合,增强局部感知以及网络层之间的特征传递能力,以确定各个尺度特征对于输出特征所产生的影响;

24、s3-5 将融合好的特征送入检测层。

25、所述步骤s4中增加四尺度检测头的具体步骤为:

26、s4-1 在backbone层增加一次4倍下采样;

27、s4-2 原有neck层上增加一次上采样和一次下采样;

28、s4-3 将backbone层的第一个c3输出特征图与neck层中的3次上采样进入 concat层融合,然后得到检测尺度为160×160的检测头;

29、s4-4 在检测头使用更高分辨率160×160的检测特征图后,车辆或船舶占据的像素会增加,更易被检测出来。

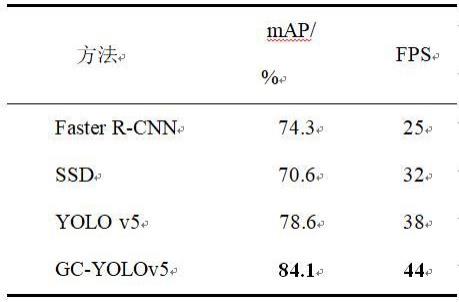

30、本技术方案方法在改进后的yolov5在backbone层gc模块替换c3模块加强从全局视角对图像特征提取,ac-sppf模型的构建加强信息聚合减少局部信息丢失。在neck层采用bifpn结构采用了跨尺度特征融合实现了多尺度信息融合,使得模型融合更多的信息。另外还增加了跨连接操作,有效缓解了主干网络得到的原始信息难以参与融合的问题。通过bfconcat 层设置可学习权重参数,实现深浅层特征双向融合,增强了局部感知以及网络层之间的特征传递能力,从而可以确定各个尺度特征对于输出特征所产生的影响。在检测头部增加大尺寸检测头提升了车辆或船舶目标检测能力。

31、改进后的yolov5方法在低可视环境下(雨雾天、夜晚)和复杂背景下车辆或船舶目标检测精度相比原yolov5方法有效提高,降低在上述环境下的车辆或船舶误检、漏检概率,提高方法在多场景目标检测的泛化能力。

- 还没有人留言评论。精彩留言会获得点赞!