基于视角选择和多特征融合的光场显著性目标检测方法

本发明属于计算机视觉、图像处理和分析领域,具体说是一种基于视角选择和多特征融合的光场显著性目标检测方法。

背景技术:

1、视觉显著性是人类视觉系统的一种注意力机制,当我们在观察一个场景时,场景中往往会有一个显著的区域能够吸引我们的注意力,与此同时,我们会自然的忽略那些非显著的区域,这样我们人类就可以在短时间内处理大量的图像信息。显著性目标检测(salient object detection,sod)旨在快速、有效地提取场景中最引人瞩目的物体或区域。准确的显著性目标检测结果可以为相关的计算机视觉任务提供重要的先验信息,例如图像分割、视觉追踪、自动驾驶和视频压缩。

2、以输入数据的类型进行划分,现有的显著性目标检测任务主要分为三类:(1)基于rgb图像的显著性目标检测;(2)基于rgb-d图像的显著性目标检测:(3)基于光场的显著性目标检测。基于rgb图像的传统方法通常根据图像的颜色、形状、背景和纹理等低层特征来获取显著图,此类方法在简单的场景中能够取得较理想的效果,然而对于一些具有挑战性的场景(例如目标与背景相似,低对比度,背景复杂和遮挡场景等),检测结果较差;基于深度学习的方法虽然可以进一步获取图像的高级特征,但是rgb图像本身缺乏深度信息的特点限制了其进一步的发展。基于rgb-d图像的方法同时输入rgb图和深度图,准确的深度图可以为显著性目标检测任务提供明确的场景深度和结构信息,但此类方法对深度图质量要求较高,受限于深度摄像机所获得的深度图的质量,基于rgb-d图像的方法也难以获得理想的效果。光场能够记录来自同一场景不同方向的光线,可以同时提供光线的强度信息和多角度几何信息,为获得高质量的显著图提供了更多的信息支撑。

3、目前,基于光场的显著性目标检测方法大致分为两类,即基于特征的方法和基于学习的方法。基于特征的方法是在光场焦点堆栈图像和全焦距图像的基础上,利用色彩,深度,背景先验等信息来估计显著图。这类方法由于只考虑了几种有限的特征,因此检测精度往往不高。基于学习的方法通过一定量的训练样本来训练一个显著性目标检测的模型。基于学习的方法依赖于深度神经网路强大的学习能力,融合了多种特征,因此相较于基于特征的方法,检测精度得到很大提升。但是这些基于学习的方法仍存在不足之处:

4、1、大部分基于焦点堆栈的方法仅融合了焦点切片和全聚焦图像的特征,没有对不同聚焦区域之间的关系进行挖掘,致使丰富的光场信息无法得到充分的利用;

5、2、对于基于焦点堆栈的方法,不同焦点切片内的局部模糊不利于此类方法得到具有尖锐边缘的显著图,且当场景深度范围较窄时,此类方法很难得到理想的效果;

6、3、对于基于多视角图像的方法如果直接将全部的视角图像作为输入,则会导致大量的数据冗余和极大的计算开销;如果仅选择一部分连续的视角图像作为输入,则难以使视差信息得到最大化的利用。

技术实现思路

1、本发明为解决现有技术中的不足之处,提供了一种基于视角选择和多特征融合的光场显著性目标检测方法,以期能够在多目标、复杂背景等富有挑战性的场景中实现高精度的显著性目标检测,从而为相关的计算机视觉任务提供重要的先验信息。

2、为解决上述技术问题,本发明采用的技术方案是:

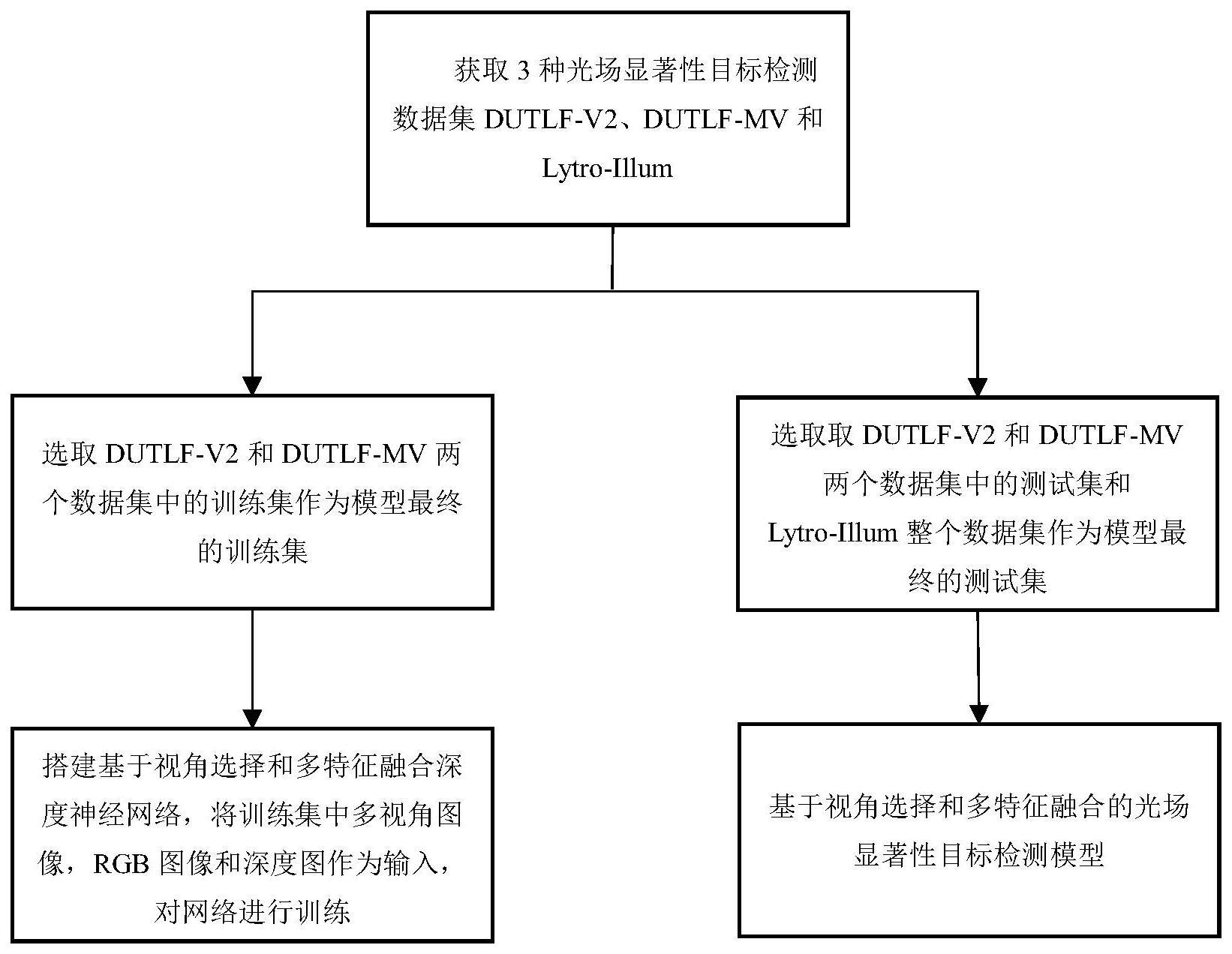

3、本发明一种基于视角选择和多特征融合的光场显著性目标检测方法的特点在于,是按照如下步骤进行:

4、步骤1、获取光场显著性目标检测数据集ω={r,m,z};其中,r表示rgb图像集合,m表示以所述rgb图像集合r中每张图像为中心图像的多视角图像集合,z表示所述rgb图像集合r中每张图像所对应的深度图像集合;令rgb图像集合中的任一第m张图像记为rm,则以图像rm为中心图像的多视角图像记为{viewm,1,viewm,2,...,viewn,...,viewm,n},其中,viewm,n表示以图像rm为中心图像的第n个视角图像;n表示多视角图像的数量;图像rm所对应的深度图像记为zm;

5、步骤2、多视角图像选择;

6、从图像rm的多视角图像中{viewm,1,viewm,2,...,viewn,...,viewm,n}中选取4个间隔为45°的视点角度下的若干张图像各自组成一组视角图像,记为{listθ|θ=1,2,3,4};其中,listθ表示第θ组视角图像;

7、将第θ组视角图像listθ在通道维度进行融合和降维操作后,得到第θ组融合图像list′θ;

8、步骤3、构建基于视角选择和多特征融合的光场显著性目标检测模型,包括:编码器、通道降维模块、3个视差提取模块,解码器和融合-反馈模块;

9、步骤3.1、所述编码器包含l个基本块,每个基本块利用卷积层对第θ组融合图像list′θ进行处理后,得到第θ个视点角度下l个特征图其中,表示第θ个视点角度下第i个特征图;

10、将所述rgb图像集合r中的图像rm及其对应的深度图像记为zm分别输入所述编码器中进行处理,得到l个边缘特征{ei|i=1,2,...n}和l个深度特征{di|i=1,2,...n};其中,ei表示第i个边缘特征,di表示第i个深度特征;

11、步骤3.2、所述通道降维模块依次由两个卷积层,一个批量归一化层和一个relu激活层构成,并对第θ个视点角度下l个特征图进行处理后,得到降维后的l个特征图其中,表示第θ个视点角度下降维后的第i个特征图;

12、步骤3.3、3个视差提取模块依次对进行处理后,得到4个视点角度下第i个总视差信息从而得到总视差流

13、步骤3.4、所述解码器由l个解码模块组成;每个解码模块依次由卷积层、批量归一化层和relu激活层构成;

14、当i=l时,将第i个总视差信息输入第i个解码模块中进行处理,得到第i个解码特征

15、当i=l-1,l-2,…,1时,将第i+1个解码特征和第i个总视差信息输入第i个解码模块中进行处理,得到第i个解码特征从而由第1个,得到第i个解码模块输出最终的多视角图像特征

16、将所述rgb图像特征{ei|i=1,2,...l}和深度图像特征{di|i=1,2,...l}分别输入到解码器中进行处理,得到解码后的rgb图像特征和深度图像特征

17、步骤3.5、所述融合-反馈模块由通道融合模块和反馈模块组成;

18、步骤3.5.1、所述通道融合模块利用式(4)得到粗糙的预测显著图

19、

20、式(4)中,cat表示通道融合操作,⊙表示元素级乘法;

21、步骤3.5.2、所述反馈模块依次由l个子反馈模块构成,每个子反馈模块依次由卷积层、批量归一化层,relu激活层和最大池化层构成;

22、所述粗糙的预测显著图通过依次通过l个子反馈模块处理,并在每个子反馈模块产生一种尺度的特征后,对应反馈输入到l个解码器中,从而生成准确的预测显著图xpre;

23、步骤4、训练基于视角选择和多特征融合的光场显著性目标检测模型;

24、步骤4.1、建立损失函数;

25、步骤4.1.1、通过式(5)、式(6)和式(7)分别建立空间损失函数ls、边缘损失函数le和深度损失函数ld:

26、

27、

28、

29、式(5)、式(6)和式(7)中,egt为图像rm的真实边缘图,xgt为图像rm的真实显著图;

30、步骤4.1.2、通过式(8)建立融合特征损失函数:

31、

32、步骤4.1.3、通过式(9)建立总损失函数:

33、l=ls+le+ld+lcat (9)

34、步骤4.2、基于数据集ω={r,m,z},利用随机梯度下降算法对所述基于视角选择和多特征融合的深度神经网络模型进行训练,并计算总损失函数l以更新网络参数,直到总损失函数收敛为止,从而得到最优光场显著性目标检测模型,用于对光场图像进行显著性目标检测。

35、本发明所述的一种基于视角选择和多特征融合的光场显著性目标检测方法的特点也在于,所述步骤3.3是按照如下步骤进行:

36、步骤3.3.1、第θ个子视差提取模块对相互正交的第θ个视点角度下第i个特征图和第θ+2个视点角度下第i个特征图进行元素级乘法计算,得到一组相互正交的视点角度下第i个共同特征

37、步骤3.3.2、第θ个子视差提取模块利用式(1)和式(2)分别得到第θ个视点角度下第i个视差信息和θ+2个视点角度下第i个视差信息

38、

39、

40、步骤3.3.3、第θ个子视差提取模块利用式(3)得到一组相互正交的视点角度下第i个子视差信息

41、

42、式(3)中,α为衰减系数;

43、步骤3.3.4、将两组第i个子视差信息输入第3个子视差提取模块中进行处理后,得到4个视点角度下第i个总视差信息从而得到总视差流

44、本发明一种电子设备,包括存储器以及处理器的特点在于,所述存储器用于存储支持处理器执行所述光场显著性目标检测方法的程序,所述处理器被配置为用于执行所述存储器中存储的程序。

45、本发明一种计算机可读存储介质,计算机可读存储介质上存储有计算机程序的特点在于,所述计算机程序被处理器运行时执行所述光场显著性目标检测方法的步骤。

46、与已有技术相比,本发明的有益效果是:

47、1、本发明通过构建基于视角选择和多特征融合的深度神经网络,使用标签数据监督深度神经网络进行学习,从而获得具有鲁棒性的光场显著性目标检测特征模型,解决了传统方法根据图像的颜色、形状、背景和纹理等低层特征来获取显著图,忽略了很多特征信息,且检测精度不高的问题。

48、2、本发明所构建的基于视角选择和多特征融合的深度神经网络,与当前主流方法采用的视角选择方法进行对比分析,并根据光场的几何特征提出了一种新的视角选择方案,从而能在角度分布均衡的前提下,采用更少的视图数量的同时获得较大的视差量,更高效率地利用多视角图像的视察信息。

49、3、本发明所构建的基于视角选择和多特征融合的深度神经网络,设计了视差提取模块,实现在不同正交方向的多视角图像队列中提取共同特征及差异化特征,并根据所提取特征的相关性完成建模,从而在定位图像中的显著性物体的同时又高效聚合了不同视角的差异信息,等同于对场景中的目标实现了小范围的动态观察,提高了在复杂多变场景下显著性目标检测的精准性。

50、4、本发明所构建的基于视角选择和多特征融合的深度神经网络,通过光场空间、深度、边缘特征信息的协同互补性,设计了一个有效的融合-反馈模块用于实现各分支间的特征交互,从而能够生成更准确的显著图。

- 还没有人留言评论。精彩留言会获得点赞!