一种基于深度学习算法的雷达视觉数据关联方法与流程

本发明涉及雷达视觉信息融合,具体为一种基于深度学习算法的雷达视觉数据关联方法。

背景技术:

1、作为探测系统提升感知能力的突破点,雷达相机信息融合技术可以充分发挥各传感器的优势,实现信息互补,弥补单个传感器的性能限制,获取更稳定可靠的环境兼容信息,在军事、民用等多领域前景广阔。

2、在雷达-视频交通融合感知系统中,一个重要问题是如何判断来自不同局部节点的输出信息是否指向同一目标,即数据关联问题。对此,现有技术中通过搜索与当前视频帧时序最近的雷达帧,作为与当前视频帧匹配的雷达帧,并对当前视频帧和匹配的雷达帧进行融合。此方法没有充分利用传感器数据特征,易受单传感器工作状态影响,关联抗干扰能力较差。另一方法中,将雷达回波信号与视频监控的目标姿态识别进行关联匹配,实现毫米波雷达与视频目标的匹配融合。此方法仅适用于目标运动状态差异较大且变化明显场景,对于杂波干扰大、场景复杂情况匹配效果大幅下降。此外,在密集、拥堵目标场景下,多种传感器数据关联的难度大幅增加,限制了融合感知系统的性能发展。

3、因此,如何提供一种雷达视觉数据关联方法,以实现更优的融合感知性能,成为领域内的重点难点之一。

技术实现思路

1、本发明的目的是提供一种基于深度学习算法的雷达视觉数据关联方法,基于centerfsuion网络架构提取雷达、视觉目标多类特征,并设计反投影机制将视觉检测信息投影至雷达坐标系,放大视觉目标位置变化,结合雷达、视觉连续帧匹配信息进行多源数据关联。通过第一阶段关联滤除大量虚警目标,然后对于不同尺寸目标设置不同的特征权重系数,在第二阶段关联中输出更加准确的关联结果,避免密集场景下的误关联。本方法的场景适应性更强,在虚警漏报、密集目标等场景下有更高的鲁棒性。

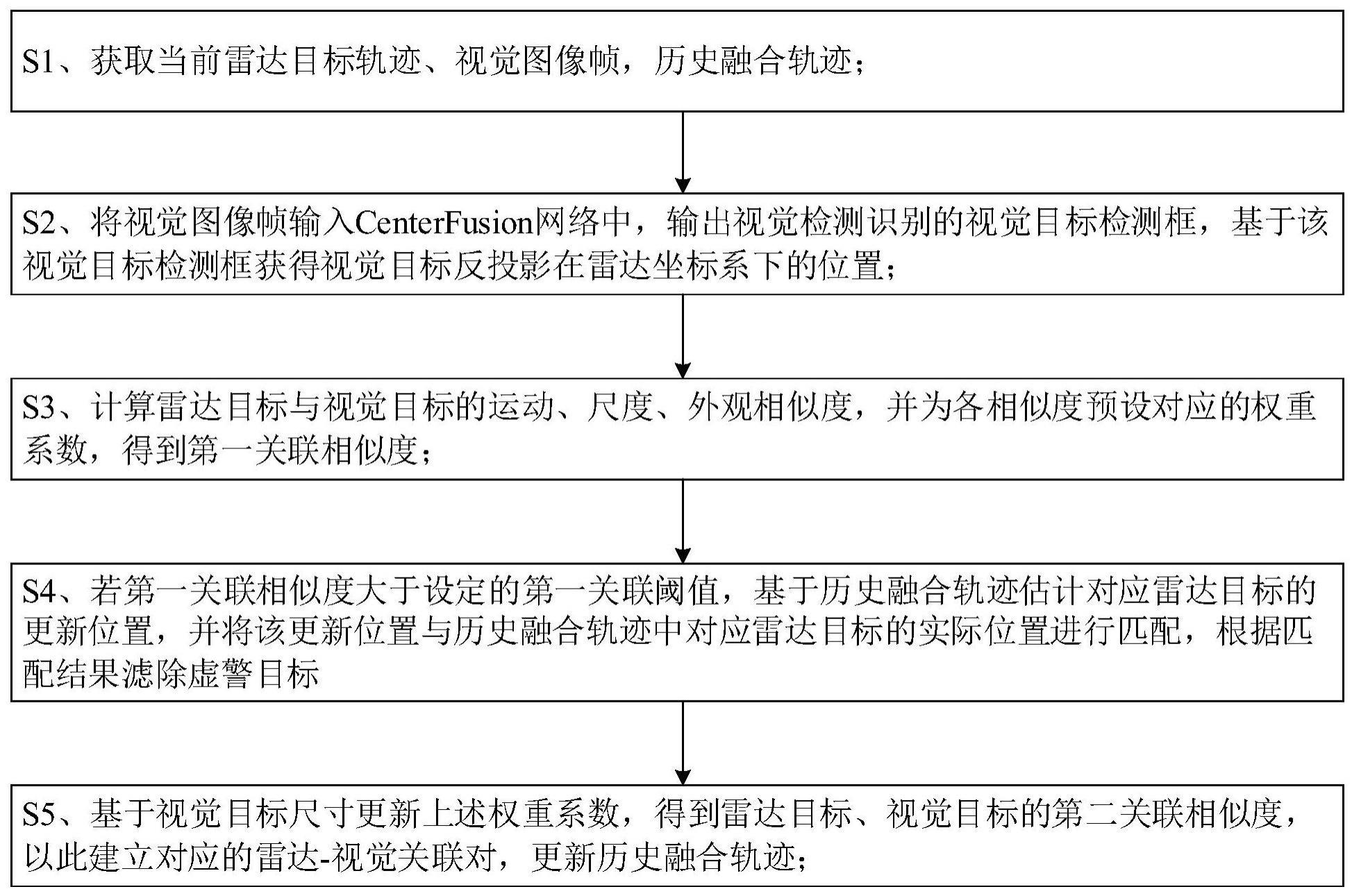

2、为了达到上述目的,本发明提供一种基于深度学习算法的雷达视觉数据关联方法,包含步骤:

3、s1、获取历史融合轨迹,当前雷达目标轨迹、视觉图像帧;所述历史融合轨迹包含上一时刻雷达视觉关联目标轨迹、雷达目标轨迹、视觉目标轨迹;

4、s2、将当前视觉图像帧输入centerfusion网络中,输出视觉检测识别的视觉目标检测框;并设置反投影机制,将视觉目标检测框反投影至雷达坐标系,获得对应视觉目标在雷达坐标系下的位置;

5、s3、计算雷达目标与视觉目标的运动、尺度、外观相似度,并为所述运动、尺度、外观相似度预设对应的权重系数,计算得到雷达目标与视觉目标的第一关联相似度;

6、s4、若所述第一关联相似度大于设定的第一关联阈值,基于历史融合轨迹估计对应雷达目标的更新位置,并将所述更新位置与历史融合轨迹中对应雷达目标的实际位置进行匹配,根据匹配结果滤除虚警目标;

7、s5、基于视觉目标的尺寸为所述运动、尺度、外观相似度分别更新对应的权重系数,更新第一关联相似度为第二关联相似度;若所述第二关联相似度大于设定的第二关联阈值,基于对应雷达目标和视觉目标建立对应的雷达-视觉关联对,并基于对应雷达目标更新历史融合轨迹;进入下一时刻,重复步骤s1至s5。

8、可选的,所述步骤s1中,将当前雷达传感器接收的回波信号经过信号处理后生成雷达目标的点迹;并通过联合概率数据关联算法和卡尔曼滤波算法,基于所述点迹得到当前雷达目标轨迹集rt,为当前第i个雷达目标的轨迹,m为当前雷达目标轨迹中的轨迹总数;t表示回波信号的帧数;

9、历史融合轨迹的集合记为ft-1,为ft-1中的第k个历史融合轨迹,p为历史融合轨迹集合的轨迹总数。

10、可选的,所述步骤s2包含:

11、s21、将当前视觉图像帧输入centerfusion网络中,得到通过视觉目标检测框标注的视觉目标集合表示识别的第j个视觉目标,n为识别的视觉目标总个数;

12、s22、使用设备架设高度hdev作为先验信息获取目标空间高度-hdev+hobj/2,hobj为目标自身高度;通过视觉传感器的内参标定和三维坐标转换得到视觉、雷达传感器之间的位置转换矩阵;基于所述位置转换矩阵,将视觉目标的视觉目标检测框下边缘作为参考点投影至雷达坐标系下,获得视觉目标在雷达坐标系下的反投影位置分别为视觉目标反投影在雷达坐标系下的横向位置、纵向位置。

13、可选的,所述步骤s3包含:

14、s31、基于雷达坐标系下,雷达目标的位置、视觉目标的反投影位置,得到雷达目标、视觉目标的运动相似度φmotion(rti,vtj):

15、

16、分别表示轨迹rti所对应的雷达目标在雷达坐标系下的横向、纵向位置,分别表示视觉目标的视觉目标检测框的宽度、高度;

17、s32、计算视觉目标与历史融合轨迹中的轨迹的尺度相似度

18、

19、分别表示与轨迹关联的视觉目标的视觉目标检测框宽度、长度;分别表示视觉目标的视觉目标检测框宽度、长度;

20、s33、以视觉目标的灰度直方图作为外观特征,使用巴氏距离计算视觉目标与历史融合轨迹中的轨迹之间的外观相似度

21、分别表示的灰度直方图特征;

22、s34、为运动、尺度、外观相似度设置对应的权重系数β1、β2、β3,并分别赋予预设值,得到关联矩阵其中视觉目标与轨迹所对应雷达目标的第一关联相似度表示为:

23、

24、可选的,步骤s4包含:

25、s41、若第一关联相似度大于设定的第一关联阈值,进行视觉目标与历史融合轨迹间的二次关联匹配;利用卡尔曼滤波算法,估计轨迹对应雷达目标的更新位置轨迹的最近数据更新时间为t′,分别表示t′时在雷达坐标系下轨迹预估的横向、纵向位置;

26、s42、若满足以下关系式,将轨迹对应的雷达目标、视觉目标放入待关联池,否则将雷达目标、视觉目标作为虚警目标并滤除:

27、

28、为当前视觉目标在雷达坐标系下反投影的横向、纵向位置,thre_x、thre_y、thre_t分别表示横向位置、纵向位置、间隔时间上的匹配阈值。

29、可选的,步骤s5包含:

30、s51、基于视觉目标在视觉图像帧中的占比,将待关联池中的视觉目标划分为大目标、中目标、小目标,并为所述大目标、中目标、小目标分别更新对应的运动、尺度、外观相似度的权重系数β1、β2、β3;基于更新后的β1、β2、β3,计算待关联池中的视觉目标、雷达目标的第二关联相似度;

31、s52、利用匈牙利算法对第二关联相似度大于第二关联阈值的视觉目标、雷达目标进行筛选,获得一一对应的雷达-视觉关联对;

32、s53、基于centerfusion网络和雷达-视觉关联对融合对应的雷达特征、视觉特征,回归输出目标信息,并将回归输出的结果存入对应的历史融合轨迹中,作为下一时刻的网络输入信息;所述目标信息包含目标的位置、速度、运动方向、尺寸中的任一种或多种。

33、可选的,步骤s34中,β1、β2、β3的预设值均为1/3。

34、可选的,步骤s51中,令σ为视觉目标的像素值,令size为视觉图像帧像素值;σ1=size/100,σ2=(3*size)/100,当σ<σ1为小目标,若σ1≤σ<σ2为中目标,若σ≥σ2为大目标,则更新后的β1、β2、β3如下所示:

35、

36、与现有技术相比,本发明的有益效果在于:

37、1)本发明的基于深度学习算法的雷达视觉数据关联方法采用多特征融合的方法,基于centerfsuion网络将雷达目标投影至视觉图像帧,并将带视觉目标检测框的视觉目标反投影至雷达坐标系下,放大视觉目标位置变化。在第一阶段关联中,计算视觉目标和雷达目标的运动、尺度、外观相似度,并为各相似度分别赋予对应的权重系数,得到第一关联相似度。基于第一关联相似度结合历史融合轨迹从时空维度上与视觉目标进行匹配,根据匹配结果滤除虚警目标,提高雷达视觉数据关联的抗干扰能力,解决由于大量目标和误检导致关联精度下降的问题。

38、2)本发明根据视觉目标在视觉图像帧中的不同占比,根据尺寸差异为视觉目标更新对应运动、尺度、外观相似度的权重系数,在第二阶段关联中得到更加准确的第二关联相似度,以此得到一一对应的稳定雷达-视觉关联对,避免密集场景下的误关联。并解决了雷达目标出现高度相似性和遮挡时,轨迹分配混乱的问题。

39、3)本发明结合深度学习特征提取算法和历史融合轨迹进行多源数据关联,数据关联场景适应性更强,数据关联准确性大幅提升。

- 还没有人留言评论。精彩留言会获得点赞!