奖励模型训练和奖励值生成方法、装置、设备和介质与流程

本公开涉及人工智能,具体为自然语言处理、深度学习等,尤其涉及一种奖励模型训练和奖励值生成方法、装置、设备和介质。

背景技术:

1、随着自然语言处理技术的发展,出现了任务式对话生成模型。训练任务式对话生成模型的步骤之一是训练奖励模型(reward model,rm)。rm是基于同一个请求对应的多个排序后的响应(response)进行训练的,响应是根据标注者打分进行排序的。一般来讲,响应越长,其对应的质量就越高,标注者的打分也会越高,从而产生rm的长度偏置问题。这样就会造成最终训练的任务式对话生成模型倾向于输出长度更长的结果,发生无法结尾的情况。

2、相关技术中,为了纠正rm的长度偏置问题,通常是对多个标注者的打分情况进行拟合,根据拟合结果对响应进行排序。但是,这种方式会增加标注成本和标注时间,不利于模型的快速迭代和发展。

技术实现思路

1、本公开提供了一种奖励模型训练和奖励值生成方法、装置、设备和介质。

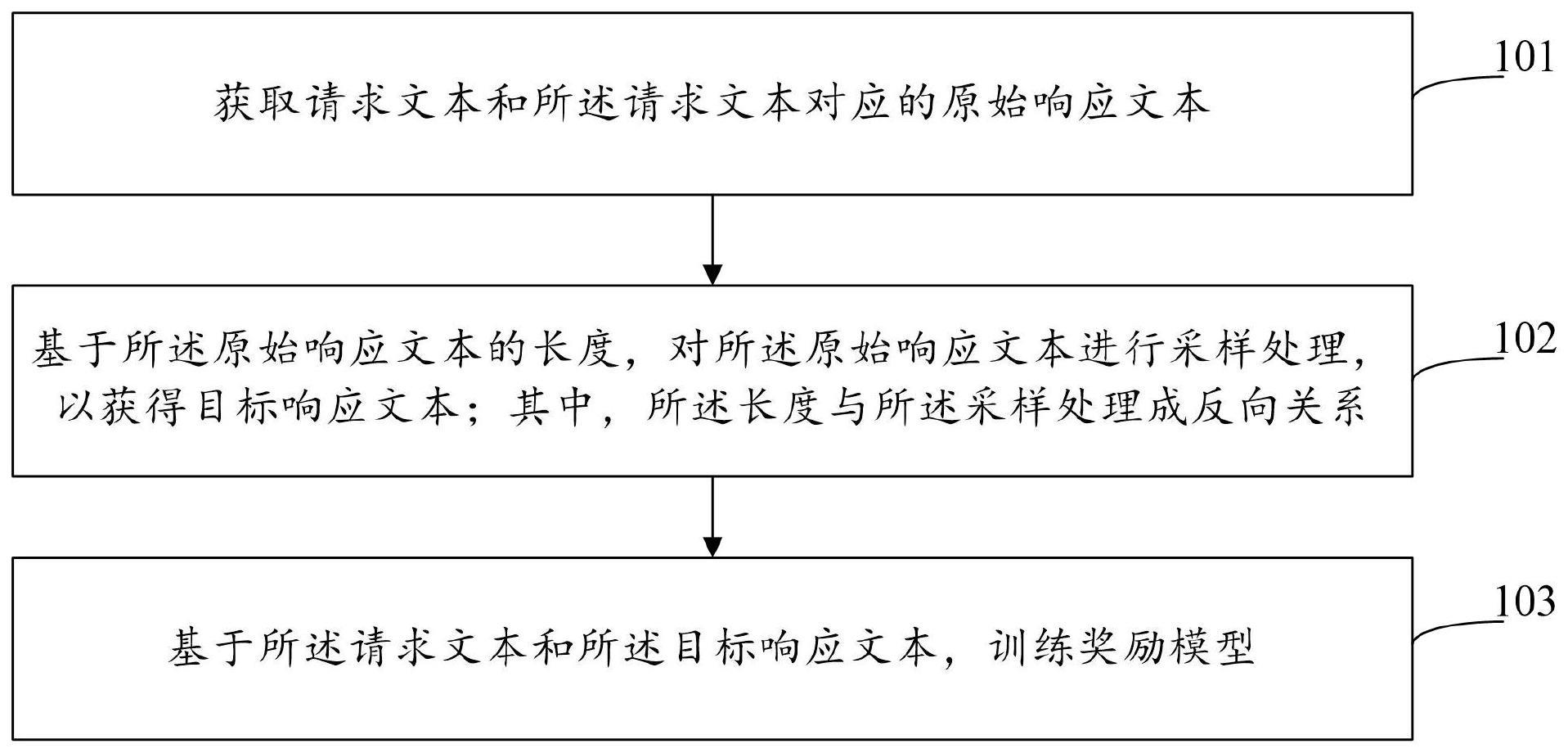

2、根据本公开的一方面,提供了一种奖励模型训练方法,包括:获取请求文本和所述请求文本对应的原始响应文本;基于所述原始响应文本的长度,对所述原始响应文本进行采样处理,以获得目标响应文本;其中,所述长度与所述采样处理成反向关系;基于所述请求文本和所述目标响应文本,训练奖励模型。

3、根据本公开的另一方面,提供了一种奖励值生成方法,包括:获取问答对,所述问答对包括:请求文本和响应文本;采用预先训练的奖励模型,对所述问答对进行处理,以获得所述问答对的奖励值;其中,所述奖励模型采用上述任一方面的任一项所述的方法训练的。

4、根据本公开的另一方面,提供了一种奖励模型训练装置,包括:获取模块,用于获取请求文本和所述请求文本对应的原始响应文本;采样模块,用于基于所述原始响应文本的长度,对所述原始响应文本进行采样处理,以获得目标响应文本;其中,所述长度与所述采样处理成反向关系;训练模块,用于基于所述请求文本和所述目标响应文本,训练奖励模型。

5、根据本公开的另一方面,提供了一种奖励值生成装置,包括:获取模块,用于获取问答对,所述问答对包括:请求文本和响应文本;生成模块,用于采用预先训练的奖励模型,对所述问答对进行处理,以获得所述问答对的奖励值;其中,所述奖励模型采用上述任一方面的任一项所述的方法训练的。

6、根据本公开的另一方面,提供了一种电子设备,包括:至少一个处理器;以及与所述至少一个处理器通信连接的存储器;其中,所述存储器存储有可被所述至少一个处理器执行的指令,所述指令被所述至少一个处理器执行,以使所述至少一个处理器能够执行如上述任一方面的任一项所述的方法。

7、根据本公开的另一方面,提供了一种存储有计算机指令的非瞬时计算机可读存储介质,其中,所述计算机指令用于使所述计算机执行根据上述任一方面的任一项所述的方法。

8、根据本公开的另一方面,提供了一种计算机程序产品,包括计算机程序,所述计算机程序在被处理器执行时实现根据上述任一方面的任一项所述的方法。

9、根据本公开的技术方案,可以高效地纠正奖励模型的长度偏置问题。

10、应当理解,本部分所描述的内容并非旨在标识本公开的实施例的关键或重要特征,也不用于限制本公开的范围。本公开的其它特征将通过以下的说明书而变得容易理解。

技术特征:

1.一种奖励模型训练方法,包括:

2.根据权利要求1所述的方法,其中,

3.根据权利要求2所述的方法,其中,

4.根据权利要求3所述的方法,其中,所述对所述第一待处理响应文本进行下采样处理,以获得所述目标响应文本,包括:

5.根据权利要求2所述的方法,其中,

6.根据权利要求5所述的方法,其中,所述对所述第二待处理响应文本进行上采样处理,以获得所述目标响应文本,包括:

7.一种奖励值生成方法,包括:

8.一种奖励模型训练装置,包括:

9.根据权利要求8所述的装置,其中,

10.根据权利要求9所述的装置,其中,

11.根据权利要求10所述的装置,其中,所述采样模块进一步用于:

12.根据权利要求9所述的装置,其中,

13.根据权利要求12所述的装置,其中,所述采样模块进一步用于:

14.一种奖励值生成装置,包括:

15.一种电子设备,包括:

16.一种存储有计算机指令的非瞬时计算机可读存储介质,其中,所述计算机指令用于使所述计算机执行根据权利要求1-7中任一项所述的方法。

17.一种计算机程序产品,包括计算机程序,所述计算机程序在被处理器执行时实现根据权利要求1-7中任一项所述的方法。

技术总结

本公开提供了一种奖励模型训练和奖励值生成方法、装置、设备和存储介质,涉及人工智能技术领域,具体为自然语言处理、深度学习等技术领域。奖励模型训练方法包括:获取请求文本和所述请求文本对应的原始响应文本;基于所述原始响应文本的长度,对所述原始响应文本进行采样处理,以获得目标响应文本;其中,所述长度与所述采样处理成反向关系;基于所述请求文本和所述目标响应文本,训练奖励模型。本公开可以高效地纠正奖励模型的长度偏置问题。

技术研发人员:丁思宇,韩雅倩,王硕寰,孙宇,田浩,吴华,王海峰

受保护的技术使用者:北京百度网讯科技有限公司

技术研发日:

技术公布日:2024/1/15

- 还没有人留言评论。精彩留言会获得点赞!