一种基于退化融合级联网络的少样本遥感时空融合方法和系统

本发明属于遥感图像处理,特别涉及一种基于退化融合级联网络的少样本遥感时空融合方法。

背景技术:

1、单一卫星遥感影像由于受到卫星传感器自身物理特性的限制,其时间分辨率与空间分辨率之间往往相互制约。所谓的时间分辨率是指卫星对地球同一地点相邻两次遥感观测的最小时间间隔;空间分辨率是指是指遥感图像上能够详细区分的最小单元的尺寸或大小,是用来表征影像分辨地面目标细节的指标。另外其成像过程易受到云等外界因素以及自身传感器受损等自身因素影响,导致可用高分影像数量受限,其应用如动态监测、变化检测、地物类型识别等也会受到较大影响。针对以上问题,通常可采用遥感影像时空融合方法将异源(不同卫星传感器)高空间、低时间分辨率影像与低空间、高时间分辨率影像进行融合进而得到高空间、高时间分辨率影像,充分提升高质量遥感影像的时空可用性以及充分利用和挖掘遥感影像中蕴含的有用信息。

2、目前现有时空融合方法基本可分为传统方法与深度学习方法。前者包括基于权重函数、基于混合像元分解等方法,这些方法算法较简单计算速度较快,但存在线性假设等局限性;而深度学习方法拥有其强大非线性特征提取与表达优势,其融合效果优于多数传统融合方法。基于深度学习时空融合方法主要分为监督学习、自监督学习或无监督学习方法等。监督学习方法需要较大量数据训练以保证模型普适性,但当训练数据与待融合数据特征存在较大差异时,即训练的网络不适用于待融合数据时融合效果较差;而自监督学习方法一般通过线性插值方法将原始影像降采样再以原始影像为标签数据构造训练集进行训练,但由于高分卫星影像与低分卫星影像来自不同卫星传感器导致影像风格存在较大差异,即普通线性插值方法无法较好模拟两者之间较为复杂的退化关系也会影响融合效果,导致融合结果与参考结果差异较大。另外,目前多数深度学习时空融合方法需要较多样本或多个参考时刻数据进行训练,对于数据数量要求较高,而本方法为基于少样本的时空融合方法,仅需要一个参考时刻的高、低分辨率影像对即可,对数据要求较低且具有较高的融合精度,能够更好服务于实际应用。

技术实现思路

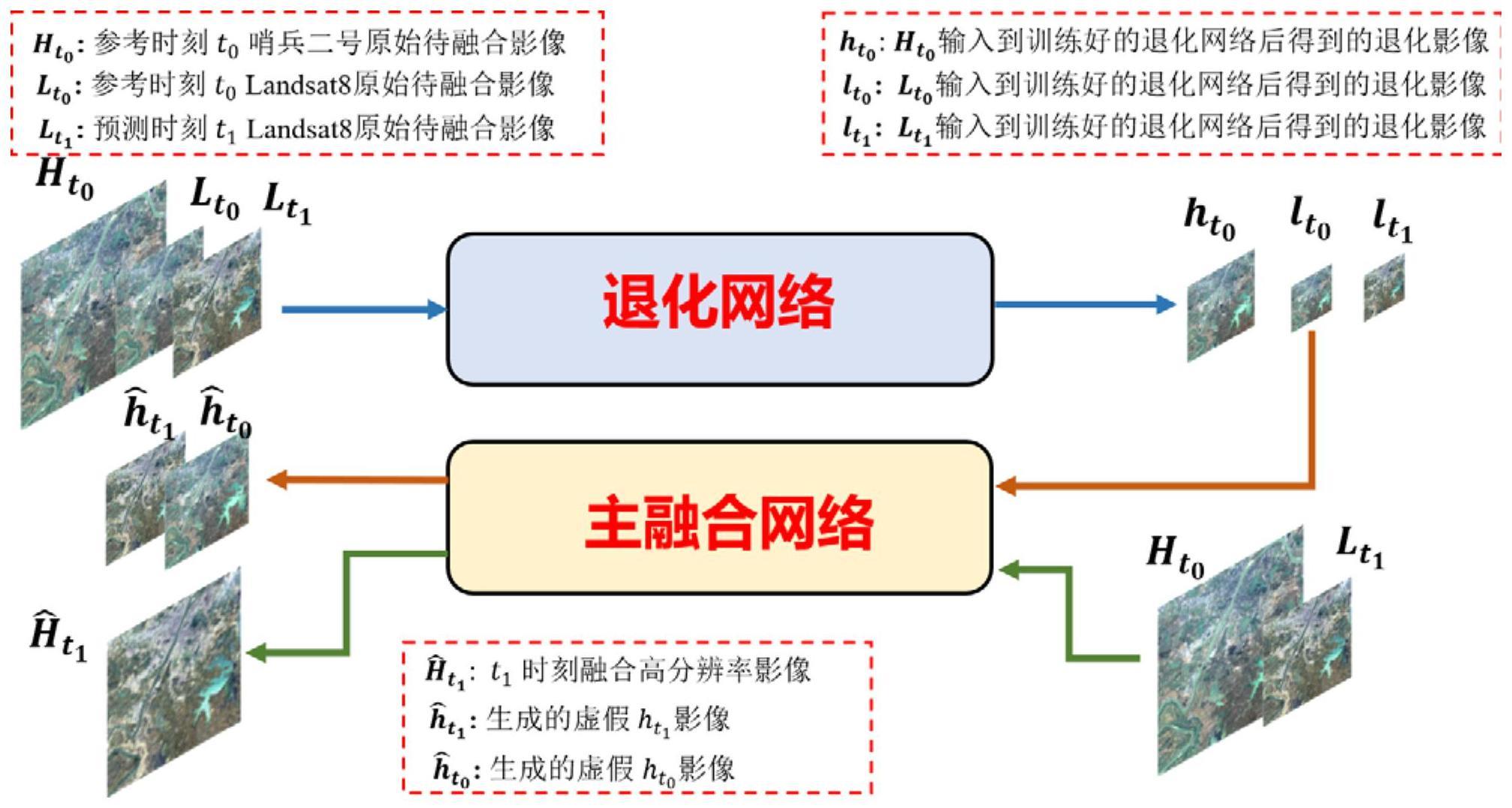

1、针对现有技术存在的不足,本发明提出了一种基于退化融合级联网络的少样本遥感时空融合方法。首先针对现有基于自监督学习策略深度学习时空融合方法中采用的插值降采样方式可能无法较好模拟来自不同遥感器高空间分辨率、低空间分辨率遥感影像之间复杂退化关系的问题,在第一阶段设计了一个退化网络依靠深度神经网络强大的非线性学习能力学习待融合高空间分辨率与低分辨率影像之间复杂的退化关系代替传统插值降采样构造训练集。以高空间分辨率影像为输入,低空间分辨率影像为标签对退化网络进行训练。训练完成后将低分辨率影像输入退化网络得到低空间分辨率退化影像。之后以低分辨率影像、低分辨率退化影像为训练数据训练一个以循环一致性生成对抗网络为基础的融合网络,以低分辨率退化影像为输入、低分辨率影像为标签进行训练。训练完成后,将低分辨率影像输入融合网络得到最终融合高分辨率影像。本方法仅需要单个参考时刻的高、低空间分辨率影像对,对训练样本数量要求较低,且融合精度高,具有一定普适性。具体包括以下步骤:

2、步骤1,首先构建退化网络并进行训练,所述退化网络由特征提取编码模块与退化解码模块共同构成;在退化网络训练阶段,以参考时刻t0的高空间分辨率影像低空间分辨率影像作为训练数据;

3、步骤2,退化网络测试阶段,将参考时刻高分辨率、低分辨率影像以及预测时刻低分辨率影像输入到训练好的退化网络,得到各自相应退化后影像退化后影像与预测时刻低分辨率影像共同构成下一阶段主融合网络的训练集,t1为预测时刻;

4、步骤3,主融合网络基于循环一致性生成对抗网络cycle-gan框架搭建,所述主融合网络包含前向生成器后向反馈生成器以及相对应的两个判别器在主融合网络训练阶段,按照以下方式:前向生成器利用参考时刻高分辨率影像以及预测时刻低分辨率影像融合生成预测时刻高分辨率影像,后向反馈生成器是为保证前向生成器生成的高分辨率影像包含信息约束于原始输入影像,利用前向生成器生成的高分辨率影像得到原始输入高分辨率影像,判别器用于提取输入影像特征来判别输入影像的真实性,与生成器相互博弈提升各自性能;

5、步骤4,在主融合网络测试阶段,通过将原始待融合影像输入到训练好的前向生成器中获得最终预测时刻融合影像。

6、进一步的,步骤1中,特征提取编码模块先通过第一层卷积初步提取浅层特征,之后通过多个激活、卷积、归一化组合层用于提取多层次特征,与之相对应的,退化解码模块通过多个激活、反卷积、归一化组合层逐步生成退化结果,通过数据增强方式构造融合网络所需训练集,由多层卷积与反卷积构成。

7、进一步的,步骤1中,退化网络训练阶段的具体过程如下:以参考时刻的高分辨率影像作为输入,参考时刻的低分辨率影像作为标签数据进行训练,其过程用下式表示:

8、

9、其中,为训练过程中网络生成的虚假参考时刻低分影像,nd表示退化网络生成过程,θd表示退化网络的可训练参数;训练阶段结束后,得到一个训练好的能够表达来自不同传感器的高、低空间分辨率影像退化关系的退化网络,其中m、n、b表示图像长、宽、波段数,s为高分辨率影像与低分辨率影像的尺度因子。

10、进一步的,步骤2中退化网络测试阶段的实现过程用下式表示:

11、

12、其中,是参考时刻高分辨率影像输入到退化网络后得到的退化后影像,是参考时刻与预测时刻低分辨率影像输入到退化网络后分别得到的退化后影像,其中m、n、b表示图像长、宽、波段数,s为高分辨率影像与低分辨率影像的尺度因子。

13、进一步的,步骤3中,两个生成器由浅层特征提取模块、深度残差模块以及融合生成模块组成,浅层特征提取模块由多个卷积层、填充层与激活层组成用于提取浅层特征,深度残差模块由多个残差块组成用于提取深层特征,融合模块也是由卷积层、激活层和填充层组成,用于生成融合结果;两个判别器采用多个卷积层、激活层和归一化层组成。

14、进一步的,步骤3的具体实现方式如下:

15、步骤3.1,将退化网络得到的输入到前向生成器得到t1时刻相应的预测高分辨率影像,表示为下式:

16、

17、其中,为训练过程中生成的预测时刻目标融合影像,为前向生成器的可训练参数;

18、步骤3.2,将步骤3.1生成的与其参考标签影像输入到前向判别器,通过判别器约束生成的的质量;

19、步骤3.3,将步骤3.1生成的与一并输入到后向反馈生成器得到预测的原始输入高分辨率影像,以约束生成的融合影像的空间信息与原始输入的高空间分辨率影像的空间信息的一致性,表示为:

20、

21、其中,为训练过程中生成的预测原始输入高分辨率影像,为后向反馈生成器的可训练参数;

22、步骤3.4,将步骤3.3生成的与其参考标签影像输入到后向反馈判别器,通过判别器约束生成的的质量。

23、进一步的,在退化网络训练阶段,采用的目标损失函数为下式:

24、

25、进一步的,在主融合网络训练阶段,采用的总目标损失函数为:

26、lf=ladv+λlcontent+δlconsist (18)

27、其中,ladv表示生成对抗损失,lcontent表示内容损失即生成器生成影像与参考影像之间差异损失,lconsist表示一致性约束损失,用于约束融合影像更多保留输入影像的空间特征,λ和δ表示权重参数用于权衡内容损失以及一致性约束损失的贡献,生成对抗损失定义如下:

28、lf=ladv+λlcontent+δlconsist (19)

29、其中各项定义为:

30、

31、

32、

33、其中,与分别表示由参考时刻到预测时刻融合过程与预测时刻到参考时刻融合影像反向生成原始输入影像过程的生成对抗损失;

34、内容损失与一致性约束损失定义如下:

35、

36、

37、本发明还提供一种基于退化融合级联网络的少样本遥感时空融合系统,包括以下模块:

38、退化网络构建模块,首先构建退化网络并进行训练,所述退化网络由特征提取编码模块与退化解码模块共同构成;在退化网络训练阶段,以参考时刻t0的高空间分辨率影像、低空间分辨率影像作为训练数据;

39、退化网络测试模块,用于在退化网络测试阶段,将参考时刻高分辨率、低分辨率影像以及预测时刻低分辨率影像()输入到训练好的退化网络,得到各自相应退化后影像(),退化后影像与预测时刻低分辨率影像共同构成下一阶段主融合网络的训练集,t1为预测时刻;

40、主融合网络构建模块,主融合网络基于循环一致性生成对抗网络cycle-gan框架搭建,所述主融合网络包含前向生成器、后向反馈生成器以及相对应的两个判别器在主融合网络训练阶段,按照以下方式:前向生成器利用参考时刻高分辨率影像以及预测时刻低分辨率影像融合生成预测时刻高分辨率影像,后向反馈生成器是为保证前向生成器生成的高分辨率影像包含信息约束于原始输入影像,利用前向生成器生成的高分辨率影像得到原始输入高分辨率影像,判别器用于提取输入影像特征来判别输入影像的真实性,与生成器相互博弈提升各自性能;

41、主融合网络测试模块,用于在主融合网络测试阶段,通过将原始待融合影像输入到训练好的前向生成器中获得最终预测时刻融合影像。

42、与现有技术相比,本发明具有如下的优点和有益效果:

43、1、本发明提出了一种基于深度学习退化网络的时空融合方法,首次通过深度学习的方式学习不同遥感器高、低空间分辨率影像之间的复杂映射关系取代传统自监督学习中插值降采样方式来构造训练数据,使得训练数据更加贴合实际测试数据进而提升融合质量;

44、2、采用循环一致性生成对抗网络作为主融合网络的基本框架,可以更好保生成的高分辨率影像保留原始输入影像的空间特征信息。在损失函数方面,除了基本生成对抗损失之外加入内容损失与一致性约束损失进一步约束融合结果;

45、3、本发明为基于小样本的时空融合方法,对样本数量要求较低,可以应用在较为极端的情况下的时空融合(如仅有参考时刻高分辨率、低分辨率影像以及预测时刻低分辨率影像三张影像的情况),具有较高的实际应用价值;

46、4、通过目视、定量对比实验表明,本发明相比较于其他现阶段时空融合代表方法具有更高的融合精度。

- 还没有人留言评论。精彩留言会获得点赞!