结合可解释深度学习的彩色图引导深度图超分辨率方法

本发明属于图像质量增强领域,具体涉及的是一种结合可解释深度学习的彩色图引导深度图超分辨率方法。

背景技术:

1、随着虚拟现实、自动驾驶汽车、人机交互等工业应用的快速发展,人们更希望获得高分辨率(hr)深度图。然而,消费级深度相机只能获得低分辨率(lr)深度图。为了解决这个问题,深度图超分辨率(dsr)技术已成为估计hr深度图的重要手段。但是,只有lr深度图的情况下,通常难以获得高质量的hr深度图。考虑到彩色图像和深度图在同一场景中具有结构相似性,很多dsr方法将彩色图像作为先验条件来指导深度图重建。

2、在以往的彩色图引导dsr工作中,基于局部滤波的dsr方法是一种比较常用的方法,这些方法利用彩色图像信息来生成权重指导hr深度图的滤波重建。基于非局部滤波的dsr方法方法是对局部滤波方法的扩展。不同之处在于局部滤波方法使用不同像素点的强度差进行滤波,而非局部滤波方法使用不同局部块的强度差进行滤波。马尔科夫随机场方法和全变分优化方法是通过优化算法来估计所有像素的深度值。上述传统方法虽然取得了较好的超分辨率重建性能,但是这些方法都需要使用人工设计的特征提取算子,这些算子限定了这些方法的发展潜力。

3、不同于传统的dsr方法,一些基于卷积神经网络的dsr方法采用端到端的训练来获得可学习的网络模型,从而改善了传统方法的一些缺点。一般来说,早期的dsr方法通常直接将彩色图像和lr深度图输入网络,但是这种方法往往缺乏网络可解释性,同时很大程度上忽略了深度图边界先验信息的重要性。随后,基于边界先验的dsr方法进一步考虑了深度图的边界先验来提升性能。该方法首先预测深度边界图,然后将其作为先验条件输入dsr网络。这可以大大缓解边界模糊的不良现象。虽然以上工作都能取得不错的效果,但是这些网络都是黑箱的操作。为了解决该问题,一些研究工作将一些优化算法展开为不同类型的网络拓扑结构。例如,在引导图像与目标图像稀疏系数存在相似性的假设条件下,marivani等人将图像稀疏表示展开为一种端到端的可学习网络。最近zhou等人探索不同模态之间的局部和非局部相关性,将深度图超分辨率重建优化模型展开为dsr网络。与非展开的dsr方法相比,由于展开的dsr方法继承了优化算法的固有先验结构的优点,因此,展开的dsr方法具有更高的参数利用率和良好的可解释性。

技术实现思路

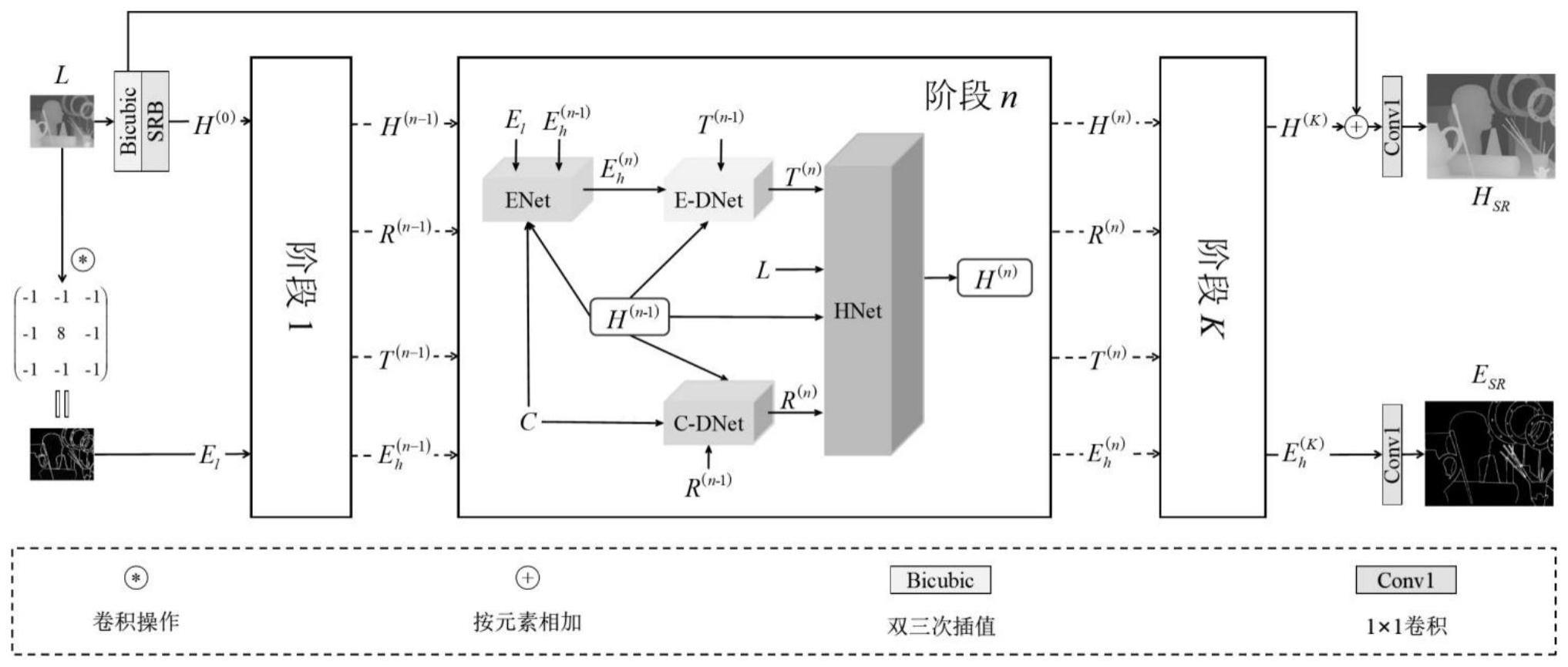

1、本发明提出了一种结合可解释深度学习的彩色图引导深度图超分辨率方法,首先提出一种双任务驱动的深度图超分辨率优化模型,然后将其展开为双任务驱动的深度图超分辨率网络ecdsrnet。该网络包括四个子网络:边界重建网络(enet),边界引导深度特征重建网络(e-dnet),彩色图引导深度特征重建网络(c-dnet)和高保真网络(hnet)。所提方法不仅具有可解释性,而且是一种从粗到精的网络结构,这在理论上保证了其优越性。大量实验结果表明,所提出方法在平均绝对偏差、均方根误差、峰值信噪比、结构相似性等方面可以超越许多最先进的dsr方法。

2、为了实现上述目的,本发明通过以下技术方案予以实现。

3、一种结合可解释深度学习的彩色图引导深度图超分辨率方法,包括以下步骤:

4、步骤1)训练数据构建

5、在网络训练前,对nyu-v2和middleburyrgb-d数据集中的部分图像进行处理,得到该网络的训练数据集,同时对另一部分图像进行处理,得到测试数据集。

6、步骤2)构建双任务驱动的深度图超分辨率优化模型

7、第一,使低分辨率(lr)深度图l通过拉普拉斯算子提取边界特征,即得到lr深度边界el;第二,根据贝叶斯公式和最大后验概率公式探索lr深度图l∈r1×m/m×n/m、高分辨(hr)深度图h∈r1×m×n、lr深度边界el∈r1×m/m×n/m、hr深度边界eh∈r1×m×n和彩色图c∈r3×m×n之间的分布关系,进而得到一种双任务驱动的深度图超分辨率优化模型。这里m和n分别是hr图像的长和宽,m是降质倍数。

8、步骤3)求解双任务驱动的深度图超分辨率优化模型

9、使用半二次分裂算法和近端梯度下降算法求解优化步骤2)所构建的深度图超分辨率优化模型。

10、步骤4)构建一种双任务驱动的深度图超分辨率网络

11、将双任务驱动的深度图超分辨率优化模型每一步的求解表达式转化为特定的子网络,再将这些子网络组合在一起,形成一种双任务驱动的深度图超分辨率网络ecdsrnet。

12、步骤5)损失函数

13、使用l1约束dsr重建图像的数据保真损失,使用l2范数约束深度图边界超分辨率重建图像的数据保真损失。

14、进一步的,所述步骤1)中来自microsoft kinect相机拍摄的nyu-v2 rgb-d数据集的前1000张640×480rgb-d图像对作为训练数据集,该数据集的最后449张640×480rgb-d图像作为测试数据集来评估本发明方法的性能。为了进一步验证本发明方法的通用性,从middlebury rgb-d数据集中收集36张1312×1072rgb-d图像来训练所提网络,同时使用6张1312×1072rgb-d图像(art、books、dolls、laundry、moebius和reindeer)进行网络性能测试。为了便于训练,随机裁剪训练数据集中分辨率大小为256×256的hr图像作为真实(gt)深度图。为了得到4×、8×和16×的lr深度图,对gt深度图使用双三次插值方法进行下采样得到64×64、32×32和16×16的lr深度图。采用均方根误差(rmse)、平均绝对偏差(mad)、峰值信噪比(psnr)、结构相似度(ssim)等4个被广泛采用的指标来评估所提方法的性能。使用pytorch框架实现提出的方法,并且使用nvidiageforce rtx 3090的gpu进行训练和测试。采用adam优化器对网络进行优化。初始学习率为0.0001。经过100个epochs后,学习率衰减为0.00001,总共使用150个epochs进行训练,图像训练的批大小为16。

15、进一步,所述步骤2)中lr边界图el=l*lpls,其中lpls是八邻域拉普拉斯算子,*为卷积运算。lr深度边界el和待估计的hr深度边界eh、lr深度图l和待估计的hr深度图h之间的数学表达式可以表示为:

16、

17、其中,d(.),k(.)和n(.)分别是下采样算子、图像模糊卷积核和加性噪声。另外,c、l、el、h和eh之间的分布关系可以表示为:

18、

19、将上述中与待求解变量无关的项视为常数,则上式可以改写为:

20、

21、假设四个隐式的先验分布为:

22、

23、其中,g1(·)是关于c和h的能量函数,g2(·)是关于h和eh的能量函数,g3(·)是传递h先验结构的能量函数,g4(·)是关于eh,c和h的能量函数。α、β、γ和η是四个平衡参数。将公式(1)和(4)代入公式(3),然后取负对数将h和eh的后验分布最大化问题转化为最小化优化问题:

24、

25、进一步的,所述步骤3)中,在半二次分裂算法中引入两个辅助变量r和t来优化公式(5),即:

26、

27、其中,α1和β1是平衡参数。将公式(6)中与待求解变量无关的项视为常数,然后使用近端梯度下降算法进一步优化待解目标函数,即交替地更新eh、t、r和h,交替优化表达式可以写为:

28、

29、

30、

31、

32、其中,δ1、δ2、δ3和δ4是迭代步长,n表示算子的第n次迭代数,(·)t是矩阵的转置操作。和是近端算子。

33、进一步,所述步骤4)中将公式(7)、(8)、(9)和(10)转换为四个特定的子网络,即边界重建网络(enet),边界引导深度特征重建网络(e-dnet),彩色图引导深度特征重建网络(c-dnet)和高保真网络(hnet)。

34、边界重建网络enet:为了获得深度边界特征eh,将公式(7)展开为enet,即:

35、

36、其中,关于c和h的近端算子可以使用一个u型网络unet(·)来近似表示,则enet可以具体写为:

37、

38、其中,srb是一个简单的残差块,conv1是一个起到改变通道数作用的1×1卷积,[·]是沿着通道维度的堆叠操作。

39、边界引导深度特征重建网络e-dnet:在已经通过enet获得深度边界特征的情况下,设计e-dnet来预测hr深度图特征,公式(8)可以展开为:

40、

41、其中,unet(·)用于近似取代近端算子是关于t(n-1)的梯度下降表达式的输出。

42、彩色图引导深度特征重建网络c-dnet:同样地,在彩色图c的指导下,通过c-dnet预测hr深度特征r(n)。公式(9)可以展开为:

43、

44、其中,unet(·)用于近似取代近端算子是关于r(n-1)的梯度下降表达式的输出。

45、高保真网络hnet:通过公式(10)可以构建一个高保真网络hnet对e-dnet和c-dnet输出深度图进行细化,可以表示为:

46、

47、其中,α1和β1是用来平衡c-dnet和e-dnet输出深度图的作用,使用unet(·)近似prelu是激活函数,conv是一个具有图像降质的步长为m的下采样卷积操作,dconv是步长为m的转置卷积操作。通过由粗糙到精细渐进重建的高保真网络可以很好地缓解预测深度图中的边界模糊和纹理复制问题。

48、总的来说,所提出的双任务驱动的深度图超分辨率网络ecdsrnet包括k个阶段,对应于公式(12)、(13)、(14)和(15)的k次迭代。每个阶段包含四个子网络,即enet,e-dnet,c-dnet和hnet。

49、进一步的,所述步骤5)中,在dsr中,使用l1范数来测量超分辨率(sr)深度图hsr与真实(gt)深度图hgt之间的距离,可以表示为对于训练深度边界图sr模型,使用l2范数来度量sr深度边界图esr与gt边界图egt之间的距离,可以表示为总损失函数可以写成losssum=loss1+μloss2,其中,μ用于两个损失函数之间的权衡,i表示图像的第i个像素,n表示整个图像的总像素数。

50、与现有技术相比,本发明的有益效果为:

51、1、本发明为了解决彩色图引导的dsr带来的纹理复制和边界模糊问题,构建了双任务驱动的深度图超分辨率优化模型,并将其分解为两个子优化模型,将这些子优化模型联合展开为一个由粗到精的边界约束dsr网络ecdsrnet。与其它的dsr方法相比,本发明提出的网络兼顾了可解释性与高性能。

52、2、本发明合理地展示了如何利用边界重建子优化模型驱动边界重建网络(enet)获取精确的边界信息的过程,这是高质量重建深度图的先决条件。与其它优秀的dsr方法相比,本发明提取的边界特征更加高效。

53、3、将深度重建子优化模型展开为边界引导深度特征重建网络(e-dnet)和彩色图引导深度特征重建网络(c-dnet)。这两个网络预测两种hr深度特征,然后引入高保真网络(hnet)融合两种hr深度特征,最终重建出比其它dsr方法更高质量的深度图。

- 还没有人留言评论。精彩留言会获得点赞!