基于多任务负采样的跨领域实体链接方法、装置及介质

本发明涉及自然语言处理和知识图谱中实体链接领域,尤其涉及基于多任务学习和负采样策略的跨领域实体链接方法、装置及介质。

背景技术:

1、实体链接旨在将模糊的实体提及链接到已经构建好的知识库中的相关实体,这种将粗略描述的实体提及对齐到知识库中精确描述的实体本身的能力是许多自然语言处理任务,如知识问答、信息抽取、文本分析等重要基础。为了使这种能力更加贴近真实场景中数据多源异构的特点,更有挑战性地跨领域实体链接任务被提出,它在多个训练领域利用实体提及对进行训练,鉴别真实实体,并在多个完全不同的测试领域测试实体链接的领域泛化性能和鉴别实体的能力。

2、目前,现有的跨领域实体链接方法注重多任务学习互补能力和负采样带来的鉴别真实实体的能力,但它们面临着诸多挑战:1)多任务学习互补表示中,往往存在多任务融合交互不足的问题;2)负采样方法针对鉴别真实实体的能力进行了改良,但同时引入了许多无关数据,从而带来了巨大的计算开销。因此,现有技术难以取得令人满意的效果。

3、针对现有技术中存在的上述问题,本发明结合多任务学习和负采样方法的特点,设计了一种基于多任务学习和锚定点采样方法的跨领域实体链接框架,并在广泛使用的跨领域实体链接数据集上进行了大量实验,在客观评价指标上取得了更好的效果,超过以前的最优模型。

技术实现思路

1、本发明是为了解决上述现有技术存在的不足之处,提出一种基于多任务负采样的跨领域实体链接方法、装置及介质,利用多任务学习和负采样方式,将在训练领域所获得的鉴别实体的能力迁移到不同的测试领域上,从而得到跨领域实体链接的最佳泛化性能。

2、本发明为达到上述发明目的,采用如下技术方案:

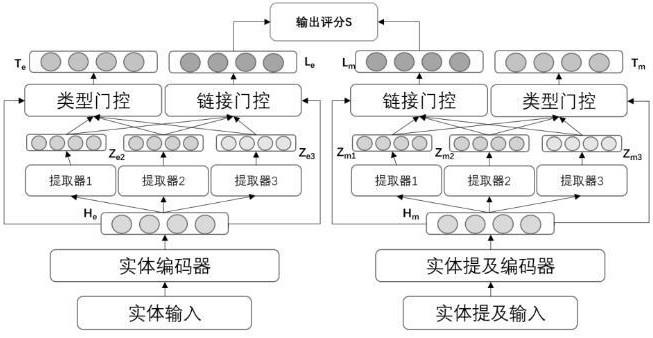

3、第一方面,本发明提供了一种基于多任务负采样的跨领域实体链接方法,该跨领域实体链接方法分为辅助任务阶段、建立多任务学习模型阶段和训练多任务学习模型参数阶段,所述辅助任务阶段选择实体类型预测作为辅助任务,并生成多任务学习阶段辅助任务所需的标签;所述多任务学习模型的主体框架分为锚定点采样模块、底层全局共享模块和高层局部共享模块,锚定点采样模块对训练数据进行锚定点采样,随机选择实体类型相同的实体提及对,并将实体类型与该实体提及对进行绑定,得到锚定点集合后以锚定点集合为单位作为训练数据,送入底层全局共享模块进行训练;所述底层全局共享模块利用文本编码器获取实体和实体提及的文本表征,并将获得的文本表征进行聚合,以分别获得实体和实体提及在底层融合交互的全局特征;高层局部共享模块将底层全局共享模块输出的实体和实体提及的文本表征,生成更细粒度且深层次、用于不同程度任务交互共享的文本表征;所述训练多任务学习模型参数阶段采用辅助任务的训练数据训练类型预测模型,生成多任务的标签,并利用训练配对完成的实体和实体提及训练多任务学习模型中的参数。

4、更进一步地,该基于多任务负采样的跨领域实体链接方法,具体包括以下步骤:

5、s1、在辅助任务阶段中,对输入的实体类型预测的文本数据进行预处理,将实体提及和实体上下文拼接后作为辅助任务训练的输入,训练实体类型预测模型,训练后将实体链接的数据输入,生成对应的实体类型作为后续多任务学习中实体类型预测任务的标签;

6、s2、在建立多任务学习模型阶段中,以实体链接为主任务和以实体类型预测为辅助任务进行多任务学习,依次分为以下步骤:

7、(1)锚定点采样模块在训练数据进行多任务学习前,选取一个先验条件作为标准,将相同条件下的实体划分为一类,然后对于原本的训练数据中实体提及对,根据选取的先验条件随机地选择对应集合中的实体提及对作为负样本对,并且将负样本对与原实体提及对进行静态绑定,得到最终的数据形式作为底层全局共享模块的输入;

8、(2)底层全局共享模块将给定的一个实体和实体提及对利用预训练模型中的多层文本编码器对文本描述进行多粒度、多层次编码,通过注意力机制分别得到融合不同任务的文本全局特征,文本全局特征再融合多个任务对于全局共享和任务特有信息的偏好,同时作为高层局部共享模块的输入;

9、(3)高层局部共享模块利用多个细粒度信息提取器对实体和实体提及的底层特征进行深层次提取,获得不同程度共享和特有的多任务融合交互特征,然后利用任务特性将底层全局共享模块输出的文本全局特征送入每个任务的门控网络,从而获取不同任务对不同程度共享和私有的偏好,实现底层与高层次的深度融合交互,最后将偏好与对应的细粒度信息提取器所获得的表征进行聚合,获得高层的细粒度任务共享交互表征;

10、s3、在训练多任务学习模型参数阶段中,多任务学习模型的训练利用交叉熵损失训练实体链接任务、二分类交叉熵损失训练实体类型预测任务,并使用随机梯度下降算法以更新模型参数。

11、更进一步地,所述步骤s1中,将一个实体提及和相应的上下文信息拼接后送入预训练的编码器,编码器选择预训练模型bert和软提示,经过分类器后再与标签计算损失,得到训练完成的类型生成模型,将实体链接数据中的实体送入,得到所有实体的类型标签。

12、更进一步地,所述锚定点集合中的每个样本对,对于每个样本对自身均为正样本对,当计算损失时,同一个批次中所有样本对互为负样本对。

13、更进一步地,所述建立多任务学习模型阶段的具体实施步骤如下:

14、(1)所述锚定点采样模块对于一个实体提及对,先选择先验标准为实体类型和实体领域,从相同实体类型或者实体领域的实体提及对集合中随机选择个锚定点样本,构成锚定点集合,表示为:,再以锚定点集合为基本单位作为训练数据送入底层全局共享模块进行训练;

15、(2)所述底层全局共享模块对于锚定点集合中的一个实体提及对,先将实体提及和实体上下文拼接,实体名称和描述进行拼接得到输入,分别表示为:,,然后将分别送入实体和实体提及的预训练模型bert中提取文本语义特征,得到序列化的底层全局共享表征,分别表示为:,,作为高层局部共享模块深度共享交互的输入;

16、(3)所述高层局部共享模块对于经过底层全局共享模块得到的共享表征,将三个单层的transformer编码器作为提取器,从底层共享表征中得到不同的局部细粒度信息表征,分别表示为:

17、,建模不同任务对局部信息的共享交互,将底层共享信息送入多个由线性层和归一化层组成的门控网络,得到不同任务对不同的局部细粒度信息表征的权重,然后将对应的权重和特征进行点乘相加,得到不同任务的高层共享特征,将每个任务得到的高层共享特征和底层共享特征分别进行对应拼接,得到最终的高层共享特征,然后分别送入不同的优化目标,分别表示为:,其中,表示拼接操作。

18、更进一步地,对于辅助任务的实体类型预测,具体是将最终的高层共享特征送入分类器得到,然后分别与标签进行计算损失函数,得到类型的优化结果,两个损失函数分别表示为:,,其中表示实体类别数量,表示第个标签预测值,表示实体提及对中实体输入文本编码器得到的结果,表示实体提及对中提及输入文本编码器得到的结果;对于主任务实体链接,具体是将最终的高层共享特征计算评分函数,表示为:,通过交叉熵损失函数优化实体链接任务,表示为:,其中表示每个批次采样的数据大小;最后将辅助任务和主任务的损失函数合并,得到联合训练函数,表示为:=,其中,为两个任务损失函数的权重,用于衡量任务重要性以及平衡多个任务的不同的收敛速度和数值规模。

19、更进一步地,在多任务学习模型的训练过程中,使用随机梯度下降算法优化由交叉熵损失函数、二分类交叉熵损失函数所组成的多任务联合损失,使用的优化器为随机梯度下降优化器,且反向传播优化参数。

20、更进一步地,所述随机梯度下降优化器每个批次的大小为128,初始学习率设置为0.00002,负采样的个数为3。

21、第二方面,本发明提供了一种跨领域实体链接装置,包括存储器以及处理器,存储器存储有计算机可执行指令,处理器被配置为运行所述计算机可执行指令,所述计算机可执行指令被所述处理器运行时实现所述的基于多任务负采样的跨领域实体链接方法。

22、第三方面,本发明提供了一种计算机可读存储介质,计算机可读存储介质上存储有计算机程序,所述计算机程序被处理器运行时实现所述的基于多任务负采样的跨领域实体链接方法。

23、与现有技术相比,本发明的有益效果在于:

24、本发明的多任务学习模型的主体框架分为锚定点采样模块、底层全局共享模块和高层局部共享模块,在训练数据进行多任务学习之前,锚定点采样模块利用负采样方式提升鉴别真实实体的能力,同时利用条件数据分布的多样性,提升跨领域能力。底层全局共享模块利用文本编码器获取实体和实体提及的文本表征,将获得的表征进行聚合,以分别获得实体和实体提及在底层融合交互的全局特征。高层局部共享模块对输出的实体和实体提及的表征,生成更细粒度且更深层次的、可用于不同程度任务交互共享的文本表征。本发明通过利用多任务学习的互补表示,同时充分利用不同粗细粒度的信息交互,以及不同任务间的信息交互共享,并考虑到负采样方式带来的鉴别真实实体的能力和计算开销的平衡,因此在跨领域实体链接上取得了较好效果。

25、本发明可以采用辅助任务的训练数据训练类型预测模型,生成多任务的标签,并用训练领域已经配对好的实体和实体提及去训练多任务框架中的参数。当模型参数训练完毕,可以在完全不同的测试领域进行实体链接的检测,从而验证该框架的跨领域性能。本发明利用多任务学习和负采样方式,将在训练领域所获得的鉴别实体的能力迁移到不同的测试领域上,从而得到跨领域实体链接的最佳泛化性能。本发明可以充分利用已有数据学习出效果良好的跨领域实体链接模型,达到实体链接跨领域的最好结果。

- 还没有人留言评论。精彩留言会获得点赞!