基于多源视频数据融合的船舰目标识别与追踪方法

本发明属于目标识别,具体涉及一种基于多源视频数据融合的船舰目标识别与追踪方法。

背景技术:

1、随着卫星和遥感技术的不断发展,20世纪70年代,卫星遥感技术被越来越多地应用到航空拍摄中,成为应用最广泛的一种航空测量技术。目前,卫星遥感技术已经成为军事侦察、海洋监控、气象观测等领域必不可少的工具。海上作业有很大的风险,利用卫星成像技术和人工智能技术加强对海洋的观测,实现海上舰船快速且有效识别目标,是海洋战略布局的一项重要技术,有助于提高海上作业效率和预测预警的能力,但是海上天气复杂多变,容易形成云雾、海浪等的遮挡,对目标捕捉以后后续识别、追踪造成影响。

2、视频中包含着丰富的目标信息,常见的视频包括热红外视频和可见光视频。可见光视频通常具有丰富的纹理;而目标可能由于伪装而不清晰,包括隐藏在海上的大雾中、夜晚黑暗条件下等;在这种情况下,目标看不清楚。红外视频在低频分量中表示,可以看到隐藏的目标;而红外视频通常缺乏纹理。由于可见光和热红外视频具有不同的互补优势,因此可以融合可见光和热红外视频,提高整体感知质量。然而,在不同天气条件下拍摄的可见光视频(例如,在雾天或夜间)可能表现出不同的特征,热红外视频很容易受到环境温度变化的影响;这种对环境条件的敏感性使得可见光和热红外视频的融合成为一个挑战。除此之外还有遥感、多光谱等不同类型的视频数据,因此多源视频融合是一个很重要的问题。

3、一个视频通常包含许多具有不同类型特征的区域,例如时间运动目标和空间几何特征。如果将这些静态图像融合规则通过简单的扩展应用到视频融合中,源视频中具有不同类型特征的所有区域都将被平等对待,这将在一定程度上降低时空一致性。目前提出的视频融合的方法主要分为两类,分别是基于视频的融合方法和基于帧的融合方法。

4、由于视频与图像的特殊关系,视频一般采用静态图像融合算法逐帧融合。现有基于帧的融合方法的重点是保留图像的细节,并最大限度地提高源的纹理。基于视频的方法中,现有方法提出了三维非分离多尺度变换(mst)工具,如三维曲面小波变换(st)、双树复小波变换和均匀离散曲线变换(udct)。利用这些3d-mst工具,开发了视频融合的新方法。然而,这些3d变换具有很高的计算复杂度,并且需要整个视频的完整信息,这仅适用于离线应用。

5、在基于帧的方法中,两个视频逐帧融合,可以在空间域或变换域进行融合,有人使用遗传算法进行自适应融合,但遗传算法需要多次迭代,因此效率低下。还有考虑到时间复杂度,以及使用引导滤波器的图像融合方法。但是这些算法忽略了不同类型视频帧之间的差异,容易造成信息丢失,影响融合结果的全局性能。

6、因此,现有算法没有充分考虑到在不同环境条件下获取的不同类型的视频的不同特征,对它们采用相同的处理方法,这种基于单帧的融合算法只考虑了输入视频的空间信息,浪费了输入视频中丰富的时间信息,并且时空一致性较低。

技术实现思路

1、为了解决现有技术中存在的上述问题,本发明提供了一种基于多源视频数据融合的船舰目标识别与追踪方法。本发明要解决的技术问题通过以下技术方案实现:

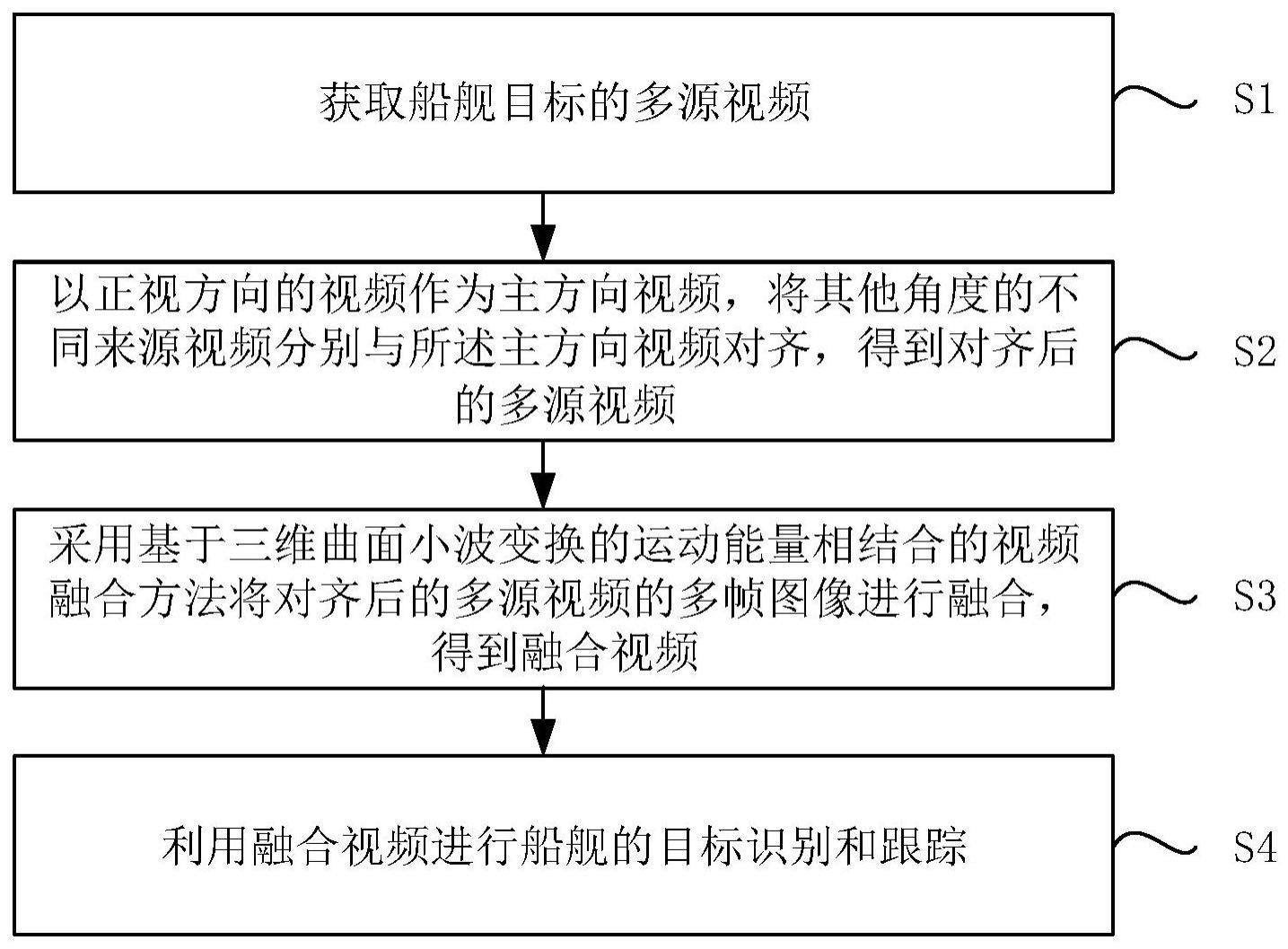

2、本发明实施例提供了一种基于多源视频数据融合的船舰目标识别与追踪方法,包括步骤:

3、获取船舰目标的多源视频;

4、以正视方向的视频作为主方向视频,将其他角度的不同来源视频分别与所述主方向视频对齐,得到对齐后的多源视频;

5、采用基于三维曲面小波变换的运动能量相结合的视频融合方法将所述对齐后的多源视频的多帧图像进行融合,得到融合视频;

6、利用所述融合视频进行船舰的目标识别和跟踪。

7、在本发明的一个实施例中,以正视方向的视频作为主方向视频,将其他角度的不同来源视频分别与所述主方向视频对齐,得到对齐后的多源视频,包括:

8、检测和跟踪所述多源视频中目标的特征点,构造若干特征轨迹;

9、估计每个所述特征轨迹的基本属性;

10、基于所述基本属性构造轨迹间初步匹配的初始表;

11、从所述初始表中选择选择一对目标轨迹,并计算所述目标轨迹间的误差函数,获取所述误差函数最小化时的候选参数向量,重复该步骤若干次,得到若干候选参数向量;

12、从所述若干候选参数向量中选取得分最高的候选参数向量作为目标参数;

13、以正视方向的视频作为主方向视频,利用所述目标参数将其他角度的不同来源视频分别与所述主方向视频对齐,得到对齐后的多源视频。

14、在本发明的一个实施例中,所述基本属性包括动态属性、空间属性、形状属性中的一种或多种。

15、在本发明的一个实施例中,所述误差函数的计算公式为:

16、

17、其中,[t0,...,tn]为时空轨迹γ的时间支撑,为时空点在时间t下的空间位置,为时间t′=s·t+δt时时空点在另一序列中的空间位置,s为两个相机的帧速率之间的比率,δt为未知参数;

18、所述候选参数向量的计算公式为:

19、

20、其中,γ为主方向视频中所有轨迹的集合,d(·)是disth(·)或distf(·),对于三维情况,为误差度量,distf(l,q)是点q和极线l之间以像素为单位的距离,f为3d情况下的基本矩阵。

21、在本发明的一个实施例中,采用基于三维曲面小波变换的运动能量相结合的视频融合方法将所述对齐后的多源视频的多帧图像进行融合,得到融合视频,包括:

22、采用三维曲面小波变换方法将对齐后的每个视频分解成不同尺度和方向的子带,所述不同尺度和方向的子带包括带通方向子带和低通方向子带;

23、采用基于st运动的多源视频融合方法融合带通方向子带系数,得到带通方向子带融合系数,并利用所述带通方向子带融合系数对所述对齐后的多源视频进行融合,得到带通方向融合视频;

24、在st域中逐帧合并低通方向子带系数,得到低通方向子带融合系数,并利用所述低通方向子带融合系数对所述对齐后的多源视频进行融合,得到子带方向融合视频;

25、对所述带通方向融合视频和所述子带方向融合视频进行逆3d-st重构,得到所述融合视频。

26、在本发明的一个实施例中,采用基于st运动的多源视频融合方法融合带通方向子带系数,得到带通方向子带融合系数,包括步骤:

27、利用改进的st域z-score方法,结合所述带通方向子带系数将所述对齐后的多源视频中每帧视频的时间运动信息和空间几何信息区分开,得到运动检测图;

28、根据所述运动检测图,将所述对齐后的多源视频的每个带通方向子带分割为第一区域、第二区域和第三区域,其中,所述第一区域表示在一个视频中检测到运动信息,所述第二区域表示在至少2个视频中检测到运动信息,所述第三区域表示所有视频均检测不到运动信息;

29、根据所述第一区域、第二区域和第三区域中检测到运动信息的视频数量融合带通方向子带系数,得到不同区域的带通方向子带融合系数。

30、在本发明的一个实施例中,利用改进的st域z-score方法,结合所述带通方向子带系数将所述对齐后的多源视频中每帧视频的时间运动信息和空间几何信息区分开,得到运动检测图,包括:

31、在固定的尺度和子方向,利用视频的带通方向子带系数的时间变化判断当前帧中是否存在运动物体;其中,所述带通方向子带系数的时间变化为:

32、δ(s,j,k)(x,y,t)=y(s,j,k)(x,y,t+1)-y(s,j,k)(x,y,t)

33、其中,s为尺度,(j,k)为子方向,y(s,j,k)(x,y,t)为st带通方向子带系数,t为时间维度,(x,y)为空间位置;

34、当所述带当前帧中存在运动物体,利用修正后的z-score方法对每个子带的所述运动物体进行两次运动检测,得到运动检测图:

35、

36、

37、

38、其中,是当前帧t沿x和y维度的δ(s,j,k)(x,y,t)的中位数,mad(s,j,k)(t)为绝对偏差中位数,β为预定义的实验阈值,z(s,j,k)(x,y,t)为修正后的z-score。

39、在本发明的一个实施例中,所述第一区域、第二区域和第三区域的定义为:

40、

41、其中,为运动映射,区域表示在一个视频vm中检测到运动信息,表示多个或全部视频中检测到运动信息,表示所有视频中未检测到运动信息,vm表示输入的视频,m∈1,2,...,n,n表示输入视频的总个数。

42、在本发明的一个实施例中,根据所述第一区域、第二区域和第三区域中检测到运动信息的视频数量融合带通方向子带系数,得到不同区域的带通方向子带融合系数,包括:

43、对于所述第一区域,带通方向子带融合系数取检测到运动信息的视频的带通方向子带系数:

44、

45、对于所述第二区域,选取运动信息显著的系数作为带通方向子带融合系数:

46、

47、其中,为运动显著性,定义为:

48、

49、其中,ks,j表示第s个尺度和第j个沙漏分支的总方向数,t1为局部帧号,τ表示时间变化量。

50、对于所述第三区域,采用基于时空能量匹配的融合规则融合带通方向子带系数,得到所述第三区域的带通方向子带融合系数。

51、在本发明的一个实施例中,对于所述第三区域,采用基于时空能量匹配的融合规则融合带通方向子带系数,得到所述第三区域的带通方向子带融合系数,包括:

52、对每个尺度、方向和空间位置分别计算每个视频的st带通方向子带系数沿时间维度的平均值,得到平均值:

53、

54、其中,t(s,j,k)表示当前子带包含的帧数,表示每个视频的st带通方向子带系数,t为时间纬度,s为尺度,(j,k)为子方向,(x,y)为空间位置;

55、根据所述平均值,计算每个视频中以所述空间位置为中心的局部空间区域的能量:

56、

57、其中,a1×b1为局部空间区域的大小;

58、计算多个视频的能量之间的相似性:

59、

60、其中,vc表示多个视频;

61、对于当前子带中的每一帧,根据所述相似性与自适应阈值之间的比较结果确定所述第三区域的带通方向子带融合系数:

62、

63、其中,为局部权重,m∈(1,n),γ(s,j,k)为自适应阈值,表示视频能量最大时该视频的带通方向子带系数,表示最大的视频能量。

64、与现有技术相比,本发明的有益效果:

65、本发明采用基于三维曲面小波变换的运动能量相结合的视频融合方法对对齐后的多源视频进行融合;基于运动的融合规则对时间运动目标区域进行独立检测和融合,具有较高的时间稳定性和一致性,可用于实时融合,计算效率较高;基于能量的融合规则,用三维曲面小波变换的运动选择性,采用基于时空区域能量的融合规则从输入视频中提取时空信息,有很好的时空信息提取能力,并且可以抑制噪声;将两种算法结合起来,同时考虑到时间信息和空间信息,不仅获得较好的空间信息提取能力,同时在时间稳定性和一致性方面取得了很好的效果,从而达到了更好的融合效果,提高了视频质量,使得船舰能够高效准确的识别周边目标,有利于对舰船及时作出后续追踪等航行行为的判断。

- 还没有人留言评论。精彩留言会获得点赞!