一种基于几何拼接的宽基线图像新视点合成方法

本发明涉及一种新视点合成方法,特别涉及一种基于几何拼接的宽基线图像新视点合成方法,属于三维重建。

背景技术:

1、新视点合成(new view synthesis)是一种可以从一组已知视角的图像中合成新的视角图像的技术。这种技术可以高效地完成虚拟3d内容生成,并通过多个维度的新视点探索三维场景。六自由度(6-dof)是指用户在探索3d内容时除了具备在x、y、z三轴上旋转的能力(3-dof)之外,也具备在x、y、z三轴上移动的能力。然而,目前的新视点合成技术为了保证合成图像质量,往往需要密集视点的窄基线数据从而导致合成效率低下,且只能实现3-dof的新视点合成,这种观看体验可能会引发一些用户感到晕动症,甚至恶心。

2、对于新视点合成这一具有较高应用价值问题,国内外的学者已经做了大量的基础研究。常用的新视点合成方法主要包括四种:基于三维重建的方法、基于分层图像的方法、基于隐式表示的方法和基于变形的方法。基于三维重建的方法,以基于增量式运动恢复结构重建为代表,根据重建出来的显式几何场景从新视点渲染图像。但是该方法需要足够密集的图像序列作为输入从而导致重建效率低下,且传统三维重建单独步骤过多,算法鲁棒性差。基于分层图像的方法,以多平面图像为代表,以固定层数的多层图像作为三维场景表示,通过α合成从新视点生成最终的新视点图像。该方法可以实现稀疏视点的新视点合成,但是固定分层表示对三维空间的表达能力有限,无法准确描述宽基线场景,且6-dof的新视点合成效果较差。基于隐式表示的方法,以神经辐射场为代表,使用具有多层感知器(mlp)的5d辐射场构建三维场景表示,借助5d辐射函数提取新视点图像。该方法可以提供高质量的6-dof新视点合成结果,但同样需要足够密集的图像序列作为输入且训练开销大,泛化性不足。基于扭曲的方法,以基于深度图的图像绘制为代表,从包含深度信息的参考图像来绘制新视点下的目标图像。这种方法虽然可以在稀疏图像数据上完成6-dof新视点的图像生成,但是在面对基线较大数据时,生成的图像会由于场景遮挡关系产生较大的孔洞。

技术实现思路

1、针对密集图像输入生成新视点图像效率低、宽基线图像新视点合成效果差的问题,本发明的主要目的是提出一种基于几何拼接的宽基线图像新视点合成方法,通过将宽基线rgb图像重建的两个网格拼接为一个整体作为三维场景表示,从几何层面提高由于场景遮挡导致的孔洞的填补效果,并通过学习的方法实现用稀疏图像高效生成高质量新视点图像,提高虚拟3d内容生成的效率,提高用户观看体验的舒适度。

2、本发明的目的是通过如下技术方案实现的:

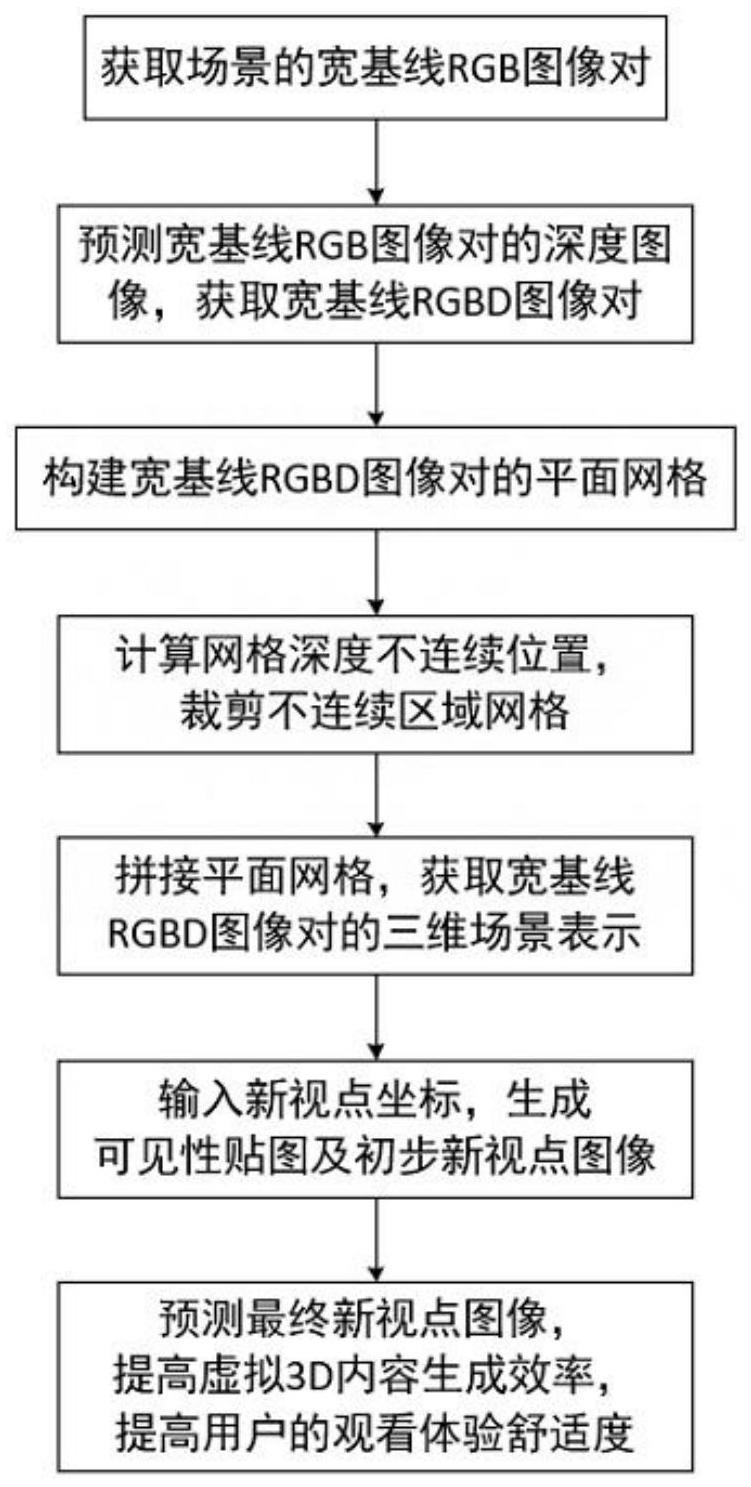

3、本发明公开的一种基于几何拼接的宽基线图像新视点合成方法,首先为获取的宽基线rgb图像对生成深度图像;接着借助宽基线rgbd图像对为每组rgbd图像创建一个平面网格;然后裁剪掉对应深度图像中深度不连续区域的三角形网格;并基于宽基线rgbd图像对的相对位置关系将二者拼接为一个整体网格,作为三维场景表示;之后输入新视点坐标,使用扭曲算法从新视点渲染三维场景表示的rgb图像和深度图像;接着提取渲染出的深度图像中负值的区域作为可见性贴图;最后根据渲染出的rgb图像和可见性贴图得到6-dof新视点图像。提高虚拟3d内容生成的效率,提高用户观看体验的舒适度。

4、本发明公开的一种基于几何拼接的宽基线图像新视点合成方法,具体实现步骤如下:

5、步骤一、获取场景的宽基线rgb图像对;

6、从三维场景数据集中获取或者使用特制双目相机采集一对基线为0.4m-0.6m且具有相同时间戳的宽基线rgb图像,以及图像对应的相机内参、外参的真实值。从三维场景数据集中和双目立体匹配数据集中,获取立体rgb图像对及其视差图,用于双目立体匹配网络训练;

7、步骤二、预测宽基线rgb图像对的深度图像,获取宽基线rgbd图像对;

8、对立体rgb图像对进行特征提取,得到左右两幅图像的特征表示。计算左右特征图之间的代价,构建代价体积。预测每个像素代价最小的视差值,并使用3d卷积神经网络后接transformer递归层模型的结构对视差进行细化,其形式化表示为:

9、lz=(1-λ)ld+λ·le

10、其中,lz表示立体匹配损失值,ld表示视差损失,le表示边缘损失,λ表示权重。不断迭代,直至损失值稳定,得到双目立体匹配网络权重。根据网络权重,输入宽基线rgb图像对,预测宽基线视差图。根据视差图计算深度图,得到宽基线rgbd图像对,其形式化表示为:

11、

12、其中,z为深度值,b为基线大小,f为相机焦距,d为视差值;

13、步骤三、根据步骤二得到的宽基线rgbd图像对,为每组rgbd图像创建一个平面网格,将每个网格的顶点偏移到正确的深度,并赋予正确的rgb值,构建宽基线rgbd图像对的平面网格;

14、步骤四、计算宽基线深度图像对沿x轴和y轴方向的梯度,得到dx和dy的梯度图像。将梯度值大于阈值k的区域视为深度不连续区域,并裁剪网格中深度不连续部分的三角形;

15、步骤五、拼接平面网格,获取宽基线rgbd图像对的三维场景表示;

16、利用宽基线rgbd图像对的相机内参、相机外参,计算宽基线rgbd图像对的平面网格的相对位置。根据相对位置关系,将重建出的两个网格在同一世界坐标系下拼接为一个整体网格,作为宽基线rgbd图像对的三维场景表示;

17、步骤六、输入新视点坐标,生成可见性贴图及初步新视点图像;

18、根据宽基线rgbd图像对的相机内参、相机外参和新视点坐标建立单应性变换矩阵,根据矩阵使用扭曲算法从新视点渲染三维场景表示的rgb图像和深度图像。其中,rgb图像作为初步新视点图像,提取深度图像中负值的区域作为可见性贴图;

19、步骤七、预测最终新视点图像,提高虚拟3d内容生成的效率,提高用户观看体验的舒适度。

20、根据初步新视点图像和可见性贴图,预测最终的新视点图像,并通过损失函数对预测值与真实值拟合:

21、ln=||pgt-ppre||1

22、其中,ln表示新视点合成损失,pgt表示真实新视点图像,ppre表示预测新视点图像,使用l1损失进行监督;

23、不断迭代,直至损失值稳定,得到优化网络权重。根据网络权重,输入初步新视点图像和可见性贴图,预测最终新视点图像。

24、有益效果:

25、本发明方法,对比现有技术,具有以下优点:

26、1、现有的基于扭曲算法的新视点合成方法中,深度图像使用基于立体视觉的深度估计方法获取或者基于深度传感器获取,这些方法无法处理具有较大视差的场景,即宽基线数据,获取到的深度图往往会出现严重的伪影或明显的错误视差估计,这样生成出的深度图质量不高,从而导致后续步骤中网格重建误差较大。本发明公开的一种基于几何拼接的宽基线图像新视点合成方法,基于损失函数中的边缘约束项减轻边缘模糊;通过transformer递归层模型,建立长距离的上下文关系,扩大视差的搜索范围;使用宽基线数据训练增强模型,大幅提高预测的宽基线数据的深度图质量及后续网格重建的质量。

27、2、现有的基于扭曲算法的新视点合成方法中,往往通过单组rgbd图像生成点云的三维场景表示,再扭曲到目标视点生成新视点图像。但是当新视点位置距离输入视点位置较远时,单组rgbd图像生成的三维场景表示信息过于欠缺,通过扭曲算法生成的新视点图像会出现大面积的孔洞。本发明公开的一种基于几何拼接的宽基线图像新视点合成方法,通过重建左右两个视点的网格,根据宽基线图像的相对位置将两个网格拼接为整体网格作为三维场景表示,从几何层面填补一定面积的孔洞,提高宽基线数据通过扭曲算法生成的初步新视点图像的质量。

28、3、现有的基于扭曲算法的新视点合成方法中,往往使用线性插值的方法填补由于场景遮挡关系造成的孔洞。然而对于宽基线数据,新视点位置距离输入视点位置较远时,产生较大视差,扭曲造成的孔洞较大,从而线性插值的方法效果差,新视点图像会存在严重的伪影。本发明公开的一种基于几何拼接的宽基线图像新视点合成方法,基于提取渲染三维场景表示的深度图像中负值的区域得到可见性贴图作为孔洞的先验信息,与最初渲染的带有孔洞的新视点图像,通过神经网络并用海量数据学习,生成的高质量的宽基线6-dof新视点图像,提高虚拟3d内容生成的效率和用户观看体验的舒适度。

- 还没有人留言评论。精彩留言会获得点赞!