一种虚拟人物表情驱动方法与流程

本发明涉及人脸识别与驱动,尤其涉及一种虚拟人物表情驱动方法。

背景技术:

1、随着数字技术的发展,动漫行业已经成为多元化、综合化的产业,涵盖电影、电视、游戏、广告等多个领域。目前,动漫行业已经成为世界上最具活力和竞争力的产业之一,市场规模和影响力不断扩大。

2、未来动漫行业的发展趋势不仅要求动画内容更加丰富和深入,而且为了满足不同观众的需要,也要求动画的技术水平更高,虚拟人物的表情变化更加真实细腻。

3、中国专利公开号:cn115601484b公开了一种虚拟人物面部驱动方法、装置、终端设备和可读存储介质,其中方法包括获取用户的面部图像,对面部图像进行人脸关键点检测,得到用户人脸关键点;对用户人脸关键点进行平滑处理;对平滑处理后的用户人脸关键点与标准人脸关键点采用最小二乘法进行对齐处理,得到对齐后的人脸关键点矩阵;对对齐后的人脸关键点矩阵按照人脸部位进行划分,得到各部位关键点矩阵;对各表情基按照人脸部位进行划分,得到各部位表情基矩阵;将各部位表情基矩阵输入到对应的部位关键点矩阵进行稀疏编码,计算出各编码系数;采用各编码系数来驱动虚拟人物面部。

4、然而,现有技术中,虚拟人物的表情变化较为僵硬,精细化程度不足。

技术实现思路

1、为此,本发明提供一种虚拟人物表情驱动方法,用以克服现有技术中虚拟人物的表情变化较为僵硬,精细化程度不足的问题。

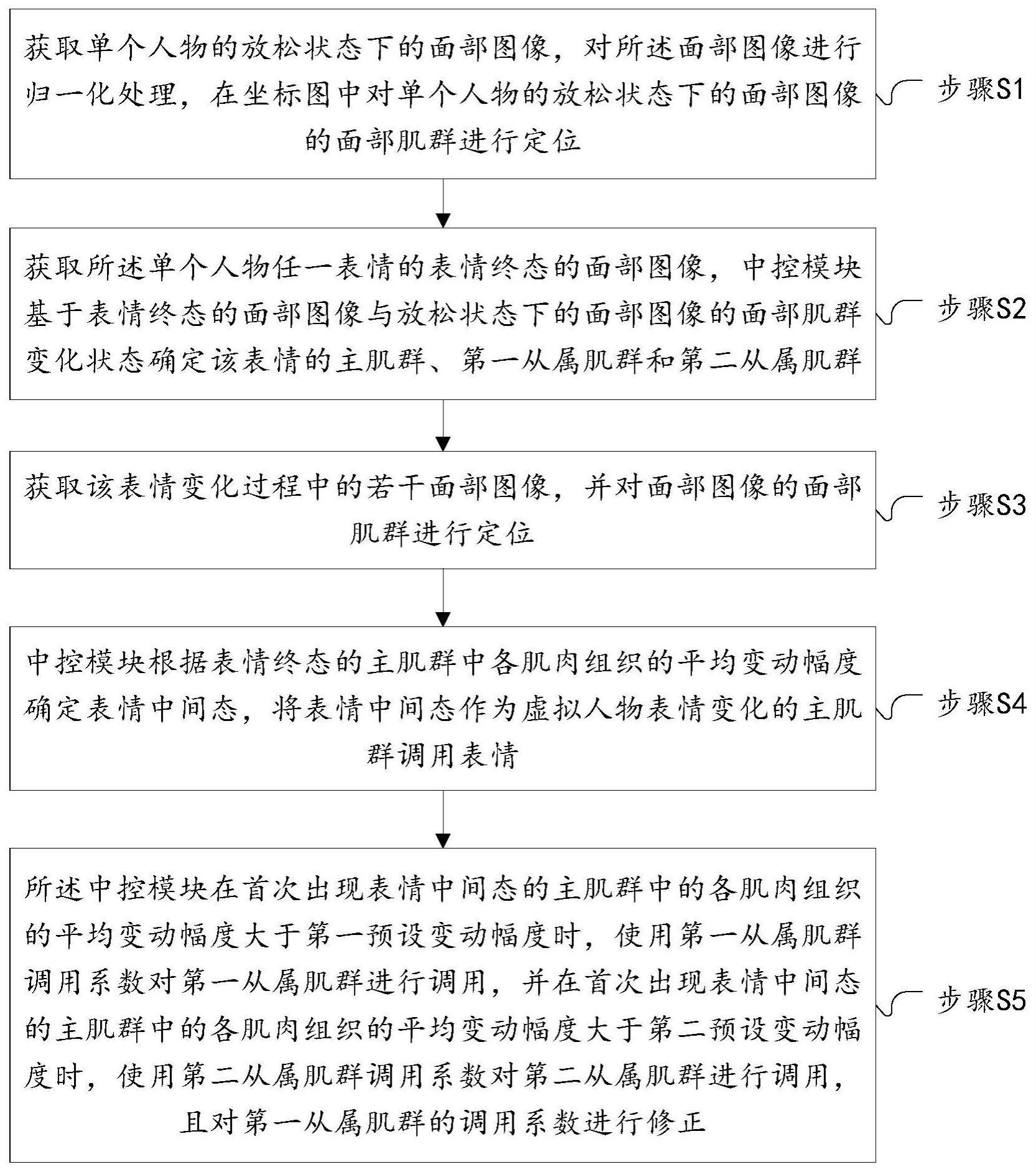

2、为实现上述目的,本发明提供一种虚拟人物表情驱动方法,包括:

3、步骤s1,获取单个人物的放松状态下的面部图像,对所述面部图像进行归一化处理,在坐标图中对单个人物的放松状态下的面部图像的面部肌群进行定位;

4、步骤s2,获取所述单个人物任一表情的表情终态的面部图像,中控模块基于表情终态的面部图像与放松状态下的面部图像的面部肌群变化状态确定该表情的主肌群、第一从属肌群和第二从属肌群;

5、步骤s3,获取该表情变化过程中的若干面部图像,并对面部图像的面部肌群进行定位;

6、步骤s4,中控模块根据表情终态的主肌群中各肌肉组织的平均变动幅度确定表情中间态,将表情中间态作为虚拟人物表情变化的主肌群调用表情;

7、步骤s5,所述中控模块在首次出现表情中间态的主肌群中的各肌肉组织的平均变动幅度大于第一预设变动幅度时,使用第一从属肌群调用系数对第一从属肌群进行调用,并在首次出现表情中间态的主肌群中的各肌肉组织的平均变动幅度大于第二预设变动幅度时,使用第二从属肌群调用系数对第二从属肌群进行调用,且对第一从属肌群的调用系数进行修正。

8、进一步地,在所述步骤s1中,对所述面部图像进行归一化处理的方法包括,将面部图像中的鼻子、左眼和右眼进行连线形成三角区域,以该三角区域的几何中心作为坐标原点,对该三角区域进行缩放处理使处理后的面部图像的三角区域面积与归一化标准面积相同。

9、进一步地,在所述步骤s2中,对于任一表情的表情终态,所述中控模块将表情终态的面部图像与放松状态下的面部图像进行对比,计算表情终态的面部肌群中各肌肉组织的变化部分占比b,设定b=a1/a0,其中,a1为任一肌肉组织坐标发生变化的部分面积,a0为对应的肌肉组织原坐标面积;

10、对存在变化的肌肉组织中,将变化部分占比b进行降序排列,取排列顺序的前1/3对应的肌肉组织作为该表情的主肌群,取排列顺序的中间1/3对应的肌肉组织作为该表情的第一从属肌群,将排列顺序的最后1/3对应的肌肉组织作为该表情的第二从属肌群。

11、进一步地,在所述步骤s3中,包括:

12、步骤s31,针对所述单个人物,获取该人物任一表情的面部变化视频信息;

13、步骤s32,对所述视频信息按照预设间隔进行切片处理,获取若干视频帧,将最后一个视频帧中的面部表情做为所述表情的表情终态;

14、步骤s33,识别所述若干视频帧中的面部图像并进行归一化处理,分别在坐标图中对所述若干视频帧中的面部图像的面部肌群进行定位。

15、进一步地,在所述步骤s32中,在若干所述视频帧中,若存在任一相邻的视频帧中面部图像的主肌群中任一肌肉组织的坐标的变动幅度超过预设变动幅度,所述中控模块根据超出预设变动幅度的大小将预设间隔调小,以提高获取的视频帧中肌群变化的精细程度。

16、进一步地,在所述步骤s4中,表情中间态的确定方法为,所述中控模块计算表情终态中主肌群中各肌肉组织的变动幅度,并根据以下公式计算主肌群中的各肌肉组织的平均变动幅度,设定

17、

18、其中,fi为主肌群中第i个肌肉组织的变动幅度,n为主肌群中包含的肌肉组织的数量。

19、进一步地,所述中控模块中设有预设分界变动幅度ff,所述中控模块计算所述平均变动幅度fp与预设分界变动幅度ff的比值d,设定d=fp/ff,若d≥1,所述中控模块判定将该表情分为若干表情中间态,其中,若d为正整数,则将表情中间态的数量设置为d,若d不为正整数,则将表情中间态的数量设置为小于d的最大正整数,并将任一视频帧中面部图像的主肌群中的各肌肉组织的平均变动幅度达到预设分界变动幅度ff的倍数时对应的视频帧中的面部图像做为一个表情中间态,将表情中间态作为虚拟人物表情变化的主肌群调用表情。

20、进一步地,在所述步骤s5中,所述中控模块顺次将表情中间态的主肌群中的各肌肉组织的平均变动幅度与第一预设变动幅度进行比对,当首次出现表情中间态的平均变动幅度大于第一预设变动幅度时,使用第一从属肌群调用系数对第一从属肌群进行调用;

21、所述第一从属肌群调用系数按照以下公式计算,设定

22、

23、其中,m为第一从属肌群中肌肉组织的数量,n为主肌群中肌肉组织的数量,fc为表情终态的第一从属肌群中各肌肉组织的平均变动幅度,fp为表情终态的主肌群中各肌肉组织的平均变动幅度。

24、进一步地,所述中控模块计算第一从属肌群的单位变动幅度,则在首次出现表情中间态的平均变动幅度大于第一预设变动幅度时调用第一从属肌群,第一从属肌群的变动幅度为第一从属肌群的单位变动幅度×第一从属肌群调用系数,在首次出现表情中间态之后的第i个表情中间态时第一从属肌群的变动幅度为单位变动幅度×第一从属肌群调用系数×i。

25、进一步地,所述中控模块顺次将表情中间态的主肌群中的各肌肉组织的平均变动幅度与第二预设变动幅度进行比对,当首次出现表情中间态的平均变动幅度大于第二预设变动幅度时,使用第二从属肌群调用系数对第二从属肌群进行调用,并对第一从属肌群的调用系数进行修正,所述第二预设变动幅度=2×第一预设变动幅度。

26、与现有技术相比,本发明的有益效果在于,本发明通过将面部肌群划分为主肌群、第一从属肌群和第二从属肌群,根据主肌群的变动幅度确定表情中间态,并在不同的表情中间态调用第一从属肌群和第二从属肌群,通过上述技术方案,提高了对虚拟人物表情的精细化处理,从而使虚拟人物的表情更加生动逼真。

27、进一步地,任一表情的面部变化视频信息动态展示了一个表情从放松状态到表情出现时的肌群变化过程,通过将视频信息进行切片处理,可连续静止的展现处肌群的每一个变化状态,然后根据肌群的变化状态对虚拟人物的表情进行驱动,提高了对虚拟人物表情的精细化处理,从而使虚拟人物的表情更加生动逼真。

28、进一步地,在若干视频帧中,若存在任一相邻的视频帧中的主肌群变动幅度超过预设变动幅度,所述中控模块根据超出预设变动幅度的大小将预设间隔调小,以提高获取的视频帧中肌群变化的精细程度,从而进一步提高对虚拟人物表情的精细化处理,从而使虚拟人物的表情更加生动逼真。

29、进一步地,本发明设定预设分界变动幅度,以计算表情中间态的数量,若平均变动幅度小于预设分界变动幅度,说明该表情的肌群变化程度较小,此时,无需设定表情中间态,从而提高了对虚拟人物表情的驱动效率,若平均变动幅度大于预设分界变动幅度,此时至少可存在一个表情中间态,表情中间态将一个表情分为若干的表示形态,根据肌群的变动程度进行划分,使虚拟人物表达表情时更加精细化,本发明通过设定若干表情中间态,增加了虚拟人物表情的精细程度,从而使虚拟人物的表情更加生动逼真。

30、进一步地,本发明通过对第一从属肌群的调用和第二从属肌群的调用,并在调用第二从属肌群时对第一从属肌群的调用系数进行修正,丰富了虚拟人物的表情细节,增加了虚拟人物表情的精细程度,从而使虚拟人物的表情更加生动逼真。

- 还没有人留言评论。精彩留言会获得点赞!