一种融合分级处理、多尺度及深度学习的计算机视觉三维重建方法

本发明涉及一种二次分级、多尺度融合及深度图优化的三维重建方法,具体是一种融合分级处理、多尺度及深度图优化的三维重建方法。属于计算机视觉、深度学习图像处理领域。

背景技术:

1、mvsnet(multi-view stereo network,多视角立体网络)是一种端到端的三维重建方法,mvsnet主要分为五步,特征提取,构造匹配代价,代价聚合,深度估计,深度图优化。mvsnet将包含重建目标的深度范围按照不同的深度值划分为一个个深度平面,并提出了可微的单应性变换方法,将不同视角下的多个视图变换到同一参考视图视角下,结合双目立体匹配代价聚合的方法,使用3d cnn(three-dimensional convolutional neuralnetworks,三维卷积神经网络):进行代价聚合,并从双目扩展到多视图深度估计,结合多角度扫描原理,将双目的视差匹配代价聚合扩展为多视图在指定深度范围内的代价聚合。

2、但是,目前对mvsnet进行改进的方法主要聚焦于三维重建的效果,没有考虑到多视图深度估计三维重建过程中资源占用率较高造成效率低下以及点云融合度不够等不足,没有侧重效率和精度两方面进行方法设计。权龙的r-mvsnet方法,减小了gpu显存的占用,但缺点是处理效率低下;p-mvsnet方法,相比于原始mvsnet的精度有所改进,但是并没有减小gpu资源的占用率、也没有提高效率;d2hc-rmvsnet方法的主要思想是提出了两个处理模块,提高深度估计的鲁棒性和准确性,但效率较低。

技术实现思路

1、针对当前快速三维重建技术存在处理耗费时间久效率低下、重建过程中资源占用率较高以及点云融合度较低等主要问题,本发明的目的在于提供一种融合分级处理、多尺度及深度图优化的三维重建方法。

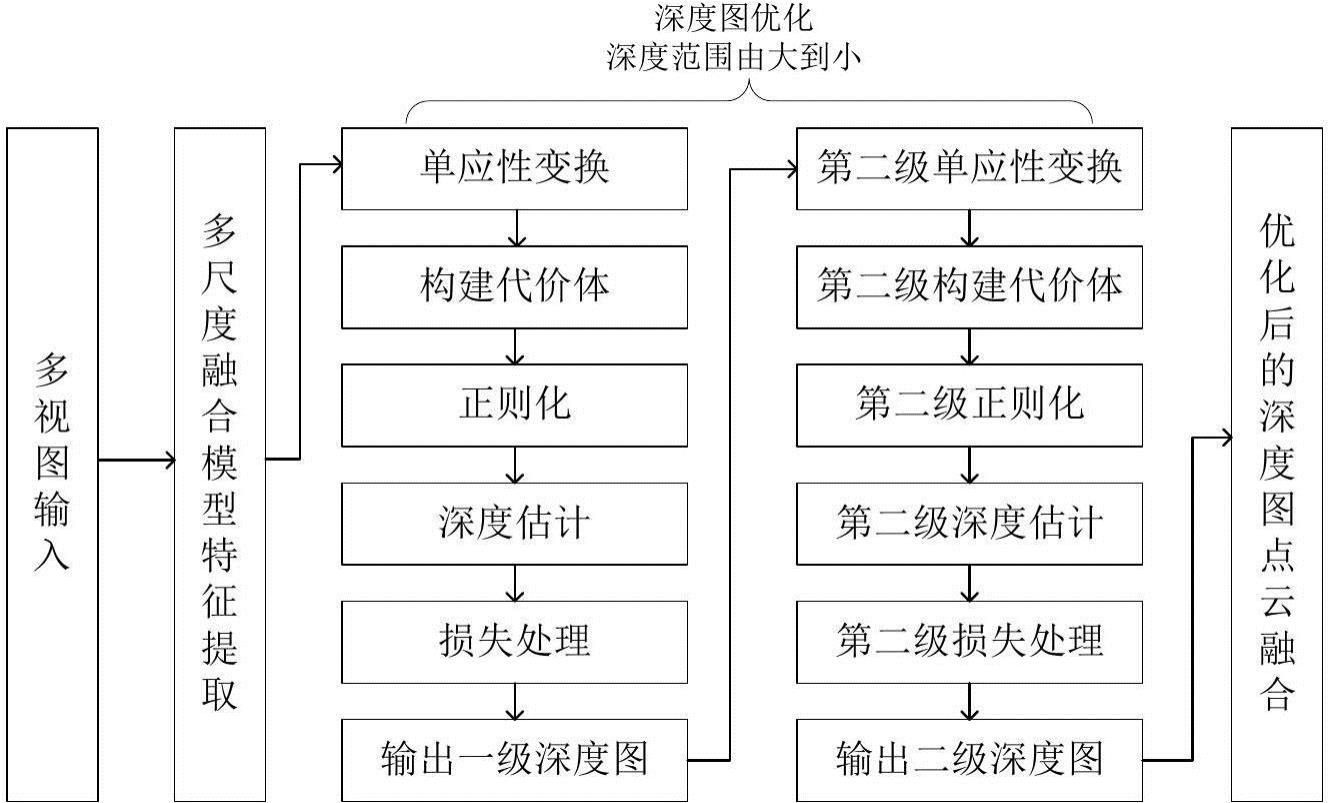

2、本发明的步骤包括:1)利用多尺度融合模型进行特征提取,使用四个不同尺度的数学卷积表达生成多尺度条件下的特征图,更多地融合多尺度的上下文信息,同时不改变原始图像的分辨率大小;2)采用多尺度残差级联网络对初始深度图进行优化,解决深度图不完整等情况;3)基于深度图过滤系统,对步骤2) 经过残差优化后的深度图进行峰值离群点和重投影误差点的过滤;4)进行极线约束、极线搜索,按照像素对应行进行搜索,简化搜索问题,构建容量函数代价体;5)二次分级进行三维重建,设计了一种串行的分级结构,提高深度估计的精确度;6)深度估计及点云融合。

3、所述步骤1)利用多尺度融合模型进行特征提取,使用四个不同尺度的数学卷积表达生成多尺度条件下的特征图,更多地融合多尺度的上下文信息,同时不改变原始图像的分辨率大小,包括以下步骤:①输入1张参考视图和n-1张源视图,首先使用两个3×3大小的卷积来总结局部像素信息;②使用四个具有不同尺度2、3、4、5的卷积核来融合多尺度条件下的上下文信息,不同尺度的输出在特征提取过程中具有同等的地位,每个尺度的特征图都进行三次卷积,加深网络的深度;③使用批处理归一化,然后将多尺度信息关联在一起,得到密集提取的特征图。

4、所述步骤2)构建多尺度残差级联网络对初始深度图进行优化,解决深度图不完整等情况,包括以下步骤:①将四个不同尺度特征图与初始深度图依次串联在一起;②经过第一级残差网络,比较输出结果,若输出效果比较好,就保留该级的残差网络,否则,通过残差网络的优势,直接映射输出,继续从第二级开始进行深度图优化,不断优化;③同样的步骤,继续经过第二级、第三级残差网络,最后输出深度图。

5、所述步骤3)基于深度图过滤系统,对步骤2) 经过残差优化后的深度图进行峰值离群点和重投影误差点的过滤,包括以下步骤:①对峰值离群点进行过滤,计算深度图图像中局部相邻区域内不同像素的深度值,然后进行平滑滤波操作,对峰值离群点加以保留并进行深度值平滑、双线性插值,以便后续融合操作; ②对重投影误差点进行过滤,计算深度重投影误差和坐标重投影误差,若两部分映射的距离在阈值内,则保留该特征点,否则剔除该点,完成深度图优化。

6、所述步骤4)进行极线约束、极线搜索,按照像素对应行进行搜索,简化搜索问题,构建容量函数代价体,包括以下步骤:①计算该物体表面点的最可能深度值;②按照不同的深度大小,从最小深度映射到最大深度,转换到参考视图的不同深度值的视角下,形成n-1个源视图组成的代价体和1个参考视图组成的代价体;③使用双线性插值将n个锥型代价体变成长宽相等的容量函数代价体。

7、所述步骤5)二次分级进行三维重建,设计了一种串行的分级结构,提高深度估计的精确度,包括以下步骤:①第一级设计48个深度平面,从稀疏的深度平面获取粗略的深度图估计范围;②第二级设计48个深度平面,以第一级的深度估计范围为基础,更新深度估计范围,再次进行深度估计,得到更精细的深度图。

8、所述步骤6)深度估计及点云融合,包括以下步骤:①计算已估计深度值附近5个深度值的期望,将不连续、不平滑深度的深度图变得平滑,减小出现深度值突变的情况;②将2d深度图通过坐标系转换,生成3d点云坐标,同时将多视图的rgb强度值和点云坐标映射融合到统一的点云中,融合后的深度图直接重新投影到空间,生成三维点云。

9、与现有技术相比,本发明的积极效果为:

10、1、融合分级多尺度与深度图优化的方案与其方法相比,由于增加了多尺度融合模块,使得多视角立体三维重建的点云数据明显稠密,点云完整度和点云融合后的总体效果得到明显提升。

11、2、相对于已有的三维重建方法,本发明在多视角立体三维重建效率方面显著提高;

12、3、本发明在多视角立体三维重建的精度方面,三维重建点云精确度(acc)数值指标,完整度(comp),总体评价(overall)均得到有效提高,结果验证了本发明的有效性与创新性。

技术特征:

1.一种融合分级处理、多尺度及深度学习的计算机视觉三维重建方法,其步骤包括:

2.如权利要求1所述的方法,其特征在于,构建多尺度融合模型,对源视图进行特征提取的方法为:设和分别表示输入1张参考视图和n-1张源视图。类似于编解码操作,首先使用两个3×3大小的卷积来总结局部像素信息;,其中表示卷积操作,表示为8×1600×1200的卷积,表示为16×1600×1200的卷积,表示多尺度浅层特征图。

3.如权利要求2所述的方法,其特征在于,使用四个具有不同尺度2、3、4、5的卷积核来融合多尺度条件下的上下文信息,每个尺度的特征图都进行三次卷积;,其中表示通过卷积操作加深网络深度之后的特征图;得到密集提取的特征图,包含足够多的特征信息;,其中表示最终处理后所得到的特征图。

4.如权利要求1所述的方法,其特征在于,所述构建多尺度条件下的残差级联网络,对初始深度图进行优化的方法为:将四个不同尺度(5,4,3,2)的2d1_3_2、2d1_2_2、2d1_1_2、2d1_0_2特征图与初始深度图依次串联在一起,多尺度的特征图与残差网络级联,深度图优化模型公式如下:。

5.如权利要求1和4所述的方法,其特征在于,所述基于深度图过滤系统,对经过残差优化后的深度图进行峰值离群点及重投误差点进行过滤;设置两个阈值,如果坐标重投影和深度重投影满足公式以及公式,则可认为像素点的深度估计无重投影误差的。

6.如权利要求1和5所述的方法,其特征在于基于深度图过滤系统,所述重投影误差点过滤的方法为:对重投影误差点进行过滤,在输入图像之间,深度重投影误差和坐标重投影误差,若两部分映射的距离在阈值内,则保留该特征点,否则剔除该点,完成深度图优化。

7.如权利要求1所述的方法,其特征在于,进行极线约束、极线搜索,按照像素对应行进行搜索,构建容量代价体的方法为:计算该物体表面点的最可能深度值;任意选取一张图像为参考视图,以参考图像的视角作为多角度扫描方向,将所有参考视图、源视图的特征图通过单应性变换,按照不同的深度大小,从最小深度映射到最大深度,转换到参考视图的不同深度值的视角下,形成n-1个源视图组成的代价体和1个参考视图组成的代价体;③使用双线性插值将n个锥型代价体变成长宽相等的容量代价体。

8.如权利要求1所述的方法,其特征在于,设计一种串行的分级结构,完成深度估计及点云融合,第一级设计48个深度平面,从稀疏的深度平面获取粗略的深度图估计范围,第二级设计48个深度平面,以第一级的深度估计范围为基础,更新深度估计范围,再次进行深度估计,得到更精细的深度图。

9.如权利要求1和8所述所述,其特征在于,计算概率值最大的深度两侧相邻两个深度范围的数学期望,将2d深度图通过坐标系转换,生成3d点云坐标,生成三维点云。

技术总结

本发明公开了一种融合分级处理、多尺度及深度学习的计算机视觉三维重建方法,其步骤包括:1)利用多尺度融合模型进行特征提取,使用四个不同尺度的数学卷积表达来生成多尺度条件下的特征图;2)构建多尺度残差级联网络对初始深度图进行优化;3)基于深度图过滤系统,对步骤2)经过残差优化后的深度图进行峰值离群点和重投影误差点的过滤;4)进行极线约束、极线搜索,按照像素对应行进行搜索,简化搜索问题,构建容量函数代价体;5)二次分级进行三维重建,设计了一种串行的分级结构,提高深度估计的精确度;6)完成深度估计及点云融合。本发明使得多视角立体三维重建效率方面显著提高,三维重建的点云数据明显稠密,点云完整度和点云融合后的总体效果得到明显提升。

技术研发人员:赵海盟,杨鹏,薛乐堂,李双,焦健楠,王强,胡高美,张慧敏

受保护的技术使用者:桂林航天工业学院

技术研发日:

技术公布日:2024/1/15

- 还没有人留言评论。精彩留言会获得点赞!