一种无人机多目标长期追踪方法与流程

本发明属于目标跟踪,尤其涉及一种无人机多目标长期追踪方法。

背景技术:

1、多目标跟踪在最近十几年发展迅速,早期比较典型的方法有meanshift(均值偏移)和粒子滤波等方法,但整体精度比较低,且为单目标跟踪为主。随着检测目标的精度不断提升,出现了基于检测的跟踪框架,像sort、deepsort、bytetrack、botsort都是典型算法。

2、基于检测的跟踪框架流程主要分为检测和匹配两部分,但是由于框架的灵活性,检测部分可以随着目标检测算法的发展而不断更新,检测的结果也影响后续匹配过程准确性。sort算法是检测跟踪中最初始经典算法,匹配过程的核心主要是卡尔曼滤波和匈牙利算法的结合,主要流程首先对上一帧检测目标框进行卡尔曼滤波预测在当前帧的位置,然后利用匈牙利匹配算法进行当前检测目标框与预测目标框之间的最优匹配。deepsort算法是sort的改进版本,主要是增加cnn网络提取目标框的表观特征,增加对遮挡的鲁棒性,提出级联匹配策略通过结合运动信息和外观信息来实现真实目标框和预测目标框之间的关联度量。bytetrack算法提出了一种新的数据关联方法,同sort算法不同,该算法考虑到了由于遮挡产生的低置信度检测目标框,算法利用检测框和轨迹之间相似性,在保留高分检测结果的同时,从低分结果中去除背景,挖掘真正的物体,从而提高轨迹连贯性,首先,高分框与之前的轨迹匹配,然后利用低分框和首次未匹配成功的高分轨迹框匹配,而对于没有匹配到的轨迹,得分高的检测框构建新跟踪轨迹。botsort算法是更为鲁棒的跟踪器,匹配整体流程与bytetrack基本一致,但是它加入了reid模块和相机运动补偿方式。

3、现有多目标跟踪技术方案中,像sort、bytetrack,仅仅使用位置信息进行匹配,能准确匹配的前提都是前后帧背景不能发生很大变化,而且目标移动速度相对较慢,如果不满足前提条件,匹配结果都存在严重的id switch(身份转换)问题,甚至短期连续追踪某个目标也无法实现,当在摄像头发生抖动、转动情况时,仅依靠位置信息几乎无法连续追踪,而deepsort、botsort虽然加入了reid(跨镜追踪),对监控镜头下的物体进行重新识别和辨认,在一定程度上缓解了id switch情况,但是当目标遮挡时间较长或者摄像头转动幅度较大时,在匹配过程中加入的位置信息无法发挥作用,进而导致无法将同一目标进行关联。

技术实现思路

1、为解决上述技术问题,本发明提出一种无人机多目标长期追踪方法。

2、本发明第一方面公开了一种无人机多目标长期追踪方法;所述方法基于追踪系统对无人机获取的多种目标进行定位跟踪监视,所述追踪系统包括检测模块、跨镜追踪模块以及匹配模块;

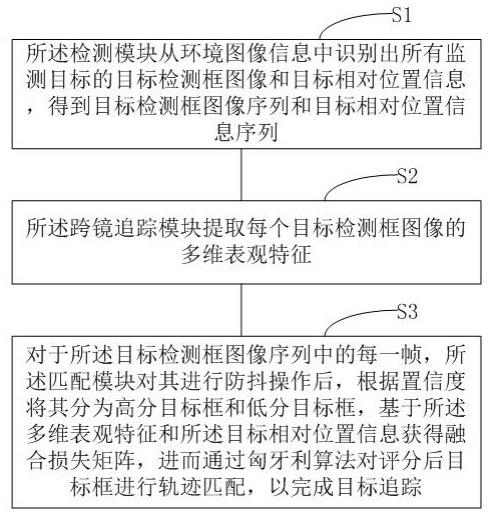

3、所述方法包括以下步骤:

4、s1,所述检测模块从环境图像信息中识别出所有监测目标的目标检测框图像和目标相对位置信息,得到目标检测框图像序列和目标相对位置信息序列;

5、s2,所述跨镜追踪模块提取每个目标检测框图像的多维表观特征;

6、s3,对于所述目标检测框图像序列中的每一帧,所述匹配模块对其进行防抖操作后,根据置信度将其分为高分目标框和低分目标框,基于所述多维表观特征和所述目标相对位置信息获得融合损失矩阵,进而通过匈牙利算法对评分后目标框进行轨迹匹配,以完成目标追踪。

7、根据本发明第一方面的方法,在所述步骤s3中,进行防抖操作的步骤包括:

8、基于当前帧的目标检测框图像和上一帧的目标检测框图像获取单应性变换矩阵,进而根据所述上一帧的目标检测框图像与所述单应性变换矩阵的乘积得到透视变换后的当前检测目标框。

9、根据本发明第一方面的方法,所述基于当前帧的目标检测框图像和上一帧的目标检测框图像获取单应性变换矩阵的步骤包括:

10、利用orb算子分别提取当前帧的目标检测框图像和上一帧的目标检测框图像的特征点及每个特征点对应的描述子;

11、通过匹配所述特征点的描述子,获得匹配的特征点对;

12、对所述特征点对进行异常匹配过滤后,获得正确特征点对;

13、基于随机抽样一致算法选取最优的8个特征点对, 通过所述8个特征点对计算所述单应性变换矩阵。

14、根据本发明第一方面的方法,在所述步骤s3中,基于所述多维表观特征和所述目标相对位置信息获得融合损失矩阵的步骤包括:

15、基于卡尔曼滤波预测轨迹池中上一帧检测目标框在所述当前检测目标框中位置,获得预测目标框;

16、基于所述目标相对位置信息将所述当前检测目标框和所述预测目标框分别建模成2d的高斯分布;

17、计算所述当前检测目标框和所述预测目标框对应的高斯分布之间的距离;

18、所述高斯分布之间的距离的计算公式为:

19、

20、其中,表示当前检测目标框a和预测目标框b之间的高斯分布之间的距离,表示当前检测目标框a的高斯分布,表示预测目标框b的高斯分布,(,)表示当前检测目标框a的中心点坐标,表示当前检测目标框a的宽度,表示当前检测目标框a的高度,(,)表示预测目标框b的中心点坐标,表示预测目标框b的宽度,表示预测目标框b的高度;

21、对所述高斯分布之间的距离进行归一化,获得所述当前检测目标框和所述预测目标框之间的位置相似度;

22、所述位置相似度的计算公式为:

23、其中,表示当前检测目标框a和预测目标框b之间的相似度,c表示数据集相关常数;

24、根据所述位置相似度计算nwd损失矩阵;

25、所述nwd损失矩阵公式为:

26、采用cos相似度计算所述当前检测目标框和所述预测目标框对应的多维表观特征之间的相似度;

27、所述多维表观特征之间的相似度的计算公式为:

28、

29、其中,表示第i个目标框的表观特征,表示第j个目标框的表观特征,表示第i个目标第k个维度的值,表示第j个目标第k个维度的值,表示表观特征的维度;

30、对所述多维表观特征之间的相似度进行归一化,获得表观特征损失矩阵;

31、所述表观特征损失矩阵为:

32、根据所述nwd损失矩阵和所述表观特征损失矩阵获得融合损失矩阵;

33、所述融合损失矩阵为:

34、

35、其中,表示位置距离的阈值,当前取值0.3,表示表观特征的阈值。

36、根据本发明第一方面的方法,与所述高分目标框匹配的轨迹池为当前可被关联的轨迹,与所述低分目标框匹配的轨迹池为与高分目标框未匹配成功的轨迹。

37、根据本发明第一方面的方法,步骤s3之后还包括:

38、利用高分未匹配到的目标表观特征与删除轨迹中的目标表观特征计算余弦损失矩阵,并基于所述余弦损失矩阵利用匈牙利算法进行关联匹配。

39、根据本发明第一方面的方法,对于匹配成功的轨迹进行更新;

40、具体通过如下公式进行更新:

41、

42、其中,表示权重参数,当前取值0.9,fea为上一帧目标表观特征,cur_fea是当前目标表观特征。

43、根据本发明第一方面的方法,步骤s2包括:

44、对所述每个目标检测框图像进行图像预处理;

45、采用restnet50作为主干网络捕捉预处理后的每个目标检测框图像的特征图[1,2048,16,8];

46、采用聚合网络对所述特征图[1,2048,16,8]进行降维和归一化获得多维表观特征[1,2048,1,1]。

47、本发明第二方面公开了一种电子设备。电子设备包括存储器和处理器,存储器存储有计算机程序,处理器执行计算机程序时,实现本公开第一方面中任一项的一种无人机多目标长期追踪方法中的步骤。

48、本发明第三方面公开了一种计算机可读存储介质。计算机可读存储介质上存储有计算机程序,计算机程序被处理器执行时,实现本公开第一方面中任一项的一种无人机多目标长期追踪方法中的步骤。

49、综上,本发明提出的方案具备如下技术效果:本发明在匹配过程融合了镜头防抖策略,解决了无人机受天气影响发生抖动时追踪发生错误的问题,并且引入reid模型,加入了匹配后处理策略,解决了摄像头发生转动时,同一个人消失又重现在摄像头时id新增问题,进而实现了无人机视角下的多目标长期稳定的目标跟踪。

- 还没有人留言评论。精彩留言会获得点赞!