一种虚拟现实环境下的学习投入度评估方法

本发明属于智能分析领域,具体是一种虚拟现实环境下的学习投入度评估方法。

背景技术:

1、虚拟现实(virtual reality,以下简称vr)是新一代信息技术的重要前沿方向,由于vr技术具有沉浸感强、交互性高,并可根据需要设计任意的3d虚拟场景等优点,在目前的k12教育、高等教育、职业教育培训中得到广泛应用,比如中学阶段的危险性化学实验,通常会伴随爆炸、燃烧、有毒物质的产生,为了让每一位同学都能动手做实验,采用vr技术来模拟真实的实验交互过程能规避安全风险,另外,在职业教育中,很多技术工人的培养需要特殊的培训设备和实训环境(比如飞机发动机维修、石油钻井设备的操控),这些设备通常非常昂贵、不易获得且容易损耗,这时候采用vr技术来仿真培训过程能极大地降低成本、缩短培训周期,并且可以重复使用。基于以上优势,在信息技术与教育不断深度交叉融合的趋势下,越来越多的课堂开始引入vr教学。

2、伴随数字化教学场景的普及和教育评价理念的发展,学习投入度成为评价课堂教学质量的关键指标。目前,智能化评估学习投入度的方法主要可以分为三类:第一类是基于计算机视觉的评估,这类方法不需要任何侵入式采集设备,仅通过高清摄像头在学生无意识的状态下即可采集面部表情、眼动视线、身体姿态等视觉信息,从而对学习投入度进行计算;第二类是基于生理信号的学习投入度评估,这类方法需要借助生理数据采集设备实现学习投入度的测评,如脑电、可穿戴设备等工具;第三类是融合以上两类方法的多模态学习投入度评估,即针对同一学习过程同时采用多种方式获取数据以全方位表征学习投入度的方法。

3、但是由于vr课堂中学生在听课或者互动实验时需要佩戴vr头盔并手持vr手柄进行交互,此时再使用脑电、可穿戴设备等生理数据采集设备会非常不方便,影响互动实验的完成。而vr课堂中学生在听课或者实验互动时需要佩戴vr头盔,这个时候教师或高清摄像头很难捕捉学生的面部表情,甚至无法知晓学生是否睁眼观看教学内容,无法实时地根据学生的行为对vr课堂教学效果进行效果评估。

技术实现思路

1、本发明的目的是提供一种虚拟现实环境下的学习投入度评估方法,通过多模态数据的采集,在不影响学习者进行互动操作的自然状态下进行学习投入度的评估。

2、为了实现上述目的,本发明的技术方案如下:

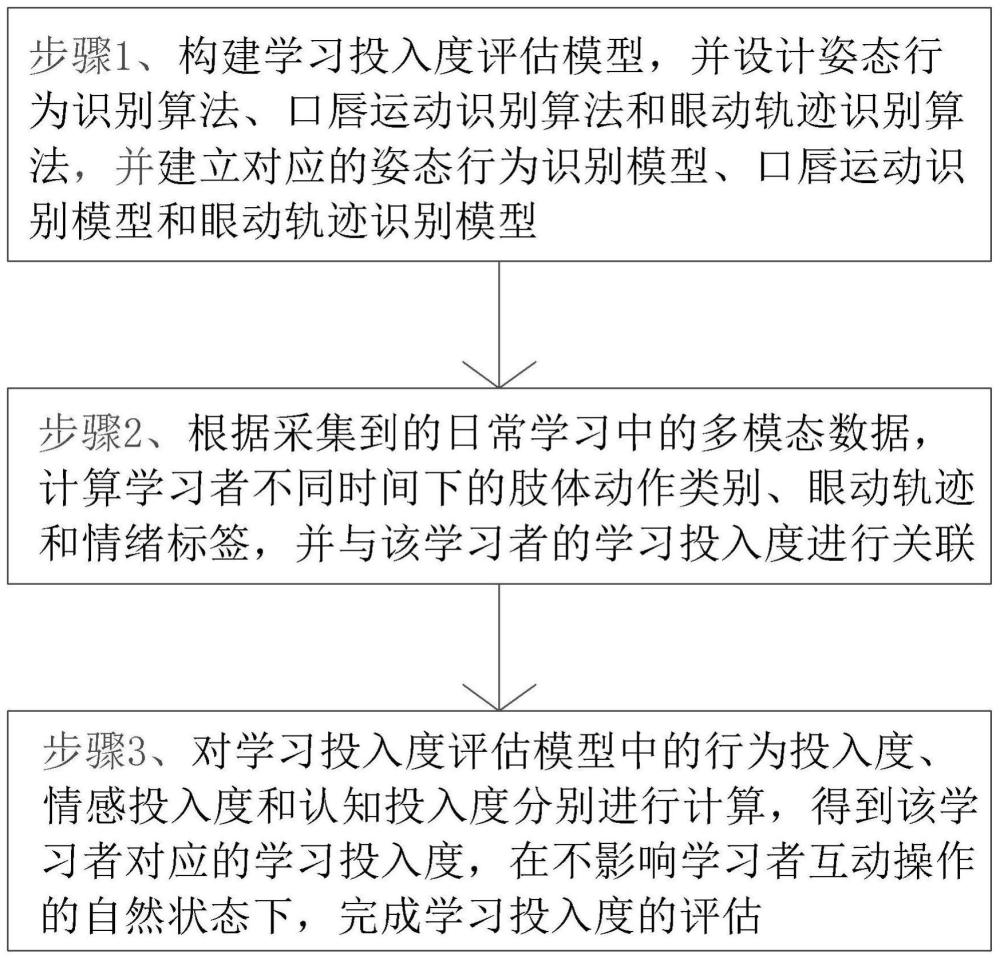

3、一种虚拟现实环境下的学习投入度评估方法,包括以下步骤:步骤1、构建学习投入度评估模型,并设计姿态行为识别算法、口唇运动识别算法和眼动轨迹识别算法,并基于姿态行为识别算法、口唇运动识别算法和眼动轨迹识别算法分别建立对应的姿态行为识别模型、口唇运动识别模型和眼动轨迹识别模型;

4、学习投入度评估模型中将学习投入度划分为行为投入度、情感投入度和认知投入度;其中,行为投入度依据肢体动作和眼动轨迹进行确定;情感投入度依据口唇运动进行确定;认知投入度依据vr互动结果统计进行确定,vr互动结果统计包括实验完成时间和正确操作次数占所有操作次数的比例;

5、步骤2、根据采集到的该学习者的日常多模态数据,计算并分析该学习者不同时间下的肢体动作类别、眼动轨迹类别和情绪标签,并将肢体动作类别、眼动轨迹类别和情绪标签与该学习者的学习投入度进行关联;

6、采集该学习者在日常学习中的多模态数据,基于多模态数据分析并计算得到该学习者在日常学习中的对比学习投入度,得到对比学习投入对应的个人行为投入度和个人情感投入度;

7、其中,将多模态数据中的视频数据导入姿态行为识别模型得到该学习者的不同时间的个人肢体动作类别;再将视频数据中的人脸面部图像数据导入眼动轨迹识别模型中,得到该学习者的不同时间的个人眼动轨迹类别,并将个人肢体动作类别和个人眼动轨迹类别与个人行为投入度进行关联;

8、将视频数据中的人脸面部图像数据导入口唇运动识别模型中,得到该学习者的不同时间的个人口唇运动类别和情绪标签,先将个人口唇运动类别与情绪标签进行关联,再将待识别口唇运动类别与情绪标签与个人情感投入度进行关联;

9、步骤3、对学习投入度评估模型中的行为投入度、情感投入度和认知投入度分别进行计算,得到该学习者对应的学习投入度;

10、基于当前时间该学习者学习的课程,得到当前时间的多模态数据,重复步骤2中的步骤,得到当前时间该学习者的个人肢体动作类别、个人眼动轨迹类别和个人口唇运动类别,得到当前课程中该学习者对应的个人行为投入度和个人情感投入度;

11、若该学习者学习的课程为vr实验类的课程,则获取该学习者通过vr实验课程应用软件操作的vr互动结果统计,并基于vr互动结果统计得到对应的认知投入度,并将认知投入度、个人行为投入度和个人情感投入度导入学习投入度评估模型中,得到该学习者对应的学习投入度;

12、若学习者学习的课程为vr观摩类的课程,则将个人行为投入度和个人情感投入度导入学习投入度评估模型中,得到该学习者对应的学习投入度。

13、采用上述方案后实现了以下有益效果:通过建立学习投入度评估模型、姿态行为识别模型、口唇运动识别模型和眼动轨迹识别模型,能根据该学习者在学习课程中肢体动作、口唇运动和眼动轨迹进行识别,从而对学习投入度评估模型中的行为投入度、情感投入度和认知投入度进行确定,与现有技术相比,能消除佩戴vr头盔的影响,在不影响学习者进行互动操作的自然状态下进行学习投入度的评估。

14、进一步,在步骤一中,姿态行为识别模型采用基于混合注意力的transformer网络3d人体姿态估计方法进行建立,且姿态行为识别模型将学习者的姿态分为观看、站立、举手、趴桌子、左顾右盼、发呆和动手交互;

15、口唇运动识别模型采用基于级联卷积神经网络进行人脸口唇特征点的定位,再基于双模态空时域特征自动学习的口唇运动识别方法,将口唇运动表达的情感进行分类,情感包括高兴、反感、困惑、害怕、惊讶、愤怒与中性;

16、眼动轨迹识别模型采用1dcnn-bilstm网络对眼动跟踪数据提取分类特征,根据眼动数据将不同时间段将眼动轨迹划分为注视、跳视、平稳追踪、闭眼和未知。

17、有益效果:将学习者的姿态、口唇运动表达的情感和眼动轨迹进行分类,便于对肢体动作、眼动轨迹和口唇运动进行识别,从而将肢体动作、眼动轨迹和口唇运动转化为对应的行为投入度标签和情感投入度标签,导入学习投入度评估模型中得到该学习者对应的学习投入度。

18、进一步,人脸口唇特征点的定位步骤如下:首先提取vr头盔的边框作为基准,计算头部的倾斜角度,在倾斜角度作为修正旋转图像,纠正头部倾斜,再通过构建级联的深度神经网络,实现人脸轮廓及口唇部位的特征点定位。

19、有益效果:口唇特征点采取由粗到精的定位方式,逐步获得更为精准的特征点定位;并降低头部姿态对人脸特定点定位的影响。

20、进一步,口唇运动识别模型中口唇运动识别方法还会根据口唇运动的图像序列中选取固定数量的代表帧作为神经网络的输入,口唇运动代表帧选择方法如以下公式所示:

21、

22、其中,f'表示选取的口唇运动代表帧集合;ft表示代表帧,下标t是代表帧的时间码;ton和tapex分别表示口唇运动序列中的起始帧和峰值帧的时间码;n表示要选取的代表帧的总数量。

23、有益效果:图像序列形式的面部表情从起始到结束的持续时间是一个变化量,而神经网络自身的特点决定了输入数据的维度必须是一个恒定值。不能直接将图像序列形式的口唇运动输入神经网络,因为每个口唇状态包含的图像帧数量不一致。因此本方案从口唇运动的图像序列中选取固定数量的代表帧作为神经网络的输入,以解决每个口唇状态包含的图像帧数量不一致的问题。

24、进一步,在步骤1中,学习投入度评估模型还会运用指标函数和模糊数学中的隶属度函数,对行为投入度、情感投入度和认知投入度进行无量纲处理,公式如下:

25、

26、其中,f(xi)为无量纲化处理的各指标参数,xi为行为投入度、情感投入度或认知投入度。

27、有益效果:通过无量纲化处理以控制行为投入度、情感投入度和认知投入度的变量数目,便于后续计算客观权重序列和综合权重。

28、进一步,在步骤1中,学习投入度评估模型还会计算综合权重,公式如下:

29、

30、其中,wi为主观权重序列,vi为客观权重序列,且客观权重序列由上述的无量纲化处理的各指标参数确定;f(i)为综合权重。

31、有益效果:根据综合权重便于得到行为与情感的特征分布,便于构建学习投入度评估模型。

32、进一步,在步骤1中,学习投入度评估模型中学习投入度评估机制的建立方法如下,按狄利克雷分布对学习者个体的学习数据进行处理,从该狄利克雷先验分布中采样生成行为与情感的分布;从狄利克雷分布中采样得到学习投入度的行为与情感分布,并依据行为与情感的多项式分布采样得到行为类别与情感状态,得到预测学习投入度状态公式如下:

33、

34、其中是未知的投入度,是输入,w是模型参数,p(w|x,y)是w的后验概率。

35、有益效果:由于狄利克雷分布与多项式分布属于共轭分布,已对先验分布进行了约束,据此采用变分推断近似后验分布。

36、通过确定行为、情感与学习投入度的关联机理以及隐含变量之间关联关系,可以对计算得到的学习投入度结果进行有效呈现,拟采用符合个体认知规律的呈现形式(例如:雷达图),对学习投入度的多维表征进行直观地可视化。

37、进一步,还包括以下步骤:步骤4、在学习者学习课程中,在一定的间隔时间,周期性获取所有学习者对应的情绪标签,并将情绪标签进行一致性对比,若一致,则终止,若不一致,则获取不一致的学习者对应的图像数据和眼动图像数据,则进入步骤4.1;

38、步骤4.1、首先,将图像数据导入姿态行为识别模型中,得到该学习者当前时间对应的肢体动作类别,并将肢体动作类别与当前时间的课程需要进行一致性对比,若一致,则进入步骤4.2,若不一致,则记录一次违规次数,并进入步骤4.2;

39、步骤4.2、将眼动图像数据导入眼动轨迹识别模型中,得到对应的眼动轨迹,再将眼部轨迹变化与该课程显示的vr图像对应的专注点进行对比,若一致,则终止,若不一致,则记录一次违规次数;

40、并计算违规次数与设定额定值之间的差值,根据差值与额定值之间的比例减小学习投入度。

41、有益效果:通过违规次数对学习投入度进行修正,使得到的学习投入度更加的准确。

- 还没有人留言评论。精彩留言会获得点赞!